Spark RDD学习

RDD(弹性分布式数据集)是Spark的核心抽象。它是一组元素,在集群的节点之间进行分区,以便我们可以对其执行各种并行操作。

创建RDD的两种方式:

- 并行化驱动程序中的现有数据;

- 引用外部存储系统中的数据集。

并行化集合

SparkContext的parallelize方法。复制集合的每个元素以形成可以并行操作的分布式数据集。%Spark

val info=Array(1,2,3,4)

val distInfo=sc.parallelize(info)

%操作分布式数据集

distinfo.reduce((a, b) => a + b)

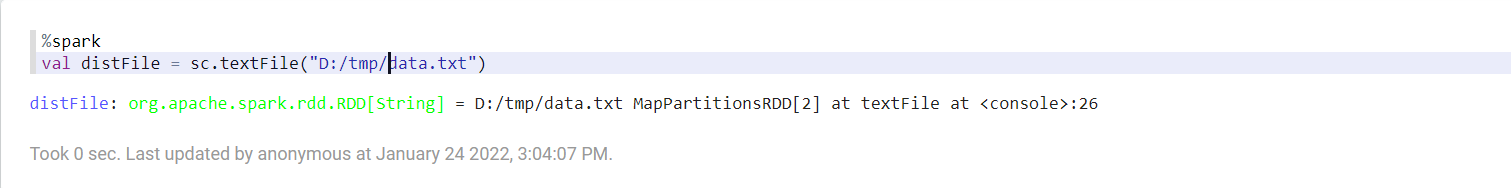

外部数据集

在Spark中,可以从Hadoop支持的任何类型的存储源(如HDFS,Cassandra,HBase甚至本地文件系统)创建分布式数据集。Spark 支持文本文件(text files),SequenceFiles 和其他 Hadoop InputFormat。

SparkContext的textFile方法可用于创建RDD的文本文件。此方法获取文件的URI(本地路径或hdfs://,s3n://等)并读取文件的数据,将文件读取成一个行集合。

一旦创建完成,distFiile 就能做数据集操作。例如,我们可以用下面的方式使用 map 和 reduce 操作将所有行的长度相加:distFile.map(s => s.length).reduce((a, b) => a + b)。

RDD的两种操作:

- 转换

- 行动

转换:在Spark中,转换的作用是从现有数据集创建新数据集。转换是惰性的,因为它们仅在动作需要将结果返回到驱动程序时才计算。

map(func)- 它返回一个新的分布式数据集, 该数据集是通过函数func传递源的每个元素而形成的。filter(func)- 它返回一个新数据集, 该数据集是通过选择函数func返回true的源元素而形成的。

flatMap(func)- 每个输入项可以映射到零个或多个输出项, 因此函数func应该返回序列而不是单个项。mapPartitions(func)- 它类似于map,但是在RDD的每个分区(块)上单独运行, 因此当在类型T的RDD上运行时,func必须是Iterator <T> => Iterator <U>类型。mapPartitionsWithIndex(func)- 它类似于mapPartitions,它为func提供了一个表示分区索引的整数值,因此当在类型T的RDD上运行时,func必须是类型(Int,Iterator <T>)=> Iterator <U>。sample(withReplacement, fraction, seed)- 它使用给定的随机数生成器种子对数据的分数部分进行采样,有或没有替换。union(otherDataset)- 它返回一个新数据集,其中包含源数据集和参数中元素的并集。intersection(otherDataset)- 它返回一个新的RDD,其中包含源数据集和参数中的元素的交集。distinct([numPartitions]))- 它返回一个新数据集,其中包含源数据集的不同元素。groupByKey([numPartitions])- 当在(K,V)对的数据集上调用时,它返回(K,Iterable)对的数据集。reduceByKey(func, [numPartitions])- 当调用(K,V)对的数据集时,返回(K,V)对的数据集,其中使用给定的reduce函数func聚合每个键的值,该函数必须是类型(V,V)=>V。aggregateByKey(zeroValue)(seqOp, combOp, [numPartitions])- 当调用(K,V)对的数据集时,返回(K,U)对的数据集,其中使用给定的组合函数和中性“零”值聚合每个键的值。sortByKey([ascending], [numPartitions])- 它返回按键按升序或降序排序的键值对的数据集,如在布尔ascending参数中所指定。join(otherDataset, [numPartitions])-当调用类型(K,V)和(K,W)的数据集时,返回(K,(V,W))对的数据集以及每个键的所有元素对。通过leftOuterJoin,rightOuterJoin和fullOuterJoin支持外连接。cogroup(otherDataset, [numPartitions])-当调用类型(K,V)和(K,W)的数据集时,返回(K,(Iterable,Iterable))元组的数据集。此操作也称为groupWith。cartesian(otherDataset)-当调用类型为T和U的数据集时,返回(T,U)对的数据集(所有元素对)。pipe(command, [envVars])-通过shell命令管道RDD的每个分区,例如, 一个Perl或bash脚本。coalesce(numPartitions)-它将RDD中的分区数减少到numPartitions。repartition(numPartitions)-它随机重新调整RDD中的数据,以创建更多或更少的分区,并在它们之间进行平衡。repartitionAndSortWithinPartitions(partitioner)- 它根据给定的分区器对RDD进行重新分区,并在每个生成的分区中键对记录进行排序。

行动:在Spark中,操作的作用是在对数据集运行计算后将值返回给驱动程序。

- reduce(func):它使用函数func(它接受两个参数并返回一个)来聚合数据集的元素。该函数应该是可交换的和关联的,以便可以并行正确计算。

- collect():它将数据集的所有元素作为数组返回到驱动程序中。在过滤器或其他返回足够小的数据子集的操作之后,这通常很有用。

count():它返回数据集中的元素数。first()它返回数据集的第一个元素(类似于take(1))take(n)它返回一个包含数据集的前n个元素的数组。takeSample(withReplacement, num, [seed])它返回一个数组,其中包含数据集的num个元素的随机样本,有或没有替换,可选地预先指定随机数生成器种子。takeOrdered(n, [ordering])它使用自然顺序或自定义比较器返回RDD的前n个元素。- saveAsTextFile(path):它用于将数据集的元素作为文本文件(或文本文件集)写入本地文件系统,HDFS或任何其他Hadoop支持的文件系统的给定目录中。

- saveAsSequenceFile(path):它用于在本地文件系统,HDFS或任何其他Hadoop支持的文件系统中的给定路径中将数据集的元素编写为Hadoop SequenceFile。

- saveAsObjectFile(path):它用于使用Java序列化以简单格式编写数据集的元素,然后可以使用

SparkContext.objectFile()加载。 - countByKey():它仅适用于类型(K,V)的RDD。因此,它返回(K,Int)对的散列映射与每个键的计数。

- foreach(func):它在数据集的每个元素上运行函数

func以获得副作用,例如更新累加器或与外部存储系统交互。

Spark RDD学习的更多相关文章

- Spark RDD学习笔记

一.学习Spark RDD RDD是Spark中的核心数据模型,一个RDD代表着一个被分区(partition)的只读数据集. RDD的生成只有两种途径: 一种是来自于内存集合或外部存储系统: 另一种 ...

- Spark菜鸟学习营Day3 RDD编程进阶

Spark菜鸟学习营Day3 RDD编程进阶 RDD代码简化 对于昨天练习的代码,我们可以从几个方面来简化: 使用fluent风格写法,可以减少对于中间变量的定义. 使用lambda表示式来替换对象写 ...

- Spark菜鸟学习营Day1 从Java到RDD编程

Spark菜鸟学习营Day1 从Java到RDD编程 菜鸟训练营主要的目标是帮助大家从零开始,初步掌握Spark程序的开发. Spark的编程模型是一步一步发展过来的,今天主要带大家走一下这段路,让我 ...

- 【spark 深入学习 06】RDD编程之旅基础篇02-Spaek shell

--------------------- 本节内容: · Spark转换 RDD操作实例 · Spark行动 RDD操作实例 · 参考资料 --------------------- 关于学习编程方 ...

- 【spark 深入学习 03】Spark RDD的蛮荒世界

RDD真的是一个很晦涩的词汇,他就是伯克利大学的博士们在论文中提出的一个概念,很抽象,很难懂:但是这是spark的核心概念,因此有必要spark rdd的知识点,用最简单.浅显易懂的词汇描述.不想用学 ...

- spark学习13(spark RDD)

RDD及其特点 1)RDD(Resillient Distributed Dataset)弹性分布式数据集,是spark提供的核心抽象.它代表一个不可变.可分区.里面的元素可并行计算的集合 2)RDD ...

- Spark菜鸟学习营Day5 分布式程序开发

Spark菜鸟学习营Day5 分布式程序开发 这一章会和我们前面进行的需求分析进行呼应,完成程序的开发. 开发步骤 分布式系统开发是一个复杂的过程,对于复杂过程,我们需要分解为简单步骤的组合. 针对每 ...

- Spark菜鸟学习营Day4 单元测试程序的编写

Spark菜鸟学习营Day4 单元测试程序的编写 Spark相比于传统代码是比较难以调试的,单元测试的编写是非常必要的. Step0:需求分析 在测试案例编写前,需完成需求分析工作,明确程序所有的输入 ...

- Spark菜鸟学习营Day2 分布式系统需求分析

Spark菜鸟学习营Day2 分布式系统需求分析 本分析主要针对从原有代码向Spark的迁移.要注意的是Spark和传统开发有着截然不同的思考思路,所以我们需要首先对原有代码进行需求分析,形成改造思路 ...

随机推荐

- 02.python线性数据结构

内建常用数据类型 分类 数值型 int.float.complex.bool 序列sequence 字符串str.字节序列bytes.bytearray 列表list.元组tuple 键值对 集合se ...

- python+openpyxl 获取最大行数,不是真正想获取的行数,导致替换时,报”NoneType' object has no attribute 'find'

问题描述: 使用excel对接口的数据进行管理,添加接口数据时,可能习惯性选择多行,设置了格式,导致多选了很多空行也被设置了格式,在读取这个sheet的最大行数时,发现有问题,获取到了为None的空行 ...

- hadoop 之 常用基本操作

HDFS 常用命令(hadoop fs.hadoop dfs.hdfs dfs): hadoop fs -ls 显示当前目录结构,-ls -R 递归显示目录结构 hadoop fs -mkdir 创建 ...

- Django_通用视图(五)

参考官网的投票系统,按照综合案例的流程创建应用polls,主要模块代码如下: test1/polls/models.py import datetime from django.db import m ...

- 【Azure 应用服务】一个 App Service 同时部署运行两个及多个 Java 应用程序(Jar包)

问题描述 如何在一个AppService下同时部署运行多个Java 应用程序呢? 问题解答 因为App Service的默认根目录为 wwwroot.如果需要运行多个Java 应用程序,需要在 www ...

- [转]webpack——CommonsChunkPlugin

作用虽然webpack4已经出来很久了,CommonsChunkPlugin也已经舍弃了,但是还是有很多项目是通过webpack3来打包的,对CommonsChunkPlugin各个配置项的认识还是比 ...

- linux开放端口关闭防火墙

linux开放端口关闭防火墙 systemctl status firewalld查看当前防火墙状态. 开启防火墙 systemctl start firewalld开放指定端口 ...

- Web开发之Cookie and Session

会话 什么是会话? 简单说:用户开一个浏览器,点击多个超链接,访问服务器的多个web资源,然后关闭浏览器,整个过程就称之为一个会话. 会话过程要解决什么问题 每个用户在使用浏览器与服务器进行会话的过程 ...

- eclipse导入项目jdk版本不一样

一:eclipse导入项目jdk版本不一样解决方案 参考博文: https://www.cnblogs.com/chenmingjun/p/8472885.html 选中项目右键 --> Pro ...

- gorm声明模型

模型定义 模型是标准的结构体,由go的基本数据类型.实现了Scanner和Valuer接口的自定义类型及其指针或别名组成 例如: type User struct { ID uint Name str ...