Python 爬虫入门(一)——爬取糗百

爬取糗百内容

GitHub 代码地址https://github.com/injetlee/Python/blob/master/qiubai_crawer.py

微信公众号:【智能制造社区】,欢迎关注。

本文目标

- 掌握爬虫的基本概念

- Requests 及 Beautiful Soup 两个 Python 库的基本使用

- 通过以上知识完成糗百段子抓取

爬虫基本概念

爬虫也称网页蜘蛛,主要用于抓取网页上的特定信息。这在我们需要获取一些信息时非常有用,比如我们可以批量到美图网站下载图片,批量下载段子。省去手工操作的大量时间。爬虫程序一般是通过模拟浏览器对相应URL发出请求,获取数据,并通过正则等手段匹配出页面中我们所需的数据。

在学习爬虫之前,最好到 w3school 去了解一下 HTML 标签的概念以及基本的 CSS 的概念。这会让我们更容易的理解如何获取页面中某个内容。

Requests 库基本介绍

Requests 是学习爬虫的一大利器。是一个优雅简单的 HTTP库。官网介绍如下:

Requests: HTTP for Humans

专门为人类使用的 HTTP 库。使用起来非常简单明了。

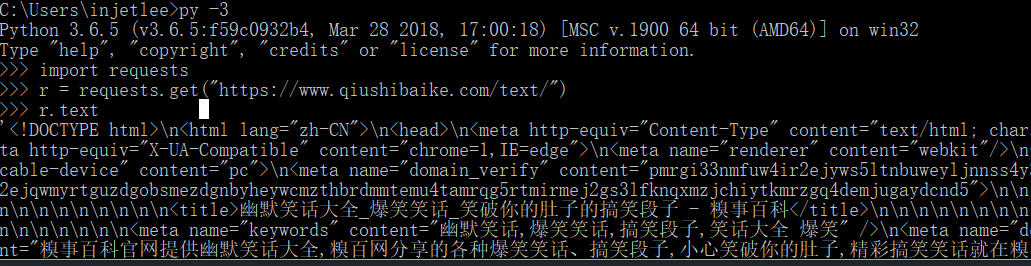

我们平时浏览网页的步骤是输入网址,打开。在 Requests 中是如下这样的,我们可以在 Python 交互式解释器中输入以下代码:

import requests

r = requests.get('https://www.qiushibaike.com/text/') # 打开网址,一般我们会设置 请求头,来更逼真的模拟浏览器,下文有介绍

r.text

我门看到下面一堆的代码,其实就是网页的源代码(也可以在浏览器上右键查看页面源代码)。通过这几行代码我们就拿到了页面的所有信息,剩下的就是从页面中找到我们所需要的信息。

Beautiful Soup 库介绍

拿到网页信息后,我们要解析页面,通常来说我们有以下几种方式来解析页面,获取我们所需的信息。

- 正则表达式

- 适用于简单数据的匹配,如果匹配内容较复杂,正则表达式写起来会很绕,同时页面内容稍微变化,正则就会失效

- Lxml

- Lxml 是专门用来解析 XML 格式文件的库,该模块用 C 语言编写,解析速度很快,和正则表达式速度差不多,但是提供了 XPath 和 CSS 选择器等定位元素的方法

- Beautiful Soup

- 这是一个 Python 实现的解析库,相比较于前两种来说,语法会更简单明了一点,文档也比较详细。唯一的一点就是运行速度比前两种方式慢几倍,当数据量非常大时相差会更多。

本文作为入门教程,就从 Beautiful Soup 入手,来学习一下匹配页面所需元素的方法。

假如有以下 HTML 内容 example.html

<html>

<head>

<meta charset="utf-8" />

<meta http-equiv="X-UA-Compatible" content="IE=edge">

<title>Page Title</title>

</head>

<body>

<div class='main-page'>

<ul class='menu-list'>

<li>首页</li>

<li>新闻</li>

<li>影视</li>

</ul>

</div>

</body>

</html>

我们通过 Beautiful Soup 来解析这个 html. 首先我们pip install beautifulsoup4安装这个库,并看一下简单使用。

>>>from bs4 import BeautifulSoup

>>>soup = BeautifulSoup('example.html', 'html.parser') #加载我们的html文件

>>>soup.find('div') # 找到 div 标签

'<div class="main-page">

<ul class="menu-list">

<li>首页</li>

<li>新闻</li>

<li>影视</li>

</ul>

</div>'

>>>soup.find_all('li') # 找到所有 li 标签

'[<li>首页</li>, <li>新闻</li>, <li>影视</li>]'

>>>for i in li:

print(i.text) #获取每个 li 标签的内容

'

首页

新闻

影视

'

详细的操作可以去看一下文档,文档非常详细,例子也很多,简单明了。

糗百爬虫代码

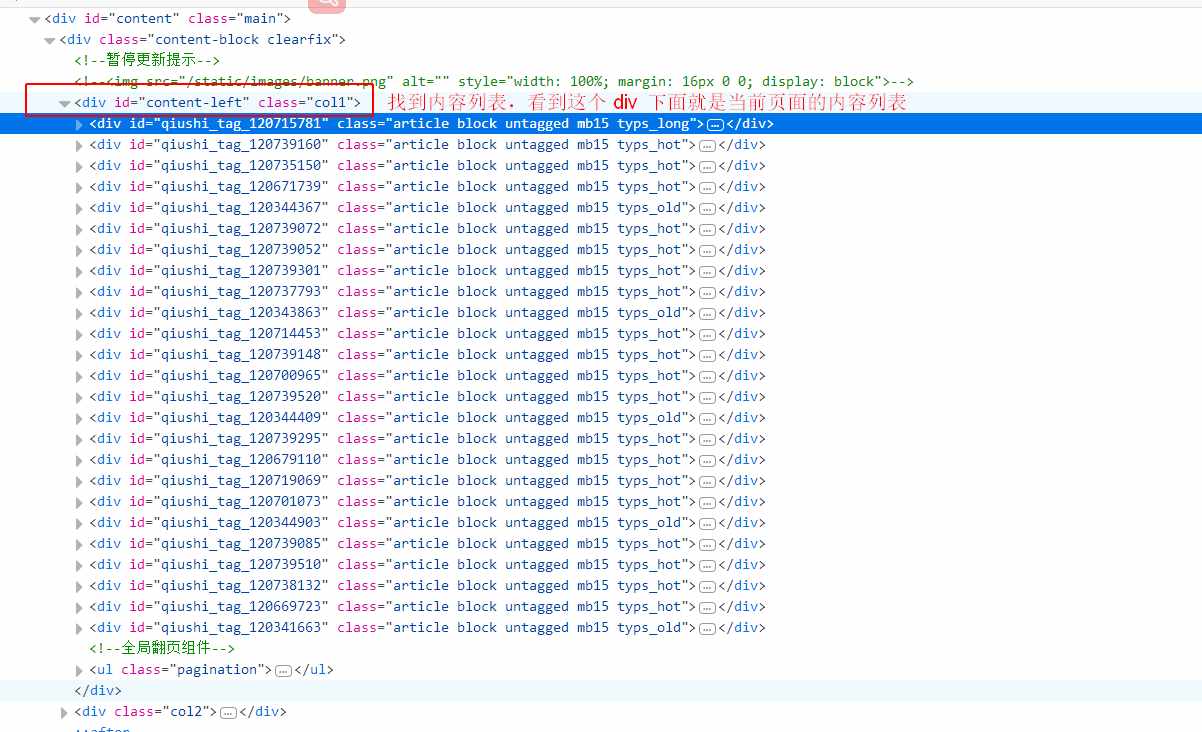

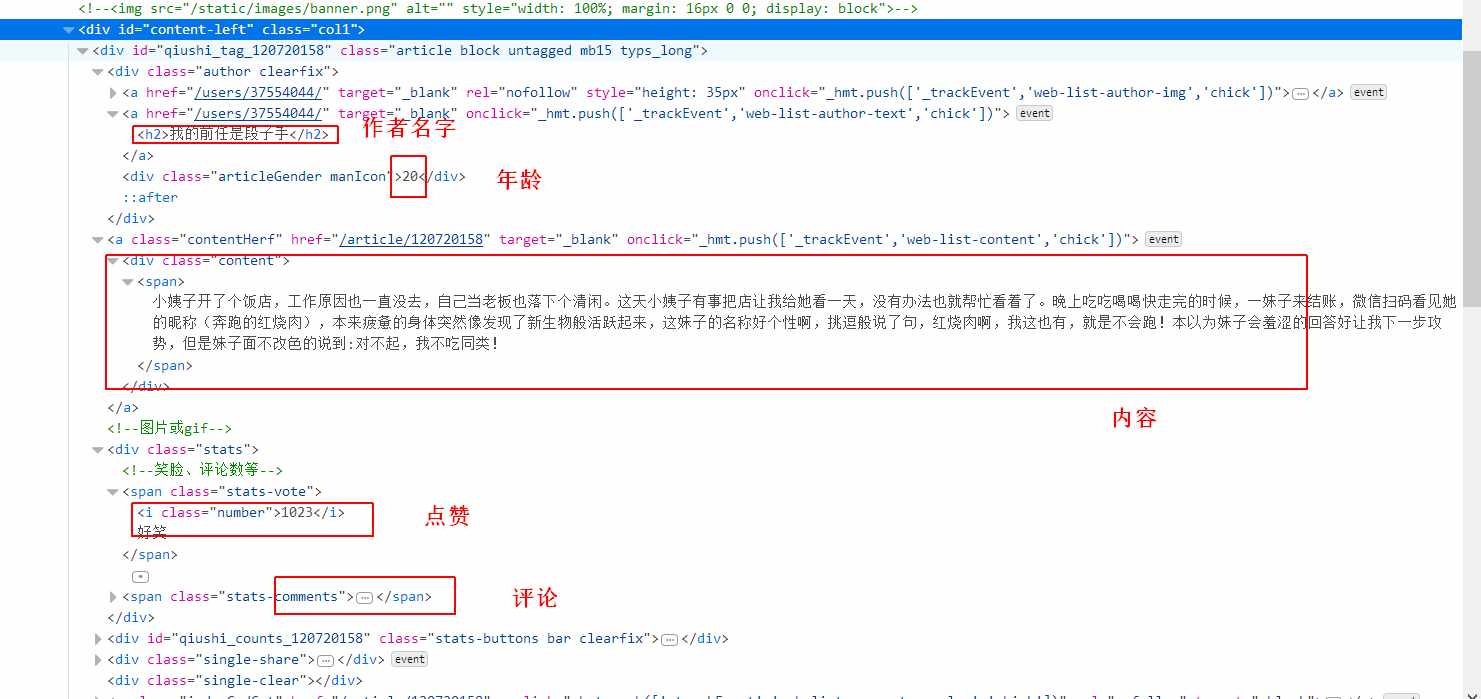

我们先爬取纯文本的内容 https://www.qiushibaike.com/text/ 爬取这个链接下的内容。我们把页面结构截图如下,我们要获取的信息,我用红色的方框进行了标注。

图一:

图二:

import requests

from bs4 import BeautifulSoup

def download_page(url):

headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:61.0) Gecko/20100101 Firefox/61.0"}

r = requests.get(url, headers=headers) # 增加headers, 模拟浏览器

return r.text

def get_content(html, page):

output = """第{}页 作者:{} 性别:{} 年龄:{} 点赞:{} 评论:{}\n{}\n------------\n""" # 最终输出格式

soup = BeautifulSoup(html, 'html.parser')

con = soup.find(id='content-left') # 如图一红色方框

con_list = con.find_all('div', class_="article") # 找到文章列表

for i in con_list:

author = i.find('h2').string # 获取作者名字

content = i.find('div', class_='content').find('span').get_text() # 获取内容

stats = i.find('div', class_='stats')

vote = stats.find('span', class_='stats-vote').find('i', class_='number').string

comment = stats.find('span', class_='stats-comments').find('i', class_='number').string

author_info = i.find('div', class_='articleGender') # 获取作者 年龄,性别

if author_info is not None: # 非匿名用户

class_list = author_info['class']

if "womenIcon" in class_list:

gender = '女'

elif "manIcon" in class_list:

gender = '男'

else:

gender = ''

age = author_info.string # 获取年龄

else: # 匿名用户

gender = ''

age = ''

save_txt(output.format(page, author, gender, age, vote, comment, content))

def save_txt(*args):

for i in args:

with open('qiubai.txt', 'a', encoding='utf-8') as f:

f.write(i)

def main():

# 我们点击下面链接,在页面下方可以看到共有13页,可以构造如下 url,

# 当然我们最好是用 Beautiful Soup找到页面底部有多少页。

for i in range(1, 14):

url = 'https://qiushibaike.com/text/page/{}'.format(i)

html = download_page(url)

get_content(html, i)

if __name__ == '__main__':

main()

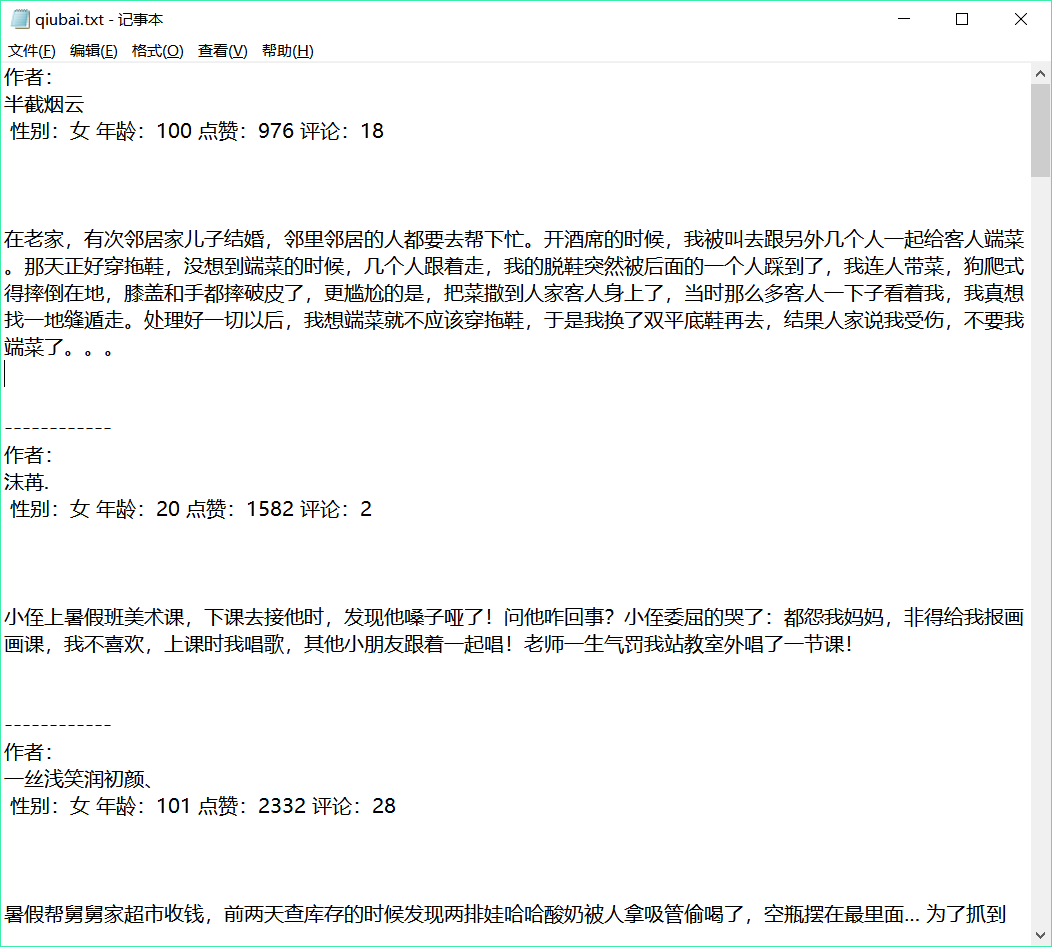

运行代码后,我们会得到 'qiubai.txt'文件,打开后如下所示

Python 爬虫入门(一)——爬取糗百的更多相关文章

- Python 爬虫入门之爬取妹子图

Python 爬虫入门之爬取妹子图 来源:李英杰 链接: https://segmentfault.com/a/1190000015798452 听说你写代码没动力?本文就给你动力,爬取妹子图.如果 ...

- Python 爬虫入门(二)——爬取妹子图

Python 爬虫入门 听说你写代码没动力?本文就给你动力,爬取妹子图.如果这也没动力那就没救了. GitHub 地址: https://github.com/injetlee/Python/blob ...

- python 爬虫入门----案例爬取上海租房图片

前言 对于一个net开发这爬虫真真的以前没有写过.这段时间学习python爬虫,今天周末无聊写了一段代码爬取上海租房图片,其实很简短就是利用爬虫的第三方库Requests与BeautifulSoup. ...

- python 爬虫入门案例----爬取某站上海租房图片

前言 对于一个net开发这爬虫真真的以前没有写过.这段时间开始学习python爬虫,今天周末无聊写了一段代码爬取上海租房图片,其实很简短就是利用爬虫的第三方库Requests与BeautifulSou ...

- Python爬虫入门:爬取豆瓣电影TOP250

一个很简单的爬虫. 从这里学习的,解释的挺好的:https://xlzd.me/2015/12/16/python-crawler-03 分享写这个代码用到了的学习的链接: BeautifulSoup ...

- Python爬虫入门:爬取pixiv

终于想开始爬自己想爬的网站了.于是就试着爬P站试试手. 我爬的图的目标网址是: http://www.pixiv.net/search.php?word=%E5%9B%9B%E6%9C%88%E3%8 ...

- python 爬虫入门1 爬取代理服务器网址

刚学,只会一点正则,还只能爬1页..以后还会加入测试 #coding:utf-8 import urllib import urllib2 import re #抓取代理服务器地址 Key = 1 u ...

- python - 爬虫入门练习 爬取链家网二手房信息

import requests from bs4 import BeautifulSoup import sqlite3 conn = sqlite3.connect("test.db&qu ...

- 【转载】教你分分钟学会用python爬虫框架Scrapy爬取心目中的女神

原文:教你分分钟学会用python爬虫框架Scrapy爬取心目中的女神 本博文将带领你从入门到精通爬虫框架Scrapy,最终具备爬取任何网页的数据的能力.本文以校花网为例进行爬取,校花网:http:/ ...

随机推荐

- Mysql配置优化,库表设计

Mysql 服务器参数类型: 基于参数的作用域: 全局参数:set global autocommit = ON/OFF; 会话参数(会话参数不单独设置则会采用全局参数):set session au ...

- java项目----衣服购买

执行bat文件:注意t_temp.properties保存的文件是否为utf8编码native2ascii -encoding UTF-8 t_temp.properties r.properties ...

- NLP自然语言处理原理及名词介绍

1. 自然语言概念 自然语言,即我们人类日常所使用的语言,是人类交际的重要方式,也是人类区别其他动物的本质特征. 但是我们只能通过自然语言与人交流,无法与计算机进行交流. 2. 自然语言处理 自然语言 ...

- 饮冰三年-人工智能-Python-29瀑布流

多适用于:整版以图片为主,大小不一的图片按照一定的规律排列的网页布局. 1:创建model类,并生成数据表 from django.db import models # Create your mod ...

- 华为AR2811配置脚本

华为AR28-11基本配置 # sysname Quidway # super password level simple admin --设置super用户password,级别,密码显示方式(明文 ...

- 关于Hbase开启snappy压缩

版本:自己编译的hbase-1.2.0-cdh5.14.0 默认情况下,Hbase不开启snappy压缩 , 所以在hbase的lib/native目录下什么也没有(我的前提是执行hadoop che ...

- Jquery DataTable初探

最近在做公司的后台模版,表格渲染都是用的datatable,现在来总结一下常用用法. datatable中文网参考链接 配置介绍 1. "aLengthMenu": [ [5, 1 ...

- SpringCloud入门

一. 什么是 SpringCloud 什么是 SpringCloud:是一个服务治理平台,提供了一些服务框架.包含了:服务注册与发现.配置中心.消息中心 .负载均衡.数据监控等等. ...

- 10_27_unittest

接口测试的本质 就是测试类里面的函数. 单元测试的本质 测试函数 代码级别 单元测试框架 unittest 接口 pytest web 功能测试: 1.写用例 ----> TestCase ...

- ubuntu制作离线包

一.应用场景a.当我们需要在多台电脑安装同一个软件,并且这个软件很大,下载需要很长时间b.需要安装软件的ubuntu不能上网二.离线安装包的制作2.1.通过如下指令下载XXXX软件所需要的deb包,首 ...