Spark ML逻辑回归

import org.apache.log4j.{Level, Logger}

import org.apache.spark.ml.classification.LogisticRegression

import org.apache.spark.ml.linalg.Vectors

import org.apache.spark.sql.SparkSession

/**

* 逻辑回归

* Created by zhen on 2018/11/20.

*/

object LogisticRegression {

Logger.getLogger("org").setLevel(Level.WARN) // 设置日志级别

def main(args: Array[String]) {

val spark = SparkSession.builder()

.appName("LogisticRegression")

.master("local[2]")

.getOrCreate()

val sqlContext = spark.sqlContext

// 加载训练数据和测试数据

val data = sqlContext.createDataFrame(Seq(

(1.0, Vectors.dense(0.0, 1.1, 0.1)),

(0.0, Vectors.dense(2.0, 1.0, -1.1)),

(1.0, Vectors.dense(1.0, 2.1, 0.1)),

(0.0, Vectors.dense(2.0, -1.3, 1.1)),

(0.0, Vectors.dense(2.0, 1.0, -1.1)),

(1.0, Vectors.dense(1.0, 2.1, 0.1)),

(1.0, Vectors.dense(2.0, 1.3, 1.1)),

(0.0, Vectors.dense(-2.0, 1.0, -1.1)),

(1.0, Vectors.dense(1.0, 2.1, 0.1)),

(0.0, Vectors.dense(2.0, -1.3, 1.1)),

(1.0, Vectors.dense(2.0, 1.0, -1.1)),

(1.0, Vectors.dense(1.0, 2.1, 0.1)),

(0.0, Vectors.dense(-2.0, 1.3, 1.1)),

(1.0, Vectors.dense(0.0, 1.2, -0.4))

))

.toDF("label", "features")

val weights = Array(0.8,0.2) //设置训练集和测试集的比例

val split_data = data.randomSplit(weights) // 拆分训练集和测试集

// 创建逻辑回归对象

val lr = new LogisticRegression()

// 设置参数

lr.setMaxIter(10).setRegParam(0.01)

// 训练模型

val model = lr.fit(split_data(0))

model.transform(split_data(1))

.select("label", "features", "probability", "prediction")

.collect()

.foreach(println(_))

//关闭spark

spark.stop()

}

}

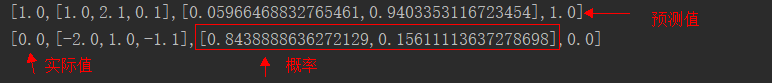

结果:

Spark ML逻辑回归的更多相关文章

- Spark LogisticRegression 逻辑回归之建模

导入包 import org.apache.spark.sql.SparkSession import org.apache.spark.sql.Dataset import org.apache.s ...

- Spark 多项式逻辑回归__多分类

package Spark_MLlib import org.apache.spark.ml.Pipeline import org.apache.spark.ml.classification.{B ...

- Spark 多项式逻辑回归__二分类

package Spark_MLlib import org.apache.spark.ml.Pipeline import org.apache.spark.ml.classification.{L ...

- Spark 机器学习------逻辑回归

package Spark_MLlib import javassist.bytecode.SignatureAttribute.ArrayType import org.apache.spark.s ...

- Spark Mllib逻辑回归算法分析

原创文章,转载请注明: 转载自http://www.cnblogs.com/tovin/p/3816289.html 本文以spark 1.0.0版本MLlib算法为准进行分析 一.代码结构 逻辑回归 ...

- Spark LR逻辑回归中RDD转DF中VectorUDT设置

System.setProperty("hadoop.home.dir", "C:\\hadoop-2.7.2"); val spark = SparkSess ...

- ML 逻辑回归 Logistic Regression

逻辑回归 Logistic Regression 1 分类 Classification 首先我们来看看使用线性回归来解决分类会出现的问题.下图中,我们加入了一个训练集,产生的新的假设函数使得我们进行 ...

- 成功秀了一波scala spark ML逻辑斯蒂回归

1.直接上官方代码,调整过的,方可使用 package com.test import org.apache.spark.{SparkConf, SparkContext} import org.ap ...

- Spark LogisticRegression 逻辑回归之简介

LogisticRegression简介

随机推荐

- java开发,年薪15W的你和年薪50W的他的差距

在这个IT系统动辄就是上亿流量的时代,Java作为大数据时代应用最广泛的语言,诞生了一批又一批的新技术,包括HBase.Hadoop.MQ.Netty.SpringCloud等等 . 一些独角 ...

- 十大经典排序算法+sort排序

本文转自:十大经典排序算法,其中有动图+代码详解,本文简单介绍+个人理解. 排序算法 经典的算法问题,也是面试过程中经常被问到的问题.排序算法简单分类如下: 这些排序算法的时间复杂度等参数如下: 其中 ...

- 21天打造分布式爬虫-Crawl类爬取小程序社区(八)

8.1.Crawl的用法实战 新建项目 scrapy startproject wxapp scrapy genspider -t crawl wxapp_spider "wxapp-uni ...

- chrome如何添加扩展程序及登录

https://jingyan.baidu.com/album/7e440953191a2b2fc0e2ef0c.html?picindex=3

- 7z 程序打包 Demo

最近准备做一个用户端 异常收集的程序 需要收集用户机器的程序日志和相关信息 准备打包发回来 所以研究了一下7Z 文件压缩 做一个笔记吧 遇到的问题: 1:VS2008 遇到 loadlibrary ...

- 初入SpringBoot——使用IDEA构建最小SpringBootDemo

前言 从SpringBoot一出现,就开始关注这个东西了. 但是一直不敢使用,因为一个原则是刚出来的东西肯定有很多坑.而且之后会不会流行也需要时间的检验. 现在渐渐的时间检验之后,SpringBoot ...

- mysql表分区实战

一,什么是数据库分区以mysql为例,mysql数据库中的数据是以文件的形势存在磁盘上的,默认放在/mysql/data下面 (可以通过my.cnf中的datadir来查看),一张表主要对应着三个文件 ...

- 【机器学习】逻辑回归(Logistic Regression)

注:最近开始学习<人工智能>选修课,老师提纲挈领的介绍了一番,听完课只了解了个大概,剩下的细节只能自己继续摸索. 从本质上讲:机器学习就是一个模型对外界的刺激(训练样本)做出反应,趋利避害 ...

- [TensorFlow] Introducing TensorFlow Feature Columns

Welcome to Part 2 of a blog series that introduces TensorFlow Datasets and Estimators. We're devotin ...

- js-ES6学习笔记-const命令

1.const声明一个只读的常量.一旦声明,常量的值就不能改变. 2.const声明的变量不得改变值,这意味着,const一旦声明变量,就必须立即初始化,不能留到以后赋值. 3.const的作用域与l ...