tensorflow张量限幅

本篇内容有clip_by_value、clip_by_norm、gradient clipping

1.tf.clip_by_value

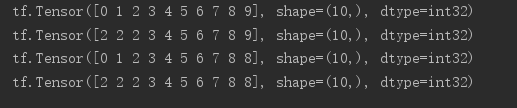

a = tf.range(10)

print(a)

# if x<a res=a,else x=x

print(tf.maximum(a,2))

# if x>a,res=a,else x=x

print(tf.minimum(a,8))

# 综合maximum和minimum两个函数的功能,指定上下限

print(tf.clip_by_value(a,2,8))

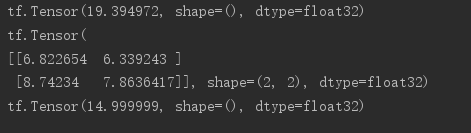

2.tf.clip_by_norm

# 随机生成一个2行2列的tensor

a = tf.random.normal([2,2],mean=10)

# 打印二范数

print(tf.norm(a))

# 根据新的norm进行放缩

print(tf.clip_by_norm(a,15))

print(tf.norm(tf.clip_by_norm(a,15)))

3.tf.clip_by_global_norm

# gradient clipping为解决梯度下降和梯度消失问题

# 可保证整体向量同时缩放(等倍数)

for g in grads:

grads,_ = tf.clip_by_global_norm(grads,15)

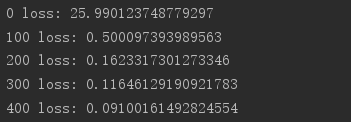

实测:

import tensorflow as tf

from tensorflow import keras

from tensorflow.keras import datasets, layers, optimizers

import os os.environ['TF_CPP_MIN_LOG_LEVEL']=''

print(tf.__version__) (x, y), _ = datasets.mnist.load_data()

x = tf.convert_to_tensor(x, dtype=tf.float32) / 50.

y = tf.convert_to_tensor(y)

y = tf.one_hot(y, depth=10)

print('x:', x.shape, 'y:', y.shape)

train_db = tf.data.Dataset.from_tensor_slices((x,y)).batch(128).repeat(30)

x,y = next(iter(train_db))

print('sample:', x.shape, y.shape)

# print(x[0], y[0]) def main(): # 784 => 512

w1, b1 = tf.Variable(tf.random.truncated_normal([784, 512], stddev=0.1)), tf.Variable(tf.zeros([512]))

# 512 => 256

w2, b2 = tf.Variable(tf.random.truncated_normal([512, 256], stddev=0.1)), tf.Variable(tf.zeros([256]))

# 256 => 10

w3, b3 = tf.Variable(tf.random.truncated_normal([256, 10], stddev=0.1)), tf.Variable(tf.zeros([10])) optimizer = optimizers.SGD(lr=0.01) for step, (x,y) in enumerate(train_db): # [b, 28, 28] => [b, 784]

x = tf.reshape(x, (-1, 784)) with tf.GradientTape() as tape: # layer1.

h1 = x @ w1 + b1

h1 = tf.nn.relu(h1)

# layer2

h2 = h1 @ w2 + b2

h2 = tf.nn.relu(h2)

# output

out = h2 @ w3 + b3

# out = tf.nn.relu(out) # compute loss

# [b, 10] - [b, 10]

loss = tf.square(y-out)

# [b, 10] => [b]

loss = tf.reduce_mean(loss, axis=1)

# [b] => scalar

loss = tf.reduce_mean(loss) # compute gradient

grads = tape.gradient(loss, [w1, b1, w2, b2, w3, b3])

# print('==before==')

# for g in grads:

# print(tf.norm(g)) grads, _ = tf.clip_by_global_norm(grads, 15) # print('==after==')

# for g in grads:

# print(tf.norm(g))

# update w' = w - lr*grad

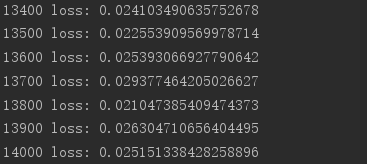

optimizer.apply_gradients(zip(grads, [w1, b1, w2, b2, w3, b3])) if step % 100 == 0:

print(step, 'loss:', float(loss)) if __name__ == '__main__':

main()

tensorflow张量限幅的更多相关文章

- AI - TensorFlow - 张量(Tensor)

张量(Tensor) 在Tensorflow中,变量统一称作张量(Tensor). 张量(Tensor)是任意维度的数组. 0阶张量:纯量或标量 (scalar), 也就是一个数值,例如,\'Howd ...

- Tensorflow张量

张量常规解释 张量(tensor)理论是数学的一个分支学科,在力学中有重要应用.张量这一术语起源于力学,它最初是用来表示弹性介质中各点应力状态的,后来张量理论发展成为力学和物理学的一个有力的数学工具. ...

- tensorflow 张量的阶、形状、数据类型及None在tensor中表示的意思。

x = tf.placeholder(tf.float32, [None, 784]) x isn't a specific value. It's a placeholder, a value th ...

- TensorFlow2.0(五):张量限幅

.caret, .dropup > .btn > .caret { border-top-color: #000 !important; } .label { border: 1px so ...

- tensorflow张量排序

本篇记录一下TensorFlow中张量的排序方法 tf.sort和tf.argsort # 声明tensor a是由1到5打乱顺序组成的 a = tf.random.shuffle(tf.range( ...

- TensorFlow—张量运算仿真神经网络的运行

import tensorflow as tf import numpy as np ts_norm=tf.random_normal([]) with tf.Session() as sess: n ...

- Tensorflow张量的形状表示方法

对输入或输出而言: 一个张量的形状为a x b x c x d,实际写出这个张量时: 最外层括号[…]表示这个是一个张量,无别的意义! 次外层括号有a个,表示这个张量里有a个样本 再往内的括号有b个, ...

- 121、TensorFlow张量命名

# tf.Graph对象定义了一个命名空间对于它自身包含的tf.Operation对象 # TensorFlow自动选择一个独一无二的名字,对于数据流图中的每一个操作 # 但是给操作添加一个描述性的名 ...

- 吴裕雄--天生自然TensorFlow2教程:张量限幅

import tensorflow as tf a = tf.range(10) a # a中小于2的元素值为2 tf.maximum(a, 2) # a中大于8的元素值为8 tf.minimum(a ...

随机推荐

- HDU_5692_dfs序+线段树

http://acm.hdu.edu.cn/showproblem.php?pid=5692 这道题真的是看了题解还搞了一天,把每条路径后序遍历按1-n重新标号,储存每个点在哪些路径中出现过(l和r数 ...

- Spark Streaming运行流程及源码解析(一)

本系列主要描述Spark Streaming的运行流程,然后对每个流程的源码分别进行解析 之前总听同事说Spark源码有多么棒,咱也不知道,就是疯狂点头.今天也来撸一下Spark源码. 对Spark的 ...

- 阿里云服务器ECS Ubuntu18.04 安装mysql

ubuntu系统好了,这下我应该安装MySQL数据库了.在安装过程中,遇到好多坑,下面是我的安装过程. 1.在阿里云控制台,用vnc登录到服务器. 用新的用户登录到Ubuntu用户系统. 打开终端: ...

- finalize的用法

public class GC { public static GC SAVE_HOOK = null; public static void main(Strin ...

- 【Java并发工具类】Java并发容器

前言 Java并发包有很大一部分都是关于并发容器的.Java在5.0版本之前线程安全的容器称之为同步容器.同步容器实现线程安全的方式:是将每个公有方法都使用synchronized修饰,保证每次只有一 ...

- nginx单个ip访问频率限制

一.限制所有单个ip的访问频率 1.http中的配置 http { #$limit_conn_zone:限制并发连接数 limit_conn_zone $binary_remote_addr zone ...

- k8s系列---资源指标API及自定义指标API

不得不说千万不要随意更改版本,我用的1.13的版本,然后学到这一步时,还因yaml文件不同,卡住了很久,然后各种google才找到解决办法 https://www.linuxea.com/2112. ...

- 领域驱动设计(DDD)实践之路(一)

本文首发于 vivo互联网技术 微信公众号 链接: https://mp.weixin.qq.com/s/gk-Hb84Dt7JqBRVkMqM7Eg 作者:张文博 领域驱动设计(Domain Dr ...

- bootstrap--网格化布局

1.响应式网格系统随着屏幕或视口(viewport)尺寸的增加,系统会自动分为最多12列 2.规则 行必须放置在 .container class 内,以便获得适当的对齐(alignment)和内边距 ...

- apue 外传

先上目录 chapter 3 [apue] dup2的正确打开方式 chapter 10 [apue] 等待子进程的那些事儿 chapter 14 [apue] 使用文件记录锁无法实现父子进程交互执行 ...