Python爬虫之lxml-etree和xpath的结合使用

本篇文章给大家介绍的是Python爬虫之lxml-etree和xpath的结合使用(附案例),内容很详细,希望可以帮助到大家。

lxml:python的HTML / XML的解析器

官网文档:https://lxml.de/

使用前需要安装lxml包

终端输入(win7.8,10在cmd输入)pip install -i https://pypi.tuna.tsinghua.edu.cn/simple lxml

功能:

1 解析html:使用etree.html(text)将字符串格式的 html片段解析成 html 文档

2 读取xml文件

3 etree和xpath配合使用(本文主要介绍)

示例:etree和xpath配合使用

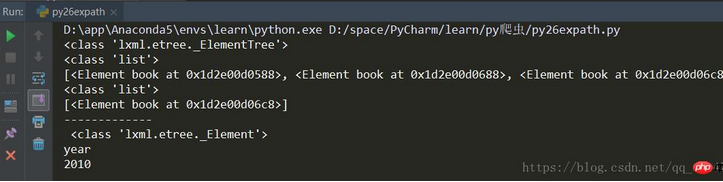

# lxml-etree读取文件from lxml import etreexml = etree.parse("./py24.xml")print(type(xml))# 查找所有 book 节点rst = xml.xpath('//book')print(type(rst))print(rst)# 查找带有 category 属性值为 sport 的元素rst2 = xml.xpath('//book[@category="sport"]')print(type(rst2))print(rst2)# 查找带有category属性值为sport的元素的book元素下到的year元素rst3 = xml.xpath('//book[@category="sport"]/year')rst3 = rst3[0]print('-------------\n',type(rst3))print(rst3.tag)print(rst3.text)

结果:

示例:使用lxml解析html代码

# 先安装lxml# 用 lxml 来解析HTML代码from lxml import etreetext = '''<p><ul><li class="item-0"><a href="0.html">item 0 </a></li><li class="item-1"><a href="1.html">item 1 </a></li><li class="item-2"><a href="2.html">item 2 </a></li><li class="item-3"><a href="3.html">item 3 </a></li><li class="item-4"><a href="4.html">item 4 </a></li><li class="item-5"><a href="5.html">item 5 </a></li></ul> </p>'''# 利用 etree.HTML 把字符串解析成 HTML 文件html = etree.HTML(text)s = etree.tostring(html).decode()print(s)

结果:

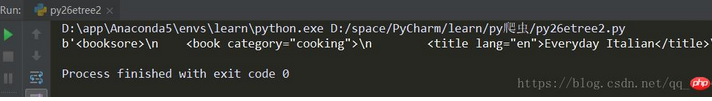

示例:读取xml文件

# lxml-etree读取文件from lxml import etreexml = etree.parse("./py24.xml")sxml = etree.tostring(xml, pretty_print=True)print(sxml)

结果:

Python爬虫之lxml-etree和xpath的结合使用的更多相关文章

- 小白学 Python 爬虫(20):Xpath 进阶

人生苦短,我用 Python 前文传送门: 小白学 Python 爬虫(1):开篇 小白学 Python 爬虫(2):前置准备(一)基本类库的安装 小白学 Python 爬虫(3):前置准备(二)Li ...

- 小白学 Python 爬虫(19):Xpath 基操

人生苦短,我用 Python 前文传送门: 小白学 Python 爬虫(1):开篇 小白学 Python 爬虫(2):前置准备(一)基本类库的安装 小白学 Python 爬虫(3):前置准备(二)Li ...

- 爬虫之lxml - etree - xpath的使用

# 解析原理: # - 获取页面源码数据 # - 实例化一个etree对象,并且将页面源码数据加载到该对象中 # - 调用该对象的xpath方法进行指定标签定位 # - xpath函数必须结合着xpa ...

- python爬虫入门(三)XPATH和BeautifulSoup4

XML和XPATH 用正则处理HTML文档很麻烦,我们可以先将 HTML文件 转换成 XML文档,然后用 XPath 查找 HTML 节点或元素. XML 指可扩展标记语言(EXtensible Ma ...

- Python 爬虫 解析库的使用 --- XPath

一.使用XPath XPath ,全称XML Path Language,即XML路径语言,它是一门在XML文档中查找信息的语言.它最初是用来搜寻XML文档的,但是它同样适用于HTML文档的搜索. 所 ...

- Python爬虫——使用 lxml 解析器爬取汽车之家二手车信息

本次爬虫的目标是汽车之家的二手车销售信息,范围是全国,不过很可惜,汽车之家只显示100页信息,每页48条,也就是说最多只能够爬取4800条信息. 由于这次爬虫的主要目的是使用lxml解析器,所以在信息 ...

- Python爬虫使用lxml模块爬取豆瓣读书排行榜并分析

上次使用了BeautifulSoup库爬取电影排行榜,爬取相对来说有点麻烦,爬取的速度也较慢.本次使用的lxml库,我个人是最喜欢的,爬取的语法很简单,爬取速度也快. 本次爬取的豆瓣书籍排行榜的首页地 ...

- python爬虫三大解析库之XPath解析库通俗易懂详讲

目录 使用XPath解析库 @(这里写自定义目录标题) 使用XPath解析库 1.简介 XPath(全称XML Path Languang),即XML路径语言,是一种在XML文档中查找信息的语言. ...

- Python爬虫:数据解析 之 xpath

资料: W3C标准:https://www.w3.org/TR/xpath/all/ W3School:https://www.w3school.com.cn/xpath/index.asp 菜鸟教程 ...

- Python爬虫教程-22-lxml-etree和xpath配合使用

Python爬虫教程-22-lxml-etree和xpath配合使用 lxml:python 的HTML/XML的解析器 官网文档:https://lxml.de/ 使用前,需要安装安 lxml 包 ...

随机推荐

- Java知识复习(一)

Java面向对象的三大特性: 封装.继承.多态. super()与this()的区别? This():当前类的实例,一个类,如果继承了父类,那么通过this既可以访问当前类的属性和方法,也可以访问父类 ...

- JMeter定时器种类+详细教程举例

首先,我们先了解一下定时器的常见种类以及它的作用. 原文地址:https://www.cnblogs.com/istart/p/11184533.html 一.定时器种类+作用 上面是我截图的自己有道 ...

- 『心善渊』Selenium3.0基础 — 6、Selenium中使用XPath定位元素

目录 1.Selenium中使用XPath查找元素 (1)XPath通过id,name,class属性定位 (2)XPath通过标签中的其他属性定位 (3)XPath层级定位 (4)XPath索引定位 ...

- 机械革命z2安装ubuntu20

为了性能买了个游戏本机械革命z2,但还是想用上linux,身为程序员习惯了linux的开发环境有点离不开.但是之前尝试安装deepin或者linux都失败了,一是N卡条件下安装过程和安装之后的显示有问 ...

- gRPC(2):四种基本通信模式

在 gRPC(1):入门及简单使用(go) 中,我们实现了一个简单的 gRPC 应用程序,其中双方通信是简单的请求-响应模式,没发出一个请求都会得到一个响应,然而,借助 gRPC 可以实现不同的通信模 ...

- [HTML]常用的文本标签(标题、段落、加粗、下划线等标签)

标签类型 写法 说明 标题 <h1></h1>......<h6></h6> 加粗.独占一行(块级元素) 段落 <p></p> ...

- NuGet微软官方中国镜像地址

https://nuget.cdn.azure.cn/v3/index.json

- 21、部署heartbeat

21.1.heartbeat部署规划: 本文的实验环境是虚拟机设备: 名称 接口 ip 用途 master-db(主) eth0 10.0.0.16/24 用于服务器之间的心跳连接(直连) eth1 ...

- uniapp 微信小程序 生成二维码

使用 tki-qrcode组件 生成二维码(https://www.npmjs.com/package/tki-qrcode) 1.引入 tki-qrcode 下载组件后引入 import tkiQr ...

- 【玩转 WordPress】基于 Serverless 搭建个人博客图文教程,学生党首选!

以下内容来自「玩转腾讯云」用户原创文章,已获得授权. 01. 什么是 Serverless? 1. Serverless 官方定义 Serverless 中的 Server是服务器的意思,less 是 ...