准确率、精确率、召回率、F-Measure、ROC、AUC

先理解一下正类(Positive)和负类(Negetive),比如现在要预测用户是否点击了某个广告链接,点击了才是我们要的结果,这时,点击了则表示为正类,没点击则表示为负类。

TP(True Positive):被预测成了正类的正类,即正确预测的正类

FP(False Positive):被预测成了正类的负类

TN(True Negetive):被预测成了负类的负类,即正确预测的负类

FN(False Negetive):被预测成了负类的正类

一、准确率(Accuracy)

准确率跟正类负类没多大关系,表示在预测结果中,正确预测的数量 / 样本总数。

二、精确率(Precision)

在预测结果中,正确预测的正类数 / 预测为正类的数量 : TP / (TP+FP)

三、召回率(Recall)

在预测结果中,正确预测的正类数 / 原本即为正类的数量 : TP / (TP+FN)

四、F-Measure

用precision和recall两个指标不直观,索性把他们合并为一个变量——F-measure:Recall * Precision * 2 / (Recall + Precision)(越大越好,1为理想状态,此时precision为1,recall为1)

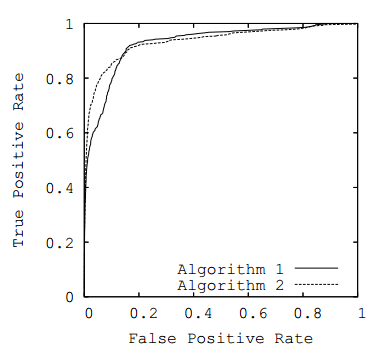

五、ROC

ROC曲线是以 FP Rate 为横轴,TP Rate 为纵轴的曲线。如下图所示

图片来源:https://www.cnblogs.com/haoguoeveryone/p/haoguo_5.html

六、AUC

AUC 即 ROC 曲线对应的面积,面积越大越好。

七、疑问

ROC曲线理想情况下,应该是TP Rate越接近1,FP Rate越接近0更好才对。但对应于AUC,应该是曲线越靠近左上方AUC越大,曲线越靠近右下方AUC越小。这样就显得有点矛盾了,有点搞不清楚,是不是曲线呈现下降趋势才是正确的?希望有大神看到了帮我一下,谢谢!感激不尽!

准确率、精确率、召回率、F-Measure、ROC、AUC的更多相关文章

- 准确率,召回率,F值,ROC,AUC

度量表 1.准确率 (presion) p=TPTP+FP 理解为你预测对的正例数占你预测正例总量的比率,假设实际有90个正例,10个负例,你预测80(75+,5-)个正例,20(15+,5-)个负例 ...

- 机器学习算法中的准确率(Precision)、召回率(Recall)、F值(F-Measure)

摘要: 数据挖掘.机器学习和推荐系统中的评测指标—准确率(Precision).召回率(Recall).F值(F-Measure)简介. 引言: 在机器学习.数据挖掘.推荐系统完成建模之后,需要对模型 ...

- 评估指标:准确率(Precision)、召回率(Recall)以及F值(F-Measure)

为了能够更好的评价IR系统的性能,IR有一套完整的评价体系,通过评价体系可以了解不同信息系统的优劣,不同检索模型的特点,不同因素对信息检索的影响,从而对信息检索进一步优化. 由于IR的目标是在较短时间 ...

- 推荐系统评测指标—准确率(Precision)、召回率(Recall)、F值(F-Measure)

下面简单列举几种常用的推荐系统评测指标: 1.准确率与召回率(Precision & Recall) 准确率和召回率是广泛用于信息检索和统计学分类领域的两个度量值,用来评价结果的质量.其中精度 ...

- 推荐系统评测指标--准确率(Precision)和召回率(Recall)、F值(F-Measure)

转自http://bookshadow.com/weblog/2014/06/10/precision-recall-f-measure/ 1,准确率和召回率是广泛应用于信息检索和统计学分类领域的两个 ...

- 准确率(Precision)、召回率(Recall)以及F值(F-Measure)

转载自:http://blog.csdn.net/yechaodechuntian/article/details/37394967 https://www.zhihu.com/question/19 ...

- 准确率(Accuracy), 精确率(Precision), 召回率(Recall)和F1-Measure

yu Code 15 Comments 机器学习(ML),自然语言处理(NLP),信息检索(IR)等领域,评估(Evaluation)是一个必要的 工作,而其评价指标往往有如下几点:准确率(Accu ...

- 信息检索(IR)的评价指标介绍 - 准确率、召回率、F1、mAP、ROC、AUC

原文地址:http://blog.csdn.net/pkueecser/article/details/8229166 在信息检索.分类体系中,有一系列的指标,搞清楚这些指标对于评价检索和分类性能非常 ...

- [机器学习] 性能评估指标(精确率、召回率、ROC、AUC)

混淆矩阵 介绍这些概念之前先来介绍一个概念:混淆矩阵(confusion matrix).对于 k 元分类,其实它就是一个k x k的表格,用来记录分类器的预测结果.对于常见的二元分类,它的混淆矩阵是 ...

- 一文让你彻底理解准确率,精准率,召回率,真正率,假正率,ROC/AUC

参考资料:https://zhuanlan.zhihu.com/p/46714763 ROC/AUC作为机器学习的评估指标非常重要,也是面试中经常出现的问题(80%都会问到).其实,理解它并不是非常难 ...

随机推荐

- Asis CTF 2016 b00ks理解

---恢复内容开始--- 最近在学习堆的off by one,其中遇到这道题,萌新的我弄了大半天才搞懂,网上的很多wp都不是特别详细,都得自己好好调试. 首先,这题目是一个常见的图书馆管理系统,虽然我 ...

- Ajax与Http协议

目录 Ajax与Http协议详解 Xhr对象 xhr对象发送请求整体感知 xhr对象的常用属性和方法 xhr对象发送post请求 xhr对象的兼容性问题 请求超时timeout与监听超时ontimeo ...

- IdentityServer4 保护.net framework webapi

一.IS4服务器配置 1.新建一个Asp.net Core MVC程序,模板选择 Empty 2.Nuget添加 IdentityServer4,我这里添加的是2.5.3 3.添加Config文件, ...

- 在Asp.Net Core MVC 开发过程中遇到的问题

1. Q: Razor视图中怎么添加全局模型验证消息 #### A:使用ModelOnly <div asp-validation-summary="ModelOnly" c ...

- 【10分钟学Spring】:(一)初识Spring框架

简介 Spring是一个轻量级的企业级的Java开发框架.主要是用来替代原来更加重量级的企业级Java技术,比如EJB(Enterprise JavaBean).Java数据对象(Java Data ...

- Day01-初识 Python

1.CPU/内存/硬盘/操作系统 CPU :计算机的运算和处理中心,相当于人类的大脑. 内存 :暂时存储数据,临时加载数据应用程序. 硬盘 :长期存储数据. 操作系统:一个软件,连接计算机的硬件与所有 ...

- elastic search(es)安装

全文搜索属于最常见的需求,开源的 Elasticsearch (以下简称 Elastic)是目前全文搜索引擎的首选. 它可以快速地储存.搜索和分析海量数据.维基百科.Stack Overflow.Gi ...

- 顺序表-C语言实现

顺序存储线性表的结构体: #define MAXSIZE 100 //数组最大长度 typedef int ElemType; //元素类型 typedef struct //定义线性表结构体 { E ...

- 微信小程序——事件冒泡

在微信小程序的事件分为冒泡事件和非冒泡事件: 冒泡事件:当一个组件上的事件被触发后,该事件会向父节点传递. 非冒泡事件:当一个组件上的事件被触发后,该事件不会向父节点传递. WXML的冒泡事件列表: ...

- css练习——两列左窄右kuan型

<!DOCTYPE html><html lang="en"><head> <meta charset="UTF-8" ...