scrapy框架爬取开源中国项目大厅所有的发布项目。

本文爬取的字段,项目名称,发布时间,项目周期,应用领域,最低报价,最高报价,技术类型

1,items中定义爬取字段。

import scrapy class KaiyuanzhongguoItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

name = scrapy.Field()

publishTime = scrapy.Field()

cycle = scrapy.Field()

application = scrapy.Field()

budgetMinByYuan = scrapy.Field()

budgetMaxByYuan = scrapy.Field()

ski = scrapy.Field()

2, 爬虫主程序

# -*- coding: utf-8 -*-

import scrapy

import json

from kaiyuanzhongguo.items import KaiyuanzhongguoItem

class KyzgSpider(scrapy.Spider):

name = 'kyzg'

# allowed_domains = ['www.xxx.com']

base_url = 'https://zb.oschina.net/project/contractor-browse-project-and-reward?pageSize=10¤tPage='

start_urls = ['https://zb.oschina.net/project/contractor-browse-project-and-reward?pageSize=10¤tPage=1']

def parse(self, response):

result = json.loads(response.text)

totalpage = result['data']['totalPage']

for res in result['data']['data']:

item = KaiyuanzhongguoItem()

item['name'] = res['name']

item['publishTime'] = res['publishTime']

item['cycle'] = res['cycle']

item['application'] = res['application']

item['budgetMinByYuan'] = res['budgetMinByYuan']

item['budgetMaxByYuan'] = res['budgetMaxByYuan']

skillList = res['skillList']

skill = []

item['ski'] = ''

if skillList:

for sk in skillList:

skill.append(sk['value'])

item['ski'] = ','.join(skill)

yield item

for i in range(2,totalpage+1):

url_info = self.base_url+str(i)

yield scrapy.Request(url=url_info,callback=self.parse)

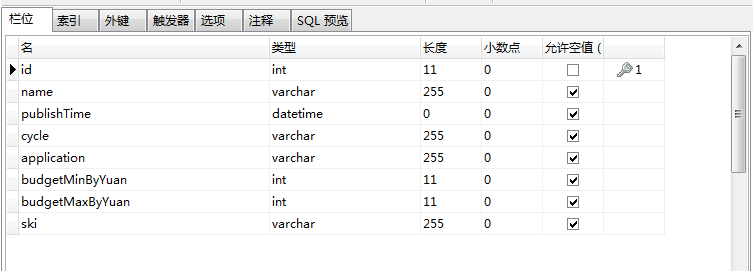

3,数据库设计

4,pipelines.py文件中写入mysql数据库

# 写入mysql数据库

import pymysql

class KaiyuanzhongguoPipeline(object):

conn = None

mycursor = None def open_spider(self, spider):

self.conn = pymysql.connect(host='172.16.25.4', user='root', password='root', db='scrapy')

self.mycursor = self.conn.cursor() def process_item(self, item, spider):

print(':正在写数据库...')

sql = 'insert into kyzg VALUES (null,"%s","%s","%s","%s","%s","%s","%s")' % (

item['name'], item['publishTime'], item['cycle'], item['application'], item['budgetMinByYuan'], item['budgetMaxByYuan'], item['ski'])

bool = self.mycursor.execute(sql)

self.conn.commit()

return item def close_spider(self, spider):

print('写入数据库完成...')

self.mycursor.close()

self.conn.close()

5,settings.py文件中设置请求头和打开下载管道

USER_AGENT = 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/39.0.2171.71 Safari/537.36'

ITEM_PIPELINES = {

'kaiyuanzhongguo.pipelines.KaiyuanzhongguoPipeline': 300,

}

6,运行爬虫

scrapy crawl kyzg --nolog

7,查看数据库是否写入成功

done。

scrapy框架爬取开源中国项目大厅所有的发布项目。的更多相关文章

- 使用scrapy框架爬取自己的博文(2)

之前写了一篇用scrapy框架爬取自己博文的博客,后来发现对于中文的处理一直有问题- - 显示的时候 [u'python\u4e0b\u722c\u67d0\u4e2a\u7f51\u9875\u76 ...

- scrapy框架爬取笔趣阁

笔趣阁是很好爬的网站了,这里简单爬取了全部小说链接和每本的全部章节链接,还想爬取章节内容在biquge.py里在加一个爬取循环,在pipelines.py添加保存函数即可 1 创建一个scrapy项目 ...

- scrapy框架爬取笔趣阁完整版

继续上一篇,这一次的爬取了小说内容 pipelines.py import csv class ScrapytestPipeline(object): # 爬虫文件中提取数据的方法每yield一次it ...

- Python使用Scrapy框架爬取数据存入CSV文件(Python爬虫实战4)

1. Scrapy框架 Scrapy是python下实现爬虫功能的框架,能够将数据解析.数据处理.数据存储合为一体功能的爬虫框架. 2. Scrapy安装 1. 安装依赖包 yum install g ...

- 爬虫入门(四)——Scrapy框架入门:使用Scrapy框架爬取全书网小说数据

为了入门scrapy框架,昨天写了一个爬取静态小说网站的小程序 下面我们尝试爬取全书网中网游动漫类小说的书籍信息. 一.准备阶段 明确一下爬虫页面分析的思路: 对于书籍列表页:我们需要知道打开单本书籍 ...

- 基于python的scrapy框架爬取豆瓣电影及其可视化

1.Scrapy框架介绍 主要介绍,spiders,engine,scheduler,downloader,Item pipeline scrapy常见命令如下: 对应在scrapy文件中有,自己增加 ...

- scrapy框架爬取糗妹妹网站妹子图分类的所有图片

爬取所有图片,一个页面的图片建一个文件夹.难点,图片中有不少.gif图片,需要重写下载规则, 创建scrapy项目 scrapy startproject qiumeimei 创建爬虫应用 cd qi ...

- scrapy框架爬取妹子图片

首先,建立一个项目#可在github账户下载完整代码:https://github.com/connordb/scrapy-jiandan2 scrapy startproject jiandan2 ...

- 使用scrapy框架爬取自己的博文(3)

既然如此,何不再抓一抓网页的文字内容呢? 谷歌浏览器有个审查元素的功能,就是按树的结构查看html的组织形式,如图: 这样已经比较明显了,博客的正文内容主要在div 的class = cnblogs_ ...

随机推荐

- Redis 分布式锁,C#通过Redis实现分布式锁(转)

目录(?)[+] 分布式锁一般有三种实现方式: 可靠性 分布式锁一般有三种实现方式: 1. 数据库乐观锁; 2. 基于Redis的分布式锁; 3. 基于ZooKeeper的分布式锁.本篇博客将介绍 ...

- 通Shell获取Tomcat进程号并杀死进程

#!/bin/bash echo "begin get tomcat8 pid" tomcat8_id=$( | grep -v grep | awk '{print $2}') ...

- Linux 就该这么学 CH03 管道符、重定向和环境变量

0 概述 1 输入输出重定向 重定向技术有5种模式: 标准覆盖输出重定向 标准追加输出重定向 错误覆盖输出重定向 错误追加输出重定向 输入重定向 输入重定向是将文件导入到命令中. 输出重定向是将输入到 ...

- WeakReference Reference ReferenceQueue

public class WeakReference<T> extends Reference<T> { public WeakReference(T referent) { ...

- 54 容器(九)——HashSet

HashSet的特点: 无序,不可重复. HashSet实现自Set,而Set继承自Collection,在日常使用中,我们都是以Set引用指向HashSet对象的方式. 所以,Set中的方法是我们主 ...

- C语言conio.h部分解释

#include <conio.h> int getch(void);// 从控制台得到下一个字符,以ASCII值返回,并不在屏幕显示该字符 int getche(void);// 从控制 ...

- Oracle--(Hierarchical Queries)层级查询(用于部门层级等)

原网址:https://www.cnblogs.com/guofeiji/p/5291486.html 如果表中包含层级数据,可以使用层级查询子句按层级顺序选择数据行,形成层级树,形式如下: 下面是层 ...

- AGC037

Contest page A Tag:贪心 猜想段的长度只会有$1$和$2$(感性理解,应该可以反证--),然后就可以DP/贪心了 B Tag:贪心.组合 考虑如何构造合法方案.从右往左考虑球,因为当 ...

- 移动端开发rem布局之less+媒体查询布局的原理步骤和心得

rem即是以html文件中font-size的大小的倍数rem布局的原理:通过媒体查询设置不同屏幕宽度下的html的font-size大小,然后在css布局时用rem单位取代px,从而实现页面元素大小 ...

- springmvc框架helloword

spring框架提供了构建web的应用程序的全功能MVC模块-spring mvc.我们首先来写一个springmvc的hellword的配置文件的形式 工程结构如下 index.jsp <%@ ...