15.sqoop数据从mysql里面导入到HDFS里面

表数据

在mysql中有一个库userdb中三个表:emp, emp_add和emp_contact

表emp

|

id |

name |

deg |

salary |

dept |

|

1201 |

gopal |

manager |

50,000 |

TP |

|

1202 |

manisha |

Proof reader |

50,000 |

TP |

|

1203 |

khalil |

php dev |

30,000 |

AC |

|

1204 |

prasanth |

php dev |

30,000 |

AC |

|

1205 |

kranthi |

admin |

20,000 |

TP |

表emp_add:

|

id |

hno |

street |

city |

|

1201 |

288A |

vgiri |

jublee |

|

1202 |

108I |

aoc |

sec-bad |

|

1203 |

144Z |

pgutta |

hyd |

|

1204 |

78B |

old city |

sec-bad |

|

1205 |

720X |

hitec |

sec-bad |

表emp_conn:

|

id |

phno |

|

|

1201 |

2356742 |

gopal@tp.com |

|

1202 |

1661663 |

manisha@tp.com |

|

1203 |

8887776 |

khalil@ac.com |

|

1204 |

9988774 |

prasanth@ac.com |

|

1205 |

1231231 |

kranthi@tp.com |

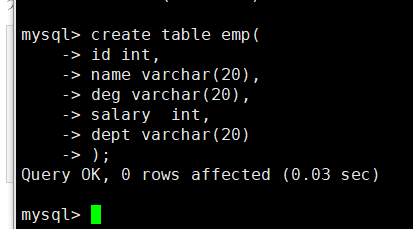

分别创建三个表

create table emp(

id int,

name varchar(),

deg varchar(),

salary int,

dept varchar()

);

导入数据

insert into emp values(,'gopal','manager',,'TP');

insert into emp values(,' manisha ',' Proof reader',,'TP');

insert into emp values(,' khalil','php dev',,'AC');

insert into emp values(,' prasanth',' php dev',,'AC');

insert into emp values(,' kranthi',' admin',,'TP');

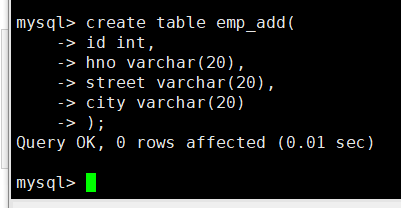

create table emp_add(

id int,

hno varchar(),

street varchar(),

city varchar()

);

导入数据

insert into emp_add values(,'288A','vgiri','jublee');

insert into emp_add values(,'','aoc','sec-bad');

insert into emp_add values(,'144Z','pguttai','hyd');

insert into emp_add values(,'78B','old city','sec-bad');

insert into emp_add values(,'720X','hitec','sec-bad');

create table emp_conn(

id int,

phno int,

email varchar()

);

导入数据

insert into emp_conn values(,'','gopal@tp.com');

insert into emp_conn values(,'','manisha@tp.com');

insert into emp_conn values(,'','khalil@ac.com');

insert into emp_conn values(,'','prasanth@ac.com');

insert into emp_conn values(,'','kranthi@tp.com');

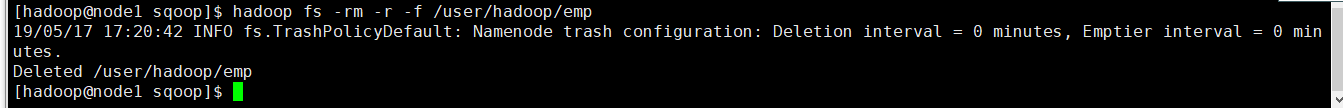

删除HDFS的目录

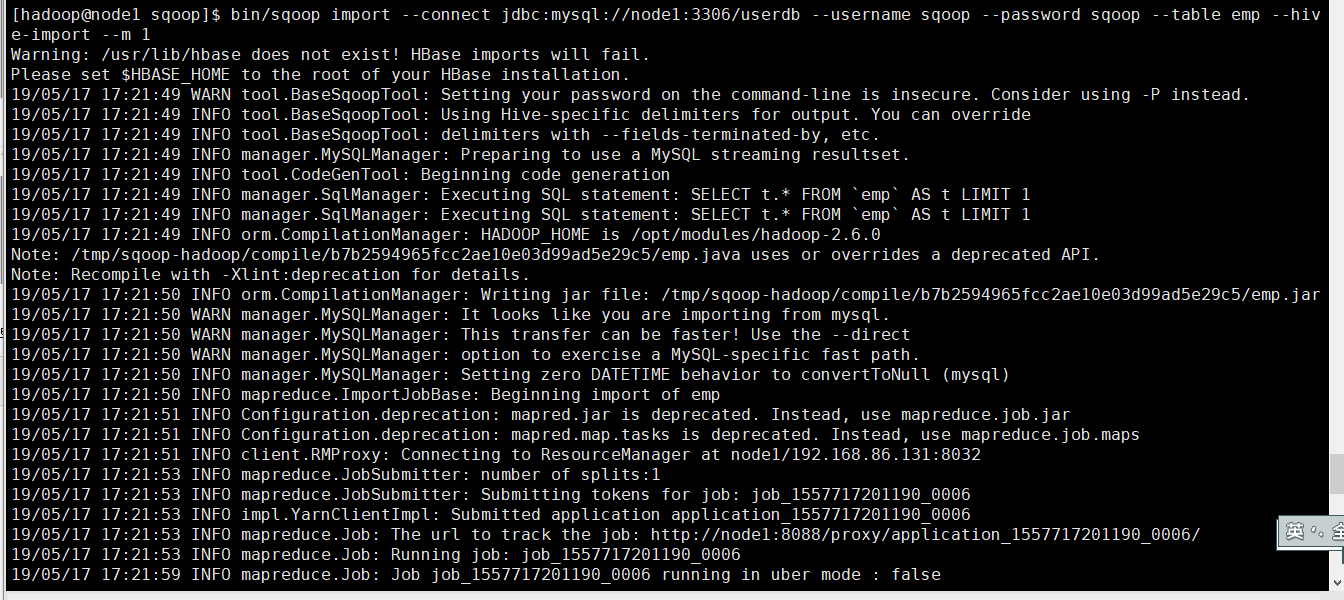

从MySQL数据库服务器中的emp表导入HDFS

bin/sqoop import \

--connect jdbc:mysql://node1:3306/userdb \

--username sqoop \

--password sqoop \

--table emp --m

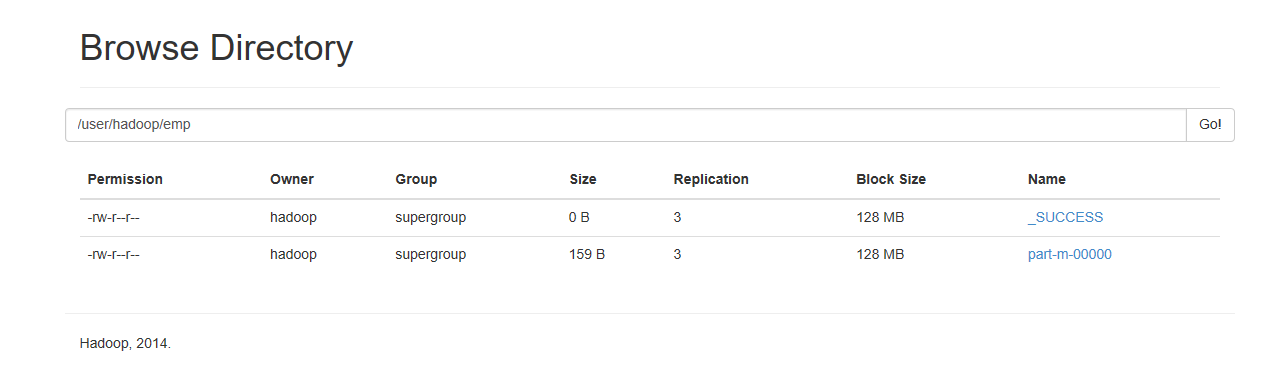

查看HDSF上的内容

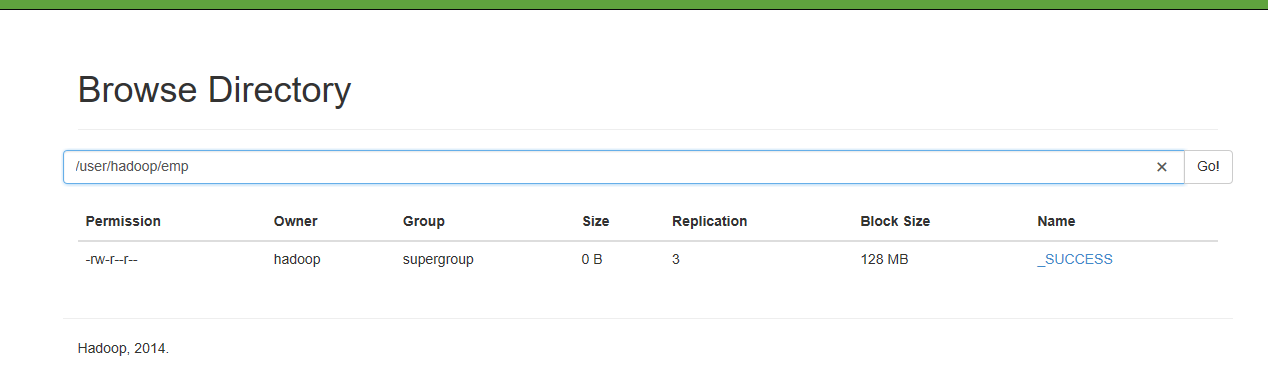

接下来把Mysql的数据导入到Hive里面

先启动Hive

在导入之前先把HDFS的/user/hadoop/emp删除,因为Hive的数据是存放在HDFS上

导入到hive表里面

[hadoop@node1 sqoop]$ bin/sqoop import --connect jdbc:mysql://node1:3306/userdb --username sqoop --password sqoop --table emp --hive-import --m 1

查看HDFS文件

查看hive里面的表

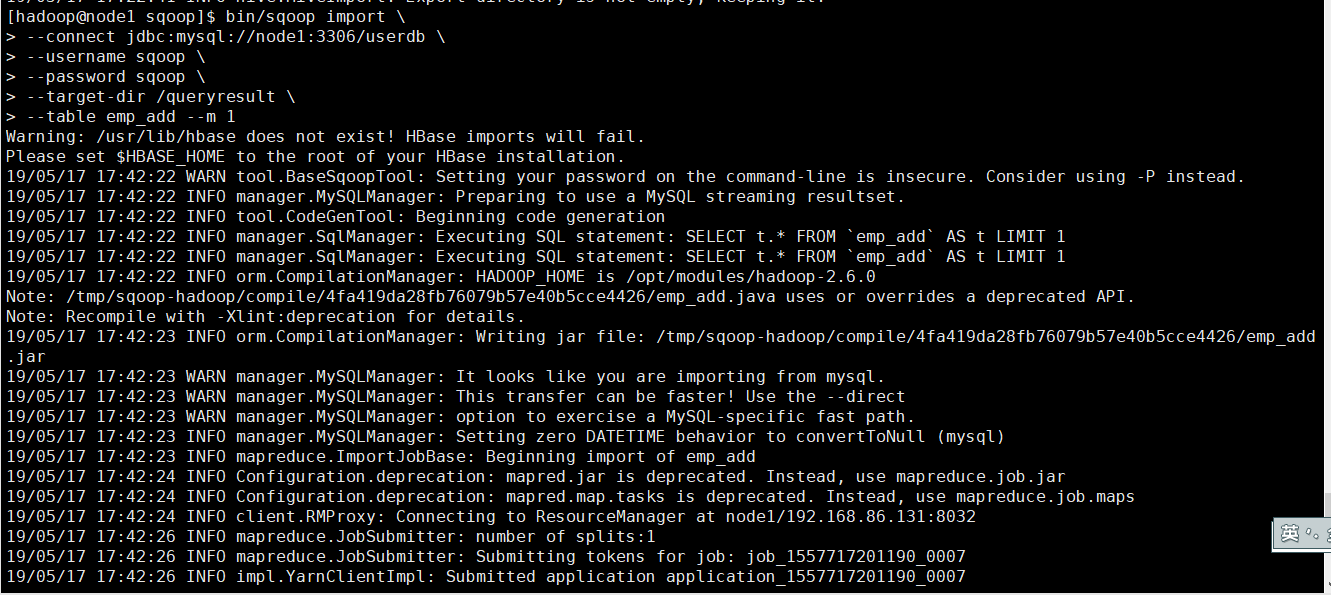

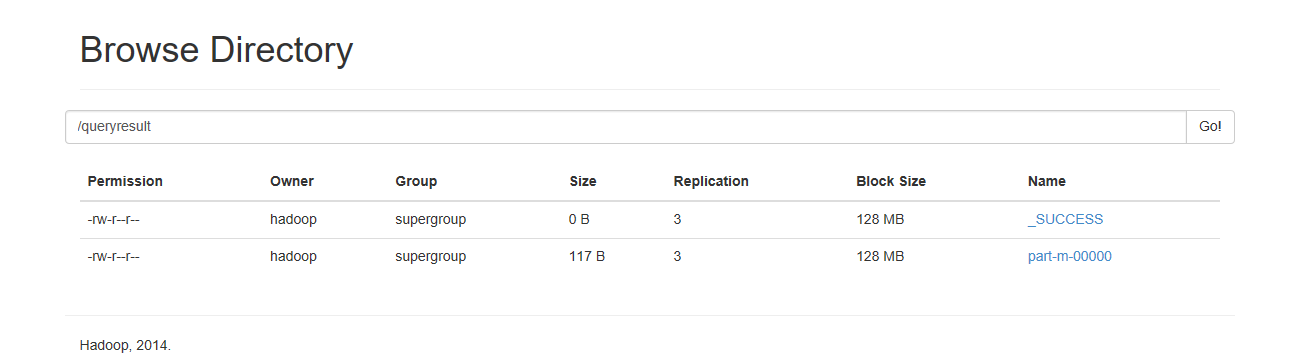

从mysql数据库中导入到HDFS中的指定目录

bin/sqoop import \

--connect jdbc:mysql://node1:3306/userdb \

--username sqoop \

--password sqoop \

--target-dir /queryresult \

--table emp_add --m

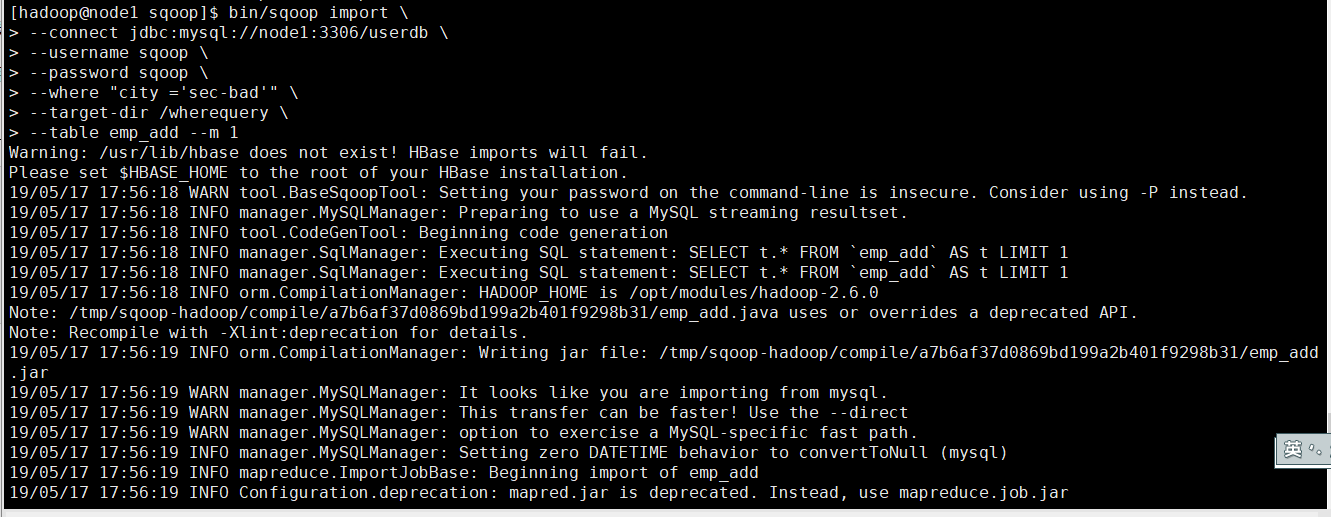

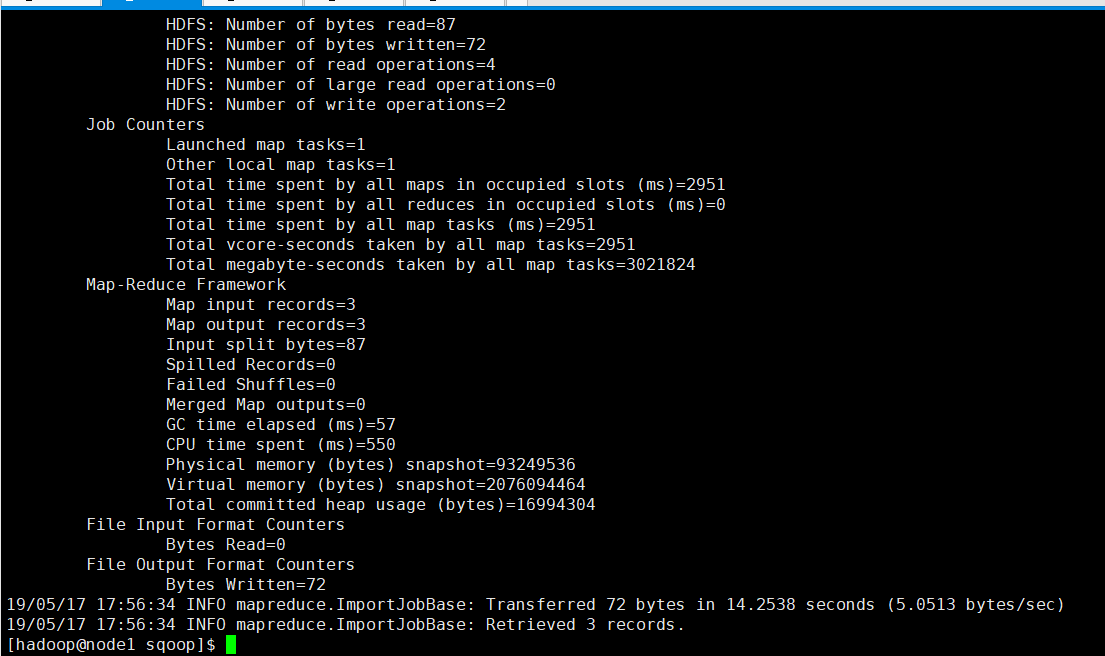

导入表数据子集

我们可以导入表的使用Sqoop导入工具,"where"子句的一个子集。它执行在各自的数据库服务器相应的SQL查询,并将结果存储在HDFS的目标目录。

下面的命令用来导入emp_add表数据的子集。子集查询检索员工ID和地址,居住城市为:Secunderabad

bin/sqoop import \

--connect jdbc:mysql://node1:3306/userdb \

--username sqoop \

--password sqoop \

--where "city ='sec-bad'" \

--target-dir /wherequery \

--table emp_add --m

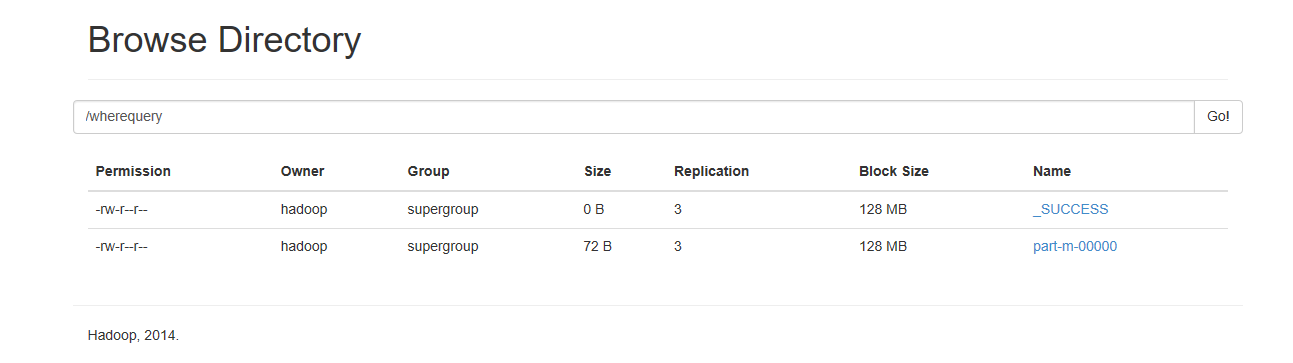

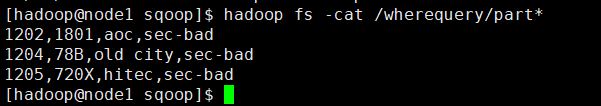

查看HDFS文件内容

15.sqoop数据从mysql里面导入到HDFS里面的更多相关文章

- 大数据之路week07--day07 (Sqoop 从mysql增量导入到HDFS)

我们之前导入的都是全量导入,一次性全部导入,但是实际开发并不是这样,例如web端进行用户注册,mysql就增加了一条数据,但是HDFS中的数据并没有进行更新,但是又再全部导入一次又完全没有必要. 所以 ...

- sqoop的使用之import导入到HDFS

原文链接: https://www.toutiao.com/i6772128429614563843/ 首先我们已经安装好sqoop了,如果没有安装好参考文档<快速搭建CDH-Hadoop-Hi ...

- Sqoop数据迁移工具的使用

文章作者:foochane 原文链接:https://foochane.cn/article/2019063001.html Sqoop数据迁移工具的使用 sqoop简单介绍 sqoop数据到HDF ...

- sqoop用法之mysql与hive数据导入导出

目录 一. Sqoop介绍 二. Mysql 数据导入到 Hive 三. Hive数据导入到Mysql 四. mysql数据增量导入hive 1. 基于递增列Append导入 1). 创建hive表 ...

- mysql数据与Hadoop之间导入导出之Sqoop实例

前面介绍了sqoop1.4.6的 如何将mysql数据导入Hadoop之Sqoop安装,下面就介绍两者间的数据互通的简单使用命令. 显示mysql数据库的信息,一般sqoop安装测试用 sqoop l ...

- sqoop:mysql和Hbase/Hive/Hdfs之间相互导入数据

1.安装sqoop 请参考http://www.cnblogs.com/Richardzhu/p/3322635.html 增加了SQOOP_HOME相关环境变量:source ~/.bashrc ...

- sqoop从hive导入数据到mysql时出现主键冲突

今天在将一个hive数仓表导出到mysql数据库时出现进度条一直维持在95%一段时间后提示失败的情况,搞了好久才解决.使用的环境是HUE中的Oozie的workflow任何调用sqoop命令,该死的o ...

- 利用sqoop将hive数据导入导出数据到mysql

一.导入导出数据库常用命令语句 1)列出mysql数据库中的所有数据库命令 # sqoop list-databases --connect jdbc:mysql://localhost:3306 ...

- 使用 sqoop 将mysql数据导入到hdfs(import)

Sqoop 将mysql 数据导入到hdfs(import) 1.创建mysql表 CREATE TABLE `sqoop_test` ( `id` ) DEFAULT NULL, `name` va ...

随机推荐

- MySQL基础练习01--牛客网

目录 1 查找最晚入职员工的信息 2 查找入职第三晚的员工信息 3 查找当前薪水详情及部门编号 4 查找所有员工入职时的薪水情况 5 查找已分配员工姓名 6 查找员工姓名 7 查找涨薪找过15次的员工 ...

- bbs-admin

目录 引入单例----单例补充 admin---url/注册的自定义配置 解析admin源码 django-admin注册账号-----创建超级用户 python manage.py createsu ...

- 解决vscode打开空白的问题

环境 :win7,最新vscode 问题:打开后窗口全黑,但是原按钮对应位置还有触摸手势,显示tag等,卸载重装等无效,如上图 最终方案: 启动方式后加 --disable-gpu 解决思路(其余参考 ...

- codeforces#1183H. Subsequences(字符串dp)

题目链接: http://codeforces.com/contest/1183/problem/H 题意: 给出一个长度为$n$的字符串,得到$k$个子串,子串$s$的花费是$n-|s|$ 计算最小 ...

- Educational Codeforces Round 64 (Rated for Div. 2) A,B,C,D,E,F

比赛链接: https://codeforces.com/contest/1156 A. Inscribed Figures 题意: 给出$n(2\leq n\leq 100)$个数,只含有1,2,3 ...

- CISCO实验记录五:静态路由与RIP动态路由

一.实验要求 1.创建设备间静态路由 2.检查三层连通性 3.清空路由,使用RIP创建动态路由 4.检查路由表 二.实验操作 1.创建设备静态路由 #iip route 192.168.1.0 255 ...

- git push and git pull

原文链接 git push 通常对于一个本地的新建分支,例如git checkout -b develop, 在develop分支commit了代码之后,如果直接执行git push命令,develo ...

- Nginx之核心结构体ngx_cycle_t

1. ngx_listening_t 结构体 ngx_cycle_t 对象中有一个动态数组成员叫做 listening,它的每个数组元素都是 ngx_listening_t 结构体,而每个 ngx_l ...

- Nslookup: command not found error on RHEL/CentOS 7

Reference: https://unix.stackexchange.com/questions/164210/nslookup-command-not-found-error-on-rhel- ...

- LeetCode 131. 分割回文串(Palindrome Partitioning)

题目描述 给定一个字符串 s,将 s 分割成一些子串,使每个子串都是回文串. 返回 s 所有可能的分割方案. 示例: 输入: "aab" 输出: [ ["aa" ...