python爬虫之scrapy安装(一)

简介:

安装环境:

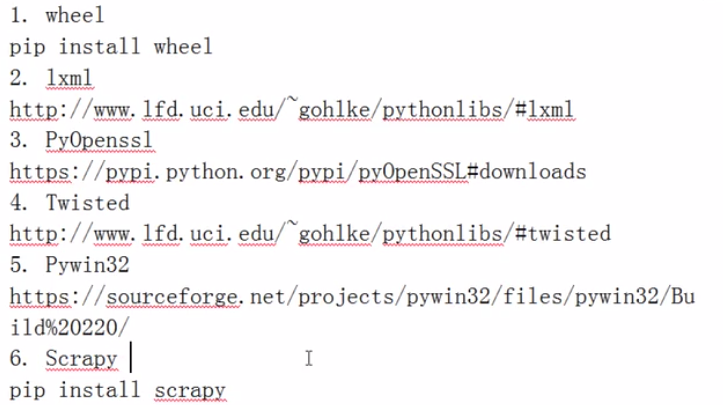

Windows安装:

注意:

1、从上往下依次安装依赖包,.whl文件直接pip3 install 文件绝对路径和名字即可安装

2、注意你的pip版本,下载9.0以上版本。

Linux:

下面是介绍Centos6.5版本安装,注意yum源的配置。

安装依赖包。

yum install python3-dev yum install -y python-dev python-pip libxml2-dev libxslt1-dev zlib1g-dev libffi-dev libssl-dev

检查pip版本是不是9.0.1

[root@localhost /]# pip3 --version

pip 9.0.1 from /usr/local/lib/python3.6/site-packages (python 3.6)

开始安装scrapy。(linux系统不像windows那样依赖包需要我们一个一个安装,它会自动安装所有需要安装的依赖包,省略了很多步骤和问题)

[root@localhost /]# pip3 install scrapy

Collecting scrapy

Downloading Scrapy-1.4.0-py2.py3-none-any.whl (248kB)

100% |████████████████████████████████| 256kB 29kB/s

Collecting PyDispatcher>=2.0.5 (from scrapy)

Downloading PyDispatcher-2.0.5.tar.gz

Collecting parsel>=1.1 (from scrapy)

Downloading parsel-1.2.0-py2.py3-none-any.whl

Collecting service-identity (from scrapy)

Downloading service_identity-17.0.0-py2.py3-none-any.whl

Collecting w3lib>=1.17.0 (from scrapy)

Downloading w3lib-1.18.0-py2.py3-none-any.whl

Collecting queuelib (from scrapy)

Downloading queuelib-1.4.2-py2.py3-none-any.whl

Collecting lxml (from scrapy)

Downloading lxml-4.1.0-cp36-cp36m-manylinux1_x86_64.whl (5.6MB)

100% |████████████████████████████████| 5.6MB 13kB/s

Collecting cssselect>=0.9 (from scrapy)

Downloading cssselect-1.0.1-py2.py3-none-any.whl

Collecting six>=1.5.2 (from scrapy)

Downloading six-1.11.0-py2.py3-none-any.whl

Collecting pyOpenSSL (from scrapy)

Downloading pyOpenSSL-17.3.0-py2.py3-none-any.whl (51kB)

100% |████████████████████████████████| 51kB 11kB/s

Collecting Twisted>=13.1.0 (from scrapy)

Downloading Twisted-17.9.0.tar.bz2 (3.0MB)

100% |████████████████████████████████| 3.0MB 20kB/s

Collecting attrs (from service-identity->scrapy)

Downloading attrs-17.2.0-py2.py3-none-any.whl

Collecting pyasn1-modules (from service-identity->scrapy)

Downloading pyasn1_modules-0.1.5-py2.py3-none-any.whl (60kB)

100% |████████████████████████████████| 61kB 79kB/s

Collecting pyasn1 (from service-identity->scrapy)

Downloading pyasn1-0.3.7-py2.py3-none-any.whl (63kB)

100% |████████████████████████████████| 71kB 87kB/s

Collecting cryptography>=1.9 (from pyOpenSSL->scrapy)

Downloading cryptography-2.1.2-cp36-cp36m-manylinux1_x86_64.whl (2.2MB)

100% |████████████████████████████████| 2.2MB 16kB/s

Collecting zope.interface>=4.0.2 (from Twisted>=13.1.0->scrapy)

Downloading zope.interface-4.4.3-cp36-cp36m-manylinux1_x86_64.whl (173kB)

100% |████████████████████████████████| 174kB 20kB/s

Collecting constantly>=15.1 (from Twisted>=13.1.0->scrapy)

Downloading constantly-15.1.0-py2.py3-none-any.whl

Collecting incremental>=16.10.1 (from Twisted>=13.1.0->scrapy)

Downloading incremental-17.5.0-py2.py3-none-any.whl

Collecting Automat>=0.3.0 (from Twisted>=13.1.0->scrapy)

Downloading Automat-0.6.0-py2.py3-none-any.whl

Collecting hyperlink>=17.1.1 (from Twisted>=13.1.0->scrapy)

Downloading hyperlink-17.3.1-py2.py3-none-any.whl (73kB)

100% |████████████████████████████████| 81kB 46kB/s

Collecting idna>=2.1 (from cryptography>=1.9->pyOpenSSL->scrapy)

Downloading idna-2.6-py2.py3-none-any.whl (56kB)

100% |████████████████████████████████| 61kB 48kB/s

Collecting asn1crypto>=0.21.0 (from cryptography>=1.9->pyOpenSSL->scrapy)

Downloading asn1crypto-0.23.0-py2.py3-none-any.whl (99kB)

100% |████████████████████████████████| 102kB 19kB/s

Collecting cffi>=1.7; platform_python_implementation != "PyPy" (from cryptography>=1.9->pyOpenSSL->scrapy)

Downloading cffi-1.11.2-cp36-cp36m-manylinux1_x86_64.whl (419kB)

100% |████████████████████████████████| 430kB 18kB/s

Requirement already satisfied: setuptools in /usr/local/lib/python3.6/site-packages (from zope.interface>=4.0.2->Twisted>=13.1.0->scrapy)

Collecting pycparser (from cffi>=1.7; platform_python_implementation != "PyPy"->cryptography>=1.9->pyOpenSSL->scrapy)

Downloading pycparser-2.18.tar.gz (245kB)

100% |████████████████████████████████| 256kB 62kB/s

Installing collected packages: PyDispatcher, six, w3lib, lxml, cssselect, parsel, idna, asn1crypto, pycparser, cffi, cryptography, pyOpenSSL, attrs, pyasn1, pyasn1-modules, service-identity, queuelib, zope.interface, constantly, incremental, Automat, hyperlink, Twisted, scrapy

Running setup.py install for PyDispatcher ... done

Running setup.py install for pycparser ... done

Running setup.py install for Twisted ... done

Successfully installed Automat-0.6.0 PyDispatcher-2.0.5 Twisted-17.9.0 asn1crypto-0.23.0 attrs-17.2.0 cffi-1.11.2 constantly-15.1.0 cryptography-2.1.2 cssselect-1.0.1 hyperlink-17.3.1 idna-2.6 incremental-17.5.0 lxml-4.1.0 parsel-1.2.0 pyOpenSSL-17.3.0 pyasn1-0.3.7 pyasn1-modules-0.1.5 pycparser-2.18 queuelib-1.4.2 scrapy-1.4.0 service-identity-17.0.0 six-1.11.0 w3lib-1.18.0 zope.interface-4.4.3

[root@localhost /]# python3

Python 3.6.3 (default, Oct 25 2017, 10:18:57)

[GCC 4.4.7 20120313 (Red Hat 4.4.7-4)] on linux

Type "help", "copyright", "credits" or "license" for more information.

>>> import scrapy

>>>

python爬虫之scrapy安装(一)的更多相关文章

- python爬虫的scrapy安装+pymongo的安装

我的:python2.7版本 32位 注意scrapy只支持2.7及以上的版本. 1.安装python 2.安装pip 安装pip就不赘述了,网上很多教学 pip安装时要注意更新,如果pip版本 ...

- python爬虫框架—Scrapy安装及创建项目

linux版本安装 pip3 install scrapy 安装完成 windows版本安装 pip install wheel 下载twisted,网址:http://www.lfd.uci.edu ...

- Python爬虫框架--Scrapy安装以及简单实用

scrapy框架 框架 -具有很多功能且具有很强通用性的一个项目模板 环境安装: Linux: pip3 install scrapy Windows: ...

- Python爬虫框架Scrapy安装使用步骤

一.爬虫框架Scarpy简介Scrapy 是一个快速的高层次的屏幕抓取和网页爬虫框架,爬取网站,从网站页面得到结构化的数据,它有着广泛的用途,从数据挖掘到监测和自动测试,Scrapy完全用Python ...

- Linux 安装python爬虫框架 scrapy

Linux 安装python爬虫框架 scrapy http://scrapy.org/ Scrapy是python最好用的一个爬虫框架.要求: python2.7.x. 1. Ubuntu14.04 ...

- 教你分分钟学会用python爬虫框架Scrapy爬取心目中的女神

本博文将带领你从入门到精通爬虫框架Scrapy,最终具备爬取任何网页的数据的能力.本文以校花网为例进行爬取,校花网:http://www.xiaohuar.com/,让你体验爬取校花的成就感. Scr ...

- 【转载】教你分分钟学会用python爬虫框架Scrapy爬取心目中的女神

原文:教你分分钟学会用python爬虫框架Scrapy爬取心目中的女神 本博文将带领你从入门到精通爬虫框架Scrapy,最终具备爬取任何网页的数据的能力.本文以校花网为例进行爬取,校花网:http:/ ...

- 0.Python 爬虫之Scrapy入门实践指南(Scrapy基础知识)

目录 0.0.Scrapy基础 0.1.Scrapy 框架图 0.2.Scrapy主要包括了以下组件: 0.3.Scrapy简单示例如下: 0.4.Scrapy运行流程如下: 0.5.还有什么? 0. ...

- Python爬虫框架Scrapy实例(三)数据存储到MongoDB

Python爬虫框架Scrapy实例(三)数据存储到MongoDB任务目标:爬取豆瓣电影top250,将数据存储到MongoDB中. items.py文件复制代码# -*- coding: utf-8 ...

随机推荐

- 数据库 schema含义

数据库Schema有两种含义,一种是概念上的Schema,指的是一组DDL语句集,该语句集完整地描述了数据库的结构.还有一种是物理上的Schema,指的是数据库中的一个名字空间,它包含一组表.视图和存 ...

- Visual Studio Code 支持TensorFlow配置支持

首先选择解释器 选择TensorFlow版本的conda版本 (当然你如果是通过python单独安装的TensorFlow也可以) 编辑器输入代码,进行测试 import tensorflow as ...

- python入门学习:3.操作列表

python入门学习:3.操作列表 关键点:列表 3.1 遍历整个列表3.2 创建数值列表3.3 使用列表3.4 元组 3.1 遍历整个列表 循环这种概念很重要,因为它是计算机自动完成重复工作的常 ...

- P1638 逛画展(直尺法)

这道题是直尺法的模板题: #include<iostream> using namespace std; ; ; int n, m, a[maxn], vis[M]; int main() ...

- Linux:Day11(上) ifcfg命令

将Linux主机接入到网络中: 配置方式: 静态指定: ifcfg:ifconfig,route,netstat ip:object{link,addr,route},ss,tc 配置文件:syste ...

- JavaScript模块化思想requireJS的使用

1. 使用require.js的意义 (1)实现JS文件的异步加载,避免网页因为加载JS文件缓慢造成网页未响应 (2)管理模块之间的依赖性,便于代码的编写和维护.页面中只需要引入require.j ...

- C语言中指针变量的加减运算

1.指针变量中存放的是地址值,也就是一个数字地址,例如某指针变量中的值是0x20000000,表示表示此指针变量存放的是内存中位于0x20000000地方的内存地址.指针变量可以加减,但是只能与整型数 ...

- spingMVC异步上传文件

框架是个强大的东西,一般你能想到的,框架都会帮你做了,然后只需要会用就行了,spingmvc中有处理异步请求的机制,而且跟一般处理请求的方法差别不大,只是多了一个注解:spingmvc也可以将stri ...

- Maven入门指南⑦:Maven的生命周期和插件

一个完整的项目构建过程通常包括清理.编译.测试.打包.集成测试.验证.部署等步骤,Maven从中抽取了一套完善的.易扩展的生命周期.Maven的生命周期是抽象的,其中的具体任务都交由插件来完成.Mav ...

- CSS实现树形结构 + js加载数据

看到一款树形结构,比较喜欢它的样式,就参照它的外观自己做了一个,练习一下CSS. 做出来的效果如下: li { position: relative; padding: 5px 0; margin:0 ...