tensorflow 之tf.nn.depthwise_conv2d and separable_conv2d实现及原理

Depthwise Separable Convolution

1.简介

Depthwise Separable Convolution 是谷歌公司于2017年的CVPR中在论文”Xception: deep learning with depthwise separable convolutions”中提出。

2.结构简介

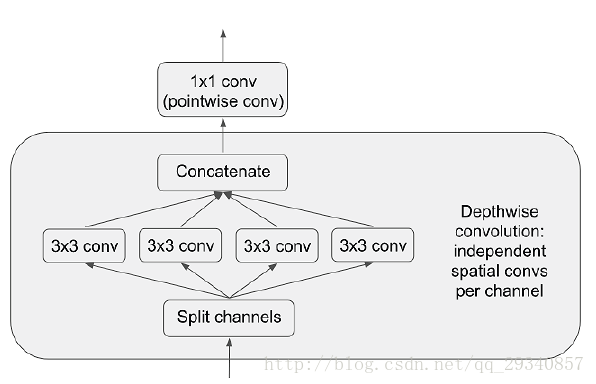

对输入图片进行分通道卷积后做1*1卷积。结构如下图:

举例来说,假设输入通道数64,输出通道数64.

传统的Conv2D方法的参数数量为3*3*64*64;而SeparableConv2D的参数数量为3*3*64+1*1*64*64。

3*3*64:对输入的64个通道分别进行卷积

1*1*64*64:对concat后的64个通道进行1*1卷积(pointwise Convolution)

结论:参数数量减少了32192个。

3.适用范围

假设输入图片的空间位置是相较于通道之间关系是高度相关的。

depthwise_conv2d来源于深度可分离卷积

tf.nn.depthwise_conv2d(input,filter,strides,padding,rate=None,name=None,data_format=None)除去name参数用以指定该操作的name,data_format指定数据格式,与方法有关的一共五个参数:

input:

指需要做卷积的输入图像,要求是一个4维Tensor,具有[batch, height, width, in_channels]这样的shape,具体含义是[训练时一个batch的图片数量, 图片高度, 图片宽度, 图像通道数]filter:

相当于CNN中的卷积核,要求是一个4维Tensor,具有[filter_height, filter_width, in_channels, channel_multiplier]这样的shape,具体含义是[卷积核的高度,卷积核的宽度,输入通道数,输出卷积乘子],同理这里第三维in_channels,就是参数value的第四维strides:

卷积的滑动步长。padding:

string类型的量,只能是”SAME”,”VALID”其中之一,这个值决定了不同边缘填充方式。rate:

这个参数的详细解释见【Tensorflow】tf.nn.atrous_conv2d如何实现空洞卷积?

结果返回一个Tensor,shape为[batch, out_height, out_width, in_channels * channel_multiplier],注意这里输出通道变成了in_channels * channel_multiplier

tf.nn.separable_conv2d

可以看做,深度卷积tf.nn.depthwise_conv2d的扩展

- tf.nn.separable_conv2d(input,depthwise_filter,pointwise_filter,strides,padding,rate=None,name=None,data_format=None)

除去name参数用以指定该操作的name,data_format指定数据格式,与方法有关的一共六个参数:

input:

指需要做卷积的输入图像,要求是一个4维Tensor,具有[batch, height, width, in_channels]这样的shape,具体含义是[训练时一个batch的图片数量, 图片高度, 图片宽度, 图像通道数]depthwise_filter:

用来做depthwise_conv2d的卷积核,也就是说这个函数对输入首先做了一个深度卷积。它的shape规定是[filter_height, filter_width, in_channels, channel_multiplier]pointwise_filter:

用来做pointwise卷积的卷积核,什么是pointwise卷积呢?我们可以把它和GoogLeNet最原始版本Inception结构中后面的1*1卷积核做channel降维来做对比,这里也是用1*1的卷积核,输入通道是depthwise_conv2d的输出通道也就是in_channels * channel_multiplier,输出通道数可以自己定义。因为前面(【Tensorflow】tf.nn.depthwise_conv2d如何实现深度卷积?)已经讲到过了,depthwise_conv2d是对输入图像的每一个channel分别做卷积输出的,那么这个操作我们可以看做是将深度卷积得到的分离的各个channel的信息做一个融合。它的shape规定是[1, 1, channel_multiplier * in_channels, out_channels]strides:

卷积的滑动步长。padding:

string类型的量,只能是”SAME”,”VALID”其中之一,这个值决定了不同边缘填充方式。- rate:

这个参数的详细解释见【Tensorflow】tf.nn.atrous_conv2d如何实现空洞卷积?

输出shape为[batch, out_height, out_width, out_channels]的Tensor

tensorflow 之tf.nn.depthwise_conv2d and separable_conv2d实现及原理的更多相关文章

- 【Tensorflow】tf.nn.depthwise_conv2d如何实现深度卷积?

版权声明:本文为博主原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接和本声明. 本文链接:https://blog.csdn.net/mao_xiao_feng/article/ ...

- 【TensorFlow】tf.nn.softmax_cross_entropy_with_logits的用法

在计算loss的时候,最常见的一句话就是 tf.nn.softmax_cross_entropy_with_logits ,那么它到底是怎么做的呢? 首先明确一点,loss是代价值,也就是我们要最小化 ...

- 【TensorFlow】tf.nn.max_pool实现池化操作

max pooling是CNN当中的最大值池化操作,其实用法和卷积很类似 有些地方可以从卷积去参考[TensorFlow]tf.nn.conv2d是怎样实现卷积的? tf.nn.max_pool(va ...

- 【Tensorflow】tf.nn.atrous_conv2d如何实现空洞卷积?膨胀卷积

介绍关于空洞卷积的理论可以查看以下链接,这里我们不详细讲理论: 1.Long J, Shelhamer E, Darrell T, et al. Fully convolutional network ...

- tf.nn.depthwise_conv2d 卷积

tf.nn.depthwise_conv2d( input, filter, strides, padding, rate=None, name=None, data_format=None ) 参数 ...

- TensorFlow学习---tf.nn.dropout防止过拟合

一. Dropout原理简述: tf.nn.dropout是TensorFlow里面为了防止或减轻过拟合而使用的函数,它一般用在全连接层. Dropout就是在不同的训练过程中随机扔掉一部分神经元.也 ...

- TensorFlow:tf.nn.max_pool实现池化操作

tf.nn.max_pool(value, ksize, strides, padding, name=None) 参数是四个,和卷积很类似: 第一个参数value:需要池化的输入,一般池化层接在卷积 ...

- 【TensorFlow】tf.nn.embedding_lookup函数的用法

tf.nn.embedding_lookup函数的用法主要是选取一个张量里面索引对应的元素.tf.nn.embedding_lookup(tensor, id):tensor就是输入张量,id就是张量 ...

- TensorFlow之tf.nn.dropout():防止模型训练过程中的过拟合问题

一:适用范围: tf.nn.dropout是TensorFlow里面为了防止或减轻过拟合而使用的函数,它一般用在全连接层 二:原理: dropout就是在不同的训练过程中随机扔掉一部分神经元.也就是让 ...

随机推荐

- 运行程序,解读this指向---case4

var param = 'window'; var obj1 = { param: 'obj1', fn1: function () { console.log(this.param); }, fn2 ...

- webview知多少?

原生页面不会用到webview,html页面内嵌APP,才会用到webview. 一.什么是webview?WebView是手机中内置了一款高性能 webkit 内核浏览器,在 SDK 中封装的一个组 ...

- linux 驱动之LCD驱动(有framebuffer)

<简介> LCD驱动里有个很重要的概念叫帧缓冲(framebuffer),它是Linux系统为显示设备提供的一个接口,应用程序在图形模式允许对显示缓冲区进行读写操作.用户根本不用关心物理显 ...

- 4951: [Wf2017]Money for Nothing 决策单调性 分治

Bzoj4951:决策单调性 分治 国际惯例题面:一句话题面:供应商出货日期为Ei,售价为Pi:用户收购截止日期为Si,收购价格为Gi.我们要求max((Si-Ej)*(Gi-Pj)).显然如果我们把 ...

- 【tarjan+SPFA】BZOJ1179-[Apio2009]Atm

[题目大意] 给出一张有点权的有向图,已知起点和可以作为终点的一些点,问由起点出发,每条边和每个点可以经过任意多次,经过点的权值总和最大为多少. [思路] 由于可以走任意多次,显然强连通分量可以缩点. ...

- JavaScript 的装饰器:它们是什么及如何使用

请访问我的独立博客地址:https://imsense.site/2017/06/js-decorator/ 装饰器的流行应该感谢在Angular 2+中使用,在Angular中,装饰器因TypeSc ...

- 20172302『Java程序设计』课程 结对编程练习_四则运算第二周阶段总结

一.结对对象 姓名:周亚杰 学号:20172302 担任角色:驾驶员(周亚杰) 伙伴第二周博客地址 二.本周内容 (一)继续编写上周未完成代码 1.本周继续编写代码,使代码支持分数类计算 2.相关过程 ...

- C#怎么通过一个按钮Button,实现点击这个按钮可以打开一个文件或者文件夹?

string path1 = @"d:\log.txt"; //打开D盘下的log.txt文件 System.Diagnostics.Process.Start(path1); ...

- sigmod2017.org

http://sigmod2017.org/sigmod-program/#ssession20

- 打通Linux脉络系列:进程、线程和调度

http://edu.csdn.net/huiyiCourse/series_detail/60 http://edu.csdn.net/mycollege