kafka安装与简单使用

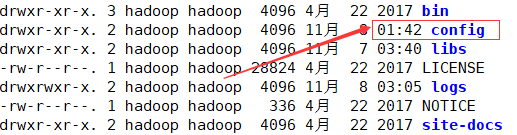

文件的详细属性为:

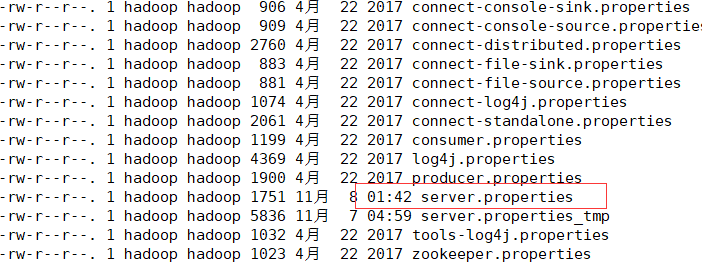

#broker的全局唯一编号,不能重复

broker.id= #用来监听链接的端口,producer或consumer将在此端口建立连接

port= #处理网络请求的线程数量

num.network.threads= #用来处理磁盘IO的线程数量

num.io.threads= #发送套接字的缓冲区大小

socket.send.buffer.bytes= #接受套接字的缓冲区大小

socket.receive.buffer.bytes= #请求套接字的缓冲区大小

socket.request.max.bytes= #kafka消息存放的路径

log.dirs=/export/servers/logs/kafka #topic在当前broker上的分片个数

num.partitions= #用来恢复和清理data下数据的线程数量

num.recovery.threads.per.data.dir= #segment文件保留的最长时间,超时将被删除

log.retention.hours= #滚动生成新的segment文件的最大时间

log.roll.hours= #日志文件中每个segment的大小,默认为1G

log.segment.bytes= #周期性检查文件大小的时间

log.retention.check.interval.ms= #日志清理是否打开

log.cleaner.enable=true #broker需要使用zookeeper保存meta数据

zookeeper.connect=192.168.52.106:,192.168.52.107:,192.168.52.108: #zookeeper链接超时时间

zookeeper.connection.timeout.ms= #partion buffer中,消息的条数达到阈值,将触发flush到磁盘

log.flush.interval.messages= #消息buffer的时间,达到阈值,将触发flush到磁盘

log.flush.interval.ms= #删除topic需要server.properties中设置delete.topic.enable=true否则只是标记删除

delete.topic.enable=true #此处的host.name为本机IP(重要),如果不改,则客户端会抛出:Producer connection to localhost: unsuccessful 错误!

host.name=spark101

ok,根据上面的配置修改自己的配置i文件,切记broker.id属性,全局唯一

然后分发文件,分发后修改broker.id和host.name属性

二、简单的使用

注意:kafka的使用,需要zookeeper的支持,请切记在启动kafka之前,zookeeper集群已启动完毕。

首先,启动kafka,启动成功后会jps查看会有一个kafka进程,若是启动失败,请仔细检查配置文件。

./bin/kafka-server-start.sh -daemon config/server.properties

创建topic

./bin/kafka-topics.sh --create --zookeeper spark101:,spark102:,spark103: --partition --replication-factor --topic test01

查看topic

./bin/kafka-topics.sh --list --zookeeper spark101:2181,spark102:2181,spark103:2181

查看详情

./bin/kafka-topics.sh --describe --zookeeper spark101:,spark102:,spark103: --topic test01

删除(若是配置文件中delete.topic.enable属性为true会直接删除,若是没有配置默认只是标记,并未真正删除)

./bin/kafka-topics.sh --delete --zookeeper spark101:,spark102:,spark103: --topic test01

说明:若是没有true,同时又想删除干净的话,逐步删除一下文件

1、删除配置真实数据目录下的数据文件

2、然后删除zookeeper下面的信息

rmr /admin/delete_topics/topicname

rmr /config/topics/topicname

rmr /brokers/topics/topicname

三、API的使用,消费者和生产者之间的简单通信

生产者:(spark101节点)

./bin/kafka-console-producer.sh --broker-list spark101:,spark102:,spark103: --topic test03

消费者:

.bin/kafka-console-consumer.sh --zookeeper spark101:,spark102:,spark103: --topic test03 --from-beginning

然后在生产者中输入数据,会在消费者那里接收到

kafka安装与简单使用的更多相关文章

- kafka安装和简单测试

kafka安装和简单测试 # 安装zookeeper(apache-zookeeper-3.5.6-bin)https://archive.apache.org/dist/zookeeper/zook ...

- 【Apache Kafka】二、Kafka安装及简单示例

(一)Apache Kafka安装 1.安装环境与前提条件 安装环境:Ubuntu16.04 前提条件: ubuntu系统下安装好jdk 1.8以上版本,正确配置环境变量 ubuntu系统下安 ...

- kafka集群安装及简单使用

关于kafka是什么及原理,请参考kafka官方文档的介绍:http://kafka.apache.org/documentation/#introduction ,英文不好的同学可以看这里http: ...

- kafka可视化工具安装及简单使用

一.安装 双击kafkatool_64bit.exe安装kafka可视化工具,并且C:\Windows\System32\drivers\etc配置HOSTS,打开HOSTS并添加: HOSTS添加: ...

- kafka安装与使用

一.下载 下载地址: http://kafka.apache.org/downloads.html kafka目录结构 目录 说明 bin 操作kafka的可执行脚本,还包含windows下脚本 co ...

- Spark简介安装和简单例子

Spark简介安装和简单例子 Spark简介 Spark是一种快速.通用.可扩展的大数据分析引擎,目前,Spark生态系统已经发展成为一个包含多个子项目的集合,其中包含SparkSQL.Spark S ...

- kafka安装和使用

kafka安装和启动 kafka的背景知识已经讲了很多了,让我们现在开始实践吧,假设你现在没有Kafka和ZooKeeper环境. Step 1: 下载代码 下载0.10.0.0版本并且解压它. &g ...

- Kafka安装教程(详细过程)

安装前期准备: 1,准备三个节点(根据自己需求决定) 2,三个节点上安装好zookeeper(也可以使用kafka自带的zookeeper) 3,关闭防火墙 chkconfig iptables o ...

- Zookeeper 安装与简单使用

一.安装Zookeeper 其实Zookeeper的安装特别简单,也不能算安装了,只需要将Zookeeper下载后解压,就完成了安装操作. 下载地址:http://zookeeper.apache.o ...

随机推荐

- Django开启国际化的支持

基础环境介绍 IDE我用的pycharm Python 3.6.0 (v3.6.0:41df79263a11, Dec 22 2016, 17:23:13) [GCC 4.2.1 (Apple Inc ...

- Android Studio导入项目一直卡在Building gradle project info的解决方案

出现了一个很神奇的现象,Android Studio导入其它项目均正常,但是导入某个项目(两天前还正常打开的项目)却一直卡在Building gradle project info 尝试了重启Andr ...

- Powershell渗透测试系列–进阶篇

原文来自:https://bbs.ichunqiu.com/thread-41561-1-1.html i春秋作家:anyedt 0×00 引言 经过基础篇的学习我们已经对powershell有了一个 ...

- Android 音乐(音效)播放方式总结

一.音效的分类 音效按照作用的不同,可以将音效分为即时音效和背景音乐.两种音效在Android中的实现技术是不同的. 主要的实现方式为:SoundPool.MediaPlayer. 区别在于,Medi ...

- HTTP 总结

一.概念 特性 1. HTTP协议用于客户端和服务端之间的通信 2. 通过请求和响应的交互达成通信 : HTTP协议规定,请求从客户端发出,最后服务器端响应请求并返回,也就是说,肯定是从客户端开始建立 ...

- Tools - 一些代码阅读的方法

1 初始能力 让阅读思路清晰连贯,保持在程序的流程架构和逻辑实现上,不被语法.编程技巧和业务流程等频繁地阻碍和打断. 语言基础:熟悉基础语法,常用的函数.库.编程技巧等: 了解设计模式.构建工具.代码 ...

- 关于git的常用命令

1.git add <name> 将工作区的内容添加到暂存区 2.git commit -m <备注> 将内容提交到暂存区 3.git status 查看状态 4. git ...

- 对nginx中location的认识

关于一些对location认识的误区 1.location的匹配顺序是“先匹配正则,在匹配普通”. location的匹配顺序其实是“先匹配普通,在匹配正则”.造成误解的原因是:正则匹配会覆盖普通匹配 ...

- 初入SpringBoot——使用IDEA构建最小SpringBootDemo

前言 从SpringBoot一出现,就开始关注这个东西了. 但是一直不敢使用,因为一个原则是刚出来的东西肯定有很多坑.而且之后会不会流行也需要时间的检验. 现在渐渐的时间检验之后,SpringBoot ...

- MapReduce业务 - 图片关联计算

1.概述 最近在和人交流时谈到数据相似度和数据共性问题,而刚好在业务层面有类似的需求,今天和大家分享这类问题的解决思路,分享目录如下所示: 业务背景 编码实践 预览截图 下面开始今天的内容分享. 2. ...