caffe中各层的作用:

关于caffe中的solver:

cafffe中的sover的方法都有:

- Stochastic Gradient Descent (

type: "SGD"),- AdaDelta (

type: "AdaDelta"),- Adaptive Gradient (

type: "AdaGrad"),- Adam (

type: "Adam"),- Nesterov’s Accelerated Gradient (

type: "Nesterov") and- RMSprop (

type: "RMSProp")solver都干了点什么?

1,创建训练网络与测试网网络.

2,进行前向传播与误差反向传播,更新参数,优化网络.

3, 间歇地进行用验证集进行测试test网络.

4, 在优化过程中,可以选择进行快照,进行保存中间状态.

数据输入层 (data layer):

在caffe中, 数据通过caffe进入.通常情况下,数据可以直接从内存中读中,可以从高效的LevelDB/LMDBD Database 中读入, 也可以从HDF5格式的硬盘文件中读去或着通常的图片文件.

通常我们对数据的预处理,我们可以参考TransformationParams里的设定.

Database 层: 类型为Data

这就是从LMDB/LeverlDB文件中读取数据的层;

In-Memory层: type:MemoryData

当我们想直接从内存中读取数据的话,那就需要调用MemoryDataLayer::Reset(c++程序)或Net.input_arrays(python程序),来指明数据源.

HDF5 Input层,类型为:HDF5Data

它的作用为从HDF5文件类型里读放数据,我们就看一个例子哦

2 layer {

3 name: "mnist"

4 type: "HDF5Data"

5 top: "data"

6 top: "label"

7 include {

8 phase: TRAIN

9 }

13 hdf5_data_param {

14 source: "mydata/train_list.txt" //是个坑哦,下面下面解释;

15 batch_size: 200

17 }上面的代码需要一地方解释:在定义.proto文件里的data层时注意,hdf5_data_param的source不要直接写我们生成的HDF5文件的路径,而是写一个.txt文件的,并在.txt文件里写入你生成的HDF5文件的路经,一个HDF5文件路径占一行,一定要这样哦。原因是因为,我们可以要读入多个HDF5文件,所以要这样写哦。

HDF5 Output层 类型为:HDF5Output

它的作用为把数据写成HDF5格式

另外还有,Images, Windows, Dummy.

激活函数层: 如果要用激活函数的话,就相当于增加一层哦

ReLU激活函数(rectified-linear and Leaky-ReLU):类型为ReLU.

在标准的ReLU激活函数中,当输入为x时,如果x>0,则输出 x,如果输入<=0,则输出0,即输出为max(0,x).

在非标准的ReLU激活函数中,当输入x<=0时, 输出为x * negative_slop(它是一个参数,默认为0).

sigmoid激活函数:类型为 Sigmoid.

这个不用多解释了.

tanh激活函数,类型为: TanH.

这个也不用多解释了.

Abolute Value:类型为 AbsVal.

计算绝对值的函数.

power激活函数:类型为:Power.

The

Powerlayer computes the output as (shift + scale * x) ^ power for each input element x.BNLL激活函数:类型为 BNLL.

The

BNLL(binomial normal log likelihood) layer computes the output as log(1 + exp(x)) for each input element x.

caffe中的layer:

convolution层:

layer的类型为:Convolution.,它有很参数,具体可以看caffe.proto里的message ConvolutionParam{}的定义.

num_output :输出的 feature map的个数啦,是否有偏置项啦,是否有把图像的边缘补充/卷积核的大小./步长/权值如何填充/偏置如何填充等.

看一个例子:

layer {

name: "conv1"

type: "Convolution"

bottom: "data"

top: "conv1"

# learning rate and decay multipliers for the filters

param { lr_mult: 1 decay_mult: 1 }

# learning rate and decay multipliers for the biases

param { lr_mult: 2 decay_mult: 0 }

convolution_param {

num_output: 96 # learn 96 filters

kernel_size: 11 # each filter is 11x11

stride: 4 # step 4 pixels between each filter application

weight_filler {

type: "gaussian" # initialize the filters from a Gaussian

std: 0.01 # distribution with stdev 0.01 (default mean: 0)

}

bias_filler {

type: "constant" # initialize the biases to zero (0)

value: 0

}

}

}pooling层:类型为:Pooling

这一层也有很多参数选择, 如pooling的核的大小/步长/pad(即上面的是否为边界加一些默认的值), 还有pooling的方法:现在有max/ average/stochastic三个方法.,具体看一下caffe.proto里的定义.

layer {

name: "pool1"

type: "Pooling"

bottom: "conv1"

top: "pool1"

pooling_param {

pool: MAX

kernel_size: 3 # pool over a 3x3 region

stride: 2 # step two pixels (in the bottom blob) between pooling regions

}

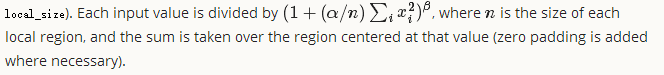

}LRN层:,类型为LRN. 即local response normalizaiton,它的作用是通过normalizing 局部输入区域,达到侧向抑制的目的(为什么,还不确定,记得在论文里看到过类似的方法).它分为两种模式,一种是across-channels,一种是within_channels .在arcoss-channel里, 分选择在相邻的feature-map之间进行,它的区域差不多为local_size *1 *1, 如果选择within_channels的话,该操作会选择在同一个feature map上操作,它的区域相当于 1* local_size * local_size.

Inner Product 层: 类型为:InnerProduct

它就是我们据说的全连接层.

caffe中的dropout 层

对于dropout层,说一下(论文中我们都会看到当我们有训练过程中dropout为(比如)0.3时,我们在测试时我们不会进行dropout,而是把输出乘以0.7。所以呢,caffe是怎么实现的呢?

当我们定义的net.prorotxt文件中,有了dropout这一层的时候,然后呢,caffe会根据你是训练还是测试进行不同的操作,当训练时,我们有一部分的神经元被dropout,然后,剩余的乘以1/(1-0.3). 然后,在测试时,dropout直接把数据进行从上一层复制到下一层,不进行操作。

明白了吧。。所以,我们不用在网络中进行定义 乘以0.7这一步。。你只需要分成训练还是测试就可以了。下面是一个dropout的例子:

layer {

name: "drop1"

type: "Dropout"

bottom: "ip11"

top: "ip11"

dropout_param {

dropout_ratio: 0.3

}

}

loss层:

在caffe中,默认的以loss结尾的layer可以作为loss层,但是中间的层同样可以作为loss层.原因是这样的:

有一个和这个相关的参数:loss_weight,它决定了你的每个loss层占最好的loss的大小.

在以loss结尾的layer里面, loss_wight的大小为1. 在不是以loss结尾的layer里面,它的loss_weight为0.

如:

layer {

name: "loss"

type: "SoftmaxWithLoss"

bottom: "pred"

bottom: "label"

top: "loss"

loss_weight: 1 #这个是默认的,可以不写的.

}如果我们想在一个net里,包含多个loss层的话,我们就可以设置他们对应的loss_weight在大小,这就相当于一个权值.(如一个网络中,我们即用softmaxWithloss用来分类,也用EuclideanLoss用来计算重构输入的loss).

最后在计算总的loss的时候,它的输出可以用下面的伪代码表示:

loss := 0

for layer in layers:

for top, loss_weight in layer.tops, layer.loss_weights:

loss += loss_weight * sum(top)softmax: 类型为:SoftmaxWithLoss

它的类型为:SoftmaxWithLoss.它其实就是一个 softmax层,然后跟了个multinomial logistic loss层. 它比单独用softmax层可以使梯度值更稳定.

sum-of-squares/也叫euclidean:

就是平时我们说的平方差代价函数.

hinge Loss: 类型:HingeLoss

最常用在 SVM 中的最大化间隔分类中等. hinge loss常分为1vs all hinge和squared hinge loss,即 L1 与L2hange.

# L1 Norm

layer {

name: "loss"

type: "HingeLoss"

bottom: "pred"

bottom: "label"

} # L2 Norm

layer {

name: "loss"

type: "HingeLoss"

bottom: "pred"

bottom: "label"

top: "loss"

hinge_loss_param {

norm: L2

}

}sigmoid cross-entropy loss:

就是平常所见的交叉熵损失函数. 类型:SigmoidCrossEntropyLoss

infogain loss:信息增益损失函数: ,类型:InfogainLoss

一些功能的layer:

splitting(把一个输入分成多个输出),类型:splitting

在caffe.proto里为什么没有找到呢.它的作用就是把一个输入复制为多个输入哦;

Flattening:类型为:Flatten

偏平的意思,如 flattens an input of shape

n * c * h * wto a simple vector output of shapen * (c*h*w))。

Reshape:(重新调整维度),类型为:Reshape

Cocatenation(把多个输入可以串联起来):类型为:Concat

Slicing(可以对输入进行切片)

类型为:Slice: 它的作用是把输入按维度进行切片。具体看一个例子哈:layer {

name: "slicer_label"

type: "Slice"

bottom: "label"

## 假设label的维度是:N x 5 x 1 x 1

top: "label1"

top: "label2"

top: "label3"

top: "label4"

slice_param {

axis: 1 # 指定维度,维度应该是从0开始的;

slice_point: 1 # 将label[~][:1][~][~]赋给label1

slice_point: 2 # 将label[~][1:3][~][~]赋给label2

slice_point: 3 # 将label[~][3:4][~][~]赋给label3

slice_point: 4 # 将label[~][4:][~][~]赋给label3

}

}

还有,切片的位置数,肯定比最后切出来的片数少一个哈。不用解释的啦。

另外还有:Elementwise Operations(类型为Eltwise), Argmax(类型为ArgMax), Softmax(类型为Softmax),

Mean-Variance Normalization(类型为MVN)

由于以上内容我只用到了一少部分,所以大部分没有详细写叱 ,随着不断的深入学习,我会再详细补充的,

caffe中各层的作用:的更多相关文章

- TensorFlow与caffe中卷积层feature map大小计算

刚刚接触Tensorflow,由于是做图像处理,因此接触比较多的还是卷及神经网络,其中会涉及到在经过卷积层或者pooling层之后,图像Feature map的大小计算,之前一直以为是与caffe相同 ...

- Caffe中Interp层的使用

最近实验当中借鉴了FPN网络,由于FPN网络对图片shape有要求,采用了两种方式,其一是在data_layer.cpp中,对原图进行padding操作:其二是需要对特征图进行类似crop操作,使得两 ...

- caffe中卷积层和pooling层计算下一层的特征map的大小

pool层,其中ceil是向上取整函数 卷积层:

- (原)torch和caffe中的BatchNorm层

转载请注明出处: http://www.cnblogs.com/darkknightzh/p/6015990.html BatchNorm具体网上搜索. caffe中batchNorm层是通过Batc ...

- 【神经网络与深度学习】如何在Caffe中配置每一个层的结构

如何在Caffe中配置每一个层的结构 最近刚在电脑上装好Caffe,由于神经网络中有不同的层结构,不同类型的层又有不同的参数,所有就根据Caffe官网的说明文档做了一个简单的总结. 1. Vision ...

- TCP/IP中链路层的附加数据(Trailer数据)和作用

1.TCP/IP中链路层的附加数据是什么 在用wireshark打开报文时,链路层显示的Trailer数据就是附加数据,如图 2.如何产生 1.例如以太网自动对小于64字节大小的报文进行填充(未实验) ...

- caffe 中 python 数据层

caffe中大多数层用C++写成. 但是对于自己数据的输入要写对应的输入层,比如你要去图像中的一部分,不能用LMDB,或者你的label 需要特殊的标记. 这时候就需要用python 写一个输入层. ...

- caffe中关于(ReLU层,Dropout层,BatchNorm层,Scale层)输入输出层一致的问题

在卷积神经网络中.常见到的激活函数有Relu层 layer { name: "relu1" type: "ReLU" bottom: "pool1&q ...

- Altium_Designer-PCB中各层作用详解

一直以来,对PCB中各层,比如:solder层.paste层.Top overlay层等等这些一知半解.今天仔细看了下,向大家介绍一下,有不对的地方还请指正. 1.mechanical机械层是定义整个 ...

随机推荐

- Flink - state管理

在Flink – Checkpoint 没有描述了整个checkpoint的流程,但是对于如何生成snapshot和恢复snapshot的过程,并没有详细描述,这里补充 StreamOperato ...

- SQLite核心函数一览

abs(X) abs(X)返回 X 的绝对值. Abs(X) returns NULL if X is NULL. Abs(X) return 0.0 if X is a string or blo ...

- android:layout_gravity 和 android:gravity 的区别

gravity 这个英文单词是重心的意思,在这里就表示停靠位置的意思. android:layout_gravity 和 android:gravity 的区别 从名字上可以看到,android:gr ...

- 使用inherit属性值继承其父元素样式来覆盖UA自带样式。

像button.input这样的表单控件,不同的浏览器都会有自己的样式风格(UA样式).我们可以使用inherit继承其父元素样式,从而覆盖浏览器的UA样式. button, input, selec ...

- DNS消息格式

一,简介 空谈误国,要让一大堆抽象的DNS概念落地,还是需要了解DNS消息格式的,本文会尽量详细地介绍DNS消息格式的每一个字段. 也可以移步rfc1035了解. 二,概览 DNS消息主要由五部分组成 ...

- Win7常规快捷键

Win7常规快捷键: Win+1:打开/显示超级任务栏第一个图标代表的程序 Win+2:打开/显示超级任务栏第二个图标代表的程序(3.4.--如此类推) Win+D:切换桌面显示窗口或者gadgets ...

- JSP-11-Servlet

1 初识Servlet Ø Servlet做了什么 本身不做业务 只接收请求并决定调用哪个JavaBean去处理请求 确定用哪个页面来显示处理返回的数据 Ø Servlet 是什么 Servlet ...

- 指定YUM安装包的体系结构或版本

在单一体系结构下同时安装32位和64位包echo ‘multilib_policy=all’ >> /etc/yum.conf 指定体系结构 查看当前系统体系结构[root@oracle ...

- 《Vuser虚拟用户开发》读书笔记

学会了Vuser开发只是算了性能测试入了门.要做好性能测试还需要了解系统的功能,架构和设计测试用例. 脚本选用什么协议的依据是需要模拟的客户端与服务器之间的通信采用什么协议.与具体的开发技术并无直接的 ...

- smarty中增加类似foreach的功能自动加载数据方法

第一步:在Smarty_Compiler.class.php的_compile_tag函数中增加: 复制代码 代码如下: //加载数据的开始标签case 'load': $this->_push ...