分布式锁与实现(二)——基于ZooKeeper实现

引言

ZooKeeper是一个分布式的,开放源码的分布式应用程序协调服务,是Google的Chubby一个开源的实现,是Hadoop和Hbase的重要组件。它是一个为分布式应用提供一致性服务的软件,提供的功能包括:配置维护、域名服务、分布式同步、组服务等。

ZooKeeper的架构通过冗余服务实现高可用性。因此,如果第一次无应答,客户端就可以询问另一台ZooKeeper主机。ZooKeeper节点将它们的数据存储于一个分层的命名空间,非常类似于一个文件系统或一个前缀树结构。客户端可以在节点读写,从而以这种方式拥有一个共享的配置服务。更新是全序的。

基于ZooKeeper分布式锁的流程

- 在zookeeper指定节点(locks)下创建临时顺序节点node_n

- 获取locks下所有子节点children

- 对子节点按节点自增序号从小到大排序

- 判断本节点是不是第一个子节点,若是,则获取锁;若不是,则监听比该节点小的那个节点的删除事件

- 若监听事件生效,则回到第二步重新进行判断,直到获取到锁

具体实现

下面就具体使用java和zookeeper实现分布式锁,操作zookeeper使用的是apache提供的zookeeper的包。

- 通过实现Watch接口,实现process(WatchedEvent event)方法来实施监控,使CountDownLatch来完成监控,在等待锁的时候使用CountDownLatch来计数,等到后进行countDown,停止等待,继续运行。

- 以下整体流程基本与上述描述流程一致,只是在监听的时候使用的是CountDownLatch来监听前一个节点。

分布式锁

import org.apache.zookeeper.*;

import org.apache.zookeeper.data.Stat;

import java.io.IOException;

import java.util.ArrayList;

import java.util.Collections;

import java.util.List;

import java.util.concurrent.CountDownLatch;

import java.util.concurrent.TimeUnit;

import java.util.concurrent.locks.Condition;

import java.util.concurrent.locks.Lock;

/**

* Created by liuyang on 2017/4/20.

*/

public class DistributedLock implements Lock, Watcher {

private ZooKeeper zk = null;

// 根节点

private String ROOT_LOCK = "/locks";

// 竞争的资源

private String lockName;

// 等待的前一个锁

private String WAIT_LOCK;

// 当前锁

private String CURRENT_LOCK;

// 计数器

private CountDownLatch countDownLatch;

private int sessionTimeout = 30000;

private List<Exception> exceptionList = new ArrayList<Exception>();

/**

* 配置分布式锁

* @param config 连接的url

* @param lockName 竞争资源

*/

public DistributedLock(String config, String lockName) {

this.lockName = lockName;

try {

// 连接zookeeper

zk = new ZooKeeper(config, sessionTimeout, this);

Stat stat = zk.exists(ROOT_LOCK, false);

if (stat == null) {

// 如果根节点不存在,则创建根节点

zk.create(ROOT_LOCK, new byte[0], ZooDefs.Ids.OPEN_ACL_UNSAFE, CreateMode.PERSISTENT);

}

} catch (IOException e) {

e.printStackTrace();

} catch (InterruptedException e) {

e.printStackTrace();

} catch (KeeperException e) {

e.printStackTrace();

}

}

// 节点监视器

public void process(WatchedEvent event) {

if (this.countDownLatch != null) {

this.countDownLatch.countDown();

}

}

public void lock() {

if (exceptionList.size() > 0) {

throw new LockException(exceptionList.get(0));

}

try {

if (this.tryLock()) {

System.out.println(Thread.currentThread().getName() + " " + lockName + "获得了锁");

return;

} else {

// 等待锁

waitForLock(WAIT_LOCK, sessionTimeout);

}

} catch (InterruptedException e) {

e.printStackTrace();

} catch (KeeperException e) {

e.printStackTrace();

}

}

public boolean tryLock() {

try {

String splitStr = "_lock_";

if (lockName.contains(splitStr)) {

throw new LockException("锁名有误");

}

// 创建临时有序节点

CURRENT_LOCK = zk.create(ROOT_LOCK + "/" + lockName + splitStr, new byte[0],

ZooDefs.Ids.OPEN_ACL_UNSAFE, CreateMode.EPHEMERAL_SEQUENTIAL);

System.out.println(CURRENT_LOCK + " 已经创建");

// 取所有子节点

List<String> subNodes = zk.getChildren(ROOT_LOCK, false);

// 取出所有lockName的锁

List<String> lockObjects = new ArrayList<String>();

for (String node : subNodes) {

String _node = node.split(splitStr)[0];

if (_node.equals(lockName)) {

lockObjects.add(node);

}

}

Collections.sort(lockObjects);

System.out.println(Thread.currentThread().getName() + " 的锁是 " + CURRENT_LOCK);

// 若当前节点为最小节点,则获取锁成功

if (CURRENT_LOCK.equals(ROOT_LOCK + "/" + lockObjects.get(0))) {

return true;

}

// 若不是最小节点,则找到自己的前一个节点

String prevNode = CURRENT_LOCK.substring(CURRENT_LOCK.lastIndexOf("/") + 1);

WAIT_LOCK = lockObjects.get(Collections.binarySearch(lockObjects, prevNode) - 1);

} catch (InterruptedException e) {

e.printStackTrace();

} catch (KeeperException e) {

e.printStackTrace();

}

return false;

}

public boolean tryLock(long timeout, TimeUnit unit) {

try {

if (this.tryLock()) {

return true;

}

return waitForLock(WAIT_LOCK, timeout);

} catch (Exception e) {

e.printStackTrace();

}

return false;

}

// 等待锁

private boolean waitForLock(String prev, long waitTime) throws KeeperException, InterruptedException {

Stat stat = zk.exists(ROOT_LOCK + "/" + prev, true);

if (stat != null) {

System.out.println(Thread.currentThread().getName() + "等待锁 " + ROOT_LOCK + "/" + prev);

this.countDownLatch = new CountDownLatch(1);

// 计数等待,若等到前一个节点消失,则precess中进行countDown,停止等待,获取锁

this.countDownLatch.await(waitTime, TimeUnit.MILLISECONDS);

this.countDownLatch = null;

System.out.println(Thread.currentThread().getName() + " 等到了锁");

}

return true;

}

public void unlock() {

try {

System.out.println("释放锁 " + CURRENT_LOCK);

zk.delete(CURRENT_LOCK, -1);

CURRENT_LOCK = null;

zk.close();

} catch (InterruptedException e) {

e.printStackTrace();

} catch (KeeperException e) {

e.printStackTrace();

}

}

public Condition newCondition() {

return null;

}

public void lockInterruptibly() throws InterruptedException {

this.lock();

}

public class LockException extends RuntimeException {

private static final long serialVersionUID = 1L;

public LockException(String e){

super(e);

}

public LockException(Exception e){

super(e);

}

}

}

测试代码

public class Test {

static int n = 500;

public static void secskill() {

System.out.println(--n);

}

public static void main(String[] args) {

Runnable runnable = new Runnable() {

public void run() {

DistributedLock lock = null;

try {

lock = new DistributedLock("127.0.0.1:2181", "test1");

lock.lock();

secskill();

System.out.println(Thread.currentThread().getName() + "正在运行");

} finally {

if (lock != null) {

lock.unlock();

}

}

}

};

for (int i = 0; i < 10; i++) {

Thread t = new Thread(runnable);

t.start();

}

}

}

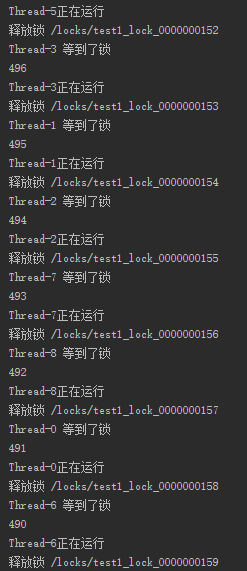

运行结果:

总体来说,如果了解到整个实现流程,使用zookeeper实现分布式锁并不是很困难,不过这也只是一个简单的实现,与前面实现Redis实现相比,本实现的稳定性更强,这是因为zookeeper的特性所致,在外界看来,zookeeper集群中每一个节点都是一致的。

完整代码可以在我的GitHub中查看:https://github.com/yangliu0/DistributedLock

分布式锁与实现(二)——基于ZooKeeper实现的更多相关文章

- 分布式锁的实现【基于ZooKeeper】

引言 ZooKeeper是一个分布式的,开放源码的分布式应用程序协调服务,是Google的Chubby一个开源的实现,是Hadoop和Hbase的重要组件.它是一个为分布式应用提供一致性服务的软件,提 ...

- 分布式锁实践(二)-ZooKeeper实现总结

写在最前面 前几周写了篇 利用Redis实现分布式锁 ,今天简单总结下ZooKeeper实现分布式锁的过程.其实生产上我只用过Redis或者数据库的方式,之前还真没了解过ZooKeeper怎么实现分布 ...

- 分布式锁与实现(一)——基于Redis实现 【比较靠谱】

转: 分布式锁与实现(一)——基于Redis实现 概述 目前几乎很多大型网站及应用都是分布式部署的,分布式场景中的数据一致性问题一直是一个比较重要的话题.分布式的CAP理论告诉我们“任何一个分布式系统 ...

- 分布式锁实现(二):Zookeeper

目录 前言 设计实现 一.基本算法 二.关键点 临时有序节点 监听 三.代码实现 Curator源码分析 一.基本使用 二.源码分析 后记 前言 紧跟上文的:分布式锁实现(一):Redis ,这篇我们 ...

- 分布式学习(一)——基于ZooKeeper的队列爬虫

zookeeper 一直琢磨着分布式的东西怎么搞,公司也没有相关的项目能够参与,所以还是回归自己的专长来吧--基于ZooKeeper的分布式队列爬虫,由于没什么人能够一起沟通分布式的相关知识,下面的小 ...

- 分布式锁实现方式介绍和Zookeeper实现原理

分布式锁实现的几种方式 基于数据库实现分布式锁(表.数据库排他锁) 基于缓存(redis,memcached,tair) 基于Zookeeper实现分布式锁 关注点: 单点问题?(集群) 失效时间?( ...

- 面试必问:分布式锁实现之zk(Zookeeper)

点赞再看,养成习惯,微信搜索[三太子敖丙]关注这个互联网苟且偷生的工具人. 本文 GitHub https://github.com/JavaFamily 已收录,有一线大厂面试完整考点.资料以及我的 ...

- 分布式锁与实现(一)——基于Redis实现

概述 目前几乎很多大型网站及应用都是分布式部署的,分布式场景中的数据一致性问题一直是一个比较重要的话题.分布式的CAP理论告诉我们"任何一个分布式系统都无法同时满足一致性(Consisten ...

- 分布式锁与实现(一)基于Redis实现

目前几乎很多大型网站及应用都是分布式部署的,分布式场景中的数据一致性问题一直是一个比较重要的话题.分布式的CAP理论告诉我们“任何一个分布式系统都无法同时满足一致性(Consistency).可用性( ...

- 分布式锁与实现(一)——基于Redis实现(转载)

php的完整流程,包护队列操作:http://www.cnblogs.com/candychen/p/5736128.html 概述 目前几乎很多大型网站及应用都是分布式部署的,分布式场景中的数据一致 ...

随机推荐

- 【转】请求处理机制其三:view层与模板解析

进入 View 了 如果处理过程这时候还在继续的话,处理器会调用 view function.Django 中的 Views 不很严格因为它只需要满足几个条件: 必须可以被调用. 必须接受 djan ...

- iOSiOS开发之数据存储之NSKeyedArchiver

1.概述 NSKeyedArchiver归档和plist文件存储不同的是NSKeyedArchiver可以直接保存对象.如果对象是NSString.NSDictionary.NSArray.NSDat ...

- bzoj3531——树链剖分+动态开点线段树

3531: [Sdoi2014]旅行 Time Limit: 20 Sec Memory Limit: 512 MB Description S国有N个城市,编号从1到N.城市间用N-1条双向道路连 ...

- 日期格式化,moment.js

官方文档:http://momentjs.com/; 使用方法:moment(data).format("YYYY-MM-DD");//data为日期的字符串形式 moment() ...

- Spring+SpringMVC+MyBatis+easyUI整合优化篇(三)代码测试

日常啰嗦 看到标题你可能会问为什么这一篇会谈到代码测试,不是说代码优化么?前两篇主要是讲了程序的输出及Log4j的使用,Log能够帮助我们进行bug的定位,优化开发流程,而代码测试有什么用呢?其实测试 ...

- xml学习_上篇

xml简介: XML 指可扩展标记语言(eXtensible Markup Language). XML 被设计用来传输和存储数据. xml小示例: /************************ ...

- Vijos1144小胖守皇宫【树形DP】

皇宫看守 太平王世子事件后,陆小凤成了皇上特聘的御前一品侍卫.皇宫以午门为起点,直到后宫嫔妃们的寝宫,呈一棵树的形状:某些宫殿间可以互相望见.大内保卫森严,三步一岗,五步一哨,每个宫殿都要有人全天候看 ...

- PPT自动载入图片并矩阵分布

最近有学生问到,能不能快速的向PPT一个页面里插入成百张图片,并让它们按统一大小的矩形排布到页面上.我写了以下代码可以在第1页中按照指定横向和纵向矩形数目,填充指定路径下的图片. Sub LoadPi ...

- POPTEST老李分享修改dns ip的vbs代码

POPTEST老李分享修改dns ip的vbs代码 poptest是国内唯一一家培养测试开发工程师的培训机构,以学员能胜任自动化测试,性能测试,测试工具开发等工作为目标.如果对课程感兴趣,请大家咨 ...

- Java并发编程:volatile 关键字

转自:http://www.cnblogs.com/aigongsi/archive/2012/04/01/2429166.html 其实Java语言是支持多线程的,为了解决线程并发的问题,在语言内部 ...