kafka学习(五)Spring Boot 整合 Kafka

文章更新时间:2020/06/08

一、创建Spring boot 工程

创建过程不再描述,创建后的工程结构如下:

POM文件中要加入几个依赖:

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 https://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<parent>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-parent</artifactId>

<version>2.1.9.RELEASE</version>

<relativePath/> <!-- lookup parent from repository -->

</parent>

<groupId>com.zhbf</groupId>

<artifactId>springboot</artifactId>

<version>0.0.1-SNAPSHOT</version>

<name>springboot</name>

<description>Demo project for Spring Boot</description> <properties>

<java.version>1.8</java.version>

</properties> <dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency> <dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

<optional>true</optional>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

<scope>test</scope>

</dependency>

<!--引入kafka依赖-->

<dependency>

<groupId>org.springframework.kafka</groupId>

<artifactId>spring-kafka</artifactId>

</dependency>

<!-- 添加 gson 依赖 -->

<dependency>

<groupId>com.google.code.gson</groupId>

<artifactId>gson</artifactId>

<version>2.8.5</version>

</dependency>

</dependencies> <build>

<plugins>

<plugin>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-maven-plugin</artifactId>

</plugin>

</plugins>

</build> </project>

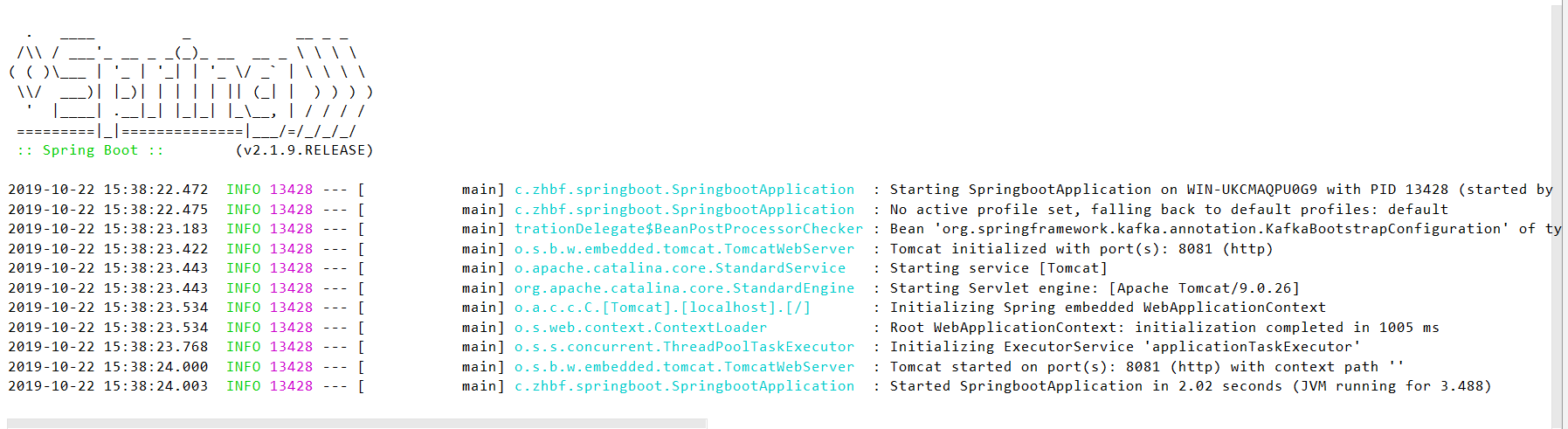

启动SpringbootApplication.java,出现下图界面则说明工程创建好了:

二、创建kafka生产者类,并通过控制器调用

kafka生产者类

/**

* Kafka消息生产类

*/

@Log

@Component

public class KafkaProducer { @Resource

private KafkaTemplate<String, String> kafkaTemplate; @Value("${kafka.topic.user}")

private String topicUser;//topic名称 /**

* 发送用户消息

*

* @param user 用户信息

*/

public void sendUserMessage(User user) {

GsonBuilder builder = new GsonBuilder();

builder.setPrettyPrinting();

builder.setDateFormat("yyyy-MM-dd HH:mm:ss");

String message = builder.create().toJson(user);

kafkaTemplate.send(topicUser, message);

log.info("\n生产消息至Kafka\n" + message);

}

}

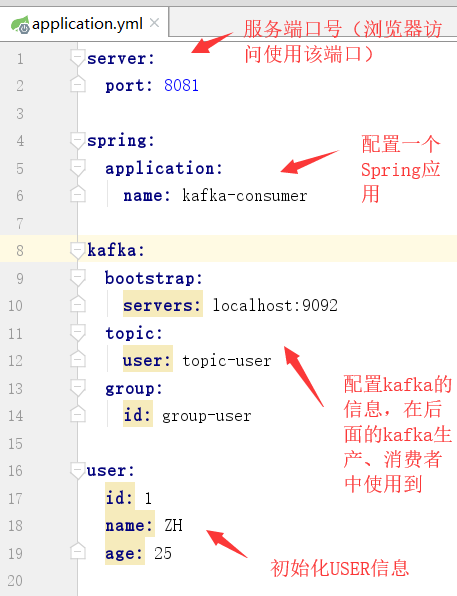

application.yml配置文件

启动ZK、kafka通讯的服务器broker,并启动消费者监听

启动方式参考上一篇文章,戳这里~

配置一个控制器,即调用kafka生成消息的入口

/**

* 测试控制器

* PS:@RestController 注解: 该注解是 @Controller 和 @ResponseBody 注解的合体版

*/

@RestController

@RequestMapping("/kafka")

public class KafkaController { @Autowired

private User user; @Autowired

private KafkaProducer kafkaProducer; @RequestMapping("/createMsg")

public void createMsg() {

kafkaProducer.sendUserMessage(user);

}

}

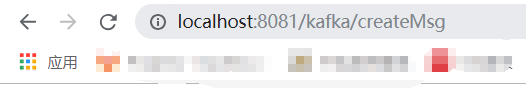

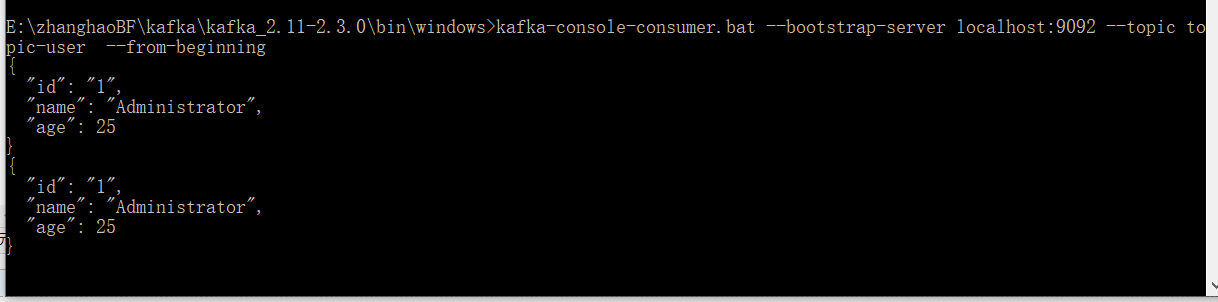

启动SpringbootApplication,并通过浏览器访问控制器,生成消息

可以看到控制台和消费者窗口都打印了kafka生成的消息。

三、创建kafka消费者类,并通过控制器调用

kafka消费者类

public class KafkaConsumerDemo {

@Value("${kafka.topic.user}")

private String topicUser;//topic名称

public void consume() {

Properties props = new Properties();

// 必须设置的属性

props.put("bootstrap.servers", "127.0.0.1:9092");

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("group.id", "group-user");

// 可选设置属性

//提交方式配置

// 自动提交offset,每1s提交一次(提交后的消息不再消费,避免重复消费问题)

props.put("enable.auto.commit", "true");//自动提交offset:true【PS:只有当消息提交后,此消息才不会被再次接受到】

props.put("auto.commit.interval.ms", "1000");//自动提交的间隔

//消费方式配置

/**

* earliest: 当各分区下有已提交的offset时,从提交的offset开始消费;无提交的offset时,从头开始消费

* latest: 当各分区下有已提交的offset时,从提交的offset开始消费;无提交的offset时,消费新产生的该分区下的数据

* none: topic各分区都存在已提交的offset时,从offset后开始消费;只要有一个分区不存在已提交的offset,则抛出异常

*/

props.put("auto.offset.reset", "earliest ");//earliest:当各分区下有已提交的offset时,从提交的offset开始消费;无提交的offset时,从头开始消费

//拉取消息设置

props.put("max.poll.records", "100 ");//每次poll操作最多拉取多少条消息(一般不主动设置,取默认的就好)

//根据上面的配置,新增消费者对象

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);

// 订阅topic-user topic

consumer.subscribe(Collections.singletonList(topicUser));

while (true) {

// 从服务器开始拉取数据

ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(100));

records.forEach(record -> {

System.out.printf("成功消费消息:topic = %s ,partition = %d,offset = %d, key = %s, value = %s%n", record.topic(), record.partition(), record.offset(), record.key(), record.value());

});

}

}

}

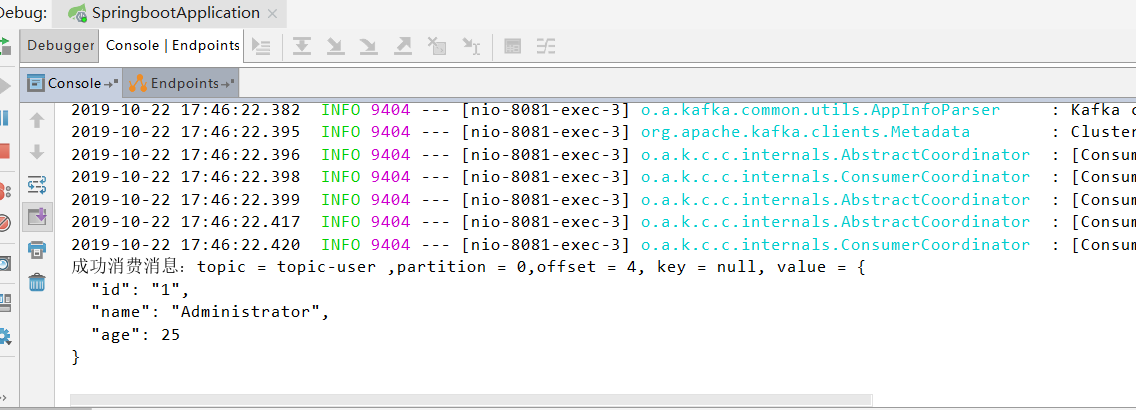

重启SpringbootApplication,并通过浏览器访问控制器,消费消息

kafka学习(五)Spring Boot 整合 Kafka的更多相关文章

- Spring Boot 项目学习 (四) Spring Boot整合Swagger2自动生成API文档

0 引言 在做服务端开发的时候,难免会涉及到API 接口文档的编写,可以经历过手写API 文档的过程,就会发现,一个自动生成API文档可以提高多少的效率. 以下列举几个手写API 文档的痛点: 文档需 ...

- spring boot整合kafka

最近项目需求用到了kafka信息中间件,在此做一次简单的记录,方便以后其它项目用到. 引入依赖 <dependency> <groupId>org.springframewor ...

- Elasticsearch学习(3) spring boot整合Elasticsearch的原生方式

前面我们已经介绍了spring boot整合Elasticsearch的jpa方式,这种方式虽然简便,但是依旧无法解决我们较为复杂的业务,所以原生的实现方式学习能够解决这些问题,而原生的学习方式也是E ...

- Spring Boot2 系列教程(二十五)Spring Boot 整合 Jpa 多数据源

本文是 Spring Boot 整合数据持久化方案的最后一篇,主要和大伙来聊聊 Spring Boot 整合 Jpa 多数据源问题.在 Spring Boot 整合JbdcTemplate 多数据源. ...

- spring boot 2.x 系列 —— spring boot 整合 kafka

文章目录 一.kafka的相关概念: 1.主题和分区 2.分区复制 3. 生产者 4. 消费者 5.broker和集群 二.项目说明 1.1 项目结构说明 1.2 主要依赖 二. 整合 kafka 2 ...

- Elasticsearch学习(1) Spring boot整合Elasticsearch

本文的Spring Boot版本为1.5.9,Elasticsearch版本为2.4.4,话不多说,直接上代码. 一.启动Elasticsearch 在官网上下载Elasticsearch后,打开bi ...

- Elasticsearch学习(4) spring boot整合Elasticsearch的聚合操作

之前已将spring boot原生方式介绍了,接下将结介绍的是Elasticsearch聚合操作.聚合操作一般来说是解决一下复杂的业务,比如mysql中的求和和分组,由于博主踩的坑比较多,所以博客可能 ...

- spring boot 整合kafka 报错 Exception thrown when sending a message with key='null' and payload=JSON to topic proccess_trading_end: TimeoutException: Failed to update metadata after 60000 ms.

org.springframework.kafka.support.LoggingProducerListener- Exception thrown when sending a message w ...

- Spring Boot 项目学习 (三) Spring Boot + Redis 搭建

0 引言 本文主要介绍 Spring Boot 中 Redis 的配置和基本使用. 1 配置 Redis 1. 修改pom.xml,添加Redis依赖 <!-- Spring Boot Redi ...

随机推荐

- Kubernetes 中 Informer 的使用

原文链接:https://mp.weixin.qq.com/s?__biz=MzU4MjQ0MTU4Ng==&mid=2247485580&idx=1&sn=7392dbadf ...

- cinder 卷迁移进度的代码分析

一.cinder-api服务的入口函数 D:\code-program\cinder-ocata_cinder\cinder\api\contrib\admin_actions.py from cin ...

- linux系统工程师修改打开文件数限制代码教程。服务器运维技术

提示linux文件打开错误,修改linux打开文件数参数. /etc/pam.d/login 添加 session required /lib/security/pam_limits.so 注意看这个 ...

- python执行gradle脚本

import os import shutil import subprocess #拷贝文件 def copyFile(srcFile, dstFile): #检查源文件是否存在 if not os ...

- Fitness - 05.22

终于到了连续熬夜,感觉身心俱疲的年纪了. 今天休息一天,瑜伽暂停. 调整作息时间,12点睡觉,5点起床学习~

- Lua C API的正确用法

http://blog.codingnow.com/2015/05/lua_c_api.html http://blog.csdn.net/oilcode/article/details/510861 ...

- python3笔记-读取ini配置文件

在代码中经常会通过ini文件来配置一些常修改的配置.下面通过一个实例来看下如何写入.读取ini配置文件. 需要的配置文件是: [path] back_dir = /Users/abc/PycharmP ...

- java初探(1)之秒杀的业务简单实现

前言 秒杀的业务场景广泛存在于电商当中,即有一个倒计时的时间限制,当倒计时为0时,秒杀开始,秒杀之后持续很小的一段时间,而且秒杀的商品很少,因此会有大量的顾客进行购买,会产生很大的并发量,从而创造技术 ...

- [BUUOJ记录] [GXYCTF2019]BabySQli

有点脑洞的题,题目不难,主要考察注入和联合查询的一个小特点 进入题目是一个登录框,看看源代码,在search.php文件中发现了这个 大写的字母和数字很明显是base32,先用base32解码一下,发 ...

- 小程序开发-基础组件icon/text/progress入门

小程序的基础组件--基础内容 基础内容分为三大组件: 1. icon--图标 index.wxml <view class="group"> <block wx: ...