爬虫系列---scrapy post请求、框架组件和下载中间件+boss直聘爬取

一 Post 请求

在爬虫文件中重写父类的start_requests(self)方法

- 父类方法源码(Request):

def start_requests(self):

for url in self.start_urls:

yield scrapy.Request(url=url,callback=self.parse)

- 重写该方法(FormRequests(url=url,callback=self.parse,formdata=data))

def start_requests(self):

data={

'kw': 'xml',

}

for url in self.start_urls:

#post请求,并传递参数

yield scrapy.FormRequest(url=url,callback=self.parse,formdata=data)

二 多页面手动爬去数据

import scrapy

from QiubaiPagePro.items import QiubaipageproItem class QiubaiSpider(scrapy.Spider):

name = 'qiubai'

# allowed_domains = ['xxx.com']

start_urls = ['https://www.qiushibaike.com/text/']

'''

https://www.qiushibaike.com/text/page/13/

'''

url='https://www.qiushibaike.com/text/page/%d/'

#手动发起请求

page=1 def parse(self, response):

div_list = response.xpath('//div[@id="content-left"]/div')

for div in div_list:

author = div.xpath('./div[1]/a[2]/h2/text()').extract_first()

content = div.xpath('./a[1]/div[@class="content"]/span//text()').extract()

content = "".join(content) #实例管道对象

item=QiubaipageproItem()

item['author']=author

item['content']=content.strip()

yield item

- 1 构造请求url的格式

url='https://www.qiushibaike.com/text/page/%d/'

#手动发起请求

page=1

- 2 手动发送请求

if self.page<=12:

self.page += 1

url=format(self.url%self.page)

#手动发送请求

yield scrapy.Request(url=url,callback=self.parse)

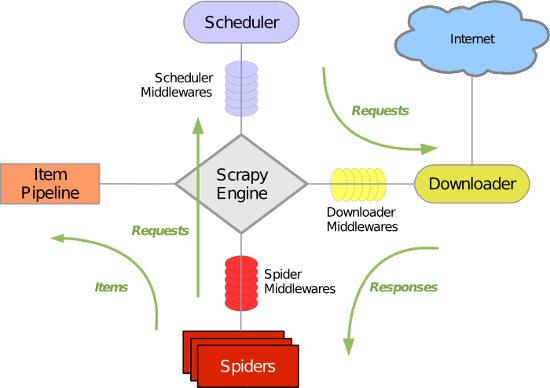

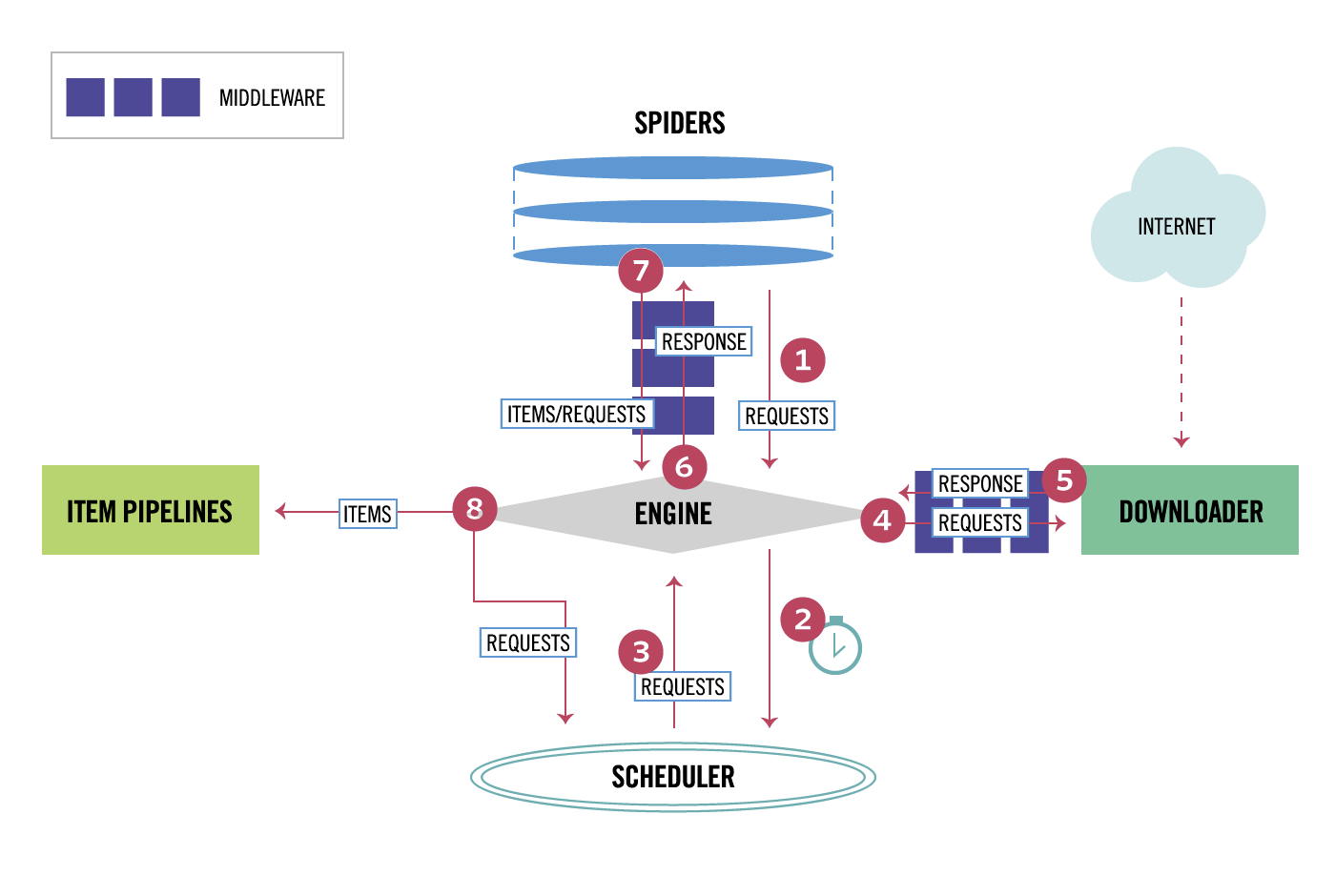

三 五大核心组件

- 引擎(Scrapy)用来处理整个系统的数据流,触发事务(框架核心)

- 调度器(Scheduler) 用来接收应勤发过来的请求,压入队列中,并在引擎再次发起请求的时候返回,可以想象成一个url的优先队列,他决定下一个要爬取的网址是什么,同时去重复的网址。

- 下载器(Downloader)用于下载页面内容,并将页面内容返回给引擎。

- 爬虫(Spider)爬虫主要是干活的,用于从特定的网页中提取自己需要的信息。用户可以在这里面编写程序,从网页中提取链接,让scrapy继续爬取下一个页面。

- 项目管理(Pipeline)负责处理爬虫从网页中爬取的数据,主要功能是持久存储,验证实体的有效性,清楚不需要的信息,当也被爬虫解析后,将被发送到项目管道,经过几个特点的次序处理数据

四 下载中间件

class QiubaipageproDownloaderMiddleware(object):

#拦截请求

def process_request(self, request, spider):

#设置代理

request.meta['proxy']='119.176.66.90:9999'

print('this is process_request')

#拦截响应

def process_response(self, request, response, spider):

# Called with the response returned from the downloader.

# Must either;

# - return a Response object

# - return a Request object

# - or raise IgnoreRequest

return response

#拦截发生异常的请求对象

def process_exception(self, request, exception, spider):

# 设置代理

request.meta['proxy'] = 'https:119.176.66.90:9999'

print('this is process_request')

setting中开启下载中间键

DOWNLOADER_MIDDLEWARES = {

'QiubaiPagePro.middlewares.QiubaipageproDownloaderMiddleware': 543,

}

五 boss直聘爬取

- bossspider.py 爬虫文件

# -*- coding: utf-8 -*-

import scrapy

from BossPro.items import BossproItem class BossspiderSpider(scrapy.Spider):

name = 'bossspider'

# allowed_domains = ['boss.com']

start_urls = ['https://www.zhipin.com/c101280600/?query=python%E7%88%AC%E8%99%AB&ka=sel-city-101280600'] def parse(self, response):

li_list=response.xpath('//div[@class="job-list"]/ul/li')

for li in li_list:

job_name=li.xpath('.//div[@class="job-title"]/text()').extract_first()

company_name=li.xpath('.//div[@class="info-company"]/div[1]/h3/a/text()').extract_first()

detail_url='https://www.zhipin.com'+li.xpath('.//div[@class="info-primary"]/h3/a/@href').extract_first()

#实例项目对象,给管道传输数据

item=BossproItem()

item['job_name']=job_name.strip()

item['company_name']=company_name.strip() #手动发起get请求,并通过meta给回调函数传参

yield scrapy.Request(url=detail_url,callback=self.parse_detail,meta={'item':item}) def parse_detail(self,response):

#从meta中取出参数item

item=response.meta['item']

job_desc = response.xpath('//*[@id="main"]/div[3]/div/div[2]/div[2]/div[1]/div//text()').extract()

job_desc = ''.join(job_desc).strip()

job_desc=job_desc.replace(';','\n')

job_desc = job_desc.replace(';', '\n')

job_desc = job_desc.replace('。', '\n')

item['job_desc']=job_desc yield item

- items.py

import scrapy class BossproItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

job_name = scrapy.Field()

company_name = scrapy.Field()

job_desc = scrapy.Field()

- pipelines.py

# -*- coding: utf-8 -*- # Define your item pipelines here

#

# Don't forget to add your pipeline to the ITEM_PIPELINES setting

# See: https://doc.scrapy.org/en/latest/topics/item-pipeline.html class BossproPipeline(object):

fp=None def open_spider(self,spider):

self.fp=open('boss.txt','w',encoding='utf-8') def process_item(self, item, spider):

# print(item)

self.fp.write(item['job_name']+":"+item['company_name'])

self.fp.write('\n'+item['job_desc']+'\n\n')

return item def close_spider(self,spider):

pass

- setings.py

USER_AGENT = 'Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/72.0.3626.119 Safari/537.36' #UA

ROBOTSTXT_OBEY = False #不遵从robots协议

ITEM_PIPELINES = {

'BossPro.pipelines.BossproPipeline': 300, #开启item_pipelines

}

爬虫系列---scrapy post请求、框架组件和下载中间件+boss直聘爬取的更多相关文章

- Python爬虫——Scrapy整合Selenium案例分析(BOSS直聘)

概述 本文主要介绍scrapy架构图.组建.工作流程,以及结合selenium boss直聘爬虫案例分析 架构图 组件 Scrapy 引擎(Engine) 引擎负责控制数据流在系统中所有组件中流动,并 ...

- scrapy——7 scrapy-redis分布式爬虫,用药助手实战,Boss直聘实战,阿布云代理设置

scrapy——7 什么是scrapy-redis 怎么安装scrapy-redis scrapy-redis常用配置文件 scrapy-redis键名介绍 实战-利用scrapy-redis分布式爬 ...

- Pyhton爬虫实战 - 抓取BOSS直聘职位描述 和 数据清洗

Pyhton爬虫实战 - 抓取BOSS直聘职位描述 和 数据清洗 零.致谢 感谢BOSS直聘相对权威的招聘信息,使本人有了这次比较有意思的研究之旅. 由于爬虫持续爬取 www.zhipin.com 网 ...

- Scrapy 爬取BOSS直聘关于Python招聘岗位

年前的时候想看下招聘Python的岗位有多少,当时考虑目前比较流行的招聘网站就属于boss直聘,所以使用Scrapy来爬取下boss直聘的Python岗位. 1.首先我们创建一个Scrapy 工程 s ...

- Python的scrapy之爬取boss直聘网站

在我们的项目中,单单分析一个51job网站的工作职位可能爬取结果不太理想,所以我又爬取了boss直聘网的工作,不过boss直聘的网站一次只能展示300个职位,所以我们一次也只能爬取300个职位. jo ...

- python爬虫10 | 网站维护人员:真的求求你们了,不要再来爬取了!!

今天 小帅b想给大家讲一个小明的小故事 ... 话说 在很久很久以前 小明不小心发现了一个叫做 学习python的正确姿势 的公众号 从此一发不可收拾 看到什么网站都想爬取 有一天 小明发现了一个小黄 ...

- Python 网络爬虫 006 (编程) 解决下载(或叫:爬取)到的网页乱码问题

解决下载(或叫:爬取)到的网页乱码问题 使用的系统:Windows 10 64位 Python 语言版本:Python 2.7.10 V 使用的编程 Python 的集成开发环境:PyCharm 20 ...

- Python 网络爬虫 005 (编程) 如何编写一个可以 下载(或叫:爬取)一个网页 的网络爬虫

如何编写一个可以 下载(或叫:爬取)一个网页 的网络爬虫 使用的系统:Windows 10 64位 Python 语言版本:Python 2.7.10 V 使用的编程 Python 的集成开发环境:P ...

- 爬虫系列---scrapy全栈数据爬取框架(Crawlspider)

一 简介 crawlspider 是Spider的一个子类,除了继承spider的功能特性外,还派生了自己更加强大的功能. LinkExtractors链接提取器,Rule规则解析器. 二 强大的链接 ...

随机推荐

- PV UV QPS 并发数

TPS(Transactions Per Second):每秒事务数 QPS(Query Per Second):每秒请求数,QPS其实是衡量吞吐量的一个常用指标,就是说服务器在一秒的时间内处理了多少 ...

- 把路由器改装成git服务器(OpenWRT环境的GIT服务器搭建)

在单位中,通常都标配了git服务器用来管理代码. 对于家庭或者小办公室,这种方式有点不经济.当然如果是开源项目就简单了,刚刚被微软收购的github是理想选择.但如果没有打算开源,我今天的话题可能对你 ...

- c# 中的封装、继承、多态详解

面向对象有封装.继承.多态这三个特性,面向对象编程按照现实世界的特点来管理复杂的事物,把它们抽象为对象,具有自己的状态和行为,通过对消息的反应来完成任务.这种编程方法提供了非常强大的多样性,大大增加了 ...

- StackExchange.Redis .net core Timeout performing 超时问题

最近在做的一个项目,用的.net core 2.1,然后缓存用的Redis,缓存相关封装是同事写的,用的驱动是StackExchange.Redis version 2.0.571 ,一直听说这个驱动 ...

- springboot+mybatis+dubbo+aop日志第二篇

本篇主要介绍dubbo-demo-api接口层和dubbo-demo-service层,以及如何通过dubbo把服务发布出去,介绍代码前,咱们先来回顾一下整个demo工程的结构,如下图所示: 1.du ...

- leetcode — subsets

import java.util.ArrayList; import java.util.Arrays; import java.util.List; /** * Source : https://o ...

- Linux基础知识第八讲,系统相关操作命令

目录 Linux基础知识第八讲,系统相关操作命令 一丶简介命令 2.磁盘信息查看. 3.系统进程 Linux基础知识第八讲,系统相关操作命令 一丶简介命令 时间和日期 date cal 磁盘和目录空间 ...

- REST API设计指导——译自Microsoft REST API Guidelines(一)

前言 前面我们说了,有章可循,有据可依,有正确的产品流程和规范,我们的工作才不至于产生混乱,团队的工作才能更有成效.我们经常见到,程序开发可能只用了半个月,但是接口的联调却经常需要花费半个月甚至一个月 ...

- js内存深入学习(一)

一. 内存空间储存 某些情况下,调用堆栈中函数调用的数量超出了调用堆栈的实际大小,浏览器会抛出一个错误终止运行.这个就涉及到内存问题了. 1. 数据结构类型 栈: 后进先出(LIFO)的数据结构 堆 ...

- [Luogu4705] 玩游戏

Description 给定两个长度分别为 \(n\) 和 \(m\) 的序列 \(a\) 和 \(b\).要从这两个序列中分别随机一个数,设为 \(a_x,b_y\),定义该次游戏的 \(k\) 次 ...