python获取网站http://www.weather.com.cn 城市 8-15天天气

参考一个前辈的代码,修改了一个案例开始学习beautifulsoup做爬虫获取天气信息,前辈获取的是7日内天气,

我看旁边还有8-15日就模仿修改了下。其实其他都没有变化,只变换了获取标签的部分。但是我碰到

一个span获取的问题,如我的案例中每日的源代码是这样的。

<li class="t">

<span class="time">周五(19日)</span>

<big class="png30 d301"></big>

<big class="png30 n301"></big>

<span class="wea">雨</span>

<span class="tem"><em>℃</em>/℃</span>

<span class="wind">东南风</span>

<span class="wind1">微风</span>

</li>

上门的所有span标签中,日期,天气,风向都可以通过beautifulsoup进行标签匹配获取。唯独温度获取不到,

获取到的值为none,我奇怪了好酒,用span.em能获取到36°,获取不完全,不符合我的要求。最后没办法。

我只能通过获取到这个span这一回内容

<span class="tem"><em>℃</em>/℃</span>

然后通过字符串替换替换掉多余的字符。剩余36℃/22℃

得到这个结果。存入变量并写入csv文件。

以下为全部代码,如有不对的地方欢迎指教。

'''

Created on 2017年5月10日 @author: bekey qq:402151718

''' #conding:UTF-8 import requests

import csv

import random

import time

import socket

import http.client

#import urllib.request

from bs4 import BeautifulSoup def get_content(url , data = None):

header={

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,*/*;q=0.8',

'Accept-Encoding': 'gzip, deflate, sdch',

'Accept-Language': 'zh-CN,zh;q=0.8',

'Connection': 'keep-alive',

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/57.0.2987.133 Safari/537.36'

}

timeout = random.choice(range(80, 180))

while True:

try:

rep = requests.get(url,headers = header,timeout = timeout)

rep.encoding = 'utf-8'

# req = urllib.request.Request(url, data, header)

# response = urllib.request.urlopen(req, timeout=timeout)

# html1 = response.read().decode('UTF-8', errors='ignore')

# response.close()

break

# except urllib.request.HTTPError as e:

# print( '1:', e)

# time.sleep(random.choice(range(5, 10)))

#

# except urllib.request.URLError as e:

# print( '2:', e)

# time.sleep(random.choice(range(5, 10)))

except socket.timeout as e:

print( '3:', e)

time.sleep(random.choice(range(8,15))) except socket.error as e:

print( '4:', e)

time.sleep(random.choice(range(20, 60))) except http.client.BadStatusLine as e:

print( '5:', e)

time.sleep(random.choice(range(30, 80))) except http.client.IncompleteRead as e:

print( '6:', e)

time.sleep(random.choice(range(5, 15))) return rep.text

# return html_text def get_data(html_text):

final = []

bs = BeautifulSoup(html_text, "html.parser") # 创建BeautifulSoup对象

body = bs.body # 获取body部分

data = body.find('div', {'id': '15d'}) # 找到id为7d的div

ul = data.find('ul') # 获取ul部分

li = ul.find_all('li') # 获取所有的li for day in li: # 对每个li标签中的内容进行遍历

temp = []

#print(day)

span = day.find_all('span') #找到所有的span标签

#print(span)

date = span[0].string # 找到日期

temp.append(date) # 添加到temp中

wea1 = span[1].string#获取天气情况

temp.append(wea1) #加入到list

tem =str(span[2])

tem = tem.replace('<span class="tem"><em>', '')

tem = tem.replace('</span>','')

tem = tem.replace('</em>','')

#tem = tem.find('span').string #获取温度

temp.append(tem) #温度加入list windy = span[3].string

temp.append(windy)#加入到list

windy1 = span[4].string

temp.append(windy1)#加入到list

final.append(temp) return final def write_data(data, name):

file_name = name

with open(file_name, 'a', errors='ignore', newline='') as f:

f_csv = csv.writer(f)

f_csv.writerows(data) if __name__ == '__main__':

url ='http://www.weather.com.cn/weather15d/101180101.shtml'

html = get_content(url)

#print(html)

result = get_data(html)

#print(result)

write_data(result, 'weather7.csv')

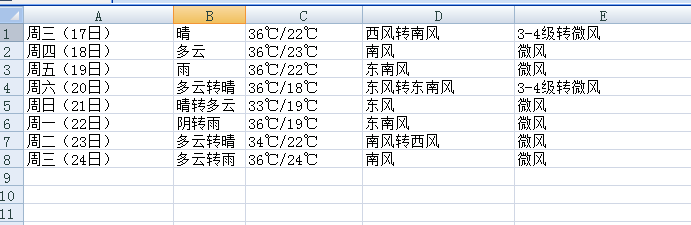

效果如图:

项目地址:git@github.com:zhangbei59/weather_get.git

python获取网站http://www.weather.com.cn 城市 8-15天天气的更多相关文章

- [Python爬虫] 之一 : Selenium+Phantomjs动态获取网站数据信息

本人刚才开始学习爬虫,从网上查询资料,写了一个利用Selenium+Phantomjs动态获取网站数据信息的例子,当然首先要安装Selenium+Phantomjs,具体的看 http://www.c ...

- ios项目开发(天气预报项目):使用正则获取 weather.com.cn站点信息

NSString *pattern = @"(?<=<td class=\"bigblod\">).*?(?=</td>)"; 2 ...

- Python 获取车票信息

提示:该代码仅供学习使用,切勿滥用!!! 先来一个git地址:https://gitee.com/wang_li/li_wang 效果图: 逻辑: 1.获取Json文件的内容 2.根据信息生成URL ...

- 【原创分享】python获取乌云最新提交的漏洞,邮件发送

#!/usr/bin/env python # coding:utf-8 # @Date : 2016年4月21日 15:08:44 # @Author : sevck (sevck@jdsec.co ...

- php 抓取天气情况 www.weather.com.cn

<?php print_r(getweather(101120501)); /** * Server 天气情况获取函数 * @param unknown $city */ function ge ...

- Python识别网站验证码

http://drops.wooyun.org/tips/6313 Python识别网站验证码 Manning · 2015/05/28 10:57 0x00 识别涉及技术 验证码识别涉及很多方面的内 ...

- 再谈获取网站图标Icon

上一篇文章讨论了一下获取网站图标方法,是通过从根目录直接获取和html解析结合的方式来获取的,并给出了相应的代码示例.这一篇来讨论一个更现成的方法,这个方法是从360导航的页面发现的,在导航页面中点击 ...

- 获取网站图标Icon

通常情况下,做网站的都会给自己的网站添加一个Icon,浏览器上一长排的标签页,用Icon来区分就显得更加醒目.现在想找一个没有Icon的网站并不好找,可见没有Icon的网站是多么的业余啊." ...

- Python获取服务器的厂商和型号信息-乾颐堂

Python获取服务器的厂商和型号信息,在RHEHL6下,需要系统预装python-dmidecode这个包(貌似默认就已经装过了) 脚本内容如下 [root@linuxidc tmp]# cat t ...

随机推荐

- JVM的逃逸分析

我们都知道Java中的对象默认都是分配到堆上,在调用栈中,只保存了对象的指针.当对象不再使用后,需要依靠GC来遍历引用树并回收内存.如果堆中对象数量太多,回收对象还有整理内存,都会会带来时间上的消耗, ...

- CodeForces765A

A. Neverending competitions time limit per test:2 seconds memory limit per test:512 megabytes input: ...

- Linux:curl

curl命令用来做HTTP协议的客户端,可以通过命令参数生成各种请求,非常强大. 1. GET 默认情况下下curl执行的是GET操作,所以可以当做wget使用如 $ curl https://www ...

- nodejs中创建web服务,监听本地IP

nodejs官网例子 var http = require('http'); http.createServer(function (req, res) { res.writeHead(200, {' ...

- php5.5过渡--mysql连接

以前: // $conn=mysql_connect("localhost","root","");// $db=mysql_select_ ...

- 移动端实现上拉加载更多(使用dropload.js vs js)

做下笔记,:移动端实现上拉加载更多,其实是数据的分段加载,在这里为了做测试我写了几个json文件作为分段数据: 方式一:使用dropload.js; 配置好相关参数及回调函数就可使用:代码如下 var ...

- Less与Sass框架

一.Less语法 1.变量声明: @变量名:变量值; @newHeight:20px; 2.调用变量: .box { width: @newHeight; height: @newHeight; } ...

- Android微信支付—注意事项

坑点一:PayReq的参数 sign的生成 PayReq对象有个参数为packageValue 而sign生成时要用到packageValue,但是对应的Key是package,这里的key容易弄错 ...

- 5.Spring MVC 自动装配问题

一.使用@controller注解,实际上也是在IOC容器中配置了,它的id是类的首字母小写 一.使用@controller注解,实际上也是在IOC容器中配置了,它的id是类的首字母小写 1.如果不使 ...

- 5.FileWriter 和 BufferWriter

FileWriter 和 BufferWriter的使用场景 IO这块,各种Writer,Reader,让人眼晕 而在网上基本找不到在什么时候用哪个类,并且网上的IO demo 很多用法都是错的 在 ...