datawhale爬虫实训4

DataWhale-Task4(爬取丁香园2)

任务:使用lxml爬虫帖子相关的回复与部分用户信息(用户名,头像地址,回复详情)

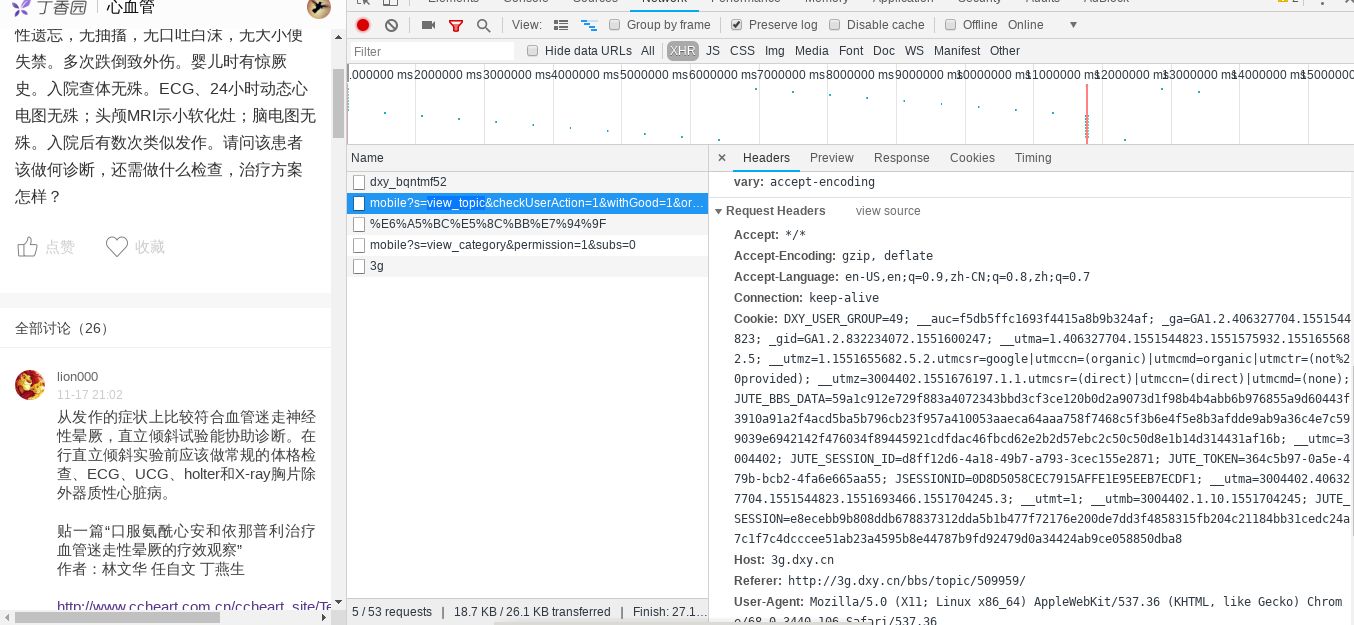

难点:需要登录才能看到所有回复

浏览器登录上去,查看cookies信息,复制,通过request.get()的参数使用标识登录身份的cookies,这样便着请求所回复(直接请求帖子主页的只是html,需要向对应的api发起请求才能看到回帖数据)

cookies = {}

temp = "DXY_USER_GROUP=49; __auc=f5db5ffc1693f4415a8b9b324af; _ga=GA1.2.406327704.1551544823; _gid=GA1.2.832234072.1551600247; __utma=1.406327704.1551544823.1551575932.1551655682.5; __utmz=1.1551655682.5.2.utmcsr=google|utmccn=(organic)|utmcmd=organic|utmctr=(not%20provided); __utmz=3004402.1551676197.1.1.utmcsr=(direct)|utmccn=(direct)|utmcmd=(none); JUTE_BBS_DATA=59a1c912e729f883a4072343bbd3cf3ce120b0d2a9073d1f98b4b4abb6b976855a9d60443f3910a91a2f4acd5ba5b796cb23f957a410053aaeca64aaa758f7468c5f3b6e4f5e8b3afdde9ab9a36c4e7c599039e6942142f476034f89445921cdfdac46fbcd62e2b2d57ebc2c50c50d8e1b14d314431af16b; __utmc=3004402; JUTE_SESSION_ID=d8ff12d6-4a18-49b7-a793-3cec155e2871; JUTE_TOKEN=364c5b97-0a5e-479b-bcb2-4fa6e665aa55; JSESSIONID=0D8D5058CEC7915AFFE1E95EEB7ECDF1; __utma=3004402.406327704.1551544823.1551693466.1551704245.3; __utmt=1; __utmb=3004402.1.10.1551704245; JUTE_SESSION=e8ecebb9b808ddb678837312dda5b1b477f72176e200de7dd3f4858315fb204c21184bb31cedc24a7c1f7c4dcccee51ab23a4595b8e44787b9fd92479d0a34424ab9ce058850dba8"

for i in temp.split(';'):

li = i.strip().split('=')

cookies[li[0]] = li[1]

完整代码

import requests

import json

import re

from lxml import etree

def display(topic):

"""

topic: 字典,键值有 topic comment

topic key 主题名

comment key 相关评论

"""

print("主题:\n", topic['topic'])

print("主题评论:\n")

for item in topic['comment']:

for k, v in item.items():

print(k, '\n')

print('\t头像:', v['avatar'], '\n')

print('\t评论:', v['body'], '\n')

def main(url, headers, cookies):

topic = {}

index = 1

resp = requests.get(url, headers=headers, cookies=cookies)

maxpage = resp.json()['pageBean']['total'] # 获取回复的全部页数

topic['topic'] = resp.json()['subject'] # 该帖子的主题

topic['comment'] = [] # 回复列表

while index < maxpage:

target_url = url.format(index)

resp = requests.get(target_url, headers=headers, cookies=cookies)

for item in resp.json()['items']:

d = {

item['nickname']: {'avatar': item['user']['avatar'],

'body': item["body"]}

}

topic['comment'].append(d)

index += 1

display(topic)

if __name__ == '__main__':

cookies = {}

headers = {

'User-Agent': ('Mozilla/5.0 (X11; Linux x86_64)'

' AppleWebKit/537.36 (KHTML, like Gecko)'

' Chrome/68.0.3440.106 Safari/537.36')

}

# temp为复制的 cookies

temp = "DXY_USER_GROUP=49; __auc=f5db5ffc1693f4415a8b9b324af; _ga=GA1.2.406327704.1551544823; _gid=GA1.2.832234072.1551600247; __utma=1.406327704.1551544823.1551575932.1551655682.5; __utmz=1.1551655682.5.2.utmcsr=google|utmccn=(organic)|utmcmd=organic|utmctr=(not%20provided); __utmz=3004402.1551676197.1.1.utmcsr=(direct)|utmccn=(direct)|utmcmd=(none); JUTE_BBS_DATA=59a1c912e729f883a4072343bbd3cf3ce120b0d2a9073d1f98b4b4abb6b976855a9d60443f3910a91a2f4acd5ba5b796cb23f957a410053aaeca64aaa758f7468c5f3b6e4f5e8b3afdde9ab9a36c4e7c599039e6942142f476034f89445921cdfdac46fbcd62e2b2d57ebc2c50c50d8e1b14d314431af16b; __utmc=3004402; JUTE_SESSION_ID=d8ff12d6-4a18-49b7-a793-3cec155e2871; JUTE_TOKEN=364c5b97-0a5e-479b-bcb2-4fa6e665aa55; JSESSIONID=0D8D5058CEC7915AFFE1E95EEB7ECDF1; __utma=3004402.406327704.1551544823.1551693466.1551704245.3; __utmt=1; __utmb=3004402.1.10.1551704245; JUTE_SESSION=e8ecebb9b808ddb678837312dda5b1b477f72176e200de7dd3f4858315fb204c21184bb31cedc24a7c1f7c4dcccee51ab23a4595b8e44787b9fd92479d0a34424ab9ce058850dba8"

for i in temp.split(';'):

li = i.strip().split('=')

cookies[li[0]] = li[1]

url = ("http://3g.dxy.cn/bbs/bbsapi/mobile?"

"s=view_topic&checkUserAction=1&with"

"Good=1&order=0&size=20&id=509959&page={}")

main(url, headers, cookies)

结果

datawhale爬虫实训4的更多相关文章

- Python-爬虫实战 简单爬取豆瓣top250电影保存到本地

爬虫原理 发送数据 获取数据 解析数据 保存数据 requests请求库 res = requests.get(url="目标网站地址") 获取二进制流方法:res.content ...

- Python实训day07pm【Selenium操作网页、爬取数据-下载歌曲】

练习1-爬取歌曲列表 任务:通过两个案例,练习使用Selenium操作网页.爬取数据.使用无头模式,爬取网易云的内容. ''' 任务:通过两个案例,练习使用Selenium操作网页.爬取数据. 使用无 ...

- 自律训练法 John Sehorz

自律训练法,系1932年由德国精神医学医师John Sehorz所创立.他研究人们在催眠催眠状态下,所呈现的生理状态,如:沉重与温暖感.. ,因而,John Sehorz改以「逆向操作」之方式,由自我 ...

- Java爬取51job保存到MySQL并进行分析

大二下实训课结业作业,想着就爬个工作信息,原本是要用python的,后面想想就用java试试看, java就自学了一个月左右,想要锻炼一下自己面向对象的思想等等的, 然后网上转了一圈,拉钩什么的是动态 ...

- 利用爬虫将Yuan先生的博客文章爬取下来

由于一次巧遇,我阅读了Yuan先生的一篇博客文章,感觉从Yuan先生得博客学到很多东西,很喜欢他得文章.于是我就关注了他,并且想阅读更多出自他手笔得博客文章,无奈,可能Yuan先生不想公开自己得博客吧 ...

- 正则表达式和豆瓣Top250的爬取练习

datawhale任务2-爬取豆瓣top250 正则表达式 豆瓣250页面分析 完整代码 参考资料 正则表达式 正则表达式的功能用于实现字符串的特定模式精确检索或替换操作. 常用匹配模式 常用修饰符 ...

- 学校实训作业:Java爬虫(WebMagic框架)的简单操作

项目名称:java爬虫 项目技术选型:Java.Maven.Mysql.WebMagic.Jsp.Servlet 项目实施方式:以认知java爬虫框架WebMagic开发为主,用所学java知识完成指 ...

- 路飞学城—Python爬虫实战密训班 第三章

路飞学城—Python爬虫实战密训班 第三章 一.scrapy-redis插件实现简单分布式爬虫 scrapy-redis插件用于将scrapy和redis结合实现简单分布式爬虫: - 定义调度器 - ...

- Scrapy框架爬虫初探——中关村在线手机参数数据爬取

关于Scrapy如何安装部署的文章已经相当多了,但是网上实战的例子还不是很多,近来正好在学习该爬虫框架,就简单写了个Spider Demo来实践.作为硬件数码控,我选择了经常光顾的中关村在线的手机页面 ...

随机推荐

- Top10Servlet

<span style="font-size:18px;">/** * Top10 * author:杨鑫 */ package servlet; import jav ...

- 查看scn headroom变化趋势的几种方法

查看scn headroom变化趋势的几种方法 scn headroom问题,本文不做解释. 本文为自己的总结,脚本来自于oracle sr技术project师. 转载请注明出处http://blog ...

- luogu4218 [JSOI2008] 最小生成树计数

题目大意 求一个加权无向图的最小生成树的个数.1<=n<=100; 1<=m<=1000,具有相同权值的边不会超过10条. 题解 命题1 由构成最小生成树的边的边权从小到大排序 ...

- luogu2152 [SDOI2009]SuperGCD

要你求两个非常大的数字的GCD. 不要想复杂,用高精度整更相减损术即可. #include <cstdio> #include <cstring> #include <a ...

- bzoj4737: 组合数问题

终于过了肝了一天啊,怎么我最近都在做细节码农题啊 (这种水平NOIP凉凉??) luacs大家都可以想到用吧,一开始我的思路是把所有在p以内的%p==0的组合数预处理出来,那C(n/p,m/p)任取, ...

- 电脑升级win10后visio的问题

上周由于电脑意外蓝屏,系统从win7升级到了win10,昨天工作写文档时才发现缺少画图的工具,于是按照了visio2013,在编辑设计图时发现,一旦用visio打开或编辑图后再到word里设计图的内容 ...

- ubuntu 12.10 禁用触摸板

1. 打开终端,输入 sudo rmmod psmouse 禁用触摸板,输入 sudo modprobe psmouse 恢复触摸板 2.syndaemon -i 10 -d >/dev/nul ...

- k-means 聚类前的数据分析

原始数据 Say you are given a data set where each observed example has a set of features, but has nolabel ...

- Gym - 101981A The 2018 ICPC Asia Nanjing Regional Contest A.Adrien and Austin 简单博弈

题面 题意:一堆有n个石子,编号从1⋯N排成一列,两个人Adrien 和Austin玩游戏,每次可以取1⋯K个连续编号的石子,Adrien先手,谁不能取了则输 题解:k==1时,显然和n奇偶相关,当k ...

- tp 推送微信的模板消息

设置推送类: <?php /** * tpshop 微信支付插件 * ============================================================== ...