06yarn简介

YARN简介

一、YARN是什么

YARN不是facebook的那个yarn,它从Hadoop 2引入,最初目的是改善MapReduce的实现,但是因为具备足够通用性,同样也可以支持其他的分布式计算模式。YARN全称是Yet Another Resource Negotiator,翻译过来是另一种资源协调者,名字听起来有点奇怪,但是不难看出它的用途是管理和调度Hadoop中的资源,具体来说是计算资源。

YARN和DHFS一样也是主从架构,它有两种服务,分为resourcemanager和nodemanager。resourcemanager负责管理nodemanager和application master进程,nodemanager负责管理容器,以及监控容器使用资源。

YARN有几个重要的概念:

- resourcemanager:资源管理器,管理和协调集群资源

- nodemanager:节点管理器,启动容器运行应用,监控容器的资源使用资源,周期向资源管理器报告自己的状态

- container:容器,nodemanager管理的资源的最小单元

- application master:应用的第一个进程,可以直接运行或者继续向资源管理器申请资源

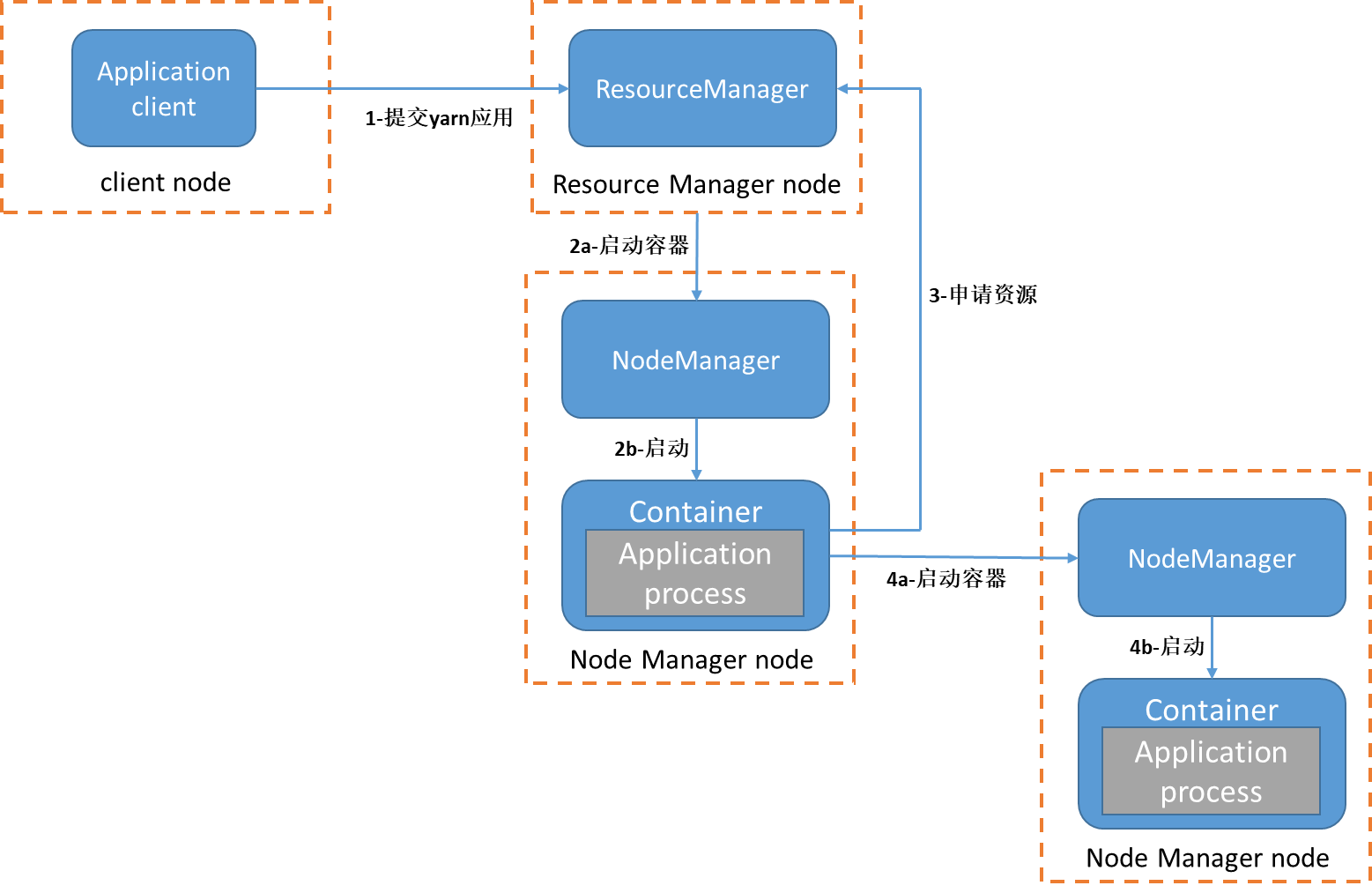

一个YARN应用的启动流程如下,图中每一个虚线框代表一个物理机器:

首先客户端提交作业到resourcemanager资源管理器(图中第1步)。resourcemanager资源管理器寻找集群中可用资源,向nodemanager节点管理器发出创建容器请求(图中2a步骤)。随后容器启动并运行应用程序,也就是application master进程(图中2b步骤),application master会运行周期的向资源管理器报告自己的状态。应用程序可能做什么取决于应用本身,应用可能只是简单执行任务,或者向集群继续申请资源运行多个子任务。例如MapReduce应用,它会把大任务拆分成小任务,然后向resourcemanager资源管理器申请资源(图中第3步),并且运行小任务(图中4a和4b步骤)。YARN本身并不会为应用的进程提供通信手段,应用之间的通信手段是专属于应用本身。

二、一个MapReduce应用运行的简单分析

下面通过在集群运行一个简单MapReduce应用来理解YARN应用的启动流程

1、集群拓扑图

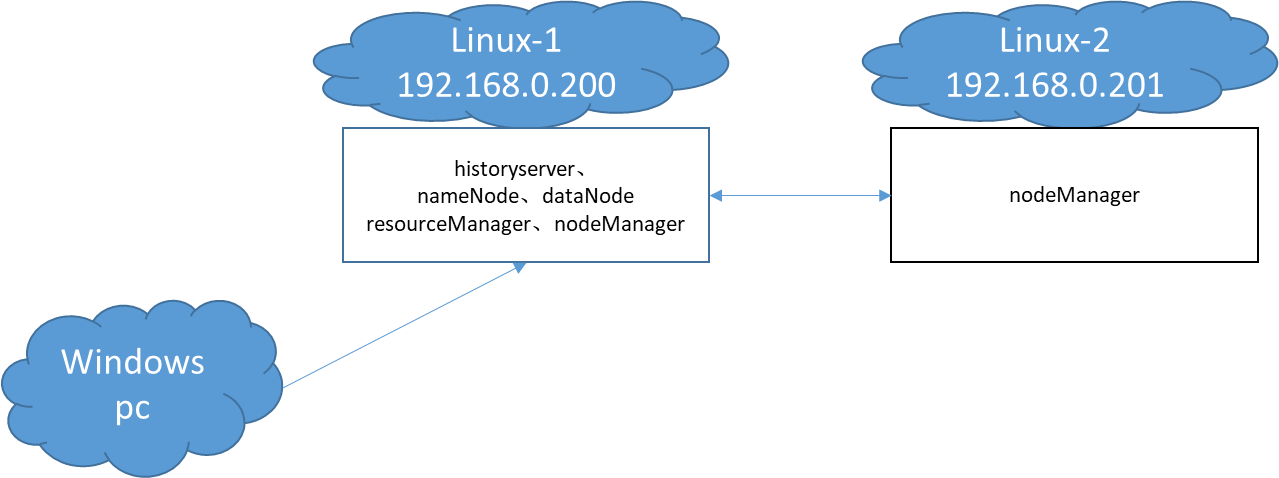

笔者的集群拓扑图如下:

Linux-1运行一个资源管理器和节点管理器,Linux-2只运行一个节点管理器,提交任务的是一台Windows主机。Windows机器的ip是192.168.0.109

2、应用启动

先用jps查看集群各个机器当前运行的进程:

-- Linux-1 192.168.0.200

debian@Linux-1:~$ jps

848 ResourceManager

4112 Jps

752 DataNode

1088 NodeManager

663 NameNode

-- Linux-2 192.168.0.201

debian@Linux-2:~$ jps

15893 Jps

10219 NodeManager

然后向集群提交应用,可能会看到如下输出:

这里提交的应用还是maxSaleMapReduce,唯一不同的是配置文件mapreduce.job.running.map.limit(map同时最大运行数量)设置成3。可以在https://github.com/xunpengliu/hello-hadoop获取代码,如果之前已经下载过需要拉取最新代码后重新打包

23/02/07 17:26:27 INFO client.RMProxy: Connecting to ResourceManager at /192.168.0.200:8032

23/02/07 17:26:37 INFO input.FileInputFormat: Total input files to process : 5

23/02/07 17:26:37 INFO mapreduce.JobSubmitter: number of splits:15

23/02/07 17:26:38 INFO mapreduce.JobSubmitter: Submitting tokens for job: job_1675757920071_0004

23/02/07 17:26:38 INFO conf.Configuration: resource-types.xml not found

23/02/07 17:26:38 INFO resource.ResourceUtils: Unable to find 'resource-types.xml'.

23/02/07 17:26:38 INFO resource.ResourceUtils: Adding resource type - name = memory-mb, units = Mi, type = COUNTABLE

23/02/07 17:26:38 INFO resource.ResourceUtils: Adding resource type - name = vcores, units = , type = COUNTABLE

23/02/07 17:26:38 INFO impl.YarnClientImpl: Submitted application application_1675757920071_0004

23/02/07 17:26:38 INFO mapreduce.Job: The url to track the job: http://192.168.0.200:8088/proxy/application_1675757920071_0004/

23/02/07 17:26:38 INFO mapreduce.Job: Running job: job_1675757920071_0004

23/02/07 17:26:43 INFO mapreduce.Job: Job job_1675757920071_0004 running in uber mode : false

23/02/07 17:26:43 INFO mapreduce.Job: map 0% reduce 0%

23/02/07 17:26:59 INFO mapreduce.Job: map 3% reduce 0%

23/02/07 17:27:00 INFO mapreduce.Job: map 11% reduce 0%

可以看到当前应用id是application_1675757920071_0004,作业id是job_1675757920071_0004,从 http://192.168.0.200:8088/proxy/application_1675757920071_0004/ 可以查询到应用运行状态。

等一小会,再使用jps查看运行的进程,可以看到多了1个MRAppMaster和3个YarnChild和进程。查看MRAppMaster进程端口绑定情况和NodeManager的进程树:

-- Linux-1 192.168.0.200

debian@Linux-1:~$ jps

848 ResourceManager

752 DataNode

1088 NodeManager

3649 MRAppMaster

663 NameNode

3754 YarnChild

3789 Jps

debian@Linux-1:~$ pstree -T -p 1088

java(1088)─┬─bash(3628)───bash(3648)───java(3649)

└─bash(3795)───bash(3750)───java(3754)

debian@Linux-1:~$ lsof -i | grep 3649

java 3649 debian 262u IPv6 88478 0t0 TCP *:43763 (LISTEN)

java 3649 debian 273u IPv6 88485 0t0 TCP *:42565 (LISTEN)

java 3649 debian 279u IPv6 88487 0t0 TCP *:41731 (LISTEN)

java 3649 debian 289u IPv6 96002 0t0 TCP 192.168.0.200:50682->192.168.0.200:8030 (ESTABLISHED)

java 3649 debian 291u IPv6 91613 0t0 TCP 192.168.0.200:43763->192.168.0.109:55029 (ESTABLISHED)

java 3649 debian 292u IPv6 96258 0t0 TCP 192.168.0.200:41731->192.168.0.200:46720 (ESTABLISHED)

java 3649 debian 293u IPv6 91977 0t0 TCP 192.168.0.200:41731->192.168.0.201:56746 (ESTABLISHED)

java 3649 debian 261u IPv6 96005 0t0 TCP 192.168.0.200:41731->192.168.0.201:56744 (ESTABLISHED)

-- Linux-2 192.168.0.201

debian@Linux-2:~$ jps

10219 NodeManager

15356 Jps

15326 YarnChild

15295 YarnChild

debian@Linux-2:~$ pstree -T -p 10219

java(10219)─┬─bash(15291)───bash(15293)───java(15295)

└─bash(15320)───bash(15323)───java(15326)

MRAppMaster也就是MapReduce应用的application master进程,它启动后向资源管理器继续申请资源,然后启动3个YARNChild进程来执行子任务,3个子任务分别运行在Linux-1和Linux-2机器上。

maxSaleMapReduce的map任务和reduce任务在启动和完成会各输出一行日志,日志内容有ip、进程启动时间、主类名称、进程pid。日志文件位置在userlogs/${appid}目录中,如果你的集群像笔者一样没开日志聚合也没修改目录,userlogs目录在Hadoop安装位置的logs目录下。日志是按容器进行分组的,例如Linux-2上的application_1675757920071_0004目录就有下面几个文件夹:

debian@Linux-2:~/program/hadoop-2.10.2/logs/userlogs/application_1675757920071_0004$ ll

总用量 44

drwx--x--- 2 debian debian 4096 2月 7 17:26 container_1675757920071_0004_01_000002

drwx--x--- 2 debian debian 4096 2月 7 17:26 container_1675757920071_0004_01_000003

drwx--x--- 2 debian debian 4096 2月 7 17:27 container_1675757920071_0004_01_000007

drwx--x--- 2 debian debian 4096 2月 7 17:27 container_1675757920071_0004_01_000008

drwx--x--- 2 debian debian 4096 2月 7 17:27 container_1675757920071_0004_01_000009

drwx--x--- 2 debian debian 4096 2月 7 17:27 container_1675757920071_0004_01_000011

drwx--x--- 2 debian debian 4096 2月 7 17:27 container_1675757920071_0004_01_000012

drwx--x--- 2 debian debian 4096 2月 7 17:28 container_1675757920071_0004_01_000014

drwx--x--- 2 debian debian 4096 2月 7 17:28 container_1675757920071_0004_01_000015

drwx--x--- 2 debian debian 4096 2月 7 17:28 container_1675757920071_0004_01_000017

drwx--x--- 2 debian debian 4096 2月 7 17:28 container_1675757920071_0004_01_000018

debian@Linux-2:~/program/hadoop-2.10.2/logs/userlogs/application_1675757920071_0004$ ll container_1675757920071_0004_01_000002

总用量 32

-rw-r--r-- 1 debian debian 0 2月 7 17:26 prelaunch.err

-rw-r--r-- 1 debian debian 70 2月 7 17:26 prelaunch.out

-rw-r--r-- 1 debian debian 0 2月 7 17:26 stderr

-rw-r--r-- 1 debian debian 0 2月 7 17:26 stdout

-rw-r--r-- 1 debian debian 27051 2月 7 17:27 syslog

syslog文件有我们自定义输出的日志,日志内容如下:

-- Linux-1 192.168.0.200

debian@Linux-1:~/program/hadoop-2.10.2/logs/userlogs/application_1675757920071_0004$ cat */syslog | grep mainClass

2023-02-07 17:26:44,392 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task setup,ip->192.168.0.200,startTime->2023-02-07 17:26:42,pid->3754,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000002_0, 4]

2023-02-07 17:26:56,849 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task cleanup,ip->192.168.0.200,pid->3754,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000002_0, 4]

2023-02-07 17:27:06,347 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task setup,ip->192.168.0.200,startTime->2023-02-07 17:27:04,pid->3839,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000003_0, 6]

2023-02-07 17:27:18,586 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task cleanup,ip->192.168.0.200,pid->3839,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000003_0, 6]

2023-02-07 17:27:27,675 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task setup,ip->192.168.0.200,startTime->2023-02-07 17:27:25,pid->3904,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000006_0, 10]

2023-02-07 17:27:39,979 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task cleanup,ip->192.168.0.200,pid->3904,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000006_0, 10]

2023-02-07 17:27:48,950 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task setup,ip->192.168.0.200,startTime->2023-02-07 17:27:47,pid->3965,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000009_0, 13]

2023-02-07 17:28:01,263 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task cleanup,ip->192.168.0.200,pid->3965,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000009_0, 13]

2023-02-07 17:28:10,980 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task setup,ip->192.168.0.200,startTime->2023-02-07 17:28:09,pid->4026,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000012_0, 16]

2023-02-07 17:28:15,964 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task cleanup,ip->192.168.0.200,pid->4026,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000012_0, 16]

-- Linux-2 192.168.0.201

debian@Linux-2:~/program/hadoop-2.10.2/logs/userlogs/application_1675757920071_0004$ cat */syslog | grep mainClass

2023-02-07 17:26:43,338 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task setup,ip->192.168.0.201,startTime->2023-02-07 17:26:41,pid->15295,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000000_0, 2]

2023-02-07 17:26:58,315 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task cleanup,ip->192.168.0.201,pid->15295,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000000_0, 2]

2023-02-07 17:26:44,621 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task setup,ip->192.168.0.201,startTime->2023-02-07 17:26:42,pid->15326,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000001_0, 3]

2023-02-07 17:26:59,053 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task cleanup,ip->192.168.0.201,pid->15326,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000001_0, 3]

2023-02-07 17:28:32,397 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleReducer: reducer task setup,ip->192.168.0.201,startTime->2023-02-07 17:27:05,mainClass->org.apache.hadoop.mapred.YarnChild,pid->15421

2023-02-07 17:28:44,596 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleReducer: reducer task cleanup,ip->192.168.0.201,pid->15421,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_r_000000_0, 7]

2023-02-07 17:27:09,522 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task setup,ip->192.168.0.201,startTime->2023-02-07 17:27:07,pid->15467,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000004_0, 8]

2023-02-07 17:27:24,832 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task cleanup,ip->192.168.0.201,pid->15467,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000004_0, 8]

2023-02-07 17:27:11,552 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task setup,ip->192.168.0.201,startTime->2023-02-07 17:27:08,pid->15500,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000005_0, 9]

2023-02-07 17:27:32,893 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task cleanup,ip->192.168.0.201,pid->15500,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000005_0, 9]

2023-02-07 17:27:36,450 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task setup,ip->192.168.0.201,startTime->2023-02-07 17:27:34,pid->15567,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000007_0, 11]

2023-02-07 17:27:52,060 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task cleanup,ip->192.168.0.201,pid->15567,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000007_0, 11]

2023-02-07 17:27:41,647 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task setup,ip->192.168.0.201,startTime->2023-02-07 17:27:40,pid->15617,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000008_0, 12]

2023-02-07 17:27:56,207 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task cleanup,ip->192.168.0.201,pid->15617,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000008_0, 12]

2023-02-07 17:28:01,633 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task setup,ip->192.168.0.201,startTime->2023-02-07 17:28:00,pid->15679,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000010_0, 14]

2023-02-07 17:28:07,591 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task cleanup,ip->192.168.0.201,pid->15679,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000010_0, 14]

2023-02-07 17:28:04,827 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task setup,ip->192.168.0.201,startTime->2023-02-07 17:28:03,pid->15725,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000011_0, 15]

2023-02-07 17:28:11,105 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task cleanup,ip->192.168.0.201,pid->15725,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000011_0, 15]

2023-02-07 17:28:16,469 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task setup,ip->192.168.0.201,startTime->2023-02-07 17:28:14,pid->15783,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000013_0, 17]

2023-02-07 17:28:25,503 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task cleanup,ip->192.168.0.201,pid->15783,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000013_0, 17]

2023-02-07 17:28:17,918 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task setup,ip->192.168.0.201,startTime->2023-02-07 17:28:16,pid->15814,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000014_0, 18]

2023-02-07 17:28:25,095 INFO [main] org.example.helloHadoop.maxSaleMapReduce.MaxSaleMapper: mapper task cleanup,ip->192.168.0.201,pid->15814,mainClass->org.apache.hadoop.mapred.YarnChild,args->[192.168.0.200, 41731, attempt_1675757920071_0004_m_000014_0, 18]

3、应用执行分析

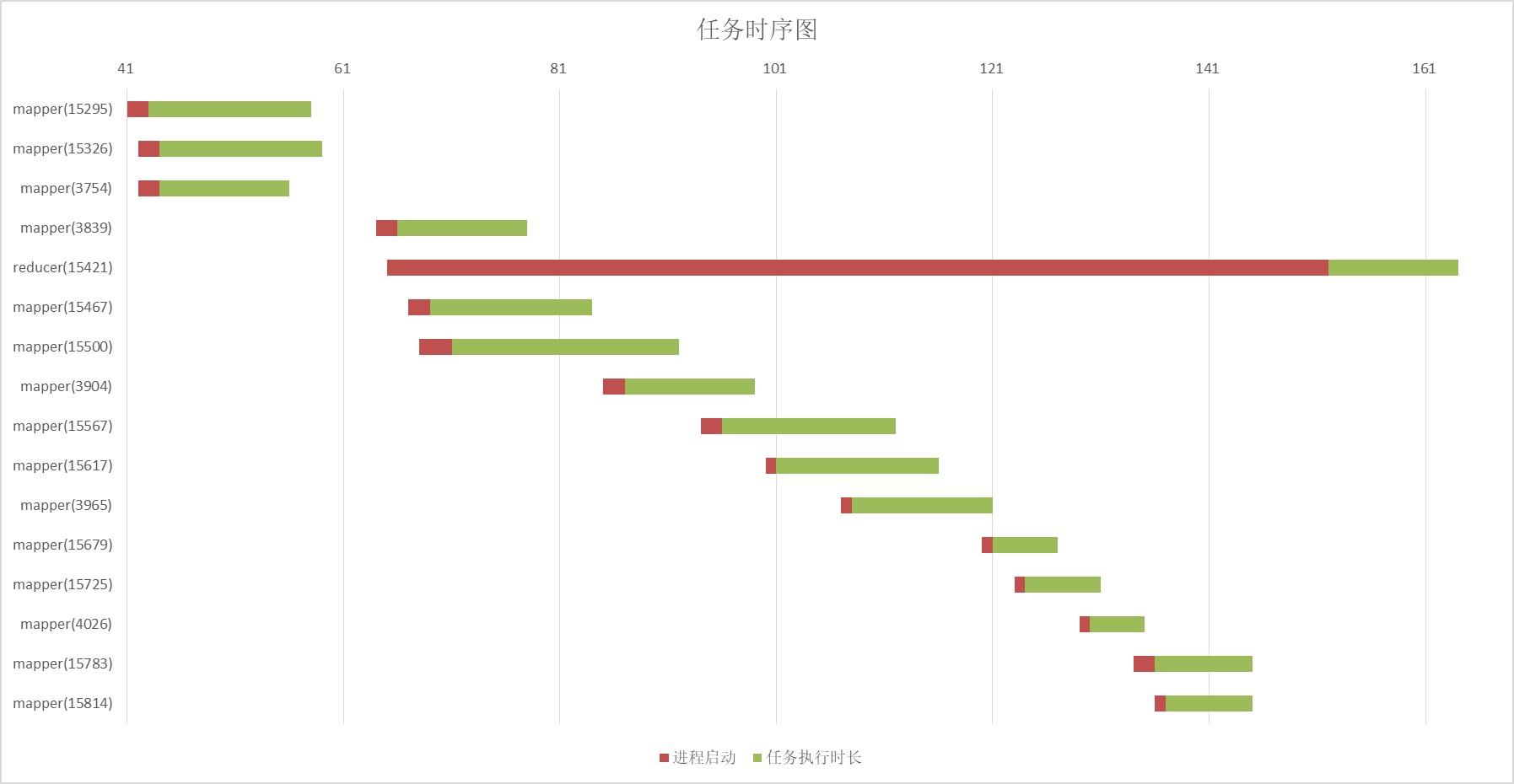

通过日志可以得到map任务和reduce任务甘特图:

红条是进程启动时间,绿条是任务真正开始消耗的时间

从图中不难看出同一时间最多只有3个map任务在运行,reduce任务很早就启动了,但是要等map任务全部完成才真正开始。这个是因为MapReduce的“慢启动”机制,由参数mapreduce.job.reduce.slowstart.completedmaps控制,默认值0.05,相当于map任务完成5%就开始启动reduce任务。

MRAppMaster通过网络连接获取子任务的状态,MRAppMaster地址和绑定的端口会通过启动参数传给子进程,也就是日志输出的192.168.0.200, 41731。同时MRAppMaster会周期性向资源管理器报告自己的状态,也就是这条连接192.168.0.200:50682->192.168.0.200:8030。

所以基本可以简单说明:

- 任务启动首先会运行application master进程

- 节点管理器负责启动容器运行应用的任务

- application master向资源管理器报告自己状态

- application master会根据需要继续申请资源

- 应用通信依赖自身,而不是通过YARN来中转

任务会被分配到不同的机器执行,那执行文件是如何共享的呢?答案是通过HDFS共享,在MRAppMaster的日志中有这样两行:

The job-jar file on the remote FS is hdfs://192.168.0.200:8082/tmp/hadoop-yarn/staging/debian/.staging/job_1675757920071_0004/job.jar

The job-conf file on the remote FS is /tmp/hadoop-yarn/staging/debian/.staging/job_1675757920071_0004/job.xml

从HDFS下载文件对比可以发现,这两个就是任务的可执行文件和使用的配置,同时当前目录下还有一些其他文件,比如我们的自定义依赖库就在libjars文件夹中。

三、YARN调度资源的几种模式

1、三种调度模式

YARN有三种调度器,分别是FIFO调度器(先进先出),容量调度器和公平调度器。

FIFO调度器是最简单的调度器,不需要任何配置,每个应用通过排队的方式使用集群资源。容量调度器通过队列分割资源,不同队列配置的容量不同,应用运行在不同的队列上。公平调度器通过动态的方式调度资源,当一个应用启动它会占用集群所有资源,当第二个应用启动后,它会慢慢等第一个应用释放出的部分资源,最终达到一个动态的公平共享资源。

2、容量调度器配置

假设有这样一个队列层次结构

root─┬─default

└─dev

└─test1

└─test2

修改etc/hadoop/capacity-scheduler.xml文件内容为如下:

更多配置可以参考 https://hadoop.apache.org/docs/r2.10.2/hadoop-yarn/hadoop-yarn-site/CapacityScheduler.html

<configuration>

<property>

<name>yarn.scheduler.capacity.maximum-applications</name>

<value>10000</value>

<description>

最大可以运行多少个应用

</description>

</property>

<property>

<name>yarn.scheduler.capacity.maximum-am-resource-percent</name>

<value>0.1</value>

<description>

application master进程占用的最大资源比例

</description>

</property>

<property>

<name>yarn.scheduler.capacity.root.queues</name>

<value>default,dev</value>

<description>

root队列下的队列

</description>

</property>

<property>

<name>yarn.scheduler.capacity.root.dev.queues</name>

<value>test1,test2</value>

<description>

dev队列下的队列

</description>

</property>

<property>

<name>yarn.scheduler.capacity.root.default.capacity</name>

<value>70</value>

<description>

default队列默认容量

</description>

</property>

<property>

<name>yarn.scheduler.capacity.root.default.maximum-capacity</name>

<value>90</value>

<description>

default队列最大容量

</description>

</property>

<property>

<name>yarn.scheduler.capacity.root.default.acl_submit_applications</name>

<value>*</value>

<description>

哪些用户可以提交作业到default,*全部

</description>

</property>

<property>

<name>yarn.scheduler.capacity.root.default.acl_administer_queue</name>

<value>*</value>

<description>

哪些用户可以控制default队列任务,*全部

</description>

</property>

<property>

<name>yarn.scheduler.capacity.root.default.acl_application_max_priority</name>

<value>*</value>

<description>

哪些用户可以在default队列设置任务优先级,*全部

</description>

</property>

<property>

<name>yarn.scheduler.capacity.root.dev.capacity</name>

<value>30</value>

<description>

dev队列默认容量

</description>

</property>

<property>

<name>yarn.scheduler.capacity.root.dev.maximum-capacity</name>

<value>50</value>

<description>

dev队列最大容量

</description>

</property>

<property>

<name>yarn.scheduler.capacity.root.dev.acl_submit_applications</name>

<value>*</value>

<description>

哪些用户可以提交作业到dev,*全部

</description>

</property>

<property>

<name>yarn.scheduler.capacity.root.dev.acl_administer_queue</name>

<value>*</value>

<description>

哪些用户可以控制dev队列任务,*全部

</description>

</property>

<property>

<name>yarn.scheduler.capacity.root.dev.acl_application_max_priority</name>

<value>*</value>

<description>

哪些用户可以在dev队列设置任务优先级,*全部

</description>

</property>

<property>

<name>yarn.scheduler.capacity.root.dev.test1.capacity</name>

<value>50</value>

<description>

test1队列默认容量

</description>

</property>

<property>

<name>yarn.scheduler.capacity.root.dev.test2.capacity</name>

<value>50</value>

<description>

test2队列默认容量

</description>

</property>

</configuration>

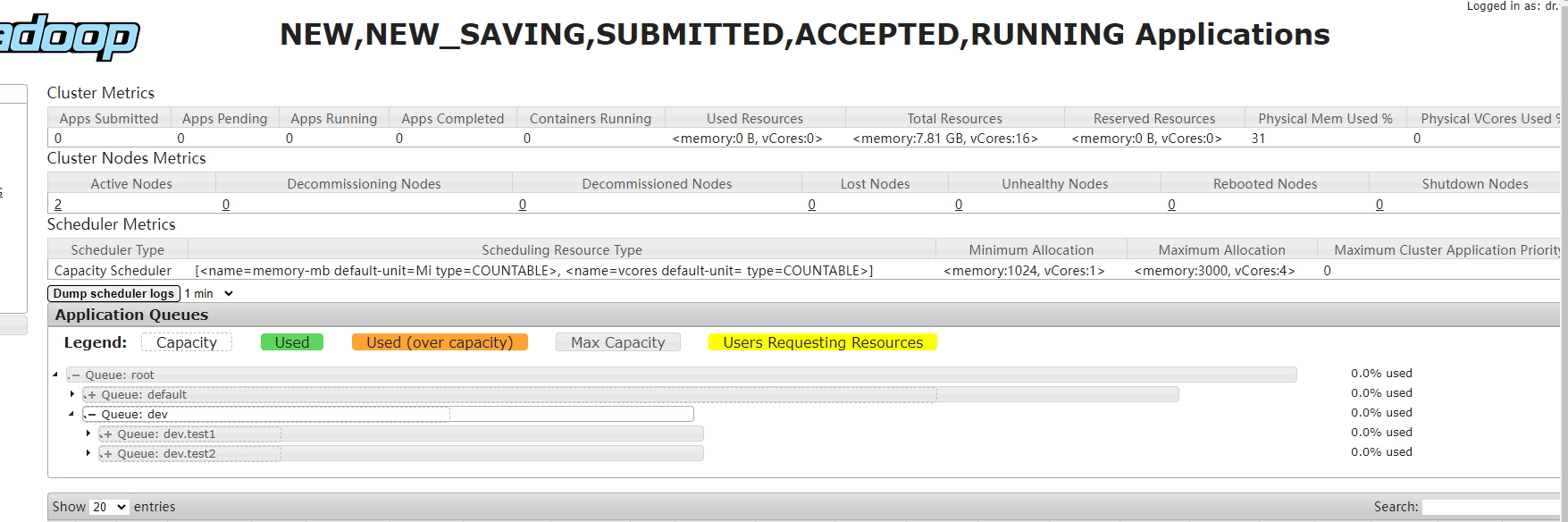

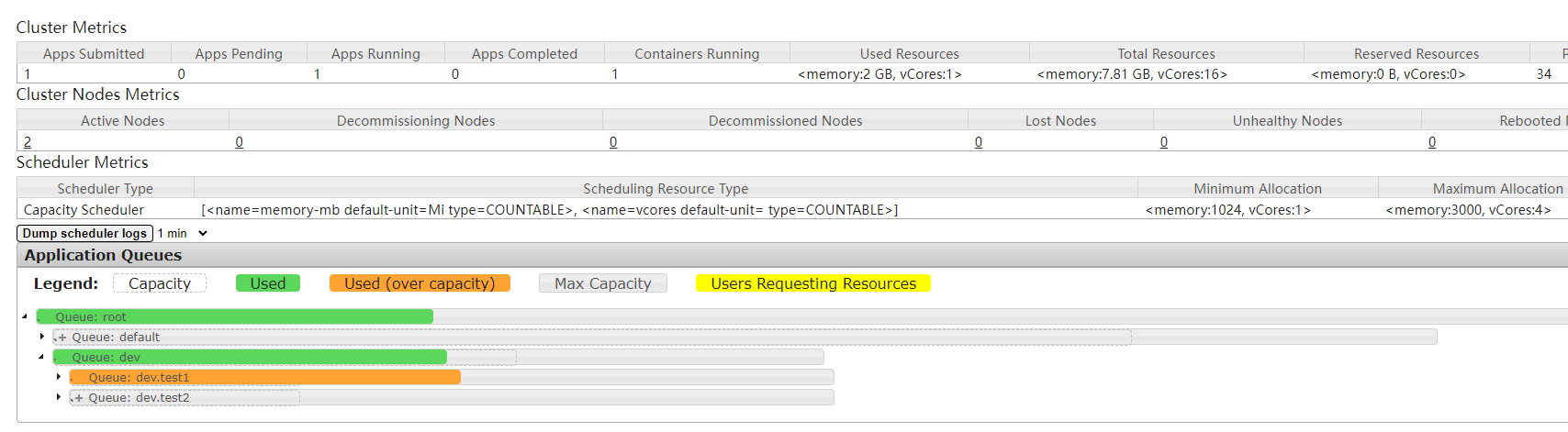

default队列和dev队列分别分配到了70%和30%的资源,dev队列又被分成了test1和test2两个队列,test1和test2平分dev队列资源。可以在资源管理器的web服务看到队列配置:

MapReduce应用通过配置mapreduce.job.queuename来指定运行队列,默认值是default。需要注意的是应该配置的是队列名,例如test1,而不是队列的全局限定名root.dev.test1。

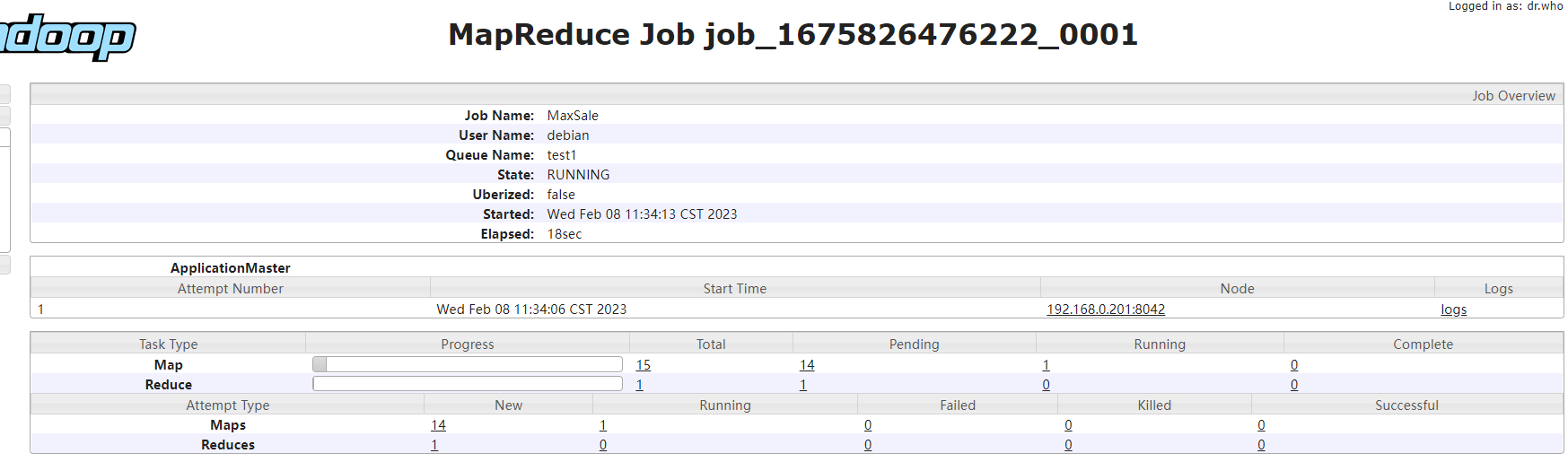

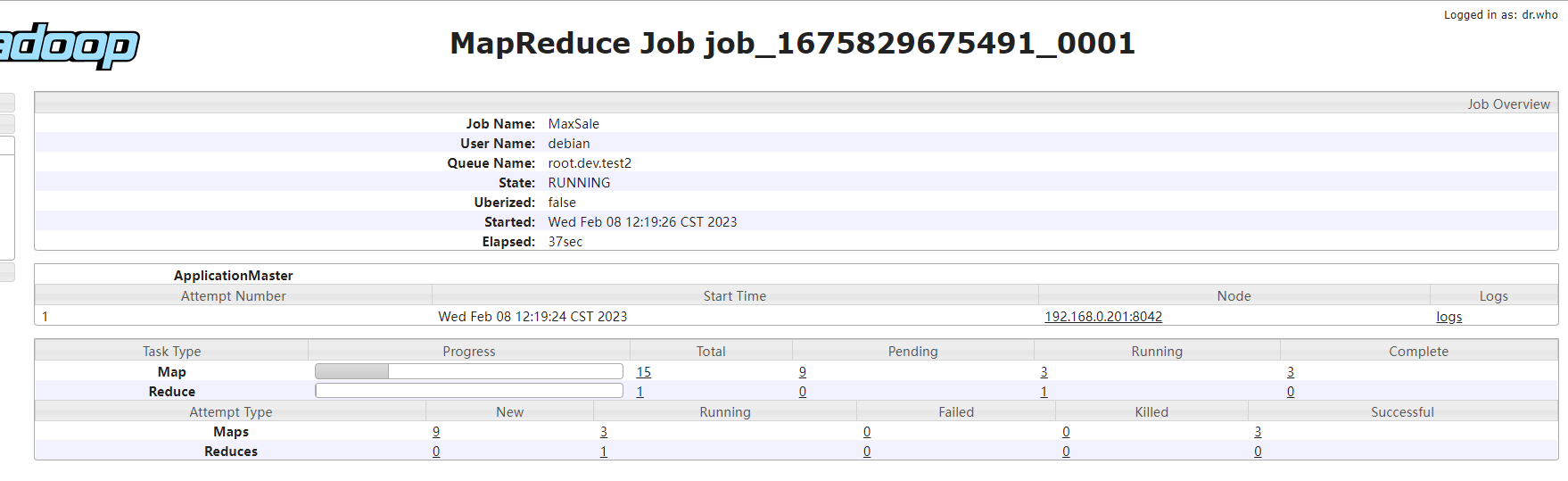

修改应用配置文件mapreduce.job.queuename为test1,再次运行maxSaleMapReduce应用,可以发现此时只会启动1个application master和1个YarnChild进程。

启动进程数量和集群资源相关,因为资源受限,可以发现此时应用执行时间明显偏长

队列状态:

任务信息:

3、公平调度器配置

还是刚才的队列层次结构:

root─┬─default

└─dev

└─test1

└─test2

首先要修改yarn-site.xml文件中的配置yarn.resourcemanager.scheduler.class为org.apache.hadoop.yarn.server.resourcemanager.scheduler.fair.FairScheduler

然后创建fair-scheduler.xml文件,内容如下:

更多配置可以参考 https://hadoop.apache.org/docs/r2.10.2/hadoop-yarn/hadoop-yarn-site/FairScheduler.html

<?xml version="1.0"?>

<allocations>

<!-- 队列内默认调度策略 -->

<defaultQueueSchedulingPolicy>fair</defaultQueueSchedulingPolicy>

<queue name="default">

<weight>70</weight>

<!-- 队列内调度策略,支持fifo,fair,drf -->

<schedulingPolicy>fifo</schedulingPolicy>

<!-- 允许提交的用户 -->

<aclSubmitApps>*</aclSubmitApps>

<!-- 允许管理的用户 -->

<aclAdministerApps>*</aclAdministerApps>

</queue>

<queue name="dev">

<weight>30</weight>

<!-- 允许提交的用户 -->

<aclSubmitApps>*</aclSubmitApps>

<!-- 允许管理的用户 -->

<aclAdministerApps>*</aclAdministerApps>

<queue name="test1">

<weight>50</weight>

</queue>

<queue name="test2">

<weight>50</weight>

</queue>

</queue>

<!-- 任务匹配队列规则 -->

<queuePlacementPolicy>

<rule name="specified" />

<rule name="default" queue="dev.test2" />

</queuePlacementPolicy>

</allocations>

defaultQueueSchedulingPolicy配置指定队列内默认调度模式,如果队列自身没有指定调度模式,则采用此配置的值。

queuePlacementPolicy配置包含一个规则,用于匹配应用放置在哪个队列。specified表示优先采用应用指定的队列,如果匹配失败则继续匹配下一条规则。如果所有规则都不匹配则命中default规则,应用会放置在test2队列中。

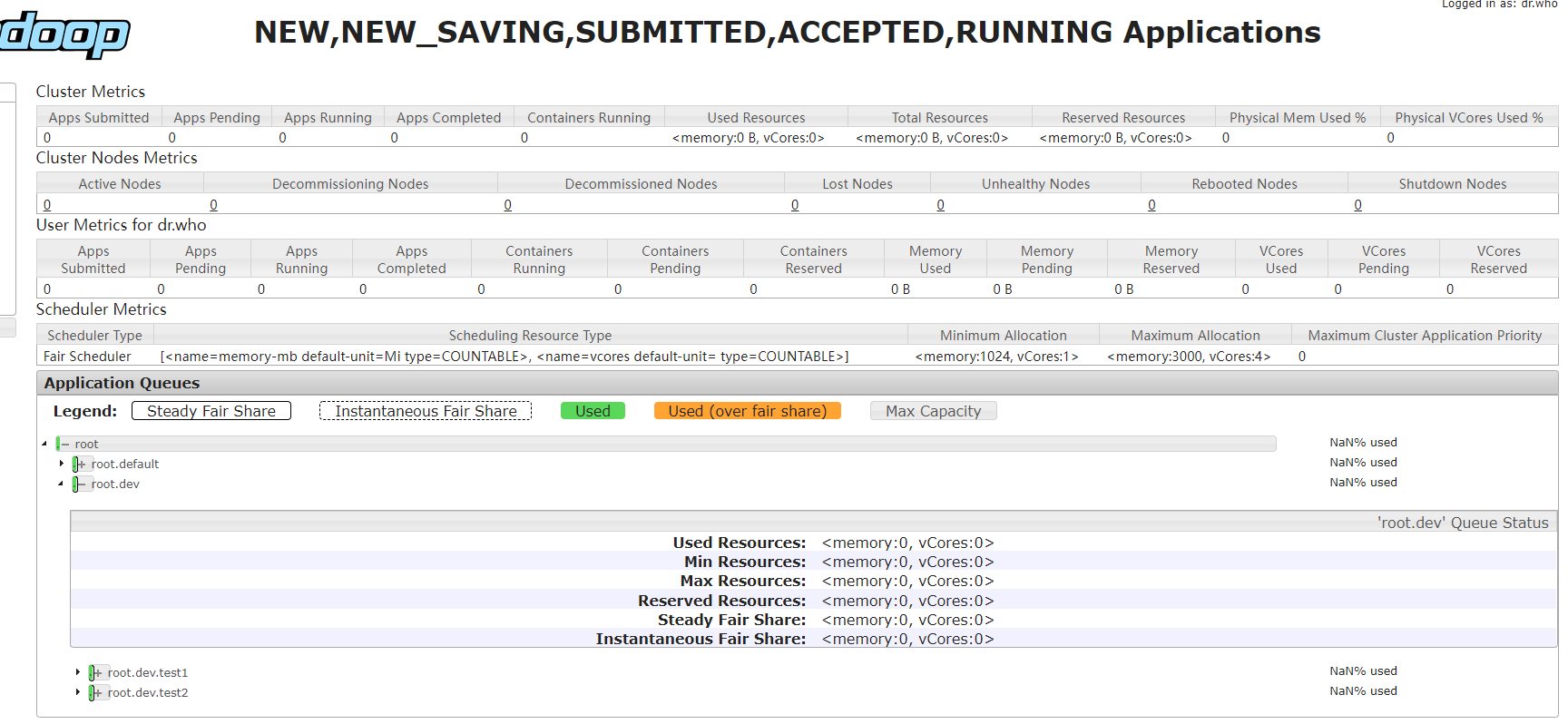

重启资源管理器,web服务显示信息如下:

不配置mapreduce.job.queuename参数启动应用,可以发现应用被调度到队列test2上:

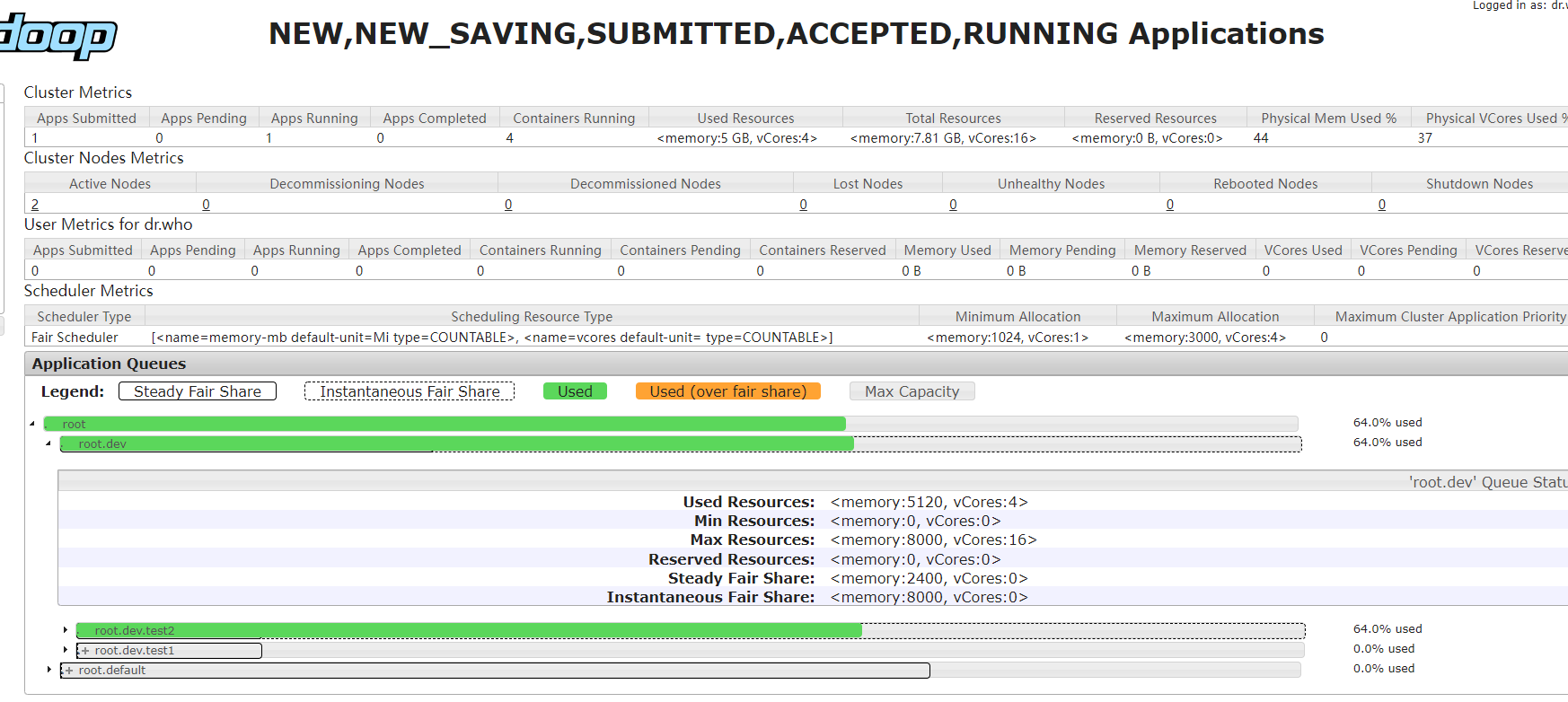

队列状态:

任务信息:

与容量调度器不同的是,test1虽然只设置了dev的一半的权重,但是实际使用了dev全部资源,而dev也超出了自身的30%的权重。这个是因为当前集群只有一个任务,所以这个任务可以独占集群所有资源。

如果一个集群非常繁忙,当任务被提交后,任务不会立即启动,任务会等待已经运行的任务释放资源才会启动。为了使任务从提交到执行的时间可预测,公平调度器支持“抢占”功能。

所谓抢占就是允许调度器主动终止超过权重的队列中运行的任务,释放的资源会被分配给低于应得权重的队列。但是因为任务被终止,所以被终止的任务会被重新执行,相当于降低了整个集群的运行效率。

通过设置yarn.scheduler.fair.preemption为true启动抢占功能,更详细的参数可以参考 https://hadoop.apache.org/docs/r2.10.2/hadoop-yarn/hadoop-yarn-site/FairScheduler.html 中的Configuration内容。

4、总结

YARN提供了三种调度器,分别是FIFO调度器(先进先出),容量调度器和公平调度器。FIFO调度器规则最为简单,任务可以独占所有资源以便更快的完成,但是如果出现大任务的情况会阻塞后续任务的执行。容量调度器通过队列来分割和保留集群资源,在一个繁忙的集群中可以为某些任务有效的保留可用资源,缺点是无法高效利用集群整体资源。公平调度器通过动态调度的模式调度资源,应用之间支持主动让出和抢占分配资源。

使用哪种模式要根据集群的业务场景来决定,不存在哪种调度模式更好或更差。

06yarn简介的更多相关文章

- ASP.NET Core 1.1 简介

ASP.NET Core 1.1 于2016年11月16日发布.这个版本包括许多伟大的新功能以及许多错误修复和一般的增强.这个版本包含了多个新的中间件组件.针对Windows的WebListener服 ...

- MVVM模式和在WPF中的实现(一)MVVM模式简介

MVVM模式解析和在WPF中的实现(一) MVVM模式简介 系列目录: MVVM模式解析和在WPF中的实现(一)MVVM模式简介 MVVM模式解析和在WPF中的实现(二)数据绑定 MVVM模式解析和在 ...

- Cassandra简介

在前面的一篇文章<图形数据库Neo4J简介>中,我们介绍了一种非常流行的图形数据库Neo4J的使用方法.而在本文中,我们将对另外一种类型的NoSQL数据库——Cassandra进行简单地介 ...

- REST简介

一说到REST,我想大家的第一反应就是“啊,就是那种前后台通信方式.”但是在要求详细讲述它所提出的各个约束,以及如何开始搭建REST服务时,却很少有人能够清晰地说出它到底是什么,需要遵守什么样的准则. ...

- Microservice架构模式简介

在2014年,Sam Newman,Martin Fowler在ThoughtWorks的一位同事,出版了一本新书<Building Microservices>.该书描述了如何按照Mic ...

- const,static,extern 简介

const,static,extern 简介 一.const与宏的区别: const简介:之前常用的字符串常量,一般是抽成宏,但是苹果不推荐我们抽成宏,推荐我们使用const常量. 执行时刻:宏是预编 ...

- HTTPS简介

一.简单总结 1.HTTPS概念总结 HTTPS 就是对HTTP进行了TLS或SSL加密. 应用层的HTTP协议通过传输层的TCP协议来传输,HTTPS 在 HTTP和 TCP中间加了一层TLS/SS ...

- 【Machine Learning】机器学习及其基础概念简介

机器学习及其基础概念简介 作者:白宁超 2016年12月23日21:24:51 摘要:随着机器学习和深度学习的热潮,各种图书层出不穷.然而多数是基础理论知识介绍,缺乏实现的深入理解.本系列文章是作者结 ...

- Cesium简介以及离线部署运行

Cesium简介 cesium是国外一个基于JavaScript编写的使用WebGL的地图引擎,一款开源3DGIS的js库.cesium支持3D,2D,2.5D形式的地图展示,可以自行绘制图形,高亮区 ...

- 1.Hibernate简介

1.框架简介: 定义:基于java语言开发的一套ORM框架: 优点:a.方便开发; b.大大减少代码量; c.性能稍高(不能与数据库高手相比,较一般数据库使用者 ...

随机推荐

- OS-HACKNOS-2.1靶机之解析

靶机名称 HACKNOS: OS-HACKNOS 靶机下载地址 https://download.vulnhub.com/hacknos/Os-hackNos-1.ova 实验环境 : kali 2. ...

- perl中ENV的使用

在打印环境变量的时候可以用到.实际上是%ENV,perl中的哈希变量,里面保存的是环境变量.键是环境变量名,值是环境变量值.例如,有一个环境变量是PATH,其值为C:\windows,那么,打印这个环 ...

- K8S之prometheus-operator监控

prometheus-operator 1. Prometheus Operator介绍 介绍文章:http://t.zoukankan.com/twobrother-p-11164391.html ...

- Jenkinsfile 同时检出多个 Git 仓库

前置 通常,在 Jenkinsfile 中使用 Git 仓库是这样的: stage('Checkout git repo') { steps { checkout([ $class: 'GitSCM' ...

- vim-瞬间移动打发

一,常用基本命令 set rnu 显示相对行号 1.ctrl+F 将屏幕向下滚动一屏 2.ctrl+u pageUp,ctrl+d pageDown 3.行内移动:W,b在单词间移动,ge向上跳,f ...

- 【iOS逆向】某营业厅算法分析

阅读此文档的过程中遇到任何问题,请关注公众号[移动端Android和iOS开发技术分享]或加QQ群[812546729] 1.目标 使用frida stalker分析某营业厅的签名算法. 2.操作环境 ...

- flex布局中,元素等间距设置,包括第一个元素的左边,最后一个元素的右边,也等间距

项目中很多地方会用到等间距排放的场景,使用flex 布局可以很方便的实现 .fu{ display: flex; ustify-content: space-between; } 通过上面代码,可以实 ...

- @responseBody 返回更多数据

@responseBody:注解的作用是将controller的方法返回的对象通过适当的转换器转换为指定的格式之后,写入到response对象的body区,通常用来返回JSON数据或者是XML数据,需 ...

- Asp.Net Core&Jaeger实现链路追踪

前言 随着应用愈发复杂,请求的链路也愈发复杂,微服务化下,更是使得不同的服务分布在不同的机器,地域,语言也不尽相同.因此需要借助工具帮助分析,跟踪,定位请求中出现的若干问题,以此来保障服务治理,链路追 ...

- 3.4:使用Weka实现KNN分类的算法示例

〇.概述 1.使用Weka平台,并在该平台使用数据导入.可视化等基本操作: 2.对KNN算法的不同k值进行比较,对比结果得出结论. 一.打开Weka3.8并导入数据 二.导入数据 三.KNN算法分类操 ...