使用Python批量爬取美女图片

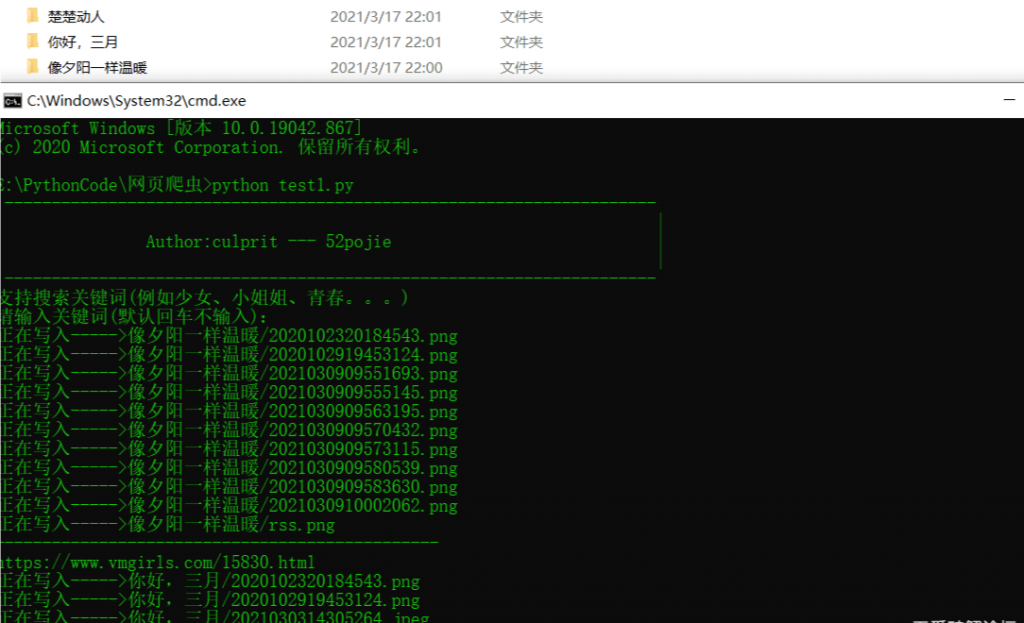

运行截图

实列代码:

from bs4 import BeautifulSoup

import requests,re,os

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/87.0.4280.88 Safari/537.36'

}

def Get_Url(url):

response = requests.get(url, headers=headers).text

soup = BeautifulSoup(response,'html.parser')

for data in soup.find_all('a',class_='list-title text-md h-2x'):

url_data = data.get('href')

urls = "https://www.vmgirls.com/" + str(url_data)

Down_Image(urls)

print('-----------------------------------------------')

print(urls)

def Down_Image(url):

response = requests.get(url, headers=headers).text

soup = BeautifulSoup(response, 'html.parser')

image_url = soup.find_all('img')

for data in image_url:

image_type = data.get('src').split('.')[-1]

if image_type == 'jpg' or image_type == 'jpeg' or image_type == 'png':

url_data = data.get('src')

# print(url_data)

dir_name = soup.find(class_='post-title h1').string

if not os.path.exists(dir_name):

os.mkdir(dir_name)

# print(dir_name)

image = requests.get("https:" + str(url_data), headers=headers).content

file_name = url_data.split('/')[-1]

# print(file_name)

with open(dir_name + '/' + file_name, 'wb') as f:

f.write(image)

print('正在写入----->' + dir_name + '/' + file_name)

if __name__ == '__main__':

print(' ---------------------------------------------------------------------')

print('| |')

print('| Author:culprit --- iamdd |')

print('| |')

print(' ---------------------------------------------------------------------')

print('支持搜索关键词(例如少女、小姐姐、青春。。。)')

key = input('请输入关键词(默认回车不输入):')

if key == '':

url = "https://www.vmgirls.com/"

else:

url = "https://www.vmgirls.com/?s=" + key

Get_Url(url)使用Python批量爬取美女图片的更多相关文章

- Scrapy爬取美女图片 (原创)

有半个月没有更新了,最近确实有点忙.先是华为的比赛,接着实验室又有项目,然后又学习了一些新的知识,所以没有更新文章.为了表达我的歉意,我给大家来一波福利... 今天咱们说的是爬虫框架.之前我使用pyt ...

- Scrapy爬取美女图片第三集 代理ip(上) (原创)

首先说一声,让大家久等了.本来打算那天进行更新的,可是一细想,也只有我这样的单身狗还在做科研,大家可能没心思看更新的文章,所以就拖到了今天.不过忙了521,522这一天半,我把数据库也添加进来了,修复 ...

- Scrapy爬取美女图片第四集 突破反爬虫(上)

本周又和大家见面了,首先说一下我最近正在做和将要做的一些事情.(我的新书<Python爬虫开发与项目实战>出版了,大家可以看一下样章) 技术方面的事情:本次端午假期没有休息,正在使用fl ...

- Scrapy爬取美女图片续集 (原创)

上一篇咱们讲解了Scrapy的工作机制和如何使用Scrapy爬取美女图片,而今天接着讲解Scrapy爬取美女图片,不过采取了不同的方式和代码实现,对Scrapy的功能进行更深入的运用.(我的新书< ...

- python 3 爬取百度图片

python 3 爬取百度图片 学习了:https://blog.csdn.net/X_JS612/article/details/78149627

- Python:爬取网站图片并保存至本地

Python:爬取网页图片并保存至本地 python3爬取网页中的图片到本地的过程如下: 1.爬取网页 2.获取图片地址 3.爬取图片内容并保存到本地 实例:爬取百度贴吧首页图片. 代码如下: imp ...

- android高仿抖音、点餐界面、天气项目、自定义view指示、爬取美女图片等源码

Android精选源码 一个爬取美女图片的app Android高仿抖音 android一个可以上拉下滑的Ui效果 android用shape方式实现样式源码 一款Android上的新浪微博第三方轻量 ...

- python爬虫-爬取百度图片

python爬虫-爬取百度图片(转) #!/usr/bin/python# coding=utf-8# 作者 :Y0010026# 创建时间 :2018/12/16 16:16# 文件 :spider ...

- 从0实现python批量爬取p站插画

一.本文编写缘由 很久没有写过爬虫,已经忘得差不多了.以爬取p站图片为着手点,进行爬虫复习与实践. 欢迎学习Python的小伙伴可以加我扣群86七06七945,大家一起学习讨论 二.获取网页源码 爬取 ...

随机推荐

- 快速 IO

IO 的进化史 cin和cout 刚开始学的时候,老师叫我们用 cin 和 cout 大概是因为这最简单吧 cin>>x; cout<<x scanf和printf 学到函数了 ...

- Spire.Office激活

更新记录: 2022年5月28日 初始代码便于复用 注意:最多支持到:E-ICEBLUE Spire.Office Platinum v6.10.3 引入命名空间: using Spire.Licen ...

- jenkins自动触发构建

1. 安装jenkins cat /etc/yum.repos.d/jenkins.repo [jenkins] name=Jenkins baseurl=http://pkg.jenkins.io/ ...

- cookie 案例 记住上一次的访问时间

需求:记住上一次的访问时间 第一次访问Servlet 提示 欢迎首次访问 之后的访问 都提示 您上次的访问时间为:"""""""& ...

- 一个bug肝一周...忍不住提了issue

导航 Socket.IO是什么 Socket.IO的应用场景 为什么选socket.io-client-java 实战案例 参考 本文首发于智客工坊-<socket.io客户端向webserve ...

- mysql中innodb和myisam区别

前言 InnoDB和MyISAM是很多人在使用MySQL时最常用的两个表类型,这两个表类型各有优劣,5.7之后就不一样了. 1.事务和外键 ● InnoDB具有事务,支持4个事务隔离级别,回滚,崩溃修 ...

- Elasticsearch面试题

Elasticsearch面试题 1.Elasticsearch是如何实现master选举的? 1.对所有可以成为master的节点根据nodeId排序,每次选举每个节点都把自己所知道节点排一次序,然 ...

- 4种Kafka网络中断和网络分区场景分析

摘要:本文主要带来4种Kafka网络中断和网络分区场景分析. 本文分享自华为云社区<Kafka网络中断和网络分区场景分析>,作者: 中间件小哥. 以Kafka 2.7.1版本为例,依赖zk ...

- (数据科学学习手札140)详解geopandas中基于pyogrio的矢量读写引擎

本文示例代码已上传至我的Github仓库https://github.com/CNFeffery/DataScienceStudyNotes 1 简介 大家好我是费老师,前不久我在一篇文章中给大家分享 ...

- spring boot 打包为war包方法

刚刚接触spring boot,其快速开发的特性吸引我去研究一下.于是我写了个demo,用spring boot内置的tomcat运行的很好,但是我需要把它部署到外部的tomcat中,于是从网上查找资 ...