【图文教程】Centos 7下安装Hadoop

环境说明:

系统:Centos7 在VM中安装的

hadoop版本:2.7.7

JDK:1.8

注意:Hadoop需要Java环境的。记得安装Java环境

PS:Centos JDK安装

mkdir /data

1:上传jdk的tar.解压

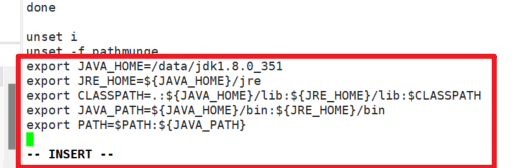

2:修改/etc/proflie,把Javahome环境变量配置上:

记住:在修改前,先备份

在文件最后添加:

export JAVA_HOME=/data/jdk1.8.0_351

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib:$CLASSPATH

export JAVA_PATH=${JAVA_HOME}/bin:${JRE_HOME}/bin

export PATH=$PATH:${JAVA_PATH}

说明:/data/jdk1.8.0_351 修改成你自己的

如下图:

添加完成后,使用 source /etc/profile 使其生效。

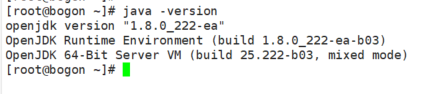

查看Java版本:

开始安装:

一:下载安装包:

1.1: 安装包下载地址 https://repo.huaweicloud.com/apache/hadoop/common/hadoop-2.7.7/hadoop-2.7.7.tar.gz

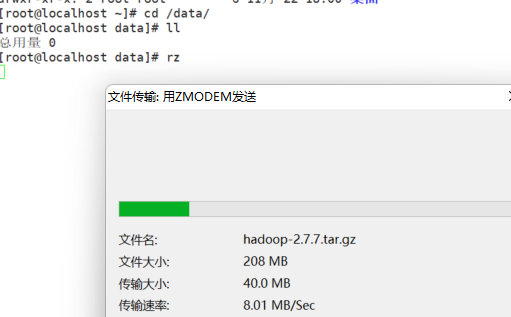

1.2:上传并解压

mkdir /data

在Xshell中可以使用rz命令进行上传

解压:

cd /data

tar -zxvf hadoop-2.7.7.tar.gz

二:hadoop配置

声明:下文中踢掉的,hadoop的安装目录:

比如凯哥的安装目录,就是第一步上传到/data后解压的。所以hadoop安装目录就是:/data/hadoop-2.7.7 这个别搞错了

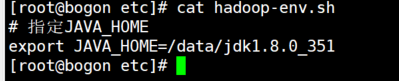

2.1:修改hadoop安装目录 /etc/hadoop 下的 hadoop-env.sh的内容

cd /data/hadoop-2.7.7/etc/hadoop/

注意:是hadoop的安装目录:

比如凯哥的安装目录,就是第一步上传到/data后解压的。所以hadoop安装目录就是:/data/hadoop-2.7.7 这个别搞错了

vi hadoop-env.sh

输入Javahome的配置

# 指定JAVA_HOME

export JAVA_HOME=/data/jdk1.8.0_351

2.2:修改hadoop安装目录 /etc/hadoop 下的

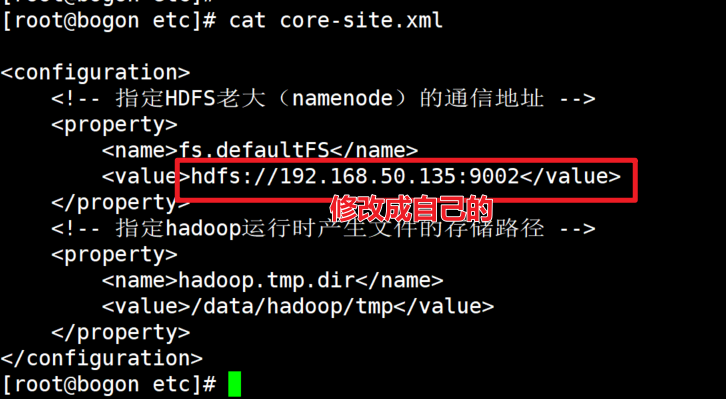

vi core-site.xml

输入下面:

主要:<configuration> 这个标签。后面第3步和第4步,同样需要注意。

<configuration>

<!-- 指定HDFS老大(namenode)的通信地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://192.168.50.135:9002</value>

</property>

<!-- 指定hadoop运行时产生文件的存储路径 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/data/hadoop/tmp</value>

</property>

</configuration>

需要主要,将hdfs的ip修改成你自己物理机的ip.

我们发现,在配置hadoop运行时候文件存储路径为/data/hadoop 如果没有这个目录,需要创建

注:这里fs.defaultFS的value最好是写本机的静态IP。当然写本机主机名,再配置hosts是最好的,如果用localhost,然后在windows用java操作hdfs的时候,会连接不上主机。

2.3:修改 hadoop安装目录/etc/hadoop下的hdf-site.xml的内容

vi hdfs-site.xml

输入:

<configuration>

<property>

<name>dfs.namenode.name.dir</name>

<value>/data/hadoop/hadoop/hdfs/nn</value>

</property>

<property>

<name>fs.checkpoint.dir</name>

<value>/data/hadoop/hdfs/snn</value>

</property>

<property>

<name>fs.checkpoint.edits.dir</name>

<value>/data/hadoop/hdfs/snn</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/data/hadoop/hdfs/dn</value>

</property>

<property>

<name>dfs.name.dir</name>

<value>/data/hadoop/name</value>

</property>

<property>

<name>dfs.data.dir</name>

<value>/data/hadoop/node</value>

</property>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.http.address</name>

<value>192.168.50.135:9000</value>

</property>

<property>

<name>ipc.maximum.data.length</name>

<value>134217728</value>

</property>

</configuration>

同样需要注意的是将ip修改成自己服务器的真实ip

2.4:修改 hadoop安装目录下的/etc/hadoop 下的yarn-site.xml

<configuration>

<!-- Site specific YARN configuration properties -->

<property>

<name>yarn.nodemanager.vmem-check-enabled</name>

<value>false</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.application.classpath</name>

<value>

/data/hadoop-2.7.7/etc/*,

/data/hadoop-2.7.7/etc/hadoop/*,

/data/hadoop-2.7.7/lib/*,

/data/hadoop-2.7.7/share/hadoop/common/*,

/data/hadoop-2.7.7/share/hadoop/common/lib/*,

/data/hadoop-2.7.7/share/hadoop/mapreduce/*,

/data/hadoop-2.7.7/share/hadoop/mapreduce/lib/*,

/data/hadoop-2.7.7/share/hadoop/hdfs/*,

/data/hadoop-2.7.7/share/hadoop/hdfs/lib/*,

/data/hadoop-2.7.7/share/hadoop/yarn/*,

/data/hadoop-2.7.7/share/hadoop/yarn/lib/*

</value>

</property>

</configuration>

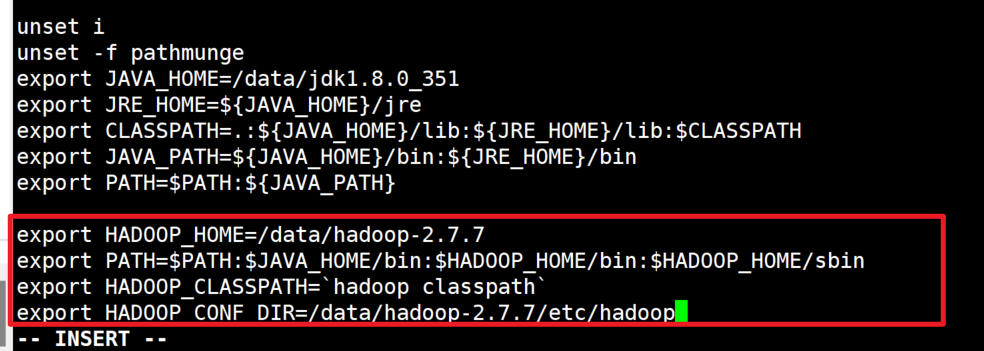

三:将Hadoop配置到环境变量中:

在 /etc/profile中配置

export HADOOP_HOME=/data/hadoop-2.7.7

export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

export HADOOP_CLASSPATH=`hadoop classpath`

export HADOOP_CONF_DIR=/data/hadoop-2.7.7/etc/hadoop

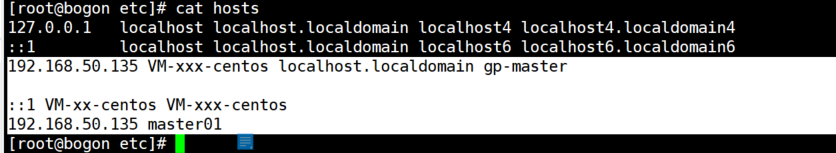

4:配置hosts

可能会用到。如下错误时候修改:

修改hosts:

在/etc/hosts。同样需要注意,修改前,记得备份下。

192.168.50.135 VM-xxx-centos localhost.localdomain gp-master

::1 VM-xx-centos VM-xxx-centos

192.168.50.135 master01

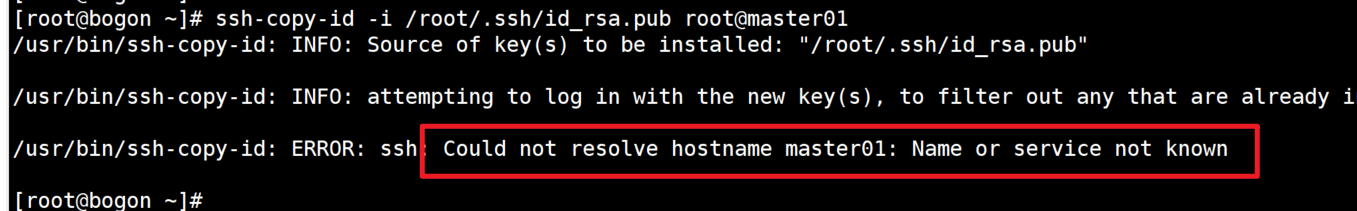

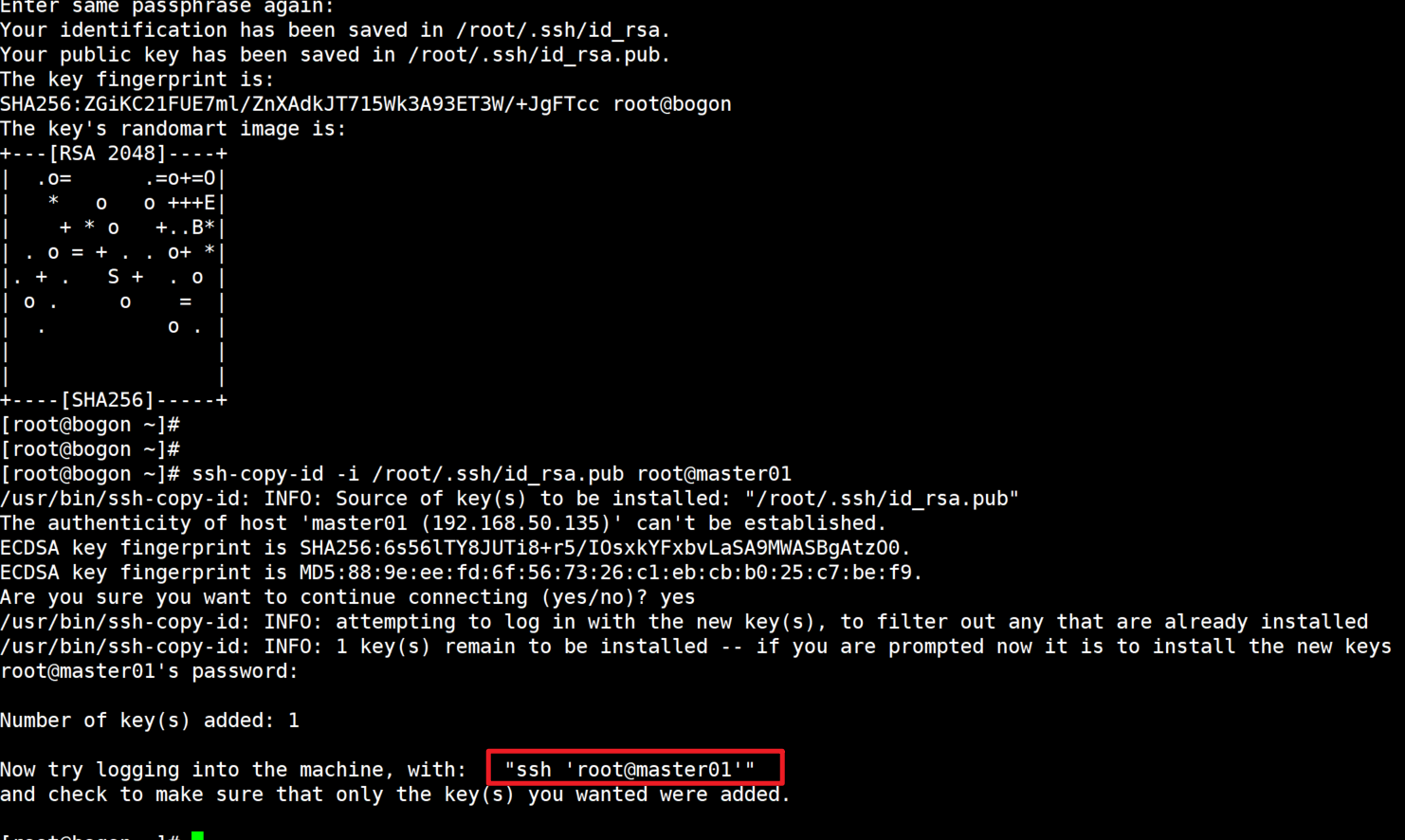

5:制作证书,免登陆配置

切换到root下

cd /root

接着:

#执行生成密钥命令:

ssh-keygen -t rsa

#然后三个回车

继续:

ssh-copy-id -i /root/.ssh/id_rsa.pub root@master01

选择yes

输入登录第一台节点的密码(操作完成该节点公钥复制到第一台节点中)

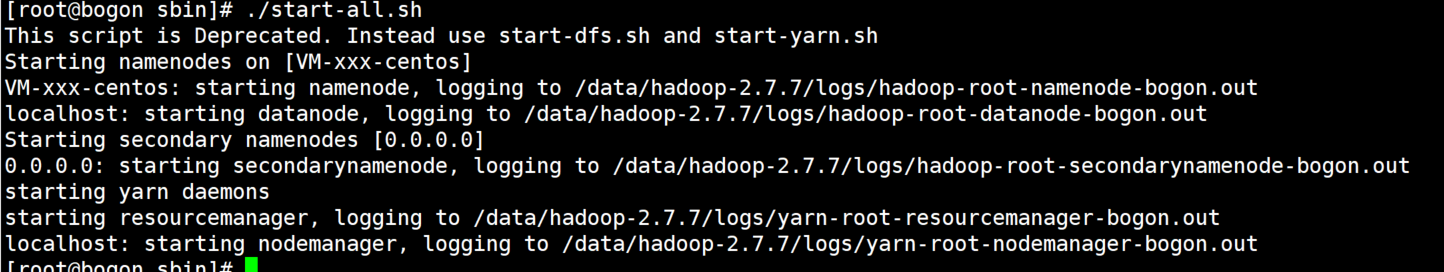

6:启动

进入到hadoop安装目录/sbin下,执行start-all.sh命令

./start-all.sh

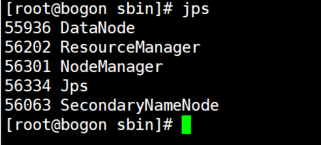

使用jps命令验证是否已经启动成功(这些都启动了才算成功:ResourceManager、DataNode、SecondaryNameNode、NodeManager、TaskManagerRunner、YarnTaskExecutorRunner、NameNode):

jps

【图文教程】Centos 7下安装Hadoop的更多相关文章

- CentOS下安装hadoop

CentOS下安装hadoop 用户配置 添加用户 adduser hadoop passwd hadoop 权限配置 chmod u+w /etc/sudoers vi /etc/sudoers 在 ...

- CentOS 7 下安装 LEMP 服务(nginx、MariaDB/MySQL 和 php)

原文 CentOS 7 下安装 LEMP 服务(nginx.MariaDB/MySQL 和 php) LEMP 组合包是一款日益流行的网站服务组合软件包,在许多生产环境中的核心网站服务上起着强有力的作 ...

- CentOS linux下安装和配置Apache+SVN(用浏览器http方式访问SVN目录)

在CentOS linux下安装SVN,我们可以进行以下步骤: 第一步:安装CentOS Linux操作系统,并在CentOS安装进行的同时,自定义安装这一步,一定要勾选Subversion(在“开发 ...

- CentOS 6 下安装Python 3

可以下载各个版本的python:https://www.python.org/ftp/python/ 配置安装 下载最新的安装包(截止2013/11/05),还是3.3.2版本. #wget http ...

- [Android Studio 权威教程]Windows下安装Android Studio

从AS 0.5版本号開始使用.也是AS的推行者,在ApkBus公布的第一篇Android Studio Perview 2 获得了50K的浏览,1800多条回复下载. 在我的[Android Stud ...

- Linux(CentOS)系统下安装好apache(httpd)服务后,其他电脑无法访问的原因

原文:Linux(CentOS)系统下安装好apache(httpd)服务后,其他电脑无法访问的原因 今天试了下在虚拟机上利用CentOS系统的yum命令安装好了httpd(apache2.4.6), ...

- CentOS 7下安装vertica记录

CentOS 7下安装vertica记录 1. 安装好centeros 并更新 Centeros安装就不说了,安装完之后联网环境下 yum update.更新下,使得那些包都是新的.(要想用中文 ...

- CentOS系统下安装python3+Django

转载:CentOS系统下安装python3+Django 1.首先用yum安装下vim,因为CentOS 7可能根本没自带完整vim,经常出现输入乱码:yum -y install vim 2.安装开 ...

- CentOS 7下安装Python3.6

CentOS 7下安装Python3.6.4 CentOS 7下安装Python3.5 •安装python3.6可能使用的依赖 yum install openssl-devel bzip2-de ...

- CentOS 7下安装Python3.6.4

CentOS 7下安装Python3.5 •安装python3.6可能使用的依赖 yum install openssl-devel bzip2-devel expat-devel gdbm-deve ...

随机推荐

- TOPSIS模型原理以及代码实现

TOPSIS 法是一种常用的组内综合评价方法,能充分利用原始数据的信息,其结果能精确地反映各评价方案之间的差距.下面我们来介绍具体步骤与代码实现 目录 问题提出 第一步:数据输入 1.如何从excel ...

- 在Winform程序中增加隐藏的按键处理,用于处理一些特殊的界面显示或者系统初始化操作

以前,我看到一个朋友在对一个系统做初始化的时候,通过一组魔幻般的按键,调出来一个隐藏的系统设置界面,这个界面在常规的菜单或者工具栏是看不到的,因为它是一个后台设置的关键界面,不公开,同时避免常规用户的 ...

- 解决方案 | winrar 使用命令行解压到同名文件夹 (QTTabBar 中创建一个【解压文件】命令按钮的设置)

需求:我们经常需要把rar或者zip解压到当前文件夹,如果是直接解压的话可能会解压出来很多文件,事实上我们当然可以通过右键解压到这个指定文件夹. 但是 经过查询知道,如果是指定文件夹好说,直接指定.\ ...

- 深度解读昇腾CANN模型下沉技术,提升模型调度性能

本文分享自华为云社区<深度解读昇腾CANN模型下沉技术,提升模型调度性能>,作者:昇腾CANN. AI模型的运行通常情况下需要CPU和NPU(昇腾AI处理器)等AI专用处理器协同工作,CP ...

- Modbus转Profinet网关模块连PLC与流量计通讯案例

一.案例背景 在饮品加工厂中,会涉及到流量计的使用,然而达到对流量计的精准控制和数据采集需要用到PLC,由于PLC和流量计可能使用不同的通信协议(如Profinet和Modbus),造成两者不能自接进 ...

- oeasy教您玩转linux 010211 牛说 cowsay

我们来回顾一下 上一部分我们都讲了什么? 软件包工具是 apt 软件包不但能下载,也能升级,还能删除 专门管理软件包的 aptitude 这次我们下载个牛说 cowsay: sudo apt inst ...

- [oeasy]python0010 - python虚拟机解释执行py文件的原理

解释运行程序 回忆上次内容 我们这次设置了断点 设置断点的目的是更快地调试 调试的目的是去除bug 别害怕bug 一步步地总能找到bug 这就是程序员基本功 调试deb ...

- 周末玩一下云技术,kvm 相关笔记

由于需要将企业的很贵的显卡和主机装在一个虚拟主机,用来跑 ue5 和 sd3 用来给用户临时使用,但是怎么将主机虚拟出来成多个主机呢,自己没有有钱请不起人,只能自己学一下虚拟化技术,第一步主机开启 ...

- Redis持久化RDB与AOF介绍

就是将内存中的数据通过rdb/aof进行持久化写入硬盘中 rdb就是进行持久化的快照 在指定的时间间隔内,执行数据集的时间点快照.这个快照文件称为(dump.rdb)RDB文件,Redis DataB ...

- 备份服务器eBackup

目录 软件包方式安装eBackup备份软件 1.前景提要 2.创建虚拟机 3.安装备份软件. 4.安装 eBackup 补丁 5.配置 eBackup 服务器 6.访问web界 ...