从RDD创建DataFrame

0.前次作业:从文件创建DataFrame

1.pandas df 与 spark df的相互转换 df_s=spark.createDataFrame(df_p) df_p=df_s.toPandas()

# 从数组创建pandas dataframe

import pandas as pd

import numpy as np

arr = np.arange(6).reshape(-1,3)

arr

df_p = pd.DataFrame(arr)

df_p

df_p.columns = ['a','b','c']

df_p

# pandas df 转为spark df

df_s = spark.createDataFrame(df_p)

df_s.show()

df_s.collect()

# spark df 转为pandas df

df_s.show()

df_s.toPandas()

2. Spark与Pandas中DataFrame对比

http://www.lining0806.com/spark%E4%B8%8Epandas%E4%B8%ADdataframe%E5%AF%B9%E6%AF%94/

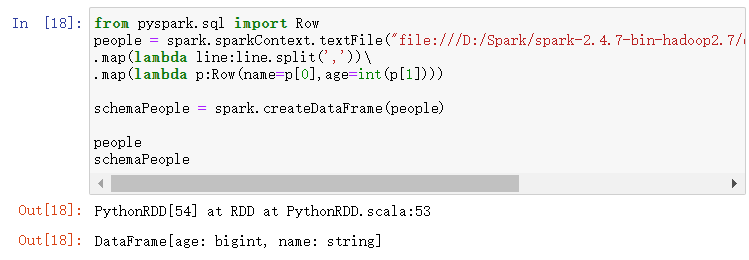

3.1 利用反射机制推断RDD模式

- sc创建RDD

spark.sparkContext.textFile("file:///D:/Spark/spark-2.4.7-bin-hadoop2.7/examples/src/main/resources/people.txt").first()

spark.sparkContext.textFile("file:///D:/Spark/spark-2.4.7-bin-hadoop2.7/examples/src/main/resources/people.txt")\

.map(lambda line:line.split(',')).first()

- 转换成Row元素,列名=值

from pyspark.sql import Row

people = spark.sparkContext.textFile("file:///D:/Spark/spark-2.4.7-bin-hadoop2.7/examples/src/main/resources/people.txt")\

.map(lambda line:line.split(','))\

.map(lambda p:Row(name=p[0],age=int(p[1])))

- spark.createDataFrame生成df

schemaPeople = spark.createDataFrame(people)

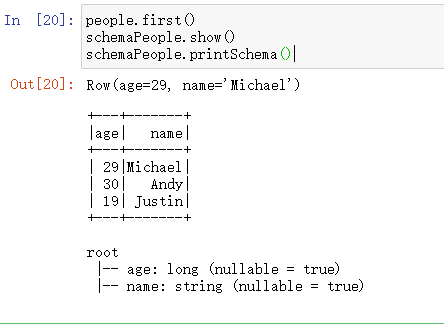

- df.show(), df.printSchema()

schemaPeople.show()

schemaPeople.printSchema()

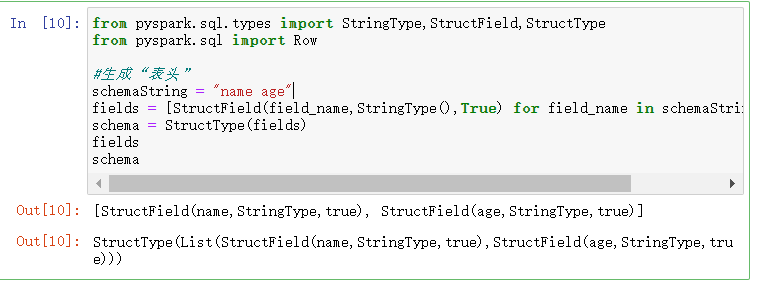

3.2 使用编程方式定义RDD模式

- 生成“表头”

- fields = [StructField(field_name, StringType(), True) ,...]

- schema = StructType(fields)

from pyspark.sql.types import StringType,StructField,StructType

from pyspark.sql import Row #生成“表头”

schemaString = "name age"

fields = [StructField(field_name,StringType(),True) for field_name in schemaString.split(" ")]

schema = StructType(fields)

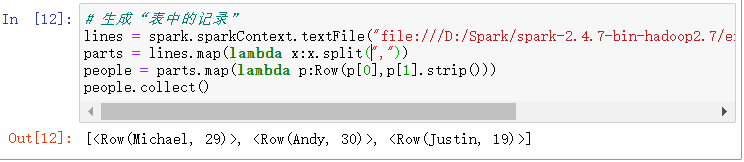

- 生成“表中的记录”

- 创建RDD

- 转换成Row元素,列名=值

# 生成“表中的记录”

lines = spark.sparkContext.textFile("file:///D:/Spark/spark-2.4.7-bin-hadoop2.7/examples/src/main/resources/people.txt")

parts = lines.map(lambda x:x.split(","))

people = parts.map(lambda p:Row(p[0],p[1].strip()))

people.collect()

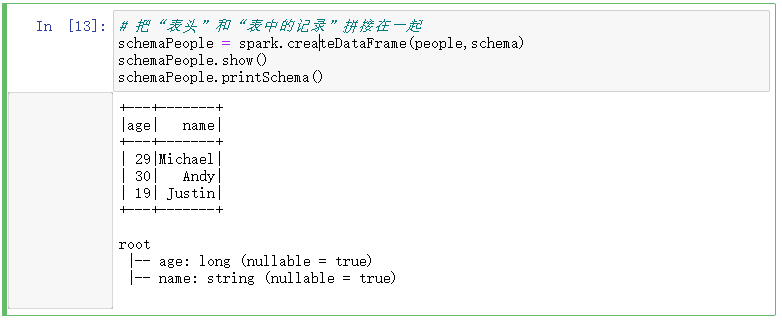

- 把“表头”和“表中的记录”拼装在一起

- = spark.createDataFrame(RDD, schema)

# 把“表头”和“表中的记录”拼接在一起

schemaPeople = spark.createDataFrame(people,schema)

schemaPeople.show()

schemaPeople.printSchema()

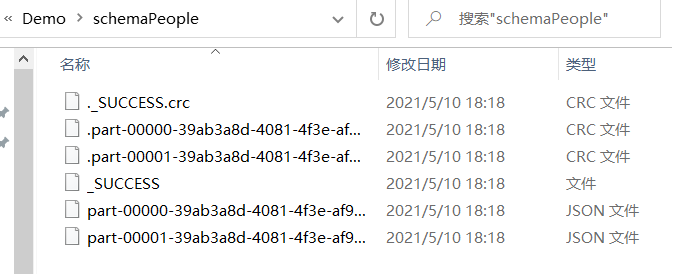

4. DataFrame保存为文件

df.write.json(dir)

schemaPeople.write.json("file:///D:/Demo/schemaPeople")

预练习:

读 学生课程分数文件chapter4-data01.txt,创建DataFrame。并尝试用DataFrame的操作完成实验三的数据分析要求。

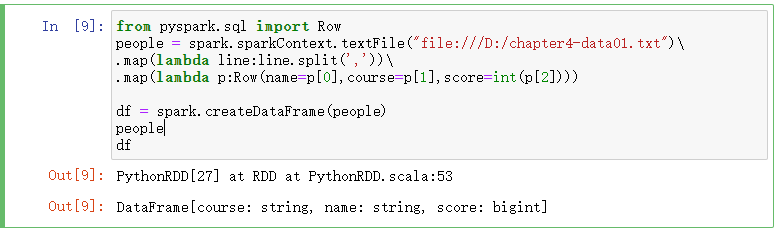

1.利用反射机制推断RDD模式

from pyspark.sql import Row

people = spark.sparkContext.textFile("file:///D:/chapter4-data01.txt")\

.map(lambda line:line.split(','))\

.map(lambda p:Row(name=p[0],course=p[1],score=int(p[2]))) df = spark.createDataFrame(people)

people

df

people.first()

df.show()

df.printSchema()

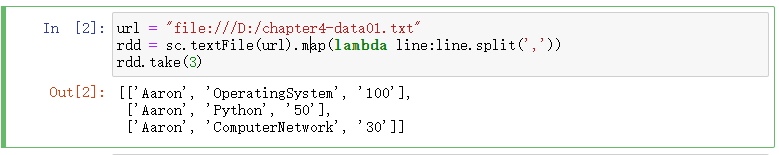

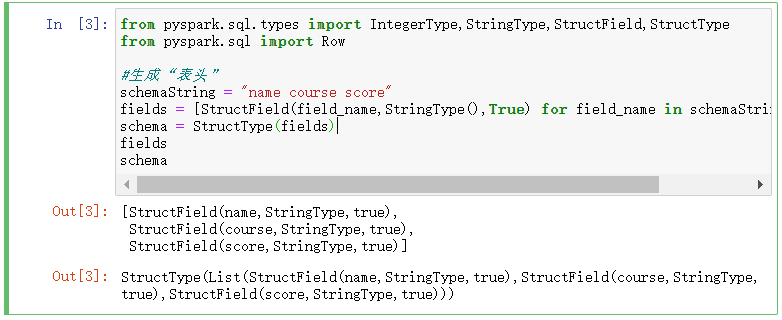

2.使用编程方式定义RDD模式

url = "file:///D:/chapter4-data01.txt"

rdd = sc.textFile(url).map(lambda line:line.split(','))

rdd.take(3)

from pyspark.sql.types import IntegerType,StringType,StructField,StructType

from pyspark.sql import Row #生成“表头”

schemaString = "name course score"

fields = [StructField(field_name,StringType(),True) for field_name in schemaString.split(" ")]

schema = StructType(fields)

fields

schema

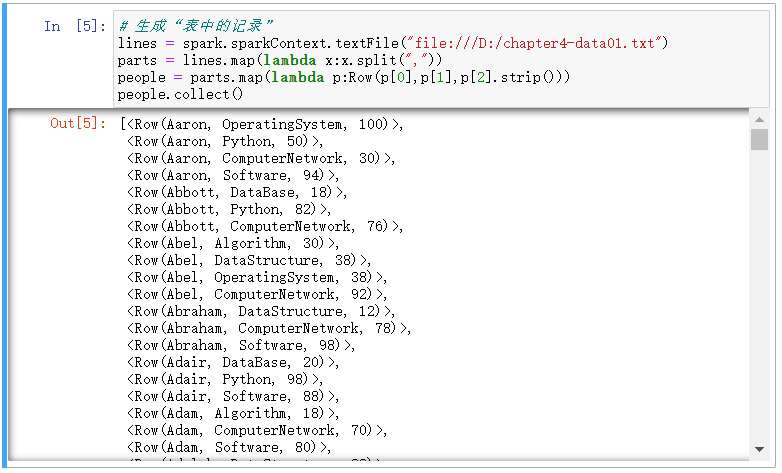

# 生成“表中的记录”

lines = spark.sparkContext.textFile("file:///D:/chapter4-data01.txt")

parts = lines.map(lambda x:x.split(","))

people = parts.map(lambda p:Row(p[0],p[1],p[2].strip()))

people.collect()

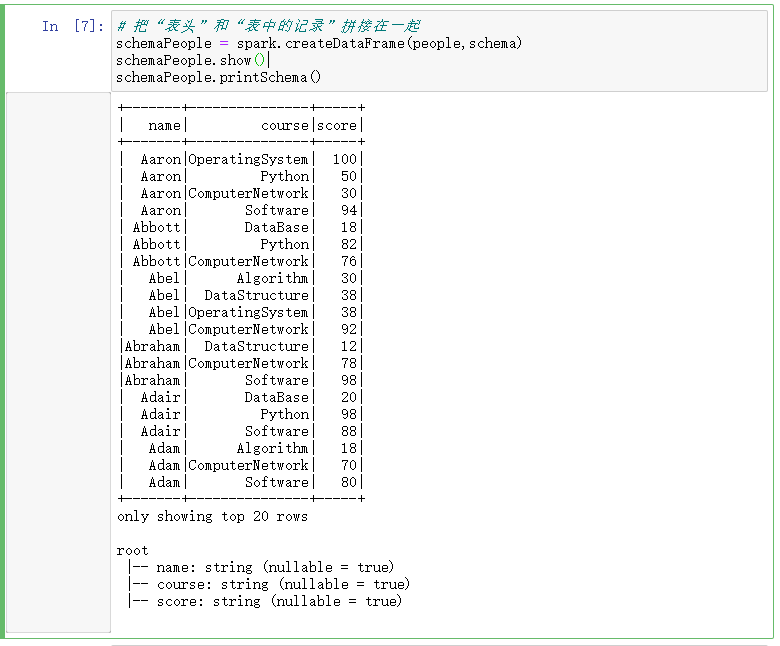

# 把“表头”和“表中的记录”拼接在一起

schemaPeople = spark.createDataFrame(people,schema)

schemaPeople.show()

schemaPeople.printSchema()

从RDD创建DataFrame的更多相关文章

- 07 从RDD创建DataFrame

1.pandas df 与 spark df的相互转换 df_s=spark.createDataFrame(df_p) df_p=df_s.toPandas() 2. Spark与Pandas中Da ...

- 【Spark篇】---SparkSQL初始和创建DataFrame的几种方式

一.前述 1.SparkSQL介绍 Hive是Shark的前身,Shark是SparkSQL的前身,SparkSQL产生的根本原因是其完全脱离了Hive的限制. SparkSQL支持查询原 ...

- Spark SQL初始化和创建DataFrame的几种方式

一.前述 1.SparkSQL介绍 Hive是Shark的前身,Shark是SparkSQL的前身,SparkSQL产生的根本原因是其完全脱离了Hive的限制. SparkSQL支持查询原 ...

- JAVA SparkSQL初始和创建DataFrame的几种方式

建议参考SparkSQL官方文档:http://spark.apache.org/docs/latest/sql-programming-guide.html 一.前述 1.SparkSQ ...

- 大数据学习day25------spark08-----1. 读取数据库的形式创建DataFrame 2. Parquet格式的数据源 3. Orc格式的数据源 4.spark_sql整合hive 5.在IDEA中编写spark程序(用来操作hive) 6. SQL风格和DSL风格以及RDD的形式计算连续登陆三天的用户

1. 读取数据库的形式创建DataFrame DataFrameFromJDBC object DataFrameFromJDBC { def main(args: Array[String]): U ...

- RDD、DataFrame和DataSet的区别

原文链接:http://www.jianshu.com/p/c0181667daa0 RDD.DataFrame和DataSet是容易产生混淆的概念,必须对其相互之间对比,才可以知道其中异同. RDD ...

- RDD与DataFrame的转换

RDD与DataFrame转换1. 通过反射的方式来推断RDD元素中的元数据.因为RDD本身一条数据本身是没有元数据的,例如Person,而Person有name,id等,而record是不知道这些的 ...

- 谈谈RDD、DataFrame、Dataset的区别和各自的优势

在spark中,RDD.DataFrame.Dataset是最常用的数据类型,本博文给出笔者在使用的过程中体会到的区别和各自的优势 共性: 1.RDD.DataFrame.Dataset全都是spar ...

- spark RDD,DataFrame,DataSet 介绍

弹性分布式数据集(Resilient Distributed Dataset,RDD) RDD是Spark一开始就提供的主要API,从根本上来说,一个RDD就是你的数据的一个不可变的分布式元素集合,在 ...

- Spark提高篇——RDD/DataSet/DataFrame(二)

该部分分为两篇,分别介绍RDD与Dataset/DataFrame: 一.RDD 二.DataSet/DataFrame 该篇主要介绍DataSet与DataFrame. 一.生成DataFrame ...

随机推荐

- Kafka存储内幕详解

1.概述 随着微服务和分布式计算的出现,Kafka已经成为各种主流平台系统架构中不可缺少的组成部分了.在本篇文章中,笔者将尝试为大家来解密Kafka的内部存储机制是如何运作的. 2.内容 在分布式系统 ...

- 电商平台趋势妙手采集类API接口

电商平台趋势,平台化.大家可以看到大的电商都开始有自己的平台,其实这个道理很清楚,就是因为这是充分利用自己的流量.自己的商品和服务大效益化的一个过程,因为有平台,可以利用全社会的资源弥补自己商品的丰富 ...

- String API(全)

类型 名称 char charAt(int index)返回 char指定索引处的值. int codePointAt(int index)返回指定索引处的字符(Unicode代码点). int co ...

- 从APNIC获取中国IP地址列表

关于APNIC 全球IP地址块被IANA(Internet Assigned Numbers Authority)分配给全球三大地区性IP地址分配机构,它们分别是: ARIN (American Re ...

- LLaMA:开放和高效的基础语言模型

LLaMA:开放和高效的基础语言模型 论文:https://arxiv.org/pdf/2302.13971.pdf 代码:https://github.com/facebookresearch/ll ...

- [Windows/Linux]Linux下的正斜杠"/"和"\"的区别 [转载]

执行某一条Linux命令时,遇到了此问题,甚为不解.[文由] 本篇属于全文转载自: Linux下的正斜杠"/"和""的区别 - 博客园 >>> ...

- python过滤列表元素

li = [1, 2, 3, 4, 5, 6] def fun(item, num): if item == num: return 1 else: return 0 def fun1(item, n ...

- PHP利用 JSON 将XML转换为数组

在很多开发项目中,我们都会遇到将XML文件转换为数组使用,因此在本篇 PHP教程 中,UncleToo和大家一起学习 如何转换XML为数组 . 现在有一个uncletoo.xml的配置文件,格式如下: ...

- AutoGPT目前只是成功学大师GPT版

一大波韭菜被收割了 最近很多人在交流对于AutoGPT的震惊和激动.AutoGPT是一个开源的应用程序,展示了GPT-4语言模型的能力.这个程序由GPT-4驱动,自主地开发和管理业务,以增加净值.它是 ...

- 在Jupyter Notebook,沉浸式体验ChatGPT

大家好,我是章北海mlpy 写代码,修Bug是 ChatGPT 目前最擅长的领域之一 今天向大家推荐一个刚刚开源的Python包 安装后可以直接在IPython和Jupyter Notebook中直接 ...