python爬虫从入门到放弃(九)之 实例爬取上海高级人民法院网开庭公告数据

通过前面的文章已经学习了基本的爬虫知识,通过这个例子进行一下练习,毕竟前面文章的知识点只是一个

一个单独的散知识点,需要通过实际的例子进行融合

分析网站

其实爬虫最重要的是前面的分析网站,只有对要爬取的数据页面分析清楚,才能更方便后面爬取数据

目标站和目标数据

目标地址:http://www.hshfy.sh.cn/shfy/gweb/ktgg_search.jsp

目标数据:目标地址页面的中间的案开庭公告数据

对数据页面分析

从打开页面后可以看到默认的数据是一个月的数据,即当天到下个月该天的

通过翻页可以返现这个时候页面的url地址是不变的,所以这里我们大致就可以判断出,中间表格的数据是通过js动态加载的,我们可以通过分析抓包,找到真实的请求地址

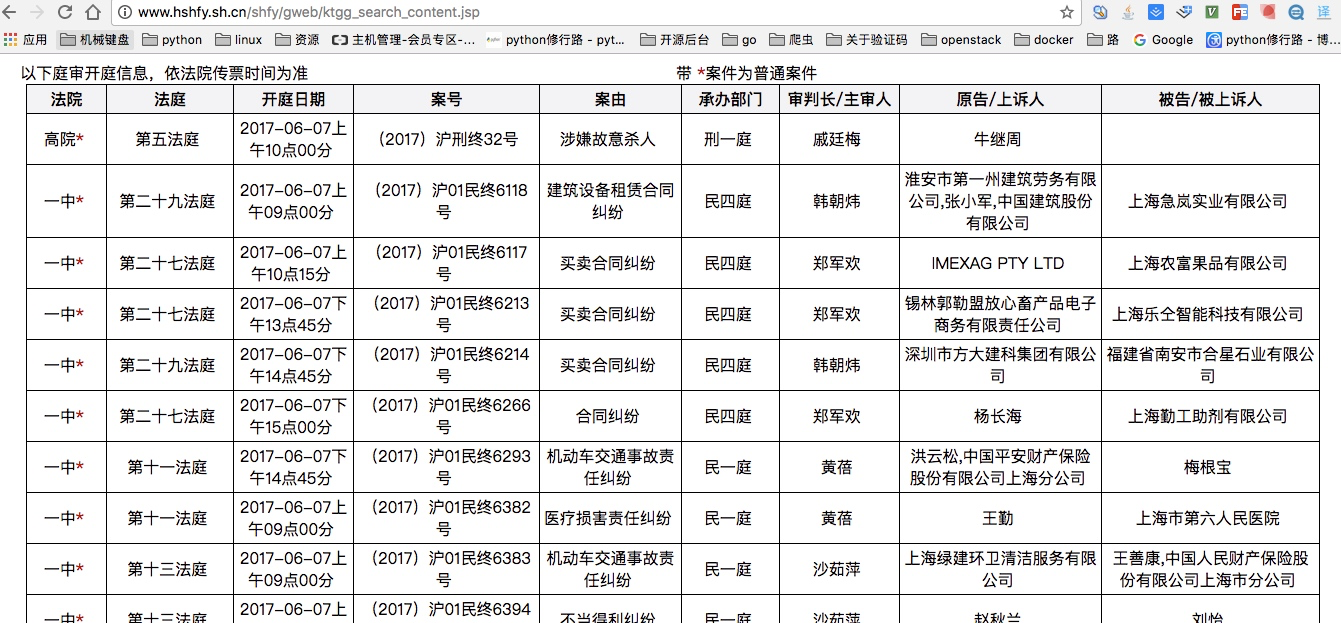

通过上图我们可以发现其实帧数的数据来源是http://www.hshfy.sh.cn/shfy/gweb/ktgg_search_content.jsp 这个地址。

当直接访问这个地址可以看到如下数据:

也正好验证了我们前面所说的,中间表格的数据是通过js动态加载的,所以我们剩下的就是对这个地址进行分析

分析真实地址

通过上图我们可以分析几个对我们有用的数据就是请求地址以及请求参数,

请求参数中,最重要的是日期以及页数

通过代码实现数据的爬取

代码的功能还有待完善,只是一个初步的例子

代码地址:https://github.com/pythonsite/spider/tree/master/www.hshfy.sh.cn

python爬虫从入门到放弃(九)之 实例爬取上海高级人民法院网开庭公告数据的更多相关文章

- python之爬虫(十一) 实例爬取上海高级人民法院网开庭公告数据

通过前面的文章已经学习了基本的爬虫知识,通过这个例子进行一下练习,毕竟前面文章的知识点只是一个 一个单独的散知识点,需要通过实际的例子进行融合 分析网站 其实爬虫最重要的是前面的分析网站,只有对要爬取 ...

- Python爬虫从入门到放弃(十一)之 Scrapy框架整体的一个了解

这里是通过爬取伯乐在线的全部文章为例子,让自己先对scrapy进行一个整理的理解 该例子中的详细代码会放到我的github地址:https://github.com/pythonsite/spider ...

- Python爬虫实战(一) 使用urllib库爬取拉勾网数据

本笔记写于2020年2月4日.Python版本为3.7.4,编辑器是VS code 主要参考资料有: B站视频av44518113 Python官方文档 PS:如果笔记中有任何错误,欢迎在评论中指出, ...

- Python爬虫从入门到放弃(十九)之 Scrapy爬取所有知乎用户信息(下)

在上一篇文章中主要写了关于爬虫过程的分析,下面是代码的实现,完整代码在:https://github.com/pythonsite/spider items中的代码主要是我们要爬取的字段的定义 cla ...

- python爬虫从入门到放弃(三)之 Urllib库的基本使用

官方文档地址:https://docs.python.org/3/library/urllib.html 什么是Urllib Urllib是python内置的HTTP请求库包括以下模块urllib.r ...

- python爬虫从入门到放弃(八)之 Selenium库的使用

一.什么是Selenium selenium 是一套完整的web应用程序测试系统,包含了测试的录制(selenium IDE),编写及运行(Selenium Remote Control)和测试的并行 ...

- python爬虫从入门到放弃前奏之学习方法

首谈方法 最近在整理爬虫系列的博客,但是当整理几篇之后,发现一个问题,不管学习任何内容,其实方法是最重要的,按照我之前写的博客内容,其实学起来还是很点枯燥不能解决传统学习过程中的几个问题: 这个是普通 ...

- Python爬虫从入门到放弃(十二)之 Scrapy框架的架构和原理

这一篇文章主要是为了对scrapy框架的工作流程以及各个组件功能的介绍 Scrapy目前已经可以很好的在python3上运行Scrapy使用了Twisted作为框架,Twisted有些特殊的地方是它是 ...

- Python爬虫从入门到放弃(十七)之 Scrapy框架中Download Middleware用法

这篇文章中写了常用的下载中间件的用法和例子.Downloader Middleware处理的过程主要在调度器发送requests请求的时候以及网页将response结果返回给spiders的时候,所以 ...

随机推荐

- 优雅地解决Ajax接口参数来自另一个接口的问题

最近闲赋在家,终于有时间回顾我在工作中遇到的一些东西,由于经验不足,有些方面做的不是很好.在上家公司曾经遇到一个小问题,就是Ajax的接口中有参数是从另一个接口后台传来的.当时我的做法是将需要参数的接 ...

- while循环语句的几种方式

我们知道,在Python中经常我们要使用循环,其中最常用的是while循环,while有很多结合方式,我们知道,如果一个循环没有结束语句那么就失去了意义,所以我们一定要有结束语句,下面来看看while ...

- NODEJS环境搭建 第一篇 安装和部署NODEJS

一.下载安装文件 根据自己当前系统环境,下载相对应的安装文件 https://nodejs.org/en/download/ 二.双击安装 都傻瓜式的安装步骤,一步一步安装就好了. 三.检查安装结果 ...

- 一个 Vue + Node + MongoDB 博客系统

源码 耗时半载(半个月)的大项目终于完成了.这是一个博客系统,使用 Vue 做前端框架,Node + express 做后端,数据库使用的是 MongoDB.实现了用户注册.用户登录.博客管理(文章的 ...

- 揭秘Kafka高性能架构之道 - Kafka设计解析(六)

原创文章,同步首发自作者个人博客.转载请务必在文章开头处以超链接形式注明出处http://www.jasongj.com/kafka/high_throughput/ 摘要 上一篇文章<Kafk ...

- selenium操作拖拽实现无效果的替代方案

如果碰到这种情况,无论你是直接通过draganddrop()还是分步执行clickandhold(),dragtoelement(),或通过by_offset位移都无法实现元素拖拽.只能物理模拟了 w ...

- PHP获取随机数

<?php $FileID=date("Ymd-His") . '-' . rand(100,999); //$FileID为 20100903-132121-908 ...

- PDO(数据访问抽象层)、pdo事务功能和预处理功能---2017-05-05

之前所学的数据访问都是用mysqli做成类来访问的,但是mysqli这个类只是针对mysql这个数据库的:那么如果访问其他类型的数据库呢? 那么这就用到了PDO(数据访问抽象层). 一.关于PDO基本 ...

- iOS刨根问底-深入理解RunLoop

开源的RunloopRef 通常所说的RunLoop指的是NSRunloop或者CFRunloopRef,CFRunloopRef是纯C的函数,而NSRunloop仅仅是CFRunloopRef的OC ...

- Python 学习——高阶函数 filter 和 sorted

filter filter函数顾名思义,筛选,通过调用函数进行筛选序列中的满足函数的子项 以实例来说话: 过滤一个序列中所有的偶数,保留奇数 另如下,过滤掉一个序列中的所有空格以及空字符等信息 可以知 ...