Hadoop 单节点(或集群)基本配置信息

1. 默认配置文件: 存放于Hadoop对应的jar包中

core-default.xmlhdfs-default.xmlyarn-default.xmlmapred-default.xml

2. 自定义配置文件: $HADOOP_HOME/etc/hadoop

core-site.xmlhdfs-site.xmlyarn-site.xmlmapred-site.xml

2.1 core-site.xml

<configuration>

<property>

<!-- 指定HDFS中NameNode的地址 -->

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

<!-- 指定Hadoop运行时产生文件的存储目录,hadoop启动时,会自动创建 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/(自定义路径)/hadoop-2.8.5/data/tmp</value>

</property>

</configuration>

2.2 hadoop-env.sh

export JAVA_HOME=服务器java环境变量

2.3 hdfs-site.xml

<configuration>

<!-- nameNode 文件的副本数量 -->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<!-- nameNode 的访问地址-->

<property>

<name>dfs.namenode.rpc-bind-host</name>

<value>0.0.0.0</value>

</property>

</configuration>

2.4 yarn-site.xml

<configuration>

<!-- Reducer 获取数据的方式-->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>0.0.0.0</value>

</property>

<!-- 指定YARN 的 ResourceManager 的地址-->

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>${yarn.resourcemanager.hostname}:8090</value>

</property>

<!-- 开启日志聚集功能 -->

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<!-- 日志保留7天 -->

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>604800</value>

</property>

</configuration>

2.5 yarn-env.sh 配置

export JAVA_HOME=服务器java环境变量

2.6 mapred-site.xml

<configuration>

<!-- 指定MR运行在YARN上 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<!-- 历史记录服务器端地址 -->

<property>

<name>mapreduce.jobhistory.address</name>

<value>localhost:10020</value>

</property>

<!-- 历史服务器web端地址 -->

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>0.0.0.0:8091</value>

</property>

</configuration>

2.7 mapred-env.sh 配置

export JAVA_HOME=服务器java环境变量

3. Hadoop 集群配置

3.1 节点内容预览

| 节点1 | 节点2 | 节点3 | |

|---|---|---|---|

| HDFS | NameNode DataNode |

DataNode | SecondaryNameNode DataNode |

| YARN | NodeManager | ResourceManager NodeManager |

NodeManager |

3.2 core-site.xml 配置

<configuration>

<property>

<!-- 指定HDFS中NameNode的地址 -->

<name>fs.defaultFS</name>

<value>hdfs://节点1:9000</value>

</property>

<!-- 指定Hadoop运行时产生文件的存储目录,hadoop启动时,会自动创建 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/(自定义路径)/hadoop-2.8.5/data/tmp</value>

</property>

</configuration>

3.3 hadoop-env.sh 配置

export JAVA_HOME=服务器java环境变量

3.4 hdfs-site.xml 配置

<configuration>

<!-- nameNode 文件的副本数量 -->

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<!-- 指定 Hadoop 辅助名称节点主机配置(SecondaryNameNode) -->

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>节点3主机名称:端口号</value>

</property>

</configuration>

3.5 yarn-env.sh 配置

export JAVA_HOME=服务器java环境变量

3.6 yarn-site.xml 配置

<configuration>

<!-- Reducer 获取数据的方式-->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>节点2</value>

</property>

<!-- 指定YARN 的 ResourceManager 的地址-->

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>${yarn.resourcemanager.hostname}:8090</value>

</property>

<!-- 开启日志聚集功能 -->

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<!-- 日志保留7天 -->

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>604800</value>

</property>

</configuration>

3.7 mapred-env.sh 配置

export JAVA_HOME=服务器java环境变量

3.8 mapred-site.xml 配置

<configuration>

<!-- 指定MR运行在YARN上 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

3.9 slaves 配置

节点1

节点2

节点3

4. 常用命令

bin/hdfs namenode -format: 格式化命令;执行命令前,需要将单节点(或集群)中的/data,/logs目录删除。bin/hdfs dfs -put 待上传文件 上传的目的地:将本地文件上传至hdfs中。sbin/hadoop-daemon.sh start(stop) namenode: 启动(或停止)单节点NameNode。sbin/hadoop-daemon.sh start(stop) datanode: 启动(或停止)单节点DataNode。sbin/yarn-daemon.sh start(stop) resourcemanager: 启动(或停止)单节点ResourceManager。sbin/yarn-daemon.sh start(stop) nodemanager: 启动(或停止)单节点NodeManager。sbin/mr-jobhistory-daemon.sh start(stop) historyserver: 启动(或停止)单节点History记录。sbin/start-dfs.sh: 启动HDFS集群(注意:所有节点均已配置"Hadoop目录/etc/hadoop/slaves")。sbin/start-yarn.sh: 启动YARN集群(注意:所有节点均已配置"Hadoop目录/etc/hadoop/slaves"; 另外,需要在ResourceManager服务器启动)。sbin/stop-dfs.sh: 停止HDFS集群。sbin/stop-yarn.sh: 停止YARN集群。

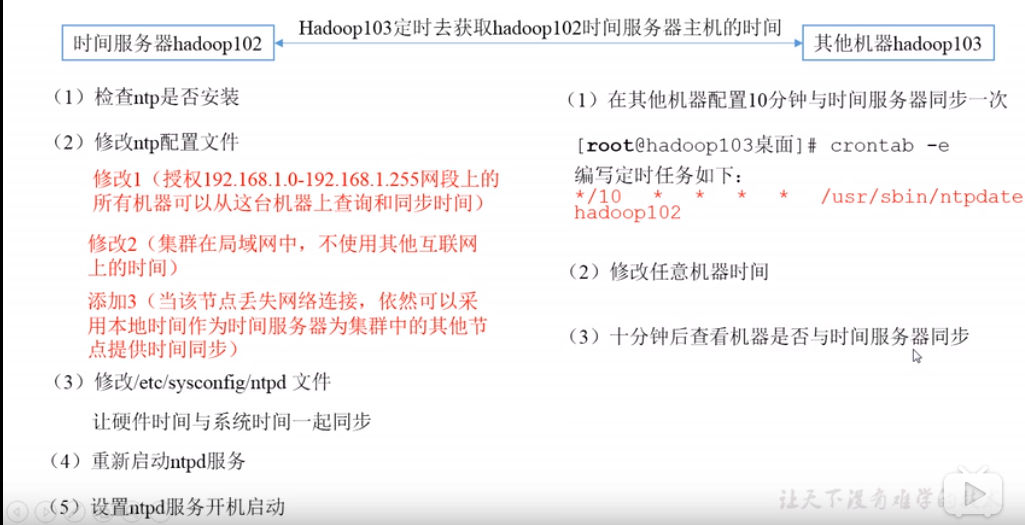

5. 集群时间同步

- 时间同步的方式:找一个机器, 作为时间服务器,所有机器与这台集群时间进行定时的同步;

- 检查

ntp是否安装rpm -qa|grep ntp; - 修改

ntp配置文件/etc/ntp.conf; - 修改

/etc/sysconfig/ntpd文件;- 让硬件时间与系统时间一起同步;

- 重启

ntpd服务; - 设置

ntpd服务开机启动;

- 检查

**参考资料:**

- [设置集群时间同步](https://www.bilibili.com/video/av32081351/?p=44)

- [rpm命令](http://man.linuxde.net/rpm)

Hadoop 单节点(或集群)基本配置信息的更多相关文章

- 使用Minikube运行一个本地单节点Kubernetes集群(阿里云)

使用Minikube运行一个本地单节点Kubernetes集群中使用谷歌官方镜像由于某些原因导致镜像拉取失败以及很多人并没有代理无法开展相关实验. 因此本文使用阿里云提供的修改版Minikube创建一 ...

- Hadoop 2.6.1 集群安装配置教程

集群环境: 192.168.56.10 master 192.168.56.11 slave1 192.168.56.12 slave2 下载安装包/拷贝安装包 # 存放路径: cd /usr/loc ...

- Kafka单节点及集群配置安装

一.单节点 1.上传Kafka安装包到Linux系统[当前为Centos7]. 2.解压,配置conf/server.property. 2.1配置broker.id 2.2配置log.dirs 2. ...

- K8s二进制部署单节点 etcd集群,flannel网络配置 ——锥刺股

K8s 二进制部署单节点 master --锥刺股 k8s集群搭建: etcd集群 flannel网络插件 搭建master组件 搭建node组件 1.部署etcd集群 2.Flannel 网络 ...

- Hadoop安装教程_集群/分布式配置

配置集群/分布式环境 集群/分布式模式需要修改 /usr/local/hadoop/etc/hadoop 中的5个配置文件,更多设置项可点击查看官方说明,这里仅设置了正常启动所必须的设置项: slav ...

- 1.如何在虚拟机ubuntu上安装hadoop多节点分布式集群

要想深入的学习hadoop数据分析技术,首要的任务是必须要将hadoop集群环境搭建起来,可以将hadoop简化地想象成一个小软件,通过在各个物理节点上安装这个小软件,然后将其运行起来,就是一个had ...

- ActiveMQ的单节点和集群部署

平安寿险消息队列用的是ActiveMQ. 单节点部署: 下载解压后,直接cd到bin目录,用activemq start命令就可启动activemq服务端了. ActiveMQ默认采用61616端口提 ...

- 使用Minikube运行一个本地单节点Kubernetes集群

使用Minikube是运行Kubernetes集群最简单.最快捷的途径,Minikube是一个构建单节点集群的工具,对于测试Kubernetes和本地开发应用都非常有用. ⒈安装Minikube Mi ...

- CentOS系统下Hadoop 2.4.1集群安装配置(简易版)

安装配置 1.软件下载 JDK下载:jdk-7u65-linux-i586.tar.gz http://www.oracle.com/technetwork/java/javase/downloads ...

- Hadoop 2.5.1集群安装配置

本文的安装只涉及了hadoop-common.hadoop-hdfs.hadoop-mapreduce和hadoop-yarn,并不包含HBase.Hive和Pig等. http://blog.csd ...

随机推荐

- ueditor+word图片上传

最近公司做项目需要实现一个功能,在网页富文本编辑器中实现粘贴Word图文的功能. 我们在网站中使用的Web编辑器比较多,都是根据用户需求来选择的.目前还没有固定哪一个编辑器 有时候用的是UEditor ...

- 网络1911、1912 C语言第4次作业--函数批改总结

目录 网络1911.1912 C语言第4次作业--函数批改总结 一.评分规则 二.本次作业亮点 三.本次作业存在的问题 四.助教有话说 五.得分详情 网络1911.1912 C语言第4次作业--函数批 ...

- python 将IP地址转换成打包后的32位格式

python 2.7 #!/usr/bin/env python # Python Network Programming Cookbook -- Chapter - # This program r ...

- 创建jQuery节点对象

现在的年轻人,经历旺盛,每天都熬夜,今天又晚了,现在才更新博客,今天更新jquery入门之对节点的操作,内容简单好掌握.认真的燥再来吧. 1.$("<li class="li ...

- selenium安装与更新

1.通过pip show selenium 查看是否已经安装过selenium,如果已经安装selenium会显示安装的selenium的版本信息. 如果在使用pip 查看命令报Unknown or ...

- getBoundingClientRect使用指南

getBoundingClientRect使用指南 author: @TiffanysBear 主要介绍getBoundingClientRect的基本属性,以及具体的使用场景和一些需要注意的问题. ...

- JS模拟Touch事件

var ele = document.getElementsByClassName('target_node_class')[0] //may have x and y properties in s ...

- python 调用github的api,呈现python的受欢迎的程度

1 使用api调用数据: 在浏览器的地址栏中输入: https://api.github.com/search/repositories?q=language:python&sort=star ...

- 慢查询explan详解

慢查询排查 show status; // 查询mysql数据库的一些运行状态 show status like 'uptime'; // 查看mysql数据库启动多 ...

- concurrency parallel 并发 并行 parallelism

在传统的多道程序环境下,要使作业运行,必须为它创建一个或几个进程,并为之分配必要的资源.当进程运行结束时,立即撤销该进程,以便能及时回收该进程所占用的各类资源.进程控制的主要功能是为作业创建进程,撤销 ...