深度学习之GAN对抗神经网络

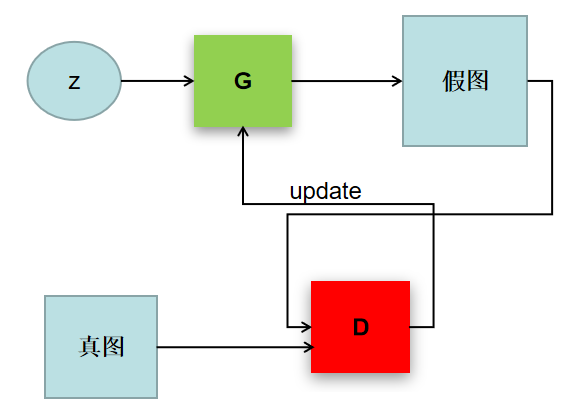

1、结构图

2、知识点

生成器(G):将噪音数据生成一个想要的数据

判别器(D):将生成器的结果进行判别,

3、代码及案例

# coding: utf-8 # ## 对抗生成网络案例 ##

#

#

# <img src="jpg/3.png" alt="FAO" width="590" > # - 判别器 : 火眼金睛,分辨出生成和真实的 <br />

# <br />

# - 生成器 : 瞒天过海,骗过判别器 <br />

# <br />

# - 损失函数定义 : 一方面要让判别器分辨能力更强,另一方面要让生成器更真 <br />

# <br />

#

# <img src="jpg/1.jpg" alt="FAO" width="590" > # In[1]: import tensorflow as tf

import numpy as np

import pickle

import matplotlib.pyplot as plt get_ipython().run_line_magic('matplotlib', 'inline') # # 导入数据 # In[2]: from tensorflow.examples.tutorials.mnist import input_data

mnist = input_data.read_data_sets('/data') # ## 网络架构

#

# ### 输入层 :待生成图像(噪音)和真实数据

#

# ### 生成网络:将噪音图像进行生成

#

# ### 判别网络:

# - (1)判断真实图像输出结果

# - (2)判断生成图像输出结果

#

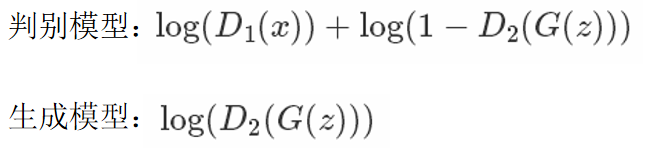

# ### 目标函数:

# - (1)对于生成网络要使得生成结果通过判别网络为真

# - (2)对于判别网络要使得输入为真实图像时判别为真 输入为生成图像时判别为假

#

# <img src="jpg/2.png" alt="FAO" width="590" > # ## Inputs # In[3]: #真实数据和噪音数据

def get_inputs(real_size, noise_size): real_img = tf.placeholder(tf.float32, [None, real_size])

noise_img = tf.placeholder(tf.float32, [None, noise_size]) return real_img, noise_img # ## 生成器

# * noise_img: 产生的噪音输入

# * n_units: 隐层单元个数

# * out_dim: 输出的大小(28 * 28 * 1) # In[4]: def get_generator(noise_img, n_units, out_dim, reuse=False, alpha=0.01): with tf.variable_scope("generator", reuse=reuse):

# hidden layer

hidden1 = tf.layers.dense(noise_img, n_units)

# leaky ReLU

hidden1 = tf.maximum(alpha * hidden1, hidden1)

# dropout

hidden1 = tf.layers.dropout(hidden1, rate=0.2) # logits & outputs

logits = tf.layers.dense(hidden1, out_dim)

outputs = tf.tanh(logits) return logits, outputs # ## 判别器

# * img:输入

# * n_units:隐层单元数量

# * reuse:由于要使用两次 # In[5]: def get_discriminator(img, n_units, reuse=False, alpha=0.01): with tf.variable_scope("discriminator", reuse=reuse):

# hidden layer

hidden1 = tf.layers.dense(img, n_units)

hidden1 = tf.maximum(alpha * hidden1, hidden1) # logits & outputs

logits = tf.layers.dense(hidden1, 1)

outputs = tf.sigmoid(logits) return logits, outputs # ## 网络参数定义

# * img_size:输入大小

# * noise_size:噪音图像大小

# * g_units:生成器隐层参数

# * d_units:判别器隐层参数

# * learning_rate:学习率 # In[6]: img_size = mnist.train.images[0].shape[0] noise_size = 100 g_units = 128 d_units = 128 learning_rate = 0.001 alpha = 0.01 # ## 构建网络 # In[7]: tf.reset_default_graph() real_img, noise_img = get_inputs(img_size, noise_size) # generator

g_logits, g_outputs = get_generator(noise_img, g_units, img_size) # discriminator

d_logits_real, d_outputs_real = get_discriminator(real_img, d_units)

d_logits_fake, d_outputs_fake = get_discriminator(g_outputs, d_units, reuse=True) # ### 目标函数:

# - (1)对于生成网络要使得生成结果通过判别网络为真

# - (2)对于判别网络要使得输入为真实图像时判别为真 输入为生成图像时判别为假

#

# <img src="jpg/2.png" alt="FAO" width="590" > # In[8]: # discriminator的loss

# 识别真实图片

d_loss_real = tf.reduce_mean(tf.nn.sigmoid_cross_entropy_with_logits(logits=d_logits_real,

labels=tf.ones_like(d_logits_real)))

# 识别生成的图片

d_loss_fake = tf.reduce_mean(tf.nn.sigmoid_cross_entropy_with_logits(logits=d_logits_fake,

labels=tf.zeros_like(d_logits_fake)))

# 总体loss

d_loss = tf.add(d_loss_real, d_loss_fake) # generator的loss

g_loss = tf.reduce_mean(tf.nn.sigmoid_cross_entropy_with_logits(logits=d_logits_fake,

labels=tf.ones_like(d_logits_fake))) # ## 优化器 # In[9]: train_vars = tf.trainable_variables() # generator

g_vars = [var for var in train_vars if var.name.startswith("generator")]

# discriminator

d_vars = [var for var in train_vars if var.name.startswith("discriminator")] # optimizer

d_train_opt = tf.train.AdamOptimizer(learning_rate).minimize(d_loss, var_list=d_vars)

g_train_opt = tf.train.AdamOptimizer(learning_rate).minimize(g_loss, var_list=g_vars) # # 训练 # In[10]: # batch_size

batch_size = 64

# 训练迭代轮数

epochs = 300

# 抽取样本数

n_sample = 25 # 存储测试样例

samples = []

# 存储loss

losses = []

# 保存生成器变量

saver = tf.train.Saver(var_list = g_vars)

# 开始训练

with tf.Session() as sess:

sess.run(tf.global_variables_initializer())

for e in range(epochs):

for batch_i in range(mnist.train.num_examples//batch_size):

batch = mnist.train.next_batch(batch_size) batch_images = batch[0].reshape((batch_size, 784))

# 对图像像素进行scale,这是因为tanh输出的结果介于(-1,1),real和fake图片共享discriminator的参数

batch_images = batch_images*2 - 1 # generator的输入噪声

batch_noise = np.random.uniform(-1, 1, size=(batch_size, noise_size)) # Run optimizers

_ = sess.run(d_train_opt, feed_dict={real_img: batch_images, noise_img: batch_noise})

_ = sess.run(g_train_opt, feed_dict={noise_img: batch_noise}) # 每一轮结束计算loss

train_loss_d = sess.run(d_loss,

feed_dict = {real_img: batch_images,

noise_img: batch_noise})

# real img loss

train_loss_d_real = sess.run(d_loss_real,

feed_dict = {real_img: batch_images,

noise_img: batch_noise})

# fake img loss

train_loss_d_fake = sess.run(d_loss_fake,

feed_dict = {real_img: batch_images,

noise_img: batch_noise})

# generator loss

train_loss_g = sess.run(g_loss,

feed_dict = {noise_img: batch_noise}) print("Epoch {}/{}...".format(e+1, epochs),

"判别器损失: {:.4f}(判别真实的: {:.4f} + 判别生成的: {:.4f})...".format(train_loss_d, train_loss_d_real, train_loss_d_fake),

"生成器损失: {:.4f}".format(train_loss_g)) losses.append((train_loss_d, train_loss_d_real, train_loss_d_fake, train_loss_g)) # 保存样本

sample_noise = np.random.uniform(-1, 1, size=(n_sample, noise_size))

gen_samples = sess.run(get_generator(noise_img, g_units, img_size, reuse=True),

feed_dict={noise_img: sample_noise})

samples.append(gen_samples) saver.save(sess, './checkpoints/generator.ckpt') # 保存到本地

with open('train_samples.pkl', 'wb') as f:

pickle.dump(samples, f) # # loss迭代曲线 # In[11]: fig, ax = plt.subplots(figsize=(20,7))

losses = np.array(losses)

plt.plot(losses.T[0], label='判别器总损失')

plt.plot(losses.T[1], label='判别真实损失')

plt.plot(losses.T[2], label='判别生成损失')

plt.plot(losses.T[3], label='生成器损失')

plt.title("对抗生成网络")

ax.set_xlabel('epoch')

plt.legend() # # 生成结果 # In[12]: # Load samples from generator taken while training

with open('train_samples.pkl', 'rb') as f:

samples = pickle.load(f) # In[13]: #samples是保存的结果 epoch是第多少次迭代

def view_samples(epoch, samples): fig, axes = plt.subplots(figsize=(7,7), nrows=5, ncols=5, sharey=True, sharex=True)

for ax, img in zip(axes.flatten(), samples[epoch][1]): # 这里samples[epoch][1]代表生成的图像结果,而[0]代表对应的logits

ax.xaxis.set_visible(False)

ax.yaxis.set_visible(False)

im = ax.imshow(img.reshape((28,28)), cmap='Greys_r') return fig, axes # In[14]: _ = view_samples(-1, samples) # 显示最终的生成结果 # # 显示整个生成过程图片 # In[15]: # 指定要查看的轮次

epoch_idx = [10, 30, 60, 90, 120, 150, 180, 210, 240, 290]

show_imgs = []

for i in epoch_idx:

show_imgs.append(samples[i][1]) # In[16]: # 指定图片形状

rows, cols = 10, 25

fig, axes = plt.subplots(figsize=(30,12), nrows=rows, ncols=cols, sharex=True, sharey=True) idx = range(0, epochs, int(epochs/rows)) for sample, ax_row in zip(show_imgs, axes):

for img, ax in zip(sample[::int(len(sample)/cols)], ax_row):

ax.imshow(img.reshape((28,28)), cmap='Greys_r')

ax.xaxis.set_visible(False)

ax.yaxis.set_visible(False) # # 生成新的图片 # In[17]: # 加载我们的生成器变量

saver = tf.train.Saver(var_list=g_vars)

with tf.Session() as sess:

saver.restore(sess, tf.train.latest_checkpoint('checkpoints'))

sample_noise = np.random.uniform(-1, 1, size=(25, noise_size))

gen_samples = sess.run(get_generator(noise_img, g_units, img_size, reuse=True),

feed_dict={noise_img: sample_noise}) # In[18]: _ = view_samples(0, [gen_samples])

4、优化目标

深度学习之GAN对抗神经网络的更多相关文章

- Hinton“深度学习之父”和“神经网络先驱”,新论文Capsule将推翻自己积累了30年的学术成果时

Hinton“深度学习之父”和“神经网络先驱”,新论文Capsule将推翻自己积累了30年的学术成果时 在论文中,Capsule被Hinton大神定义为这样一组神经元:其活动向量所表示的是特定实体类型 ...

- 深度学习之 GAN 进行 mnist 图片的生成

深度学习之 GAN 进行 mnist 图片的生成 mport numpy as np import os import codecs import torch from PIL import Imag ...

- Pytorch_第六篇_深度学习 (DeepLearning) 基础 [2]---神经网络常用的损失函数

深度学习 (DeepLearning) 基础 [2]---神经网络常用的损失函数 Introduce 在上一篇"深度学习 (DeepLearning) 基础 [1]---监督学习和无监督学习 ...

- 【深度学习】--GAN从入门到初始

一.前述 GAN,生成对抗网络,在2016年基本火爆深度学习,所有有必要学习一下.生成对抗网络直观的应用可以帮我们生成数据,图片. 二.具体 1.生活案例 比如假设真钱 r 坏人定义为G 我们通过 ...

- 深度学习-Wasserstein GAN论文理解笔记

GAN存在问题 训练困难,G和D多次尝试没有稳定性,Loss无法知道能否优化,生成样本单一,改进方案靠暴力尝试 WGAN GAN的Loss函数选择不合适,使模型容易面临梯度消失,梯度不稳定,优化目标不 ...

- [DeeplearningAI笔记]神经网络与深度学习2.11_2.16神经网络基础(向量化)

觉得有用的话,欢迎一起讨论相互学习~Follow Me 2.11向量化 向量化是消除代码中显示for循环语句的艺术,在训练大数据集时,深度学习算法才变得高效,所以代码运行的非常快十分重要.所以在深度学 ...

- 【深度学习系列】卷积神经网络CNN原理详解(一)——基本原理

上篇文章我们给出了用paddlepaddle来做手写数字识别的示例,并对网络结构进行到了调整,提高了识别的精度.有的同学表示不是很理解原理,为什么传统的机器学习算法,简单的神经网络(如多层感知机)都可 ...

- TensorFlow(实战深度学习框架)----深层神经网络(第四章)

深层神经网络可以解决部分浅层神经网络解决不了的问题. 神经网络的优化目标-----损失函数 深度学习:一类通过多层非线性变化对高复杂性数据建模算法的合集.(两个重要的特性:多层和非线性) 线性模型的最 ...

- SIGAI深度学习第二集 人工神经网络1

讲授神经网络的思想起源.神经元原理.神经网络的结构和本质.正向传播算法.链式求导及反向传播算法.神经网络怎么用于实际问题等 课程大纲: 神经网络的思想起源 神经元的原理 神经网络结构 正向传播算法 怎 ...

随机推荐

- Xshell连接阿里云服务被拒绝

问题描述:突然的Xshell连接阿里云服务被拒绝了(如图)网上众多的方案都不行例如:https://www.cnblogs.com/wanglle/p/11416987.html(参考博文,本人这个问 ...

- linux操作系统中的常用命令以及快捷键(一)

接触了linux系统一年,总结一些常用的命令,快捷键等一些尝试 1.首先查看linux内核数量,常用于编译源码包时 用 make -j 来指定内核数来编译 grep ^processor /proc/ ...

- 在线p图网址

在线P图网址 如果你是简易的P图,不用那么麻烦的去下载安装Photoshop,可以使用以下网址在线编辑 https://www.uupoop.com/ps/?hmsr=ps_menu

- PAT Basic 1064 朋友数 (20 分)

如果两个整数各位数字的和是一样的,则被称为是“朋友数”,而那个公共的和就是它们的“朋友证号”.例如 123 和 51 就是朋友数,因为 1+2+3 = 5+1 = 6,而 6 就是它们的朋友证号.给定 ...

- 打开myeclipse提示An internal error occurred during: "CheckLicensesAndNotify". com/genuitec/pulse2/client/targetcfg/ui/PulseActivator

打开myeclipse提示An internal error occurred during: "CheckLicensesAndNotify". com/genuitec/pul ...

- 统计连接到主机前十的ip地址和连接数

常用脚本–tcp #!/bin/bash # #******************************************************************** #encodi ...

- 19-SQLServer定期自动导入数据的dtsx部署

一.注意点 1.登录Integration Service必须使用windows用户,并且只能在本地服务器登录. 2.SQLServer2000以前,叫dts,全程Data Transformatio ...

- Centos7静态ip设置(亲测有效)

本文引自:https://www.cnblogs.com/toov5/p/10340395.html,特此鸣谢 最近想测试消息中间件等各类web集群相关技术,这就需要解决linux主机之间互联互通的若 ...

- net core 3 使用 autofac

参考官方:https://docs.autofac.org/en/latest/integration/aspnetcore.html#startup-class 有一些变动,现在暂时还没用net c ...

- 自己总结:汇编CALL和RET指令

ret指令,相当于 pop IP:修改IP的内容,从而实现近转移 retf指令,相当于 pop IP pop CS:修改CS和IP的内容,从而实现远转移 -------------- CPU执行cal ...