python爬虫概述

爬虫的使用:爬虫用来对网络的数据信息进行爬取,通过URL的形式,将数据保存在数据库中并以文档形式或者报表形式进行展示。

爬虫可分为通用式爬虫或特定式爬虫,像我们经常用到的搜索引擎就属于通用式爬虫,如果针对某一特定主题或者新闻进行爬取,则属于特定式爬虫。

一般用到的第三方库有urllib、request、BeautifuiSoup。经常用到的框架为Scrapy和PySpider

爬虫的爬取步骤:

- 获取指定的url链接,获得链接网址上的所有代码信息。

- 通过python的正则表达式,将嵌套的HTML代码和数据进行分离。

- 获取数据后,保存在文档或者数据库中。方便后续的展示。

正常的网络传输大致分为Request(请求)和Response(响应)两类。

正常的HTTP请求一般分为get和post方法#

#使用urllib2编写最简单的爬虫代码

from urllib import request as urllib2

#在进行url请求时,应该添加User-Agent头进行识别

header = {"User-Agent" : "Mozilla/5.0 (compatible; MSIE 9.0; Window

s NT 6.1; Trident/5.0;"}

request = urllib2.Request("http://www.baidu.com",headers=header )

response = urllib2.urlopen(request)

html = response.read()

print (html)

我们爬取的数据可分为结构化和非结构化两种

- 结构化数据:XML\JSON格式文件

- 非结构化数据:文本、图片、HTML文件

lxml VS BeautifulSoup

lxml为局部遍历,效率较高。而BeautifulSoup为全局遍历,基于HTML DOM的,性能较差。

#使用requests编写爬虫代码

import requests

r = requests.get("http://www.baidu.com")

print(r.status_code) #输出状态码

print(r.text) #输出返回文本

print(r.json) #输出json格式文件

print(r.url) #输出访问的url地址

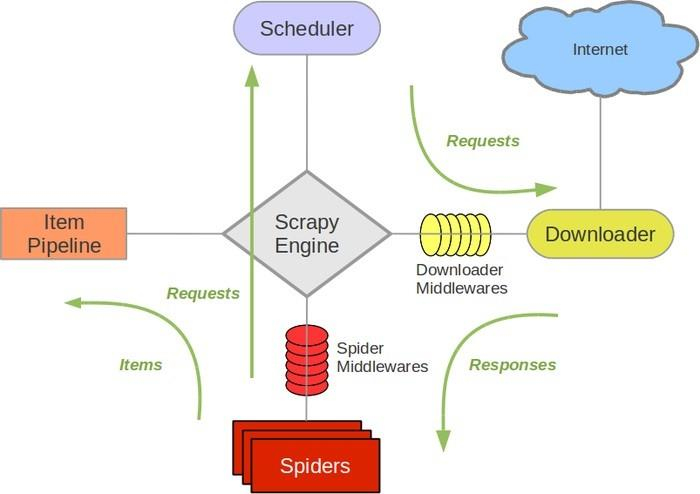

Scrapy架构图

Engine:负责其他组件的运转流程调度。

Scheduler:接收引擎发过来的request请求,并对其进行整理排列。当需要时返还。

Downloader:下载引擎所发送的Requests请求,并将获得的Response交给引擎,由Spider来处理。

Spider:负责从Response中提取Item中需要的数据,并将其他的URL提交给引擎,再转交给Scheduler。

Item PipeLine:负责处理Spider中的Item,并进行后期处理。

Downloader Middlewares:扩展下载功能组件

Spider Middlewares:扩展引擎和Spider通信的功能组件

Scrapy不支持分布式,Scrapy-redis提供了以redis为基础的组件

反爬虫策略:

- 动态设置User-Agent(浏览器识别)

- 禁用cookies

- 使用VPN和代理IP

反爬虫科普:https://segmentfault.com/a/1190000005840672

python爬虫概述的更多相关文章

- 【网络爬虫】【python】网络爬虫(一):python爬虫概述

python爬虫的实现方式: 1.简单点的urllib2 + regex,足够了,可以实现最基本的网页下载功能.实现思路就是前面java版爬虫差不多,把网页拉回来,再正则regex解析信息--总结起来 ...

- 芝麻软件: Python爬虫进阶之爬虫框架概述

综述 爬虫入门之后,我们有两条路可以走. 一个是继续深入学习,以及关于设计模式的一些知识,强化Python相关知识,自己动手造轮子,继续为自己的爬虫增加分布式,多线程等功能扩展.另一条路便是学习一些优 ...

- Python爬虫进阶一之爬虫框架概述

综述 爬虫入门之后,我们有两条路可以走. 一个是继续深入学习,以及关于设计模式的一些知识,强化Python相关知识,自己动手造轮子,继续为自己的爬虫增加分布式,多线程等功能扩展.另一条路便是学习一些优 ...

- Python爬虫之12306-分析请求总概述

python爬虫也学了一段时间了.也爬过不少网站,最后我想用12306抢票器这个项目做一个对之前的学习的效果成见也是一个目标(开始学爬虫的时候,看到说,会爬12306,就会爬80%的网站),本人纯自学 ...

- python爬虫Scrapy(一)-我爬了boss数据

一.概述 学习python有一段时间了,最近了解了下Python的入门爬虫框架Scrapy,参考了文章Python爬虫框架Scrapy入门.本篇文章属于初学经验记录,比较简单,适合刚学习爬虫的小伙伴. ...

- 一个简单的python爬虫程序

python|网络爬虫 概述 这是一个简单的python爬虫程序,仅用作技术学习与交流,主要是通过一个简单的实际案例来对网络爬虫有个基础的认识. 什么是网络爬虫 简单的讲,网络爬虫就是模拟人访问web ...

- 【Python】【爬虫】如何学习Python爬虫?

如何学习Python爬虫[入门篇]? 路人甲 1 年前 想写这么一篇文章,但是知乎社区爬虫大神很多,光是整理他们的答案就够我这篇文章的内容了.对于我个人来说我更喜欢那种非常实用的教程,这种教程对于想直 ...

- python爬虫的教程

来源:http://cuiqingcai.com/1052.html 大家好哈,我呢最近在学习Python爬虫,感觉非常有意思,真的让生活可以方便很多.学习过程中我把一些学习的笔记总结下来,还记录了一 ...

- Python爬虫系列 - 初探:爬取旅游评论

Python爬虫目前是基于requests包,下面是该包的文档,查一些资料还是比较方便. http://docs.python-requests.org/en/master/ POST发送内容格式 爬 ...

随机推荐

- eclipse中 Launch configuration的历史记录

最近用eclipse打包jar的时候,需要指定一个main函数.需要先运行一下main函数,eclipse的Runnable JAR File Specification 下的Launch confi ...

- 让create-react-app支持sass,less

用create-react-app 创建的项目不支持sass和less,需要手动配置 npm install node-sass sass-loader --save 然后在config/webpac ...

- 解决telnet: connect to address 127.0.0.1: Connection refused的错误信息问题

1.检查telnet是否已安装: rpm -qa telnet 2.有输出说明已安装,如果没有输出则没有安装,使用yum install telnet进行安装 3.检查telnet-server是否已 ...

- EntityManager的merge()方法

EntityManager的merge()方法相当于hibernate中session的saveOrUpdate()方法: 用于实体的插入和更新操作:

- Codeforces 979 D. Kuro and GCD and XOR and SUM(异或和,01字典树)

Codeforces 979 D. Kuro and GCD and XOR and SUM 题目大意:有两种操作:①给一个数v,加入数组a中②给出三个数x,k,s:从当前数组a中找出一个数u满足 u ...

- 白鹭引擎EUI做H5活动 入门篇

前言:本学习文档的目的是为了实现h5,或者简单的h5游戏,比如说,我们要实现一个可以左右,或者上下移动的场景的h5,在场景移动的过程中,会有相应的动画或者操作,我们通过 js 也可以实现,但是为了流畅 ...

- Java内存和垃圾回收

Java内存大体上可以分为:本地方法区(线程共享).Java栈(线程隔离).本地方法栈(线程隔离).Java堆(线程共享).程序计数器(线程隔离). 1.本地方法区 各个线程共享的内存区域,只要存放被 ...

- PHP依赖管理工具Composer入门

作者: JeremyWei | 可以转载, 但必须以超链接形式标明文章原始出处和作者信息及版权声明 网址: http://weizhifeng.net/manage-php-dependency-wi ...

- 两次取反 !!a 的作用

两次取反的作用 让a的结果只能是false或者是true:如果a是0:两次取反当然是false:如果a是null:两次取反是false:如果a是undefined:两次取法是false:其余的比如 a ...

- 修复Long类型太长转为JSON格式的时候出错的问题

这边项目要求ID是自动生成的20位Long型数字 但是实际中应用的时候回发生一种问题就是,查询的时候debug的时候数据都正常,但是返回前端的时候就会发现,数据错误了. 大体就是类似于下面的这种情况. ...