【大数据】SmallFile-Analysis-Script

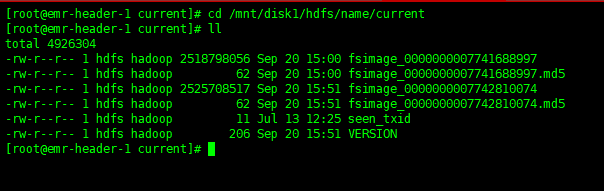

1.root账号先在namenode节点上配置一个定时任务,将fsimage定时传到其他客户机上进行操作

whereis hadoop命令确定安装目录,然后去配置文件找到namenode节点(data-93 emr-header-1)

0 1 * * * sh /root/fsimage.sh 每晚一点将fsimage文件发送到集群其他机器上,fsimage.sh如下

- #!/bin/bash

- TARGET_HOST=192.168.11.130

- SCP_PORT=

- IMAGE_DIR=/mnt/disk1/hdfs/name/current

- TARGET_DIR=/data/hdfs

- DAY=`date +%Y%m%d`

- echo "day=$DAY"

- cd $IMAGE_DIR

- fsname=`ls fsimage* | head -`

- echo $fsname

- scp -P $SCP_PORT $fsname ${TARGET_HOST}:${TARGET_DIR}/fsimage.${DAY}

- echo "done"

脚本在/mnt/disk1/hdfs/name/current下执行【scp -P 58422 fsimage_0000000007741688997 192.168.11.130:/data/hdfs/fsimage.20190920】,将namenode上的fsimage镜像文件传递到data130(192.168.11.130)上的文件夹里

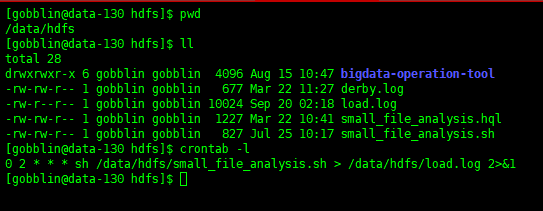

2.切换账号gobblin,在data-130的机子上配置crontab 任务,每天2点执行分析脚本

small_file_analysis.sh如下

- #!/bin/bash

- source /etc/profile

- basepath=$(cd `dirname $`; pwd)

- cd $basepath

- IMAGE_DIR="/data/hdfs"

- IMAGE_PREFIX="fsimage"

- # . 解析日期

- cur_date="`date +%Y%m%d`"

- cur_month="`date +%Y%m`"

- cur_day="`date +%d`"

- echo "cur month = $cur_month"

- echo "cur day = $cur_day"

- echo "cur date = $cur_date"

- IMAGE_NAME=$IMAGE_PREFIX.$cur_date

- echo "fsimage name is $IMAGE_NAME"

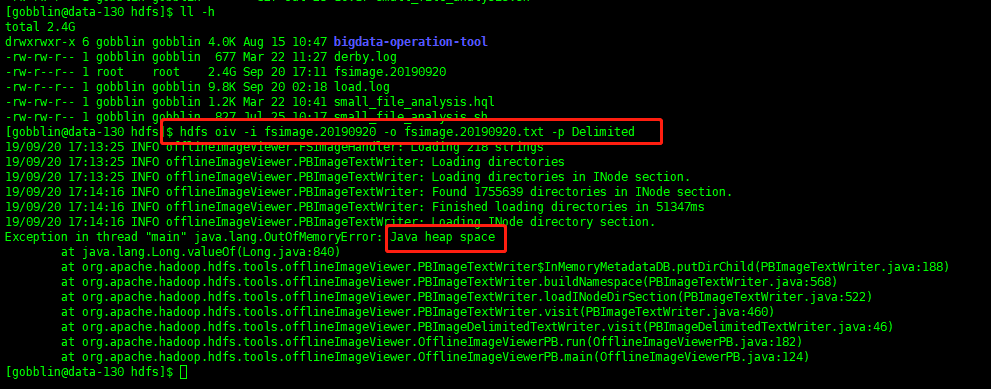

- # . 解析 fsimage 镜像文件,生成txt 文件

- export HADOOP_HEAPSIZE=

- hdfs oiv -i $IMAGE_NAME -o $IMAGE_NAME.txt -p Delimited

- # . 将 txt 文件load进 hive 表中

- hive -e "load data local inpath '$IMAGE_DIR/$IMAGE_NAME.txt' overwrite into table dataplatform.fsimage partition (month='$cur_month',day='$cur_day');"

- # . sql

- hive -hivevar CUR_MONTH=$cur_month -hivevar CUR_DAY=$cur_day -f small_file_analysis.hql

- rm -f fsimage*

- echo "done"

脚本逻辑很简单:使用image分析工具iov将image转为txt格式的文件,然后将文件导入hive 表(dataplatform.fsimage),再通过hive命令执行sql,将sql查询结果插入分析结果表(dataplatform.small_file_report_day),最后删除fsimage开头的2个文件即可

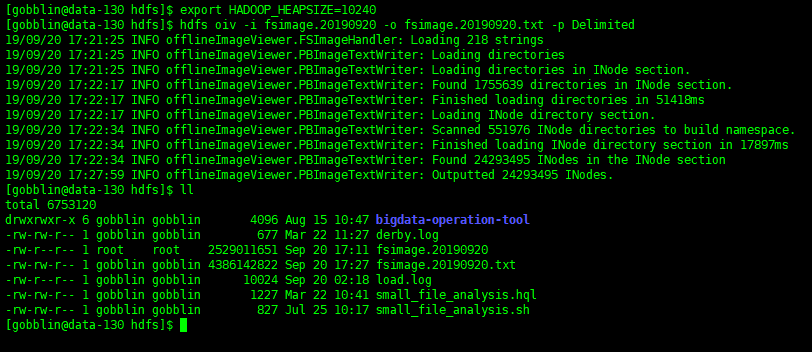

注意:export HADOOP_HEAPSIZE=10240 要加上,不然会报堆内存溢出

设置堆内存大小之后执行:

small_file_analysis.hql 如下:

- set mapreduce.job.queuename=root.production.gobblin;

- set mapreduce.job.name=small_file_analysis;

- set hive.exec.parallel=true;

- set hive.exec.parallel.thread.number=4;

- set mapreduce.map.memory.mb=1024;

- set mapreduce.reduce.memory.mb=1024;

- INSERT OVERWRITE TABLE dataplatform.small_file_report_day PARTITION (month='${CUR_MONTH}', day='${CUR_DAY}')

- SELECT b.path as path, b.total_num as total_num FROM (

- SELECT path, total_num, root_path

- FROM

- (

- SELECT

- SUBSTRING_INDEX(path, '/', 4) AS path,

- COUNT(1) AS total_num,

- SUBSTRING_INDEX(path, '/', 2) AS root_path

- FROM

- dataplatform.fsimage

- WHERE

- file_size < 1048576

- AND month='${CUR_MONTH}' AND day='${CUR_DAY}'

- AND SUBSTRING_INDEX(path, '/', 2) in ('/warehouse', '/tmp')

- GROUP BY SUBSTRING_INDEX(path, '/', 4),SUBSTRING_INDEX(path, '/', 2)

- UNION

- SELECT

- SUBSTRING_INDEX(path, '/', 5) AS path,

- COUNT(1) as total_num,

- SUBSTRING_INDEX(path, '/', 3) AS root_path

- FROM

- dataplatform.fsimage

- WHERE

- file_size < 1048576

- AND month='${CUR_MONTH}' AND day='${CUR_DAY}'

- AND SUBSTRING_INDEX(path, '/', 3) = '/gobblin/source'

- GROUP BY SUBSTRING_INDEX(path, '/', 5),SUBSTRING_INDEX(path, '/', 3)

- ) a

dataplatform.fsimage建表语句

- CREATE TABLE `fsimage`(

- `path` string,

- `block_num` int,

- `create_time` string,

- `update_time` string,

- `block_size` bigint,

- `unknown1` int,

- `file_size` bigint,

- `unknown2` int,

- `unknown3` int,

- `permission` string,

- `user` string,

- `group` string)

- PARTITIONED BY (

- `month` string,

- `day` string)

- ROW FORMAT SERDE

- 'org.apache.hadoop.hive.serde2.lazy.LazySimpleSerDe'

- WITH SERDEPROPERTIES (

- 'field.delim'='\t',

- 'serialization.format'='\t')

- STORED AS INPUTFORMAT

- 'org.apache.hadoop.mapred.TextInputFormat'

- OUTPUTFORMAT

- 'org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat'

- LOCATION

- 'hdfs://emr-cluster/warehouse/dataplatform.db/fsimage'

dataplatform.small_file_report_day建表语句:

- CREATE TABLE `dataplatform.small_file_report_day`(

- `path` string,

- `total_num` bigint)

- PARTITIONED BY (

- `month` string,

- `day` string)

- ROW FORMAT SERDE

- 'org.apache.hadoop.hive.ql.io.parquet.serde.ParquetHiveSerDe'

- STORED AS INPUTFORMAT

- 'org.apache.hadoop.hive.ql.io.parquet.MapredParquetInputFormat'

- OUTPUTFORMAT

- 'org.apache.hadoop.hive.ql.io.parquet.MapredParquetOutputFormat'

- LOCATION

- 'hdfs://emr-cluster/warehouse/dataplatform.db/small_file_report_day'

- TBLPROPERTIES

- 'parquet.compression'='SNAPPY'

【大数据】SmallFile-Analysis-Script的更多相关文章

- 杂记- 3W互联网的圈子,大数据敏捷BI与微软BI的前端痛点

开篇介绍 上周末参加了一次永洪科技在中关村 3W 咖啡举行的一次线下沙龙活动 - 关于它们的产品大数据敏捷 BI 工具的介绍.由此活动,我想到了三个话题 - 3W 互联网的圈子,永洪科技的大数据敏捷 ...

- 一篇文章看懂TPCx-BB(大数据基准测试工具)源码

TPCx-BB是大数据基准测试工具,它通过模拟零售商的30个应用场景,执行30个查询来衡量基于Hadoop的大数据系统的包括硬件和软件的性能.其中一些场景还用到了机器学习算法(聚类.线性回归等).为了 ...

- PayPal高级工程总监:读完这100篇论文 就能成大数据高手(附论文下载)

100 open source Big Data architecture papers for data professionals. 读完这100篇论文 就能成大数据高手 作者 白宁超 2016年 ...

- jquery.datatable.js与CI整合 异步加载(大数据量处理)

http://blog.csdn.net/kingsix7/article/details/38928685 1.CI 控制器添加方法 $this->show_fields_array=arra ...

- Azure HDInsight 和 Spark 大数据实战(一)

What is HDInsight? Microsoft Azure HDInsight 是基于 Hortonoworks Data Platform (HDP) 的 Hadoop 集群,包括Stor ...

- Ambari——大数据平台的搭建利器

转载自http://www.ibm.com/developerworks/cn/opensource/os-cn-bigdata-ambari/ 扩展 Ambari 管理一个自定义的 Service ...

- (原创)大数据时代:基于微软案例数据库数据挖掘知识点总结(Microsoft 决策树分析算法)

随着大数据时代的到来,数据挖掘的重要性就变得显而易见,几种作为最低层的简单的数据挖掘算法,现在利用微软数据案例库做一个简要总结. 应用场景介绍 其实数据挖掘应用的场景无处不在,很多的环境都会应用到数据 ...

- WebService - 怎样提高WebService性能 大数据量网络传输处理

直接返回DataSet对象 返回DataSet对象用Binary序列化后的字节数组 返回DataSetSurrogate对象用Binary序列化后的字节数组 返回DataSetSurrogate对象用 ...

- 爱上MVC3~MVC+ZTree大数据异步树加载

回到目录 理论部分: MVC+ZTree:指在.net MVC环境下进行开发,ZTree是一个jquery的树插件 大数据:一般我们系统中,有一些表结构属于树型的,如分类,地域,菜单,网站导航等等,而 ...

- PayPal 高级工程总监:读完这 100 篇文献,就能成大数据高手

原文地址 开源(Open Source)对大数据影响,有二:一方面,在大数据技术变革之路上,开源在众人之力和众人之智推动下,摧枯拉朽,吐故纳新,扮演着非常重要的推动作用:另一方面,开源也给大数据技术构 ...

随机推荐

- 在过滤器中获取在web.xml配置的初始化参数

在过滤器中获取在web.xml配置的初始化参数 例如 <filter> <filter-name>cross-origin</filter-name> < ...

- SringCloud学习成长之路 八 消息总线

Spring Cloud Bus 将分布式的节点用轻量的消息代理连接起来.它可以用于广播配置文件的更改或者服务之间的通讯,也可以用于监控.本文要讲述的是用Spring Cloud Bus实现通知微服务 ...

- django模板---过滤器

过滤器 通过django的过滤器可以在无须编码的情况下完成一些基本工作,比如字母的大小写转换.日期转换.获取字符串的长度.过滤器要放到标签的标识符后面,中间用竖杠(|)分隔, 如下面的过滤器把name ...

- js动态改变iframe的高度

js动态改变iframe的高度的写法 〈iframe id="docDetail" width="100%" height="200" ...

- 【CUDA开发】论CUDA和LAV解码器是否真的实用

先说配置,我电脑E3V3+GTX780TI视频就一个普通的720P AVC1编码MP4视频,实时检测软件是CPU-Z和GPU-Z,AIDA64[全默认设置]全部用ptoplayer默认播放时候,播放3 ...

- tab页签

<div class="fl" id="newsBox"> <div class="tab1 grayBar"> & ...

- python-继承之多继承

class BaseRequest(): pass class RequestHandler(BaseRequest): def serve_forever(self): print('Request ...

- zookeeper 操作命令

简介 查阅了网上相关资料,介绍zookeeper客户端命令并不是非常全面,大多数都是简单介绍ls.get.set.delete.stat这几个简单命令的,下面我把help中的所有命令简单介绍一下以供参 ...

- Redis 常用命令学习三:哈希类型命令

1.赋值与取值命令 127.0.0.1:6379> hset stu name qiao (integer) 1 127.0.0.1:6379> hset stu sex man (int ...

- PAT甲级 树 相关题_C++题解

树 目录 <算法笔记>重点摘要 1004 Counting Leaves (30) 1053 Path of Equal Weight (30) 1079 Total Sales of S ...