python urllib应用

urlopen 爬取网页

爬取网页

read() 读取内容

read() , readline() ,readlines() , fileno() , close() :这些方法的使用方式与文件对象完全一样

ret = request.urlopen("http://www.baidu.com")

print(ret.read()) #read() 读取网页

urlretrieve 写入文件

直接 将你要爬取得 网页 写到本地

import urllib.request

ret = urllib.request.urlretrieve("url地址","保存的路径地址")

urlcleanup 清除缓存

清除 request.urlretrieve 产生的缓存

print(request.urlcleanup())

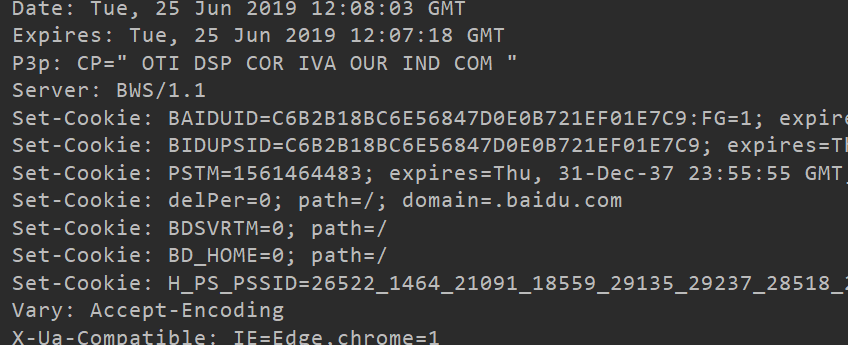

info 显示请求信息

info 返回一个httplib.HTTPMessage对象,表示远程服务器返回的头信息

ret = request.urlopen("http://www.baidu.com")

print(ret.info())

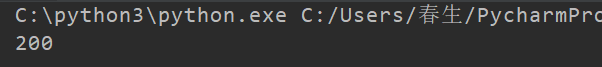

etcode 获取状态码

ret = request.urlopen("http://www.baidu.com")

print(ret.getcode()) # 返回200 就是 正常

geturl 获取当前正在爬取的网址

ret = request.urlopen("http://www.baidu.com")

print(ret.geturl)

超时设置

timeout 是以秒来计算的

ret = request.urlopen("http://www.baidu.com",timeout="设置你的超时时间")

print(ret.read())

模拟get 请求

from urllib import request

name = "python" # 你要搜索的 内容

url = "http://www.baidu.com/s?wd=%s"%name

ret_url = request.Request(url) # 发送请求

ret = request.urlopen(url)

print(ret.read().decode("utf-8"))

print(ret.geturl())

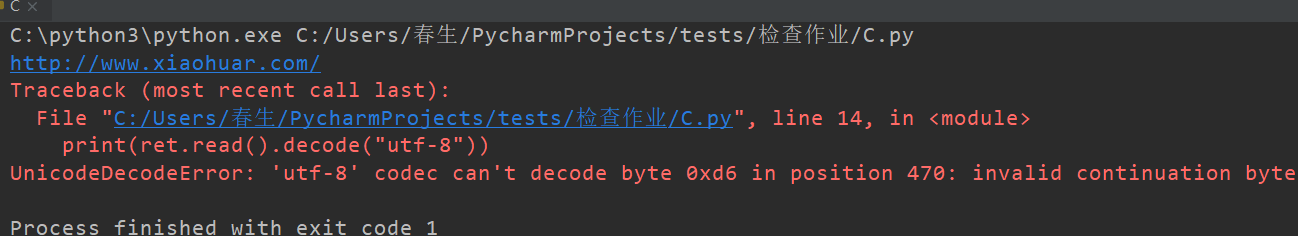

解决中文问题 request.quote

from urllib import request

name = "春生" # 你要搜索的 内容

url = "http://www.baidu.com/s?wd=%s"%name

ret_url = request.Request(url) # 发送请求

ret = request.urlopen(url)

print(ret.read().decode("utf-8"))

print(ret.geturl())

解决 request.quote

name = "春生" # 你要搜索的 内容

name = request.quote(name) # 解决中文问题

url = "http://www.baidu.com/s?wd=%s"%name

ret_url = request.Request(url) # 发送请求

ret = request.urlopen(url)

print(ret.read().decode("utf-8"))

模拟post 请求

from urllib import request, parse

url = "https://www.iqianyue.com/mypost"

mydata = parse.urlencode({

"name":"哈哈",

"pass":"123"

}).encode("utf-8")

ret_url = request.Request(url, mydata) # 发送请求

ret = request.urlopen(ret_url) # 爬取网页

print(ret.geturl()) # 打印当前爬取的url

print(ret.read().decode("utf-8"))

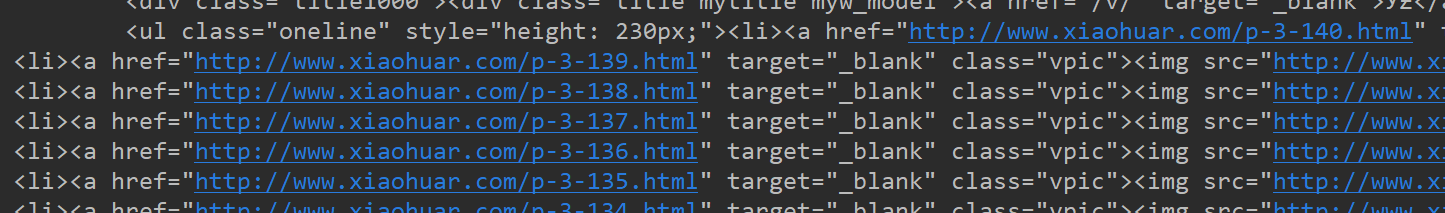

模拟浏览器 发送请求头

request.Request(url, headers=headers) 加上请求头 模拟浏览器

from urllib import request, parse

url = "http://www.xiaohuar.com/"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/75.0.3770.100 Safari/537.36"

}

ret_url = request.Request(url, headers=headers) # 发送请求

ret = request.urlopen(ret_url)

print(ret.geturl())

print(ret.read().decode("gbk"))

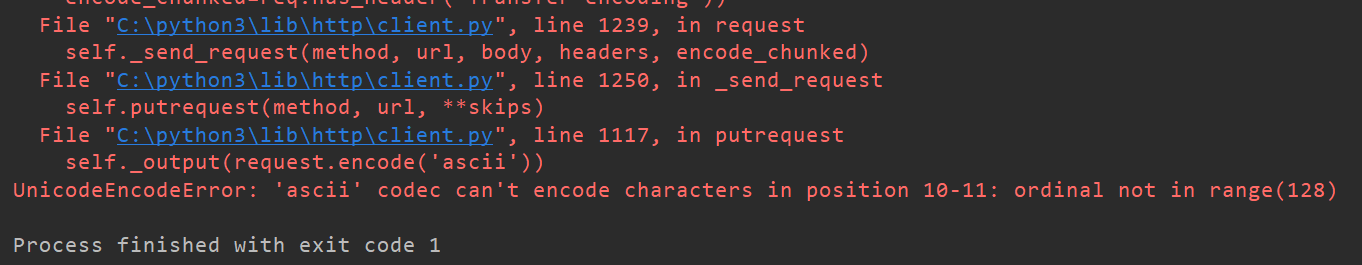

编码出现错误 报错 解决方式

出线的问题

from urllib import request, parse

url = "http://www.xiaohuar.com/"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/75.0.3770.100 Safari/537.36"

}

ret_url = request.Request(url, headers=headers) # 发送请求

ret = request.urlopen(ret_url)

print(ret.geturl())

print(ret.read().decode("utf-8"))

解决问题

decode("utf-8","ignore")

加上 "ignore" 就可以忽略掉

from urllib import request, parse

url = "http://www.xiaohuar.com/"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/75.0.3770.100 Safari/537.36"

}

ret_url = request.Request(url, headers=headers) # 发送请求

ret = request.urlopen(ret_url)

print(ret.geturl())

print(ret.read().decode("utf-8","ignore"))

python urllib应用的更多相关文章

- python urllib模块的urlopen()的使用方法及实例

Python urllib 库提供了一个从指定的 URL 地址获取网页数据,然后对其进行分析处理,获取想要的数据. 一.urllib模块urlopen()函数: urlopen(url, data=N ...

- Python:urllib和urllib2的区别(转)

原文链接:http://www.cnblogs.com/yuxc/ 作为一个Python菜鸟,之前一直懵懂于urllib和urllib2,以为2是1的升级版.今天看到老外写的一篇<Python: ...

- Python urllib和urllib2模块学习(一)

(参考资料:现代魔法学院 http://www.nowamagic.net/academy/detail/1302803) Python标准库中有许多实用的工具类,但是在具体使用时,标准库文档上对使用 ...

- python urllib和urllib2 区别

python有一个基础的库叫httplib.httplib实现了HTTP和HTTPS的客户端协议,一般不直接使用,在python更高层的封装模块中(urllib,urllib2)使用了它的http实现 ...

- Python urllib urlretrieve函数解析

Python urllib urlretrieve函数解析 利用urllib.request.urlretrieve函数下载文件 觉得有用的话,欢迎一起讨论相互学习~Follow Me 参考文献 Ur ...

- python+urllib+beautifulSoup实现一个简单的爬虫

urllib是python3.x中提供的一系列操作的URL的库,它可以轻松的模拟用户使用浏览器访问网页. Beautiful Soup 是一个可以从HTML或XML文件中提取数据的Python库.它能 ...

- HTTP Header Injection in Python urllib

catalogue . Overview . The urllib Bug . Attack Scenarios . 其他场景 . 防护/缓解手段 1. Overview Python's built ...

- python urllib urllib2

区别 1) urllib2可以接受一个Request类的实例来设置URL请求的headers,urllib仅可以接受URL.这意味着,用urllib时不可以伪装User Agent字符串等. 2) u ...

- python urllib基础学习

# -*- coding: utf-8 -*- # python:2.x __author__ = 'Administrator' #使用python创建一个简单的WEB客户端 import urll ...

- python urllib模块

1.urllib.urlopen(url[,data[,proxies]]) urllib.urlopen(url[, data[, proxies]]) :创建一个表示远程url的类文件对象,然后像 ...

随机推荐

- RabbitMQ 入门教程(PHP版) 第三部分:发布/订阅(Publish/Subscribe)

发布/订阅 在上篇第二部分教程中,我们搭建了一个工作队列.每个任务之分发给一个工作者(worker).在本篇教程中,我们要做的之前完全不一样——分发一个消息给多个消费者(consumers).这种模式 ...

- matlab基本数据结构struct

一起来学演化计算-matlab基本数据结构struct 觉得有用的话,欢迎一起讨论相互学习~Follow Me 参考文献 http://blog.sina.com.cn/s/blog_46865140 ...

- 二、部署DHCP

*本文转自https://blog.51cto.com/lumay0526/2046957 简述 DHCP是Dynamic Host Configuration Protocol的缩写,中文称动态主机 ...

- MATLAB 提取图片中的曲线数据重新画图

注意: 本代码是由[MATLAB R2015b win 32位]编写. 先上代码: %% 清空变量 clear all; clc; %% 取点之后趋势是对的,也就是点与点之间的比例是对的,但是每个点的 ...

- Git使用总结(二):分支管理

1.创建分支 a.直接创建 git branch dev(分支名) b.基于某个历史版本创建分支 git branch dev HEAD 2.查看分支 git branch -av 3.删除分支 gi ...

- Pygame01之游戏开发

一.Pygame库 Pygame是一个利用SDL库写的游戏库,SDL库全名:Simple DirectMedia Layer,据说是SamLantinga写的大牛写的为了让Loki(公司)更好的向li ...

- python检测当前端口是否使用

基于python检测端口是否在使用 - 缘起花渊 - 博客园https://www.cnblogs.com/yqmcu/p/9804002.html def net_is_used(port,ip=' ...

- jwt单点登入

主要有以下三步: 项目一开始我先封装了一个JWTHelper工具包(GitHub下载),主要提供了生成JWT.解析JWT以及校验JWT的方法,其他还有一些加密相关操作.工具包写好后我将打包上传到私 ...

- 两个gif图片动画效果

<div className="uploading-animation-tip-wrap"> <img src={require('~/shared/assets ...

- NIO堆外内存与零拷贝

重点: 1.0拷贝需要系统支持. 普通内存模型: java线程内存 --> 操作系统内存 --> 硬盘 直接内存模型: java --> 操作系统内存 --> 硬盘 两者对比, ...