【Hadoop学习之十】MapReduce案例分析二-好友推荐

环境

虚拟机:VMware 10

Linux版本:CentOS-6.5-x86_64

客户端:Xshell4

FTP:Xftp4

jdk8

hadoop-3.1.1

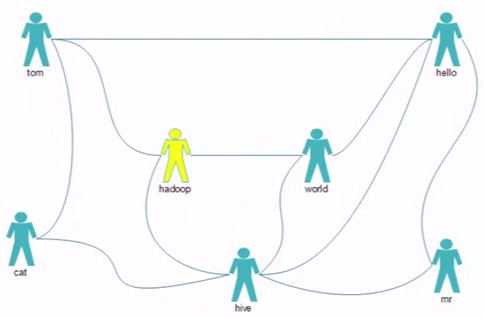

最应该推荐的好友TopN,如何排名?

tom hello hadoop cat

world hadoop hello hive

cat tom hive

mr hive hello

hive cat hadoop world hello mr

hadoop tom hive world

hello tom world hive mr

package test.mr.fof; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

import org.apache.hadoop.util.GenericOptionsParser; public class MyFOF { /**

* 最应该推荐的好友TopN,如何排名? * @param args

* @throws Exception

*/

public static void main(String[] args) throws Exception { Configuration conf = new Configuration(true);

String[] otherArgs = new GenericOptionsParser(conf, args).getRemainingArgs();

conf.set("sleep", otherArgs[2]); Job job = Job.getInstance(conf,"FOF");

job.setJarByClass(MyFOF.class); //Map

job.setMapperClass(FMapper.class);

job.setMapOutputKeyClass(Text.class);

job.setMapOutputValueClass(IntWritable.class); //Reduce

job.setReducerClass(FReducer.class); //HDFS 输入路径

Path input = new Path(otherArgs[0]);

FileInputFormat.addInputPath(job, input );

//HDFS 输出路径

Path output = new Path(otherArgs[1]);

if(output.getFileSystem(conf).exists(output)){

output.getFileSystem(conf).delete(output,true);

}

FileOutputFormat.setOutputPath(job, output ); System.exit(job.waitForCompletion(true) ? 0 :1);

}

// tom hello hadoop cat

// world hadoop hello hive

// cat tom hive

// mr hive hello

// hive cat hadoop world hello mr

// hadoop tom hive world

// hello tom world hive mr }

package test.mr.fof; import java.io.IOException; import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.util.StringUtils; public class FMapper extends Mapper<LongWritable, Text, Text, IntWritable>{ Text mkey= new Text();

IntWritable mval = new IntWritable(); @Override

protected void map(LongWritable key, Text value,Context context)

throws IOException, InterruptedException { //value: 0-直接关系 1-间接关系

//tom hello hadoop cat : hello:hello 1

//hello tom world hive mr hello:hello 0 String[] strs = StringUtils.split(value.toString(), ' '); String user=strs[0];

String user01=null;

for(int i=1;i<strs.length;i++){

//与好友清单中好友属于直接关系

mkey.set(fof(strs[0],strs[i]));

mval.set(0);

context.write(mkey, mval); for (int j = i+1; j < strs.length; j++) {

Thread.sleep(context.getConfiguration().getInt("sleep", 0));

//好友列表内 成员之间是间接关系

mkey.set(fof(strs[i],strs[j]));

mval.set(1);

context.write(mkey, mval);

}

}

} public static String fof(String str1 , String str2){ if(str1.compareTo(str2) > 0){

//hello,hadoop

return str2+":"+str1;

}

//hadoop,hello

return str1+":"+str2;

} }

package test.mr.fof; import java.io.IOException; import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Reducer; public class FReducer extends Reducer<Text, IntWritable, Text, Text> { Text rval = new Text();

@Override

protected void reduce(Text key, Iterable<IntWritable> vals, Context context)

throws IOException, InterruptedException

{

//是简单的好友列表的差集吗?

//最应该推荐的好友TopN,如何排名? //hadoop:hello 1

//hadoop:hello 0

//hadoop:hello 1

//hadoop:hello 1

int sum=0;

int flg=0;

for (IntWritable v : vals)

{

//0为直接关系

if(v.get()==0){

//hadoop:hello 0

flg=1;

}

sum += v.get();

} //只有间接关系才会被输出

if(flg==0){

rval.set(sum+"");

context.write(key, rval);

}

}

}

【Hadoop学习之十】MapReduce案例分析二-好友推荐的更多相关文章

- MapReduce深度分析(二)

MapReduce深度分析(二) 五.JobTracker分析 JobTracker是hadoop的重要的后台守护进程之一,主要的功能是管理任务调度.管理TaskTracker.监控作业执行.运行作业 ...

- Hadoop学习笔记—20.网站日志分析项目案例(二)数据清洗

网站日志分析项目案例(一)项目介绍:http://www.cnblogs.com/edisonchou/p/4449082.html 网站日志分析项目案例(二)数据清洗:当前页面 网站日志分析项目案例 ...

- 【Hadoop学习之十三】MapReduce案例分析五-ItemCF

环境 虚拟机:VMware 10 Linux版本:CentOS-6.5-x86_64 客户端:Xshell4 FTP:Xftp4 jdk8 hadoop-3.1.1 推荐系统——协同过滤(Collab ...

- Hadoop学习笔记—20.网站日志分析项目案例(一)项目介绍

网站日志分析项目案例(一)项目介绍:当前页面 网站日志分析项目案例(二)数据清洗:http://www.cnblogs.com/edisonchou/p/4458219.html 网站日志分析项目案例 ...

- Hadoop学习笔记—20.网站日志分析项目案例(三)统计分析

网站日志分析项目案例(一)项目介绍:http://www.cnblogs.com/edisonchou/p/4449082.html 网站日志分析项目案例(二)数据清洗:http://www.cnbl ...

- [b0012] Hadoop 版hello word mapreduce wordcount 运行(二)

目的: 学习Hadoop mapreduce 开发环境eclipse windows下的搭建 环境: Winows 7 64 eclipse 直接连接hadoop运行的环境已经搭建好,结果输出到ecl ...

- 【第二课】kaggle案例分析二

Evernote Export 推荐系统比赛(常见比赛) 推荐系统分类 最能变现的机器学习应用 基于应用领域分类:电子商务推荐,社交好友推荐,搜索引擎推荐,信息内容推荐等 **基于设计思想:**基于协 ...

- 【Hadoop学习之十二】MapReduce案例分析四-TF-IDF

环境 虚拟机:VMware 10 Linux版本:CentOS-6.5-x86_64 客户端:Xshell4 FTP:Xftp4 jdk8 hadoop-3.1.1 概念TF-IDF(term fre ...

- 【Hadoop学习之九】MapReduce案例分析一-天气

环境 虚拟机:VMware 10 Linux版本:CentOS-6.5-x86_64 客户端:Xshell4 FTP:Xftp4 jdk8 hadoop-3.1.1 找出每个月气温最高的2天 1949 ...

随机推荐

- wordpress 无法发送邮件

前几天创建了几个wordpress项目,有些项目中用到了用户注册,但是在实际操作中发现,用户注册无法接收到认证链接,在查找了相关资料后大多归类为几个原因: 服务器本身不支持mail()函数 未配置相关 ...

- MySQL大表DROP删除小技巧(转)

在日常工作中,经常会遇到历史大表从主库上迁移到备份机,以便腾出主库空间,那么如果你直接drop table 后,可能会引起数据库抖动,连接数升高等问题,从而影响业务. 那么用一个小技巧,即可轻松平滑的 ...

- JS中函数表达式与函数声明的区别

hello,沐晴又来更新啦,今天呢,跟大家讲讲让人头疼的函数表达式和函数声明,反正我当初看那本高级程序的时候,是没怎么看太透,哈哈.我是个比较重基础的人,跟我一起探讨函数表达式和函数声明的世界吧. 首 ...

- 【BFS宽度优先搜索】

一.求所有顶点到s顶点的最小步数 //BFS宽度优先搜索 #include<iostream> using namespace std; #include<queue> # ...

- 【PCA】周志华

一.书籍

- oralce 批量更新

<update id="batchUpdateCompensatoryData" parameterType="java.util.List"> & ...

- PHP 操作 Redis 的手册

转:https://www.cnblogs.com/jackluo/p/5708024.html String 类型操作 string是redis最基本的类型,而且string类型是二进制安全的.意思 ...

- pandas官方文档阅读收获

1.当心它里面的简写: 第二张图中的输出实际上是等效于: df = df.drop() df 若只进行下面的操作,则drop操作不会起作用,因为它的inplace默认为False: df.drop() ...

- Centos7限速和测速

限速 wondershaper是国外人开发的一款在Linux内核下基于TC工具的对整块网卡的限度工具. 第一种安装方法 首先下载wondershaper的rpm安装包:wondershaper-1.1 ...

- 【LeetCode每天一题】Pascal's Triangle(杨辉三角)

Given a non-negative integer numRows, generate the first numRows of Pascal's triangle. In Pascal's t ...