python 3 爬取某小说网站小说,注释详细

目标:每一个小说保存成一个txt文件

思路:获取每个小说地址(图一),进入后获取每章节地址(图二),然后进入获取该章节内容(图三)保存文件中。循环

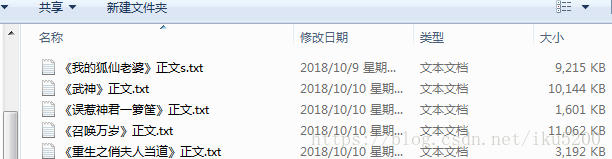

效果图:

每一行都有注释,不多解释了

import requestsfrom bs4 import BeautifulSoupimport osif __name__ == '__main__':# 要下载的网页url = 'https://www.biqubao.com/quanben/'# 网站根网址root_url = 'https://www.biqubao.com'# 保存本地路径path = 'F:\\python\\txt'# 解析网址req = requests.get(url)# 设置编码,浏览器查看网站编码:F12,控制开输入document.characterSet回车即可查看req.encoding = 'gbk'# 获取网页所有内容soup = BeautifulSoup(req.text, 'html.parser')# 查找网页中div的id为main的标签list_tag = soup.div(id="main")# 查看div内所有里标签li = list_tag[0](['li'])# 删除第一个没用的标签del li[0]# 循环遍历for i in li:# 获取到a标签间的内容---小说类型txt_type = i.a.string# 获取a标签的href地址值---小说网址short_url = (i(['a'])[1].get('href'))# 获取第三个span标签的值---作者author = i(['span'])[3].string# 获取网页设置网页编码req = requests.get(root_url + short_url)req.encoding = 'gbk'# 解析网页soup = BeautifulSoup(req.text, "html.parser")list_tag = soup.div(id="list")# 获取小说名name = list_tag[0].dl.dt.stringprint("类型:{} 短址:{} 作者:{} 小说名:{}".format(txt_type, short_url, author, name))# 创建同名文件夹# paths = path + '\\' + nameif not os.path.exists(path):# 获取当前目录并组合新目录# os.path.join(path, name)os.mkdir(path)# 循环所有的dd标签for dd_tag in list_tag[0].dl.find_all('dd'):# 章节名zjName = dd_tag.string# 章节地址zjUrl = root_url + dd_tag.a.get('href')# 访问网址爬取章节内容req2 = requests.get(zjUrl)req2.encoding = 'gbk'zj_soup = BeautifulSoup(req2.text, "html.parser")content_tag = zj_soup.div.find(id="content")# 把空格内容替换成换行text = str(content_tag.text.replace('\xa0', '\n'))text.replace('\ufffd', '\n')# 写入文件操作'a'追加with open(path + "\\" + name + ".txt", 'a') as f:f.write('\n' + '\n' + zjName)f.write(text)print("{}------->写入完毕".format(zjName))

python 3 爬取某小说网站小说,注释详细的更多相关文章

- Python轻松爬取Rosimm写真网站全部图片

RosimmImage 爬取Rosimm写真网站图片 有图有真相 def main_start(url): """ 爬虫入口,主要爬取操作 ""&qu ...

- Python爬虫爬取美剧网站

一直有爱看美剧的习惯,一方面锻炼一下英语听力,一方面打发一下时间.之前是能在视频网站上面在线看的,可是自从广电总局的限制令之后,进口的美剧英剧等貌似就不在像以前一样同步更新了.但是,作为一个宅diao ...

- Python——Scrapy爬取链家网站所有房源信息

用scrapy爬取链家全国以上房源分类的信息: 路径: items.py # -*- coding: utf-8 -*- # Define here the models for your scrap ...

- python爬虫爬取ip记录网站信息并存入数据库

import requests import re import pymysql #10页 仔细观察路由 db = pymysql.connect("localhost",&quo ...

- Python爬虫爬取全书网小说,程序源码+程序详细分析

Python爬虫爬取全书网小说教程 第一步:打开谷歌浏览器,搜索全书网,然后再点击你想下载的小说,进入图一页面后点击F12选择Network,如果没有内容按F5刷新一下 点击Network之后出现如下 ...

- Jsoup-基于Java实现网络爬虫-爬取笔趣阁小说

注意!仅供学习交流使用,请勿用在歪门邪道的地方!技术只是工具!关键在于用途! 今天接触了一款有意思的框架,作用是网络爬虫,他可以像操作JS一样对网页内容进行提取 初体验Jsoup <!-- Ma ...

- bs4爬取笔趣阁小说

参考链接:https://www.cnblogs.com/wt714/p/11963497.html 模块:requests,bs4,queue,sys,time 步骤:给出URL--> 访问U ...

- Python 爬取所有51VOA网站的Learn a words文本及mp3音频

Python 爬取所有51VOA网站的Learn a words文本及mp3音频 #!/usr/bin/env python # -*- coding: utf-8 -*- #Python 爬取所有5 ...

- Python开发爬虫之BeautifulSoup解析网页篇:爬取安居客网站上北京二手房数据

目标:爬取安居客网站上前10页北京二手房的数据,包括二手房源的名称.价格.几室几厅.大小.建造年份.联系人.地址.标签等. 网址为:https://beijing.anjuke.com/sale/ B ...

- python爬虫学习之使用BeautifulSoup库爬取开奖网站信息-模块化

实例需求:运用python语言爬取http://kaijiang.zhcw.com/zhcw/html/ssq/list_1.html这个开奖网站所有的信息,并且保存为txt文件和excel文件. 实 ...

随机推荐

- kafka partition(分区)与 group

kafka partition(分区)与 group 一. 1.原理图 2.原理描述 一个topic 可以配置几个partition,produce发送的消息分发到不同的partition中,co ...

- HDU 5984(求木棒切割期望 数学)

题意是给定一长为 L 的木棒,每次任意切去一部分直到剩余部分的长度不超过 D,求切割次数的期望. 若木棒初始长度不超过 D,则期望是 0.000000: 设切割长度为 X 的木棒切割次数的期望是 F( ...

- NOI-OJ 1.13 ID:5 素数回文数的个数

整体思路 使用埃拉拖色尼算法提前计算出1000以内的素数表. 设计一个回文判断函数isHW(int n),难点在于数字回文的判断.一个简单的方法是将数字n使用sprintf输出在一个数组中,然后从数组 ...

- WPF中的常用布局

一 写在开头1.1 写在开头评价一门技术的好坏得看具体的需求,没有哪门技术是面面俱到地好. 1.2 本文内容本文主要内容为WPF中的常用布局,大部分内容转载至https://blog.csdn.net ...

- django - 总结 - cnblog

1.头像预览 -------方法1-------- 点击头像------>点击input img和input重合; img在label,input-->display:none $(&qu ...

- 四十四、Linux 线程——线程同步之死锁以及线程和信号

44.1 死锁 死锁: 两个线程试图同时占有两个资源,并按不同的次序锁定相应的共享资源 解决方式: 按相同的次序锁定相应的共享资源 使用函数 pthread_mutex_trylock(),它是函数 ...

- Linux中执行C++程序

参考:https://blog.csdn.net/qq_31125955/article/details/79343498 https://blog.csdn.net/weixin_35477207/ ...

- 4.Centos7安装JDK8以及环境配置

1.下载 linux 版本 jdk (jdk-8u11-linux-x64.tar.gz) 一定要是 .tar.gz 版本,可以去我的百度网盘下载或者在百度上面找 2.新建文件夹命令:mkdir /u ...

- thymeleaf时间格式化

Thymeleaf模板时间格式表达式 ${#dates.format(date, 'dd/MMM/yyyy HH:mm')} 例如: <input name="enroDate ...

- 对OAuth协议的认识

一. OAuth是什么 OAuth 是Open Authorization的简写.OAuth 协议为用户资源的授权提供了一个安全的.开放而又简易的标准. 通俗地说,就是当我们想把自己系统的某些功能暴露 ...