使用Spark进行搜狗日志分析实例——列出搜索不同关键词超过10个的用户及其搜索的关键词

- package sogolog

- import org.apache.hadoop.io.{LongWritable, Text}

- import org.apache.hadoop.mapred.TextInputFormat

- import org.apache.spark.rdd.RDD

- import org.apache.spark.{SparkConf, SparkContext}

- class RddFile {

- def readFileToRdd(path: String): RDD[String] = {

- val conf = new SparkConf().setMaster("local").setAppName("sougoDemo")

- val sc = new SparkContext(conf);

- //使用这种方法能够避免中文乱码

- sc.hadoopFile("J:\\scala\\workspace\\first-spark-demo\\sougofile\\SogouQ.reduced",classOf[TextInputFormat], classOf[LongWritable], classOf[Text]).map{

- pair => new String(pair._2.getBytes, 0, pair._2.getLength, "GBK")}

- }

- }

- package sogolog

- import org.apache.spark.rdd.RDD

- /**

- * 列出搜索不同关键词超过3个的用户及其搜索的关键词

- */

- object userSearchKeyWordLT3 {

- def main(args: Array[String]): Unit = {

- //1、读入文件

- val textFile = new RddFile().readFileToRdd("J:\\scala\\workspace\\first-spark-demo\\sougofile\\SogouQ.reduced")

- //2、map操作,将每行的用户、关键词读入新的RDD中

- val userKeyWordTuple:RDD[(String,String)] = textFile.map(line=>{

- val arr = line.split("\t")

- (arr(1),arr(2))

- })

- //3、reduce操作,将相同用户的关键词进行合并

- val userKeyWordReduced = userKeyWordTuple.reduceByKey((x,y)=>{

- //去重

- if(x.contains(y)){

- x

- }else{

- x+","+y

- }

- })

- //4、使用filter进行最终过滤

- val finalResult = userKeyWordReduced.filter(x=>{

- //过滤小于10个关键词的用户

- x._2.split(",").length>=10

- })

- //5、打印出结果

- finalResult.collect().foreach(println)

- }

- }

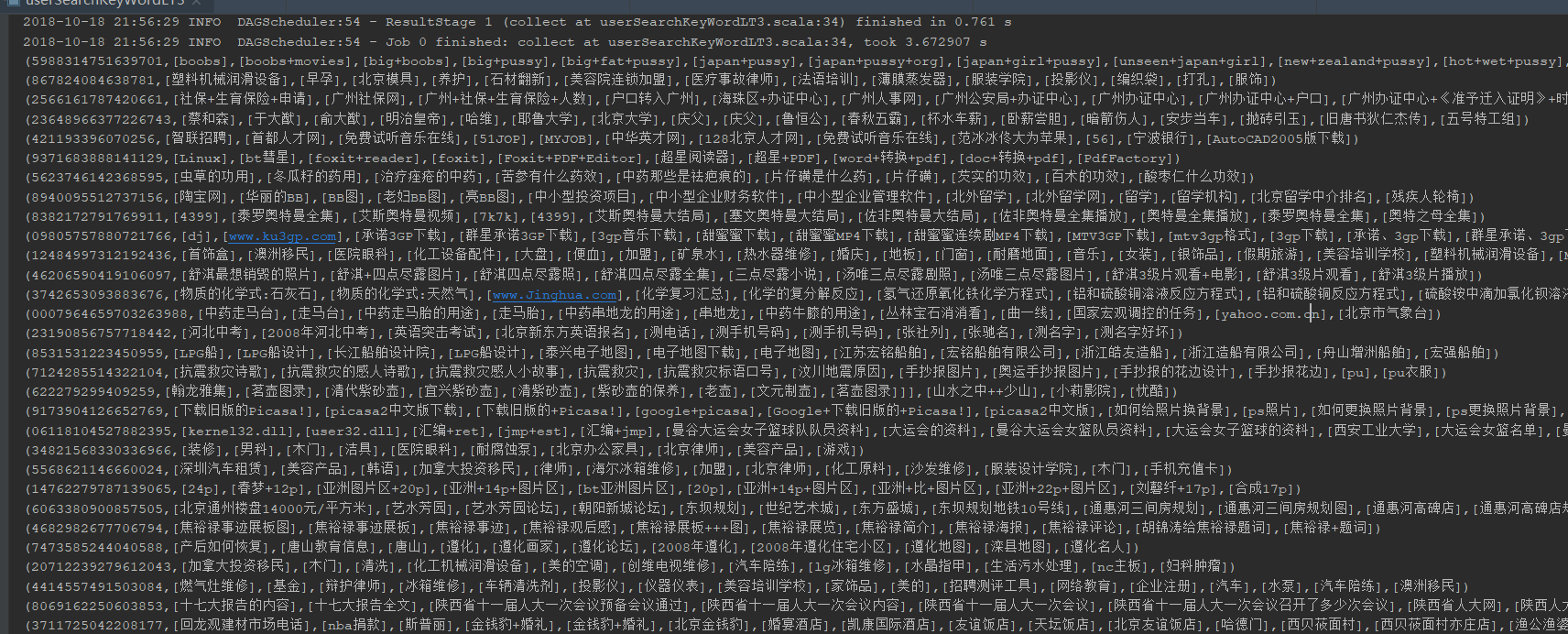

运行结果:

使用Spark进行搜狗日志分析实例——列出搜索不同关键词超过10个的用户及其搜索的关键词的更多相关文章

- 使用Spark进行搜狗日志分析实例——统计每个小时的搜索量

package sogolog import org.apache.spark.rdd.RDD import org.apache.spark.{SparkConf, SparkContext} /* ...

- 使用Spark进行搜狗日志分析实例——map join的使用

map join相对reduce join来说,可以减少在shuff阶段的网络传输,从而提高效率,所以大表与小表关联时,尽量将小表数据先用广播变量导入内存,后面各个executor都可以直接使用 pa ...

- ELK 日志分析实例

ELK 日志分析实例一.ELK-web日志分析二.ELK-MySQL 慢查询日志分析三.ELK-SSH登陆日志分析四.ELK-vsftpd 日志分析 一.ELK-web日志分析 通过logstash ...

- Spark之搜狗日志查询实战

1.下载搜狗日志文件: 地址:http://www.sogou.com/labs/resource/chkreg.php 2.利用WinSCP等工具将文件上传至集群. 3.创建文件夹,存放数据: mk ...

- 基于Spark的网站日志分析

本文只展示核心代码,完整代码见文末链接. Web Log Analysis 提取需要的log信息,包括time, traffic, ip, web address 进一步解析第一步获得的log信息,如 ...

- spark提交异常日志分析

java.lang.NoSuchMethodError: org.apache.spark.sql.SQLContext.sql(Ljava/lang/String;)Lorg/apache/spar ...

- (转载)shell日志分析常用命令

shell日志分析常用命令总结 时间:2016-03-09 15:55:29来源:网络 导读:shell日志分析的常用命令,用于日志分析的shell脚本,统计日志中百度蜘蛛的抓取量.抓取最多的页面.抓 ...

- Spark RDD/Core 编程 API入门系列之动手实战和调试Spark文件操作、动手实战操作搜狗日志文件、搜狗日志文件深入实战(二)

1.动手实战和调试Spark文件操作 这里,我以指定executor-memory参数的方式,启动spark-shell. 启动hadoop集群 spark@SparkSingleNode:/usr/ ...

- [spark案例学习] WEB日志分析

数据准备 数据下载:美国宇航局肯尼迪航天中心WEB日志 我们先来看看数据:首先将日志加载到RDD,并显示出前20行(默认). import sys import os log_file_path =' ...

随机推荐

- appium-android 遇到swipe函数无法使用的问题及解决办法

问题:cannot resolve method swipe() 问题出现原因:File->Project Structure->Modules->Dependencies-> ...

- Latex 仅使用 hyperref 包中 \href 的方法

参考: How to ask hyperref works only with href Latex 仅使用 hyperref 包中 \href 的方法 在 .tex 文件的开头使用如下方法引用 hy ...

- 访问github慢的解决方案

问题描述 打开https://github.com很慢. 解决办法 1.打开文件C:\Windows\System32\drivers\etc\hosts 2.添加如下内容: 151.101.44.2 ...

- yaf框架在windows上的环境配置和安装

1.首先检测你的php版本 如图:Architecture:×86和thread Safety:disabled 这个有什么用呢? 2.进入这个网站 tgz是linux下的扩展包,windows下点D ...

- Python3学习笔记--迭代器

迭代 使用一个循环来遍历某个东西时这个过程本身叫做迭代. 可迭代对象 python中只要定义了可以返回一个迭代器的__iter__方法,或者定义了可以支持下标索引的__getitem__方法,那么它就 ...

- web前端面试题 -- 2019最新,最全

最近在找工作,面试了好多家公司,结果都不怎么理想.要么公司环境氛围不行,要么工资达不到理想的薪资.大部分公司对程序员的面试流程几乎都一样,来了先填一份登记表,写一套面试题,然后技术面,人事面.至于有的 ...

- Postman应用笔记

Postman应用: 项目组织格式 Collections 集合--项目--根路径文件夹 文件夹 集合下只支持1级文件夹 文件夹 Request --请求 url 认证参数,头信息,体信息(Autho ...

- Django-CSRF的使用

1. 为什么要有csrf_token? 防止跨站请求伪造 2. Django中如何使用? urls.py: urlpatterns = [ # 测试跨站请求伪造 (CSRF) url(r'^csrf_ ...

- mac电脑上不能用移动硬盘的原因和方法

原因: 一般性是因为这个移动硬盘的格式是 NTFS 格式的,对于这种格式的磁盘格式,在苹果系统中却是不支持往硬盘里写入数据的 解决方法: 方法一: ntfs的格式分区,这种格式分区与我们的苹果电脑自身 ...

- React文档(二十三)Web Components

React和web components是为了解决不同问题而创立的.web components为可重用组件提供了健壮的封装,而React提供了声明式的库来保持DOM和数据同步.这两点是互相补充的.作 ...