Sqoop(三)将关系型数据库中的数据导入到HDFS(包括hive,hbase中)

一、说明:

将关系型数据库中的数据导入到 HDFS(包括 Hive, HBase) 中,如果导入的是 Hive,那么当 Hive 中没有对应表时,则自动创建。

二、操作

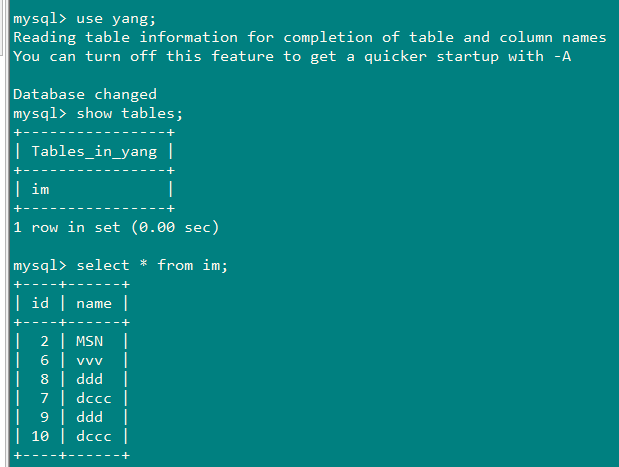

1、创建一张跟mysql中的im表一样的hive表im:

sqoop create-hive-table \

--connect jdbc:mysql://192.168.200.100:3306/yang \

--username root \

--password 010209 \

--table im \

--hive-table im

过程中报错总结:

ERROR Could not register mbeans java.security.AccessControlException: access denied

("javax.management.MBeanTrustPermission" "register

解决方法:

1、将hive-site.xml复制到${SQOOP_HOME}/conf下

2、vim $JAVA_HOME/jre/lib/security/java.policy:

在grant{}内部添加如下内容:

permission javax.management.MBeanTrustPermission "register";

Could not load org.apache.hadoop.hive.conf.HiveConf. Make sure HIVE_CONF_DIR

解决方法:

将hive 里面的lib下的hive-exec-**.jar 放到sqoop 的lib 下

2、将mysql中的数据导入到HDFS

sqoop import \

--connect jdbc:mysql://192.168.200.100:3306/yang \

--username root \

--password 010209\

--table im \

-m 1

3、将mysql中的数据导入到HDFS(按照指定分隔符和路径进行导入)

sqoop import \

--connect jdbc:mysql://192.168.200.100:3306/yang \

--username root \

--password 010209 \

--table im \

--target-dir /test/ \

--fields-terminated-by ',' \

-m 1

4、将mysql中的数据导入到HDFS(带where条件)

sqoop import \

--connect jdbc:mysql://192.168.200.100:3306/yang \

--username root \

--password 010209 \

--where "name='dccc'" \

--table im \

--target-dir /test/ \

-m 1

带where条件,查询指定列(相当于select name from im where name="dccc")

sqoop import \

--connect jdbc:mysql://192.168.200.100:3306/yang \

--username root \

--password 010209 \

--columns "name" \

--where "name='dccc'" \

--table im \

--target-dir /test/ \

-m 1

5、将mysql中的数据导入到HDFS(自定义查询SQL)

sqoop import \

--connect jdbc:mysql://192.168.200.100:3306/yang \

--username root \

--password 010209 \

--target-dir /test/ \

--query 'select id,name from im where $CONDITIONS ' \

--split-by id \

--fields-terminated-by '\t' \

-m 2

说明:

--split-by:

1.split-by 根据不同的参数类型有不同的切分方法,如int型,Sqoop会取最大和最小split-by字段值,然后根据传入的num-mappers来 确定划分几个区域。比如select max(split_by),min(split-by) from得到的max(split-by)和min(split-by)分别为1000和1,而num-mappers(-m)为2的话,则会分成两个区域 (1,500)和(501-1000),同时也会分成2个sql给2个map去进行导入操作,分别为select XXX from table where split-by>=1 and split-by<500和select XXX from table where split-by>=501 and split-by<=1000.最后每个map各自获取各自SQL中的数据进行导入工作。

2.当split-by不是int型时出现如上场景中的问题。目前想到的解决办法是:将-m 设置称1,split-by不设置,即只有一个map运行,缺点是不能并行map录入数据。(注意,当-m 设置的值大于1时,split-by必须设置字段)

3.split-by即便是int型,若不是连续有规律递增的话,各个map分配的数据是不均衡的,可能会有些map很忙,有些map几乎没有数据处理的情况

CONDITIONS:

SQoop Query imports自由查询模式下$CONDITIONS的作用:

1、必须制定目标文件的位置:--target-dir

2、必须使用$CONDITIONS关键字

3、选择使用--split-by分片(分区,结果分成多个小文件)

6、将mysql中的数据导入到Hive

sqoop import --connect jdbc:mysql://192.168.200.100:3306/yang --username root --password 010209 --table im --hive-import -m 1

7、指定分隔符和列分隔符,指定hive-import,指定覆盖导入,指定自动创建Hive表,指定表名,指定删除中间结果数据目录

sqoop import \

--connect jdbc:mysql://192.168.200.100:3306/yang \

--username root \

--password 010209 \

--table im \

--fields-terminated-by "\t" \

--lines-terminated-by "\n" \

--hive-import \

--hive-overwrite \

--create-hive-table \

--delete-target-dir \

--hive-database yang \

--hive-table im

-m 1

8、将Mysql数据库中的表数据导入到Hbase(普通导入)

sqoop import \

--connect jdbc:mysql://192.168.200.100:3306/yang \

--username root \

--password 010209 \

--table im \

--hbase-table im \

--column-family cf \

--hbase-row-key keyid

Sqoop(三)将关系型数据库中的数据导入到HDFS(包括hive,hbase中)的更多相关文章

- sqoop数据导入到Hdfs 或者hive

用java代码调用shell脚本执行sqoop将hive表中数据导出到mysql http://www.cnblogs.com/xuyou551/p/7999773.html 用sqoop将mysql ...

- 大数据入门到精通18--sqoop 导入关系库到hdfs中和hive表中

一,选择数据库,这里使用标准mysql sakila数据库 mysql -u root -D sakila -p 二.首先尝试把表中的数据导入到hdfs文件中,这样后续就可以使用spark来dataf ...

- Sqoop1.99.7将MySQL数据导入到HDFS中

准备 本示例将实现从MySQL数据库中将数据导入到HDFS中 参考文档: http://sqoop.apache.org/docs/1.99.7/user/Sqoop5MinutesDemo.html ...

- 如何使用免费控件将Word表格中的数据导入到Excel中

我通常使用MS Excel来存储和处理大量数据,但有时候经常会碰到一个问题—我需要的数据存储在word表格中,而不是在Excel中,这样处理起来非常麻烦,尤其是在数据比较庞大的时候, 这时我迫切地需要 ...

- 使用sqoop将MySQL数据库中的数据导入Hbase

使用sqoop将MySQL数据库中的数据导入Hbase 前提:安装好 sqoop.hbase. 下载jbdc驱动:mysql-connector-java-5.1.10.jar 将 mysql-con ...

- 如何将数据库中的数据导入到Solr中

要使用solr实现网站中商品搜索,需要将mysql数据库中数据在solr中创建索引. 1.需要在solr的schema.xml文件定义要存储的商品Field. 商品表中的字段为: 配置内容是: < ...

- phpexcel的写操作将数据库中的数据导入到excel中

这个版本据说是可以支持excel2007,但是我使用2007编辑的xlsx是无法获得该库的支持.于是乎我就将它转化为2003.感觉支持地很好. 下面介绍一下具体的使用: require_once('. ...

- 用ttBulkCp把excel中的数据导入到timesten数据库中

最近要做数据预处理,需要用到数据库.而且是以前从来没听说过的TimesTen. 首要目标是要把Excel里的数据,导入到TimesTen数据库中.而TimesTen在win10里用不了,于是我就在虚拟 ...

- 如何将redis中的数据导入到本地MongoDB和MySQL数据库

将redis中的数据导入到本地MongoDB数据库 创建一个process_items_mongodb.py文件(文件名自定义): #!/usr/bin/env python # -*- coding ...

随机推荐

- 转:Cookie详解

没怎么坐过客户端相关的工作,所以写爬虫的时候,很多概念都很模糊,学习起来很困难.现在想攻坚一下,所以找了一下cookies相关的内容. HTTP cookies,通常又称作"cookies& ...

- PyQt(Python+Qt)学习随笔:QListView的gridSize属性

老猿Python博文目录 专栏:使用PyQt开发图形界面Python应用 老猿Python博客地址 QListView的gridSize属性用于控制视图中数据项排列所在网格的大小,gridSize默认 ...

- PHP代码审计分段讲解(14)

30题利用提交数组绕过逻辑 本篇博客是PHP代码审计分段讲解系列题解的最后一篇,对于我这个懒癌患者来说,很多事情知易行难,坚持下去,继续学习和提高自己. 源码如下: <?php $role = ...

- Xmind Invalid Configuarton Location(the configuarton area is not writable)

今天在安装Xmind的时候,发现如下错误,原因:配置问题 步骤如下: 1.找到XMind安装目录下的文件XMind.ini2.文件中的内容替换:将:-configuration./configurat ...

- Mysql 存储过程(变量、定义条件、处理程序、光标、流程控制构造)

最近由于有同事编写了存储函数,需要进行验证,但是对存储过程一直不是很了解,所以抽时间了解了一下存储过程的基本语法.本篇文章主要包括介绍了存储过程的5个小语法:declare语句的变量.定义条件.处理程 ...

- print(end="\r") 滚动输出到屏幕

for i in range(10000): print(i, end = "\r") print(end="\r") 滚动输出到屏幕

- ORA-29701: unable to connect to Cluster Synchronization Service

修改主机名后,has无法启动,将has启动之后,尝试ASMCA,出现如图提示: 再尝试登陆asm实例,出现日下提示: [oracle@edgzrip2-+ASM ~]$ sqlplus / as sy ...

- C语言服务器编程必备常识

入门 包含了正确的头文件只能编译通过,没链接正确的库链接会报错. 一些常用的库gcc会自动链接. 库的缺省路径/lib /usr/lib /usr/local/lib 不知道某个函数在那个库可以nm ...

- js上 十九、综合案例

十九.综合案例 题目一: 封装一个函数equal(a1,a2),传入两个一维数组,判断两个数组是否包含相同的元素,如果相等,函数的返回值为true, 不相等,函数的返回值为false 1)例:arr1 ...

- fMRI数据分析学习笔记——常用工具

背景 在学习fMRI数据处理的过程中,通过其他的资料看到了别人推荐的有用的fMRI数据处理软件和小插件,在此记录一下,以便后期慢慢学习使用. 1.NeuroImaging Analysis Kit ( ...