使用 Scrapy 的 ImagesPipeline 下载图片

下载 百度贴吧-动漫壁纸吧 所有图片

定义item

Spider

spider 只需要得到图片的url,必须以列表的形式给管道处理

class PictureSpiderSpider(scrapy.Spider):

name = 'picture_spider'

allowed_domains = ['tieba.baidu.com']

start_urls = ['https://tieba.baidu.com/f?kw=%E5%8A%A8%E6%BC%AB%E5%A3%81%E7%BA%B8']

def parse(self, response):

# 贴吧中一页帖子的ID和标题

theme_urls = re.findall(r'<a rel="noreferrer" href="/p/(\d+)" title="(.*?)" target="_blank" class="j_th_tit ">',

response.text, re.S)

for theme in theme_urls:

# 帖子的url

theme_url = 'https://tieba.baidu.com/p/' + theme[0]

# 进入各个帖子

yield scrapy.Request(url=theme_url, callback=self.parse_theme)

# 贴吧下一页的url

next_url = re.findall(

r'<a href="//tieba.baidu.com/f\?kw=%E5%8A%A8%E6%BC%AB%E5%A3%81%E7%BA%B8&ie=utf-8&pn=(\d+)" class="next pagination-item " >下一页></a>',

response.text, re.S)

if next_url:

next_url = self.start_urls[0] + '&pn=' + next_url[0]

yield scrapy.Request(url=next_url)

# 下载每个帖子里的所有图片

def parse_theme(self, response):

item = PostBarItem()

# 每个贴子一页图片的缩略图的url

pic_ids = response.xpath('//img[@class="BDE_Image"]/@src').extract()

# 用列表来装图片的url

item['pic_urls'] = []

for pic_url in pic_ids:

# 取出每张图片的名称

item['pic_name'] = pic_url.split('/')[-1]

# 图片URL

url = 'http://imgsrc.baidu.com/forum/pic/item/' + item['pic_name']

# 将url添加进列表

item['pic_urls'].append(url)

# 将item交给pipelines下载

yield item

# 下完一页图片后继续下一页

next_url = response.xpath('//a[contains(text(),"下一页")]/@href').extract_first()

if next_url:

yield scrapy.Request('https://tieba.baidu.com' + next_url, callback=self.parse_theme)

ImagesPipeline

- from scrapy.pipelines.images import ImagesPipeline

- 继承ImagesPipeline,重写get_media_requests()和file_path()方法

from scrapy.pipelines.images import ImagesPipeline

import scrapy

class PostBarPipeline(ImagesPipeline):

# 需要headers的网站,再使用

headers = {

'User-Agent': '',

'Referer': '',

}

def get_media_requests(self, item, info):

for pic_url in item['pic_urls']:

# 为每个url生成一个Request

yield scrapy.Request(pic_url)

# 需要请求头的时候,添加headers参数

# yield scrapy.Request(pic_url, headers=self.headers)

def file_path(self, request, response=None, info=None):

# 重命名(包含后缀名),若不重写这函数,图片名为哈希

pic_path = request.url.split('/')[-1]

return pic_path

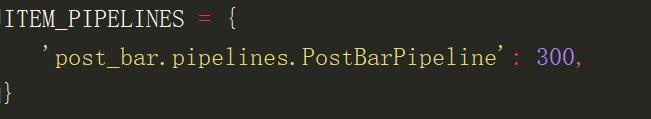

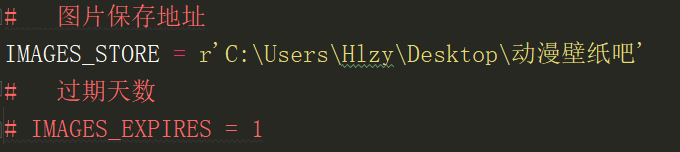

settings文件

激活管道

设置图片保存地址

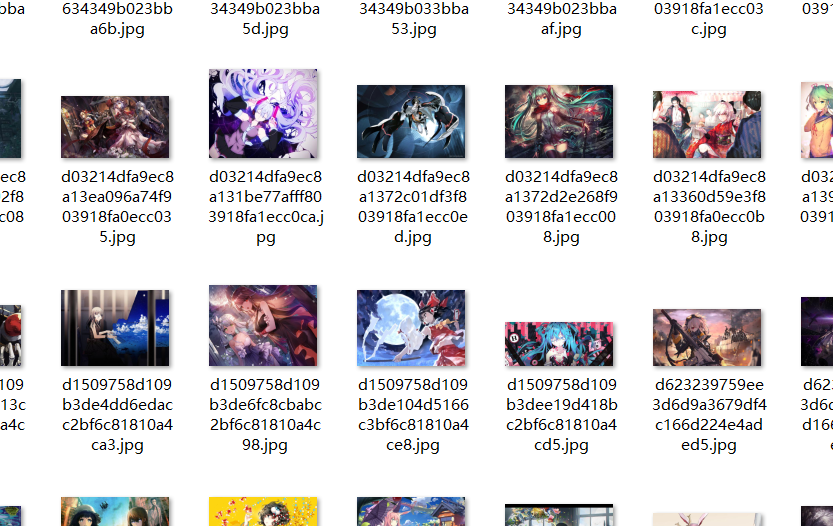

运行结果

使用 Scrapy 的 ImagesPipeline 下载图片的更多相关文章

- Scrapy框架学习 - 使用内置的ImagesPipeline下载图片

需求分析需求:爬取斗鱼主播图片,并下载到本地 思路: 使用Fiddler抓包工具,抓取斗鱼手机APP中的接口使用Scrapy框架的ImagesPipeline实现图片下载ImagesPipeline实 ...

- 使用Scrapy自带的ImagesPipeline下载图片,并对其进行分类。

ImagesPipeline是scrapy自带的类,用来处理图片(爬取时将图片下载到本地)用的. 优势: 将下载图片转换成通用的JPG和RGB格式 避免重复下载 缩略图生成 图片大小过滤 异步下载 . ...

- Scrapy爬取美女图片续集 (原创)

上一篇咱们讲解了Scrapy的工作机制和如何使用Scrapy爬取美女图片,而今天接着讲解Scrapy爬取美女图片,不过采取了不同的方式和代码实现,对Scrapy的功能进行更深入的运用.(我的新书< ...

- 用Scrapy爬虫下载图片(豆瓣电影图片)

用Scrapy爬虫的安装和入门教程,这里有,这篇链接的博客也是我这篇博客的基础. 其实我完全可以直接在上面那篇博客中的代码中直接加入我要下载图片的部分代码的,但是由于上述博客中的代码已运行,已爬到快九 ...

- scrapy批量下载图片

# -*- coding: utf-8 -*- import scrapy from rihan.items import RihanItem class RihanspiderSpider(scra ...

- scrapy下载图片到自己的目录,创建缩略图,存储入库

环境和工具:python2.7,scrapy 实验网站:http://www.27270.com/tag/333.html 爬去所有兔女郎图片,下面的推荐需要过滤 逻辑:分析网站信息,下载图片和入库 ...

- 通过scrapy内置的ImagePipeline下载图片到本地、并提取本地保存地址

1.通过scrapy内置的ImagePipeline下载图片到本地 2.获取图片保存本地的地址 1.通过scrapy内置的ImagePipeline下载图片到本地 1)在settings.py中打开 ...

- Scrapy Item用法示例(保存item到MySQL数据库,MongoDB数据库,使用官方组件下载图片)

需要学习的地方: 保存item到MySQL数据库,MongoDB数据库,下载图片 1.爬虫文件images.py # -*- coding: utf-8 -*- from scrapy import ...

- Scrapy——6 APP抓包—scrapy框架下载图片

Scrapy——6 怎样进行APP抓包 scrapy框架抓取APP豆果美食数据 怎样用scrapy框架下载图片 怎样用scrapy框架去下载斗鱼APP的图片? Scrapy创建下载图片常见那些问题 怎 ...

随机推荐

- 从eslint规则学点JavaScript知识

在知识星球陆续发了些eslint小知识,意在通过eslint知识去了解规则内部的原理,汇总在此: prefer-const 含义:始终用const定义你从不修改的变量,如果会被修改则使用let,永不使 ...

- SpringBoot整合jdbcTemplate

一.目录展示 二.导入依赖 三.配置文件 四.Student实体类 package com.zn.entity; public class Student { private Integer stu_ ...

- PLSQL设置查询快捷键

Tools-->Preferences-->User Interface-->Editor-->AutoReplace 新建文本文件shortcut.txt(名称和路径可以自定 ...

- docker chromium/chrome: error while loading shared libraries: libXcursor.so.2: cannot open shared object file: No such file or directory

在运行 pyppeteer 的时候,因为依赖浏览器,出现上述情况. 解决办法: 一般我们在Linux下执行某些外部程序的时候可能会提示找不到共享库的错误.原因一般有两个, 一个是操作系统里确实没有包含 ...

- 挑选(pick)

挑选(pick) 1s/128MB [题目背景] NOIP2017 马上就要到了,丁爷爷想要从他的小朋友里挑选出一些厉害的来参加NOIP. [题目描述] 丁爷爷共有 n 个小朋友,按编号 1 . . ...

- GitLab-使用SSH的方式拉取和推送项目

场景 Docker Compose部署GitLab服务,搭建自己的代码托管平台(图文教程): https://blog.csdn.net/BADAO_LIUMANG_QIZHI/article/det ...

- synchronized凭什么锁得住?

相关链接: <synchronized锁住的是谁?> 我们知道synchronized是重量级锁,我们知道synchronized锁住的是一个对象上的Monitor对象,我们也知道sync ...

- MVC 控制台 +log4net 存入数据库

首先在你的项目 安装好 log4net包 如下图进入AssemblyInfo.cs类 代码里面 加上这一串 [assembly: log4net.Config.XmlConfigurator(Conf ...

- spring boot 加入mail邮件支持

一.添加依赖 <!-- 邮件整合 --> <dependency> <groupId>org.springframework.boot</groupId> ...

- liunxCPU和内存,磁盘等资源

1.Screen是一款由GNU计划开发的用于命令行终端切换的自由软件.用户可以通过该软件同时连接多个本地或远程的命令行会话,并在其间自由切换.GNU Screen可以看作是窗口管理器的命令行界面版本. ...