Python机器学习——Agglomerative层次聚类

层次聚类(hierarchical clustering)可在不同层次上对数据集进行划分,形成树状的聚类结构。AggregativeClustering是一种常用的层次聚类算法。

其原理是:最初将每个对象看成一个簇,然后将这些簇根据某种规则被一步步合并,就这样不断合并直到达到预设的簇类个数。这里的关键在于:如何计算聚类簇之间的距离?

由于每个簇就是一个集合,因此需要给出集合之间的距离。给定聚类簇Ci,CjCi,Cj,有如下三种距离:

- 最小距离:

dmin(Ci,Cj)=minx⃗ i∈Ci,x⃗ j∈Cjdistance(x⃗ i,x⃗ j)dmin(Ci,Cj)=minx→i∈Ci,x→j∈Cjdistance(x→i,x→j)

它是两个簇的样本对之间距离的最小值。

- 最大距离:

dmax(Ci,Cj)=maxx⃗ i∈Ci,x⃗ j∈Cjdistance(x⃗ i,x⃗ j)dmax(Ci,Cj)=maxx→i∈Ci,x→j∈Cjdistance(x→i,x→j)

它是两个簇的样本对之间距离的最大值。

- 平均距离:

davg(Ci,Cj)=1|Ci||Cj|∑x⃗ i∈Ci∑x⃗ j∈Cjdistance(x⃗ i,x⃗ j)davg(Ci,Cj)=1|Ci||Cj|∑x→i∈Ci∑x→j∈Cjdistance(x→i,x→j)

它是两个簇的样本对之间距离的平均值。

当该算法的聚类簇采用dmindmin时,称为单链接single-linkage算法,当该算法的聚类簇采用dmaxdmax时,称为单链接complete-linkage算法,当该算法的聚类簇采用davgdavg时,称为单链接average-linkage算法。

下面给出算法:

- 输入:

- 数据集D=D={x⃗ 1,x⃗ 2,...,x⃗ Nx→1,x→2,...,x→N}

- 聚类簇距离度量函数

- 聚类簇数量KK

- 输出:簇划分C=C={C1,C2,...,CKC1,C2,...,CK}

算法步骤如下:

- 初始化:将每个样本都作为一个簇

Ci=[x⃗ i],i=1,2,...,NCi=[x→i],i=1,2,...,N

- 迭代:终止条件为聚类簇的数量为K。迭代过程如下:

- 计算聚类簇之间的距离,找出距离最近的两个簇,将这两个簇合并。

- 计算聚类簇之间的距离,找出距离最近的两个簇,将这两个簇合并。

Python实战

AgglomerativeClustering是scikit-learn提供的层级聚类算法模型,其原型为:

- 初始化:将每个样本都作为一个簇

class sklearn.cluster.AgglomerativeClustering(n_clusters=2, affinity=’euclidean’, memory=None, connectivity=None, compute_full_tree=’auto’, linkage=’ward’, pooling_func=<function mean>)

- 1

参数

- n_clusters:一个整数,指定分类簇的数量

- connectivity:一个数组或者可调用对象或者None,用于指定连接矩阵

- affinity:一个字符串或者可调用对象,用于计算距离。可以为:’euclidean’,’l1’,’l2’,’mantattan’,’cosine’,’precomputed’,如果linkage=’ward’,则affinity必须为’euclidean’

- memory:用于缓存输出的结果,默认为不缓存

- n_components:在 v-0.18中移除

- compute_full_tree:通常当训练了n_clusters后,训练过程就会停止,但是如果compute_full_tree=True,则会继续训练从而生成一颗完整的树

- linkage:一个字符串,用于指定链接算法

- ‘ward’:单链接single-linkage,采用dmindmin

- ‘complete’:全链接complete-linkage算法,采用dmaxdmax

- ‘average’:均连接average-linkage算法,采用davgdavg

- pooling_func:一个可调用对象,它的输入是一组特征的值,输出是一个数

属性

- labels:每个样本的簇标记

- n_leaves_:分层树的叶节点数量

- n_components:连接图中连通分量的估计值

- children:一个数组,给出了每个非节点数量

方法

- fit(X[,y]):训练样本

- fit_predict(X[,y]):训练模型并预测每个样本的簇标记

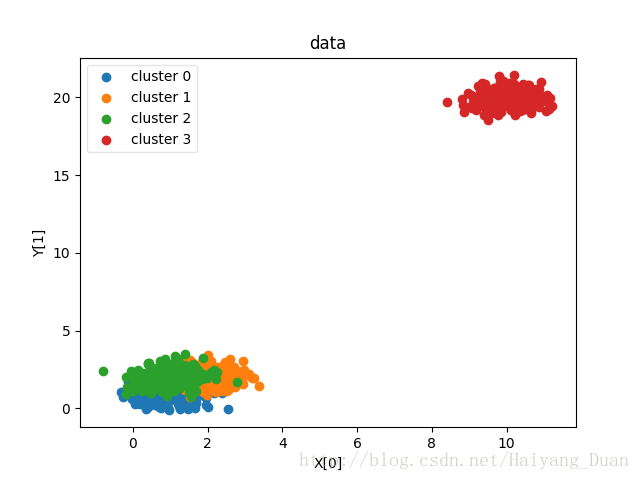

from sklearn import clusterfrom sklearn.metrics import adjusted_rand_scoreimport numpy as npimport matplotlib.pyplot as pltfrom sklearn.datasets.samples_generator import make_blobs"""产生数据"""def create_data(centers,num=100,std=0.7):X,labels_true = make_blobs(n_samples=num,centers=centers, cluster_std=std)return X,labels_true"""数据作图"""def plot_data(*data):X,labels_true=datalabels=np.unique(labels_true)fig=plt.figure()ax=fig.add_subplot(1,1,1)colors='rgbycm'for i,label in enumerate(labels):position=labels_true==labelax.scatter(X[position,0],X[position,1],label="cluster %d"%label),color=colors[i%len(colors)]ax.legend(loc="best",framealpha=0.5)ax.set_xlabel("X[0]")ax.set_ylabel("Y[1]")ax.set_title("data")plt.show()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

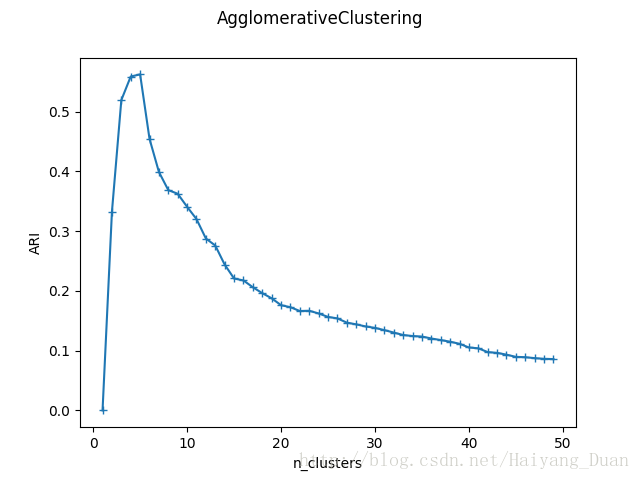

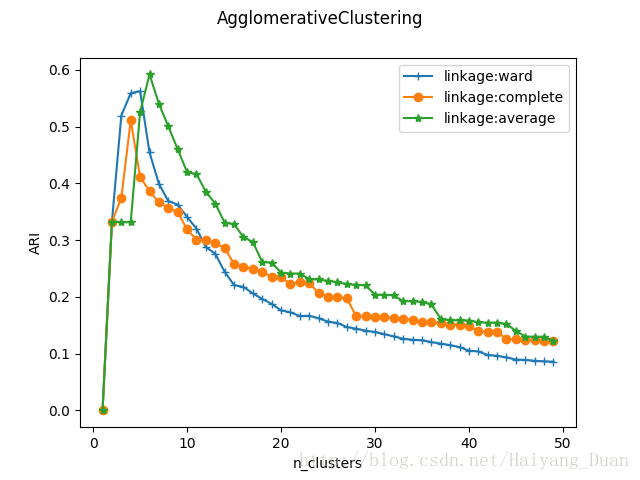

这里写代码片"""测试函数"""def test_AgglomerativeClustering(*data):X,labels_true=dataclst=cluster.AgglomerativeClustering()predicted_labels=clst.fit_predict(X)print("ARI:%s"% adjusted_rand_score(labels_true, predicted_labels))"""考察簇的数量对于聚类效果的影响"""def test_AgglomerativeClustering_nclusters(*data):X,labels_true=datanums=range(1,50)ARIS=[]for num in nums:clst=cluster.AgglomerativeClustering(n_clusters=num)predicted_lables=clst.fit_predict(X)ARIS.append(adjusted_rand_score(labels_true, predicted_lables))fig=plt.figure()ax=fig.add_subplot(1,1,1)ax.plot(nums,ARIS,marker="+")ax.set_xlabel("n_clusters")ax.set_ylabel("ARI")fig.suptitle("AgglomerativeClustering")plt.show()"""考察链接方式对聚类结果的影响"""def test_agglomerativeClustering_linkage(*data):X,labels_true=datanums=range(1,50)fig=plt.figure()ax=fig.add_subplot(1,1,1)linkages=['ward','complete','average']markers="+o*"for i,linkage in enumerate(linkages):ARIs=[]for num in nums:clst=cluster.AgglomerativeClustering(n_clusters=num,linkage=linkage)predicted_labels=clst.fit_predict(X)ARIs.append(adjusted_rand_score(labels_true, predicted_labels))ax.plot(nums,ARIs,marker=markers[i],label="linkage:%s"%linkage)ax.set_xlabel("n_clusters")ax.set_ylabel("ARI")ax.legend(loc="best")fig.suptitle("AgglomerativeClustering")plt.show()centers=[[1,1],[2,2],[1,2],[10,20]]X,labels_true=create_data(centers, 1000, 0.5)test_AgglomerativeClustering(X,labels_true)plot_data(X,labels_true)test_AgglomerativeClustering_nclusters(X,labels_true)test_agglomerativeClustering_linkage(X,labels_true)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

可以看到当n_clusters=4时,ARI指数最大,因为确实是从四个中心点产生的四个簇。

- 1

- 2

可以看到,三种链接方式随分类簇的数量的总体趋势相差无几。但是单链接方式ward的峰值最大

Python机器学习——Agglomerative层次聚类的更多相关文章

- 【Python机器学习实战】聚类算法(2)——层次聚类(HAC)和DBSCAN

层次聚类和DBSCAN 前面说到K-means聚类算法,K-Means聚类是一种分散性聚类算法,本节主要是基于数据结构的聚类算法--层次聚类和基于密度的聚类算法--DBSCAN两种算法. 1.层次聚类 ...

- python实现一个层次聚类方法

层次聚类(Hierarchical Clustering) 一.概念 层次聚类不需要指定聚类的数目,首先它是将数据中的每个实例看作一个类,然后将最相似的两个类合并,该过程迭代计算只到剩下一个类为止,类 ...

- 【Python机器学习实战】聚类算法(1)——K-Means聚类

实战部分主要针对某一具体算法对其原理进行较为详细的介绍,然后进行简单地实现(可能对算法性能考虑欠缺),这一部分主要介绍一些常见的一些聚类算法. K-means聚类算法 0.聚类算法算法简介 聚类算法算 ...

- 机器学习(6): 层次聚类 hierarchical clustering

假设有N个待聚类的样本,对于层次聚类来说,步骤: 1.(初始化)把每个样本归为一类,计算每两个类之间的距离,也就是样本与样本之间的相似度: 2.寻找各个类之间最近的两个类, ...

- 吴裕雄 python 机器学习——K均值聚类KMeans模型

import numpy as np import matplotlib.pyplot as plt from sklearn import cluster from sklearn.metrics ...

- 吴裕雄 python 机器学习——混合高斯聚类GMM模型

import numpy as np import matplotlib.pyplot as plt from sklearn import mixture from sklearn.metrics ...

- Python机器学习算法 — K-Means聚类

K-Means简介 步,直到每个簇的中心基本不再变化: 6)将结果输出. K-Means的说明 如图所示,数据样本用圆点表示,每个簇的中心点用叉叉表示: (a)刚开始时是原始数据,杂乱无章 ...

- 吴裕雄 python 机器学习——层次聚类AgglomerativeClustering模型

import numpy as np import matplotlib.pyplot as plt from sklearn import cluster from sklearn.metrics ...

- 机器学习算法总结(五)——聚类算法(K-means,密度聚类,层次聚类)

本文介绍无监督学习算法,无监督学习是在样本的标签未知的情况下,根据样本的内在规律对样本进行分类,常见的无监督学习就是聚类算法. 在监督学习中我们常根据模型的误差来衡量模型的好坏,通过优化损失函数来改善 ...

随机推荐

- asp.net mvc5 使用百度ueditor 本编辑器完整示例(三)在IIS中多个应用程序使用多个ueditor对象

最近做了一个项目,要求同一类型的多个专业应用程序(网站),但是每个应用程序都需要调用各自当中的ueditor. 步骤: 一.在vs2013中设置每个专业的asp.net mvc 应用程序. 1.配置根 ...

- 待研究———node中使用session时的id不断更改问题

使用的expree,中间件为cookie-parser,express-session,当对res.session.id进行赋值操作后,再调取其值会发现,此时它的值并不是最初给定的值,而是经过加密的字 ...

- Mac下Ruby升级与Rails的安装

也是醉了,网上查了半天一脸懵逼.然后自己动手试试 gem install rails瞬间命令行就没反应了,以为命令行挂了,但是一会儿报错说是没有权限. 好吧,那么来这个 sudo gem instal ...

- 《Windows核心编程系列》十三谈谈在应用程序中使用虚拟内存

在应用程序中使用虚拟内存 Windows提供了以下三种机制对内存进行操控: 一:虚拟内存.最适合来管理大型对象数据或大型结构数组. 二:内存映射文件.最适合用来管理大型数据流,以及在同一机 器上运行的 ...

- bzoj2333[SCOI2011]棘手的操作 洛谷P3273 [SCOI2011]棘手的操作

2333? 先记一下吧,这题现在全部都是照着题解做的,因为怎么改都改不出来,只好对着题解改,以后还要再做过 以后再也不用指针了!太恶心了!空指针可不止直接特判那么简单啊,竟然还要因为空指针写奇怪的分类 ...

- 转 【TTS】AIX平台数据库迁移到Linux--基于RMAN(真实环境)

[TTS]AIX平台数据库迁移到Linux--基于RMAN(真实环境) http://www.cnblogs.com/lhrbest/articles/5186933.html 各位技术爱好者,看完本 ...

- JSP页面自动刷新

1.页面自动刷新:把如下代码加入<head>区域中<meta http-equiv="refresh" content="20">,其中 ...

- ssm(Spring、Springmvc、Mybatis)实战之淘淘商城-第二天(非原创)

文章大纲 一.课程介绍二.整合淘淘商城ssm项目三.Mybatis分页插件PageHelper使用四.整合测试五.项目源码与资料下载六.参考文章 一.课程介绍 一共14天课程(1)第一天:电商行业 ...

- Mac OS 下安装和配置 maven

1. 安装 Maven 前的必须准备 需先安装 Java 环境 下载合适的 JDK 配置 JDK 环境变量 JAVA_HOME:为 JDK 安装目录 Path:为 JDK/bin 目录 测试是否成功: ...

- vue项目中安装cnpm和node_modules

1.安装cnpm的nodejs包管理工具,命令行: npm install -g cnpm --registry=https://registry.npm.taobao.org 2. 每个vue项 ...