Canal的简单使用

Canal的简单实用

一、背景

工作中有个需求,当数据库的数据变更时,另外一个系统中的数据要能及时感应到,通过调研知道,监听数据库的binlog可以做到一个准实时的通知,而canal主要用途是基于 MySQL 数据库增量日志解析,提供增量数据订阅和消费,正好满足需求,此处记录一下canal的简单使用。

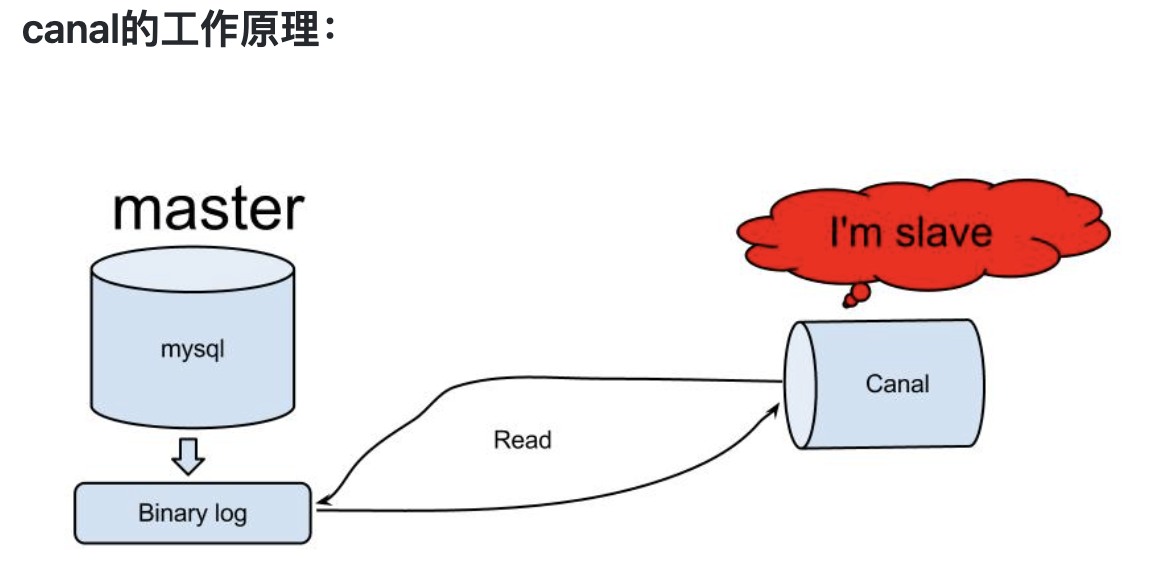

二、canal的工作原理

步骤:

- canal模拟mysql slave的交互协议,伪装自己为mysql slave,向mysql master发送dump协议

- mysql master收到dump请求,开始推送binary log给slave(也就是canal)

- canal解析binary log对象(原始为byte流)

三、安装canal

1、mysql配置相关

1、检测binlog是否开启

mysql> show variables like 'log_bin';+---------------+-------+| Variable_name | Value |+---------------+-------+| log_bin | ON |+---------------+-------+1 row in set (0.00 sec)

log_bin的值为ON说明打开了。

2、mysql开启binlog

[mysqld]#binlog日志的基本文件名,需要注意的是启动mysql的用户需要对这个目录(/usr/local/var/mysql/binlog)有写入的权限log_bin=/usr/local/var/mysql/binlog/mysql-bin# 配置binlog日志的格式binlog_format = ROW# 配置 MySQL replaction 需要定义,不能和 canal 的 slaveId 重复server-id=1# 设置中继日志的路径relay_log=/usr/local/var/mysql/relaylog/mysql-relay

3、创建canal用户

CREATE USER canal IDENTIFIED BY 'canal';GRANT SELECT, REPLICATION SLAVE, REPLICATION CLIENT ON *.* TO 'canal'@'%';-- GRANT ALL PRIVILEGES ON *.* TO 'canal'@'%' ;FLUSH PRIVILEGES;

2、canal配置相关

1、下载canal

# 1.下载 deployer$ wget https://github.com/alibaba/canal/releases/download/canal-1.1.5/canal.deployer-1.1.5.tar.gz# 下载适配器,不是必须的$ wget https://github.com/alibaba/canal/releases/download/canal-1.1.5/canal.adapter-1.1.5.tar.gz# 下载管理台,不是必须的$ wget https://github.com/alibaba/canal/releases/download/canal-1.1.5/canal.admin-1.1.5.tar.gz# 下载示例程序$ wget https://github.com/alibaba/canal/releases/download/canal-1.1.5/canal.example-1.1.5.tar.gz# 2.解压 deployer (解压后的目录要存在)tar -zxvf canal.deployer-1.1.5.tar.gz -C /Users/huan/soft/canal/deployer/# 3. 查看 conf 目录结构$ tree confconf├── canal.properties├── canal_local.properties├── example│ └── instance.properties├── logback.xml├── metrics│ └── Canal_instances_tmpl.json└── spring├── base-instance.xml├── default-instance.xml├── file-instance.xml├── group-instance.xml├── memory-instance.xml└── tsdb├── h2-tsdb.xml├── mysql-tsdb.xml├── sql│ └── create_table.sql└── sql-map├── sqlmap-config.xml├── sqlmap_history.xml└── sqlmap_snapshot.xml

2、配置一个instance

instance:一个instance就是一个消息队列,每个instance通道都有各自的一份配置,因为每个mysql的ip,帐号,密码等信息各不相同。

一个canal server可以存在多个instance。

1、复制conf/example文件夹

cp -r conf/example conf/customer

customer可以简单理解为此处我需要链接customer数据库,因此命名为这个。

2、修改instance的配置

vim conf/customer/instance.properties

# mysql集群配置中的serverId概念,需要保证和当前mysql集群中id唯一 (v1.1.x版本之后canal会自动生成,不需要手工指定)# canal.instance.mysql.slaveId=0# mysql主库链接地址canal.instance.master.address=127.0.0.1:3306# mysql主库链接时起始的binlog文件canal.instance.master.journal.name=# mysql主库链接时起始的binlog偏移量canal.instance.master.position=# mysql主库链接时起始的binlog的时间戳canal.instance.master.timestamp=# mysql数据库帐号(此处的用户名和密码为 安装canal#mysql配置相关#创建canal用户 这一步创建的用户名和密码)canal.instance.dbUsername=canal# mysql数据库密码canal.instance.dbPassword=canal# mysql 数据解析编码canal.instance.connectionCharset = UTF-8# mysql 数据解析关注的表,Perl正则表达式,即我们需要关注那些库和那些表的binlog数据,也可以在canal client api中手动覆盖canal.instance.filter.regex=.*\\..*# table black regex# mysql 数据解析表的黑名单,表达式规则见白名单的规则canal.instance.filter.black.regex=mysql\\.slave_.*

3、instance注意事项

1、配置需要关注那个库和那个表的binlog

修改 instance.properties文件的这个属性canal.instance.filter.regex,规则如下:

- 所有表:.* or .*\\..*

- canal schema下所有表: canal\\…*

- canal下的以canal打头的表:canal\\.canal.*

- canal schema下的一张表:canal\\.test1

- 多个规则组合使用:canal\\..*,mysql.test1,mysql.test2 (逗号分隔)

2、mysql链接时的起始位置

- canal.instance.master.journal.name + canal.instance.master.position : 精确指定一个binlog位点,进行启动

- canal.instance.master.timestamp : 指定一个时间戳,canal会自动遍历mysql binlog,找到对应时间戳的binlog位点后,进行启动

- 不指定任何信息:默认从当前数据库的位点,进行启动。(show master status)

3、mysql解析关注表定义

- 标准的Perl正则,注意转义时需要双斜杠:\

4、mysql链接的编码

目前canal版本仅支持一个数据库只有一种编码,如果一个库存在多个编码,需要通过filter.regex配置,将其拆分为多个canal instance,为每个instance指定不同的编码

5、instance.properties配置参考链接:

https://github.com/alibaba/canal/wiki/AdminGuide

3、canal.properties配置相关

vim conf/canal.properties

# canal server绑定的本地IP信息,如果不配置,默认选择一个本机IP进行启动服务canal.ip = 127.0.0.1# canal server提供socket服务的端口canal.port = 1111# metrics 端口canal.metrics.pull.port = 11112# canal 服务的用户名(客户端连接的时候需要这个用户名和密码,也可以不配置)canal.user = canal# canal 服务的密码canal.passwd = 123456# tcp, kafka, rocketMQ, rabbitMQ(如果我们要将数据发送到kafka中,则此处写kafka,然后配置kafka的配置,此处以tcp演示)canal.serverMode = tcp# 当前server上部署的instance列表,此处写 customer ,则和 conf 目录同级下必须要有一个 customer 文件夹,即上一步我们创建的,如果有多个instance说,则以英文的逗号隔开canal.destinations = customer# 如果系统是1个cpu,那么需要将这个并行设置成falsecanal.instance.parser.parallel = true

注意事项:

1、canal.destinations配置

在canal.properties定义了canal.destinations后,需要在canal.conf.dir对应的目录下建立同名的文件

比如:

canal.destinations = example1,example2

这时需要创建example1和example2两个目录,每个目录里各自有一份instance.properties.

ps. canal自带了一份instance.properties demo,可直接复制conf/example目录进行配置修改

cp -R example example1/cp -R example example2/

2、canal.auto.scan配置

如果canal.properties未定义instance列表,但开启了canal.auto.scan时

- server第一次启动时,会自动扫描conf目录下,将文件名做为instance name,启动对应的instance

- server运行过程中,会根据canal.auto.scan.interval定义的频率,进行扫描

- 发现目录有新增,启动新的instance

- 发现目录有删除,关闭老的instance

- 发现对应目录的instance.properties有变化,重启instance

3、参考链接

参考链接:https://github.com/alibaba/canal/wiki/AdminGuide

4、启动canal

1、启动canal

# 启动canal serversh bin/startup.sh

2、查看日志

# canal查看日志tail -f -n200 logs/canal/canal.log# 如果canal启动失败则需要查看此日志tail -f -n200 logs/canal/canal_stdout.log# 查看instance日志,由上面的配置可知,我们的instance的名字是customer,所以看这个日志.tail -f -n200 logs/customer/customer.log

3、jdk版本

启动的时候需要注意一下本地JDK的版本,测试时发现使用jdk11不能启动,使用jdk8可以启动。

四、客户端消费canal数据

1、引入依赖

<dependencies><dependency><groupId>com.alibaba.otter</groupId><artifactId>canal.client</artifactId><version>1.1.5</version></dependency><dependency><groupId>com.alibaba.otter</groupId><artifactId>canal.protocol</artifactId><version>1.1.5</version></dependency><dependency><groupId>com.alibaba.otter</groupId><artifactId>canal.common</artifactId><version>1.1.5</version></dependency></dependencies>

2、编写客户端代码

import com.alibaba.otter.canal.client.CanalConnector;import com.alibaba.otter.canal.client.CanalConnectors;import com.alibaba.otter.canal.protocol.CanalEntry;import com.alibaba.otter.canal.protocol.Message;import java.net.InetSocketAddress;import java.util.List;import java.util.concurrent.TimeUnit;/*** canal client api 的使用* https://github.com/alibaba/canal/wiki/ClientExample* 测试过程中发现,如果修改一个sql语句,但是修改的值没有发生变化,则此处不会监控到。* 同一个客户端启动多次,只有一个客户端可以获取到数据** @author huan.fu 2021/5/31 - 上午10:31*/public class CanalClientApi {public static void main(String[] args) {String destination = "customer";// 创建一个 canal 链接CanalConnector canalConnector = CanalConnectors.newSingleConnector(new InetSocketAddress("127.0.0.1", 11111), destination, "admin", "admin");// 链接对应的canal servercanalConnector.connect();// 订阅那个库的那个表等/*** 订阅规则* 1. 所有表:.* or .*\\..** 2. canal schema下所有表: canal\\..** 3. canal下的以canal打头的表:canal\\.canal.** 4. canal schema下的一张表:canal\\.test1* 5. 多个规则组合使用:canal\\..*,mysql.test1,mysql.test2 (逗号分隔)*/canalConnector.subscribe("temp_work\\.customer");// 回滚到未进行 #ack 的地方,下次fetch的时候,可以从最后一个没有 #ack 的地方开始拿canalConnector.rollback();int batchSize = 1000;while (true) {// 获取一批数据,不一定会获取到 batchSize 条Message message = canalConnector.getWithoutAck(batchSize);// 获取批次idlong batchId = message.getId();// 获取数据List<CanalEntry.Entry> entries = message.getEntries();if (batchId == -1 || entries.isEmpty()) {System.out.println("没有获取到数据");try {TimeUnit.SECONDS.sleep(3);} catch (InterruptedException e) {e.printStackTrace();}continue;}for (CanalEntry.Entry entry : entries) {if (entry.getEntryType() == CanalEntry.EntryType.TRANSACTIONBEGIN || entry.getEntryType() == CanalEntry.EntryType.TRANSACTIONEND) {continue;}CanalEntry.RowChange rowChange;try {rowChange = CanalEntry.RowChange.parseFrom(entry.getStoreValue());} catch (Exception e) {throw new RuntimeException("解析binlog数据出现异常 , data:" + entry.toString(), e);}CanalEntry.EventType eventType = rowChange.getEventType();System.out.println(String.format("================> binlog[%s:%s] , name[%s,%s] , eventType : %s",entry.getHeader().getLogfileName(), entry.getHeader().getLogfileOffset(),entry.getHeader().getSchemaName(), entry.getHeader().getTableName(),eventType));if (eventType == CanalEntry.EventType.QUERY || rowChange.getIsDdl()) {System.out.println("sql => " + rowChange.getSql());}for (CanalEntry.RowData rowData : rowChange.getRowDatasList()) {if (eventType == CanalEntry.EventType.DELETE) {printColumn(rowData.getBeforeColumnsList());} else if (eventType == CanalEntry.EventType.INSERT) {printColumn(rowData.getAfterColumnsList());} else {System.out.println("-------> before");printColumn(rowData.getBeforeColumnsList());System.out.println("-------> after");printColumn(rowData.getAfterColumnsList());}}}canalConnector.ack(batchId);}}private static void printColumn(List<CanalEntry.Column> columns) {for (CanalEntry.Column column : columns) {System.out.println(column.getName() + " : " + column.getValue() + " update=" + column.getUpdated());}}}

注意️:

经测试,同一个客户端代码,启动多份,模拟多个客户端同时消费,只有一个客户端可以消费数据。

3、测试结果

没有获取到数据没有获取到数据================> binlog[mysql-bin.000014:5771] , name[temp_work,customer] , eventType : UPDATE-------> beforeid : 12 update=falsephone : 123 update=falseaddress : abcdefg update=falsecolumn_4 : update=false-------> afterid : 12 update=falsephone : 123 update=falseaddress : 数据改变 update=truecolumn_4 : update=false没有获取到数据没有获取到数据

可以看到获取到了,改变后的数据。

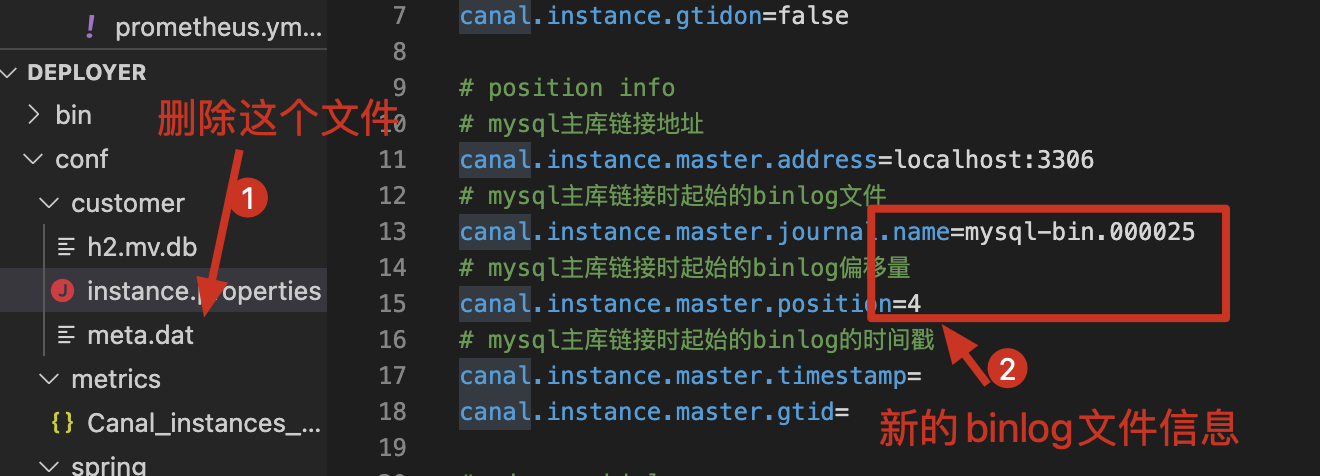

五、消费的binlog不存在

1、单机部署

1、查看数据库中binlog文件的位置

show variables like 'log_bin_basename';

2、找到binlog文件和位置

# 查询 mysql-bin.000026 这个binlog文件,从pos点: 4 开始查起,一共查询查询5条show binlog events in 'mysql-bin.000026' from 4 limit 5;

3、停止canal-server

4、修改instance下的 instance.properties下的如下配置

# mysql主库链接时起始的binlog文件canal.instance.master.journal.name=mysql-bin.000026# mysql主库链接时起始的binlog偏移量canal.instance.master.position=4# mysql主库链接时起始的binlog的时间戳canal.instance.master.timestamp=

5、删除meta.data文件。

注意️:

可能会出现的一个问题: column size is not match for table:temp_work.customer,4 vs 3,这个是因为binlog中的表结构和我们真实库中的表结构对不起来,如果发生了这个问题,参考如下链接:https://github.com/alibaba/canal/wiki/TableMetaTSDB 解决。

2、集群部署

1、停止 canal server、canal client

2、删除 zookeeper 上的 /otter/canal/destination/{instanceId} 目录

六、完整代码

七、参考链接

1、https://github.com/alibaba/canal/wiki/简介

2、https://github.com/alibaba/canal/wiki/AdminGuide

3、https://github.com/alibaba/canal/wiki/常见问题解答

4、https://github.com/alibaba/canal/wiki/TableMetaTSDB

Canal的简单使用的更多相关文章

- Canal的简单使用(监控数据库数据的变化)

原文:https://www.cnblogs.com/java-spring/p/8930740.html canal可以用来监控数据库数据的变化,从而获得新增数据,或者修改的数据,用于实际工作中,比 ...

- 阿里Canal安装和代码示例

Canal的简单使用 canal可以用来监控数据库数据的变化,从而获得新增数据,或者修改的数据,用于实际工作中,比较实用,特此记录一下 Canal简介 canal是应阿里巴巴存在杭州和美国的双机房部署 ...

- Docker安装canal、mysql进行简单测试与实现redis和mysql缓存一致性

一.简介 canal [kə'næl],译意为水道/管道/沟渠,主要用途是基于 MySQL 数据库增量日志解析,提供增量数据订阅和消费. 早期阿里巴巴因为杭州和美国双机房部署,存在跨机房同步的业务需求 ...

- canal简单安装使用

canal简介:https://github.com/alibaba/canal 1.数据库配置 首先使用canal需要修改数据库配置 [mysqld] log-bin=mysql-bin # 开启 ...

- 缓存一致性和跨服务器查询的数据异构解决方案canal

当你的项目数据量上去了之后,通常会遇到两种情况,第一种情况应是最大可能的使用cache来对抗上层的高并发,第二种情况同样也是需要使用分库 分表对抗上层的高并发...逼逼逼起来容易,做起来并不那么乐观, ...

- Canal 同步异常分析:Could not find first log file name in binary log index file

文章首发于[博客园-陈树义],点击跳转到原文Canal同步异常分析:Could not find first log file name in binary log index file. 公司搜索相 ...

- 【源码】canal和otter的高可靠性分析

一般来说,我们对于数据库最主要的要求就是:数据不丢.不管是主从复制,还是使用类似otter+canal这样的数据库同步方案,我们最基本的需求是,在数据不丢失的前提下,尽可能的保证系统的高可用,也就是在 ...

- MySQL增量订阅&消费组件Canal POC

POC的目的:1.与MYSQL的对接方式,配置文档2.订阅的延迟3.订阅后宕机消息会不会丢失4.能不能从指定的点开始重新订阅5.高并发写入的时候,日志的顺序是否还能保持,不考虑消费的情况订阅是否会延迟 ...

- 【MySQL】通过Binary Log简单实现数据回滚(一)

一.前言 对,没错,我又水了好一阵子,深刻反思寄几.前段时间,工作项目上出于对excel等批量操作可能出现误操作的问题,要求提供一个能够根据操作批次进行数据回滚的能力.在开发的过程中接触到了MySQL ...

随机推荐

- Typora + PicGo做个人知识库

最近在做个人知识库,考察了一圈各种平台和工具,发现还是直接用文件系统管理Markdown文件更符合我当前的需求.以Markdown文件作为文字载体,以文件目录作为分类结构,承载以计算机知识为主的学习笔 ...

- 植入式Web前端开发方法

上一篇,我讲述了植入式Web前端开发的基本情况,本篇就来探究其开发方法.以下假定CMS只能植入前端代码,并且需求规模是任意大小的. 代码形式 HTML代码是直接植入的毫无疑问,但除非植入的代码非常简短 ...

- 10 个不为人知的Python冷知识

1. 省略号也是对象 ... 这是省略号,在Python中,一切皆对象.它也不例外. 在 Python 中,它叫做 Ellipsis . 在 Python 3 中你可以直接写-来得到这玩意. > ...

- 升级到windows10之后的骚操作,安装debian,centos7,支持linux、docker、kubectl命令

修改Windows10默认字体和图标很大 打开Hyper-V Windows10下载Docker Desktop https://www.docker.com/products/docker-desk ...

- PHP中使用if的时候为什么建议将常量放在前面?

在某些框架或者高手写的代码中,我们会发现有不少人喜欢在进行条件判断的时候将常量写在前面,比如: if(1 == $a){ echo 111; } 这样做有什么好处呢?我们假设一个不小心的粗心大意,少写 ...

- Shell系列(6)- 管道符

多命令顺序执行 多命令执行符 格式 作用 ; 命令1 ; 命令2 连接命令:多个命令顺序执行,命令之间没有任何逻辑联系:前面命令报错,后面命令照常执行 && 命令1 && ...

- Typescript, ES6

* typescript 中文文档 https://www.tslang.cn/docs/home.html * ECMAScript 6 入门 http://es6.ruanyifeng.com/# ...

- 执行sudo apt-get update,连接失败

问题:sudo apt-get update连接失败 错误:1 http://cn.mirrors.ustc.edu.cn/ubuntu bionic InRelease 连接失败 [IP: 218. ...

- Centos7安装配置Gitlab-CE

GitLab介绍 GitLab:是一个基于Git实现的在线代码仓库托管软件,你可以用gitlab自己搭建一个类似于Github一样的系统,一般用于在企业.学校等内部网络搭建git私服. 功能:Gitl ...

- 《Android自动化环境搭建》

一.安装JDK并配置环境变量 1:在Java官网上下载本机系统相对应的jdk文件安装,直接下一步一步到位 2:配置JAVA_HOME 新建 JAVA_HOME 环境变量,变量值是所安装JDK 的路径, ...