spark实验(一)--spark安装(1)

一、实验目的

(1)掌握 Linux 虚拟机的安装方法。Spark 和 Hadoop 等大数据软件在 Linux 操作系统 上运行可以发挥最佳性能,因此,本教程中,Spark 都是在 Linux 系统中进行相关操作,同 时,下一章的 Scala 语言也会在 Linux 系统中安装和操作。鉴于目前很多读者正在使用 Windows 操作系统,因此,为了顺利完成本教程的后续实验,这里有必要通过本实验,让读 者掌握在 Windows 操作系统上搭建 Linux 虚拟机的方法。当然,安装 Linux 虚拟机只是安 装 Linux 系统的其中一种方式,实际上,读者也可以不用虚拟机,而是采用双系统的方式安 装 Linux 系统。本教程推荐使用虚拟机方式。 (2)熟悉 Linux 系统的基本使用方法。本教程全部在 Linux 环境下进行实验,因此, 需要读者提前熟悉 Linux 系统的基本用法,尤其是一些常用命令的使用方法。

二、实验过程

环境:centos6.4,jdk1.7.0,spark1.5.2

根据这篇博文https://www.cnblogs.com/Genesis2018/p/9079787.html安装spark1.5.2

首先输入

wget http://archive.apache.org/dist/spark/spark-1.5.2/spark-1.5.2-bin-hadoop2.6.tgz下载spark1.5.2

等待下载完成后,将下载完的文件进行解压

输入

tar -zxvf spark-1.5.2-bin-hadoop2.6.tgz将下载完的文件进行解压,之后输入以下命令移动到对应的/usr/local/目录中

mv spark-1.5.2-bin-hadoop2.6 /usr/local/

接着输入

gedit /etc/profile.d/spark.sh在打开的文件中添加以下的信息

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

export HDFS_CONF_DIR=$HADOOP_HOME/etc/hadoop

export YARN_CONF_DIR==$HADOOP_HOME/etc/hadoop

export SPARK_HOME=/usr/local/spark-1.5.2-bin-hadoop2.6

export PATH=$PATH:$SPARK_HOME/bin保存退出后

输入

source /etc/profile.d/spark.sh使文件生效

接着输入

cp /usr/local/spark-1.5.2-bin-hadoop2.6/conf/spark-env.sh.template /usr/local/spark-1.5.2-bin-hadoop2.6/conf/spark-env.shgedit /usr/local/spark-1.5.2-bin-hadoop2.6/conf/spark-env.sh在打开的文件中输入(IP和jdk需要根据自己本身的版本进行设置)

export JAVA_HOME=/usr/lib/jvm/java-1.7.0-openjdk-1.7.0.221.x86_64/jre

export SCALA_HOME=/usr/local/scala-2.10.6

export HADOOP_HOME=/usr/local/hadoop-2.7.2

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

export SPARK_MASTER_HOST=192.168.57.128

export SPARK_LOCAL_IP=192.168.57.128

接着输入

cp /usr/local/spark-1.5.2-bin-hadoop2.6/conf/slaves.template /usr/local/spark-1.5.2-bin-hadoop2.6/conf/slavesgedit /usr/local/spark-1.5.2-bin-hadoop2.6/conf/slaves将localhost中的内容改为对应虚拟机ip的地址

192.168.57.128

保存退出

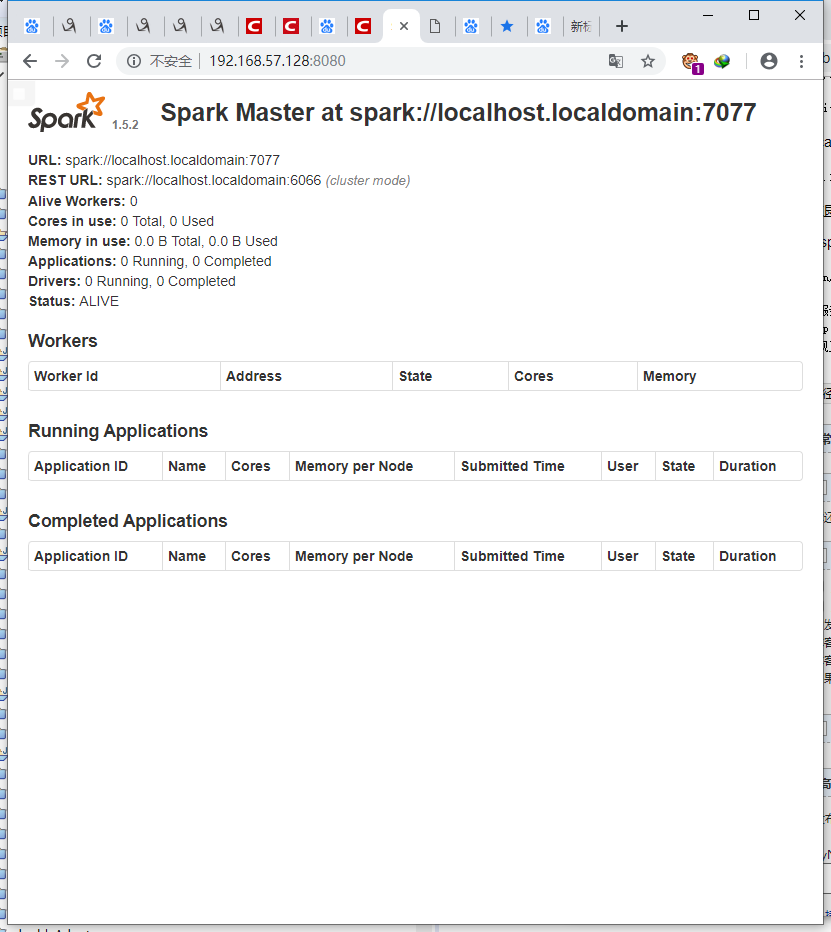

验证spark安装:

sbin/start-master.sh在服务器外边输入对应

http://192.168.57.128:8080/

发现正常启动

spark安装完毕

spark实验(一)--spark安装(1)的更多相关文章

- spark实验(五)--Spark SQL 编程初级实践(1)

一.实验目的 (1)通过实验掌握 Spark SQL 的基本编程方法: (2)熟悉 RDD 到 DataFrame 的转化方法: (3)熟悉利用 Spark SQL 管理来自不同数据源的数据. 二.实 ...

- spark实验(三)--Spark和Hadoop的安装(1)

一.实验目的 (1)掌握在 Linux 虚拟机中安装 Hadoop 和 Spark 的方法: (2)熟悉 HDFS 的基本使用方法: (3)掌握使用 Spark 访问本地文件和 HDFS 文件的方法. ...

- spark实验(二)--scala安装(1)

一.实验目的 (1)掌握在 Linux 虚拟机中安装 Hadoop 和 Spark 的方法: (2)熟悉 HDFS 的基本使用方法: (3)掌握使用 Spark 访问本地文件和 HDFS 文件的方法. ...

- spark实验(二)--eclipse安装scala环境(2)

此次在eclipse中的安装参考这篇博客https://blog.csdn.net/lzxlfly/article/details/80728772 Help->Eclipse Marketpl ...

- 在阿里云上搭建 Spark 实验平台

在阿里云上搭建 Spark 实验平台 Hadoop2.7.3+Spark2.1.0 完全分布式环境 搭建全过程 [传统文化热爱者] 阿里云服务器搭建spark特别坑的地方 阿里云实现Hadoop+Sp ...

- Apache Spark简单介绍、安装及使用

Apache Spark简介 Apache Spark是一个高速的通用型计算引擎,用来实现分布式的大规模数据的处理任务. 分布式的处理方式可以使以前单台计算机面对大规模数据时处理不了的情况成为可能. ...

- spark的standlone模式安装和application 提交

spark的standlone模式安装 安装一个standlone模式的spark集群,这里是最基本的安装,并测试一下如何进行任务提交. require:提前安装好jdk 1.7.0_80 :scal ...

- Spark运行环境的安装

scala-2.9.3:一种编程语言,下载地址:http://www.scala-lang.org/download/ spark-1.4.0:必须是编译好的Spark,如果下载的是Source ...

- 实验5 Spark SQL编程初级实践

今天做实验[Spark SQL 编程初级实践],虽然网上有答案,但都是用scala语言写的,于是我用java语言重写实现一下. 1 .Spark SQL 基本操作将下列 JSON 格式数据复制到 Li ...

随机推荐

- next.config.js

const configs = { // 编译文件的输出目录 distDir: 'dest', // 是否给每个路由生成Etag generateEtags: true, // 页面内容缓存配置 on ...

- A task in a suit and a tie:paraphrase generation with semantic augmentation解读

1.该算法核心:在seq2seq模型的编码器中增加语义的frame 和 roles 2.上图为算法整个流程: 1).首先输入一句话s,SLING会使用frame和role label注释输入语句s,然 ...

- 【笔记】Linux进程间同步和进程绑定至特定cpu

#define _GNU_SOURCE #include <stdio.h> #include <sys/types.h> #include <sys/stat.h> ...

- 寒假安卓app开发学习记录(1)

今天是安卓软件开发的第一天.虽然之前有了对javaweb的学习,但是对基于安卓的软件开发还是一无所知.所以,第一步就是寻找学习资源,从慕课网上还有菜鸟教程上都找到了对应的教程.然后就开始了开发的第一步 ...

- 前端——语言——Core JS——《The good part》读书笔记——附录三,四,五(JSLint,铁路图,JSON)

1.JSLint 本书的JSLint部分只是一个引言,详细了解该工具的使用参考http://www.jslint.com/ 2.铁路图 在本书中使用过的铁路图集中放在这部分附录中,其实读完本书之后,没 ...

- 每天进步一点点------Sobel算子(3)基于彩色图像边缘差分的运动目标检测算法

摘 要: 针对目前常用的运动目标提取易受到噪声影响.易出现阴影和误检漏检等情况,提出了一种基于Sobel算子的彩色边缘图像检测和帧差分相结合的检测方法.首先用Sobel算子提取视频流中连续4帧图像的 ...

- plotly线上绘图和离线绘图的区别

1.线上绘图 import plotly import plotly.plotly as py import plotly.graph_objs as go plotly.tools.set_cred ...

- PAT 1017 Queueing at Bank (模拟)

Suppose a bank has K windows open for service. There is a yellow line in front of the windows which ...

- [Python] [转] python.exe和pythonw.exe的区别(区分.py、.pyw、.pyc文件)

Windows系统搭建好Python的环境后,进入Python的安装目录,大家会发现目录中有python.exe和pythonw.exe两个程序.如下图所示: 它们到底有什么区别和联系呢? 概括说明一 ...

- C语言 排序算法

冒泡排序 冒泡排序(英语:Bubble Sort)是一种简单的排序算法.它重复地走访过要排序的数列,一次比较两个元素,如果他们的顺序(如从大到小.首字母从A到Z)错误就把他们交换过来. 过程演示: 选 ...