第三篇:Logstash 安装配置

Logstash 简介:

Logstash 是一个实时数据收集引擎,可收集各类型数据并对其进行分析,过滤和归纳。按照自己条件分析过滤出符合数据导入到可视化界面。Logstash 建议使用java1.8 有些版本是不支持的,比如java1.9。

一. 下载安装jdk1.8

下载地址:http://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html

下载好的安装包上传到cpy04.dev.xjh.com的/usr/local/ 目录下并三执行如下操作:

#解压文件

tar xf /usr/local/jdk1.8.0_111.tar.gz -C /usr/local

mv /usr/local/jdk1.8.0_111 /usr/local/jdk-1.8.0

#添加环境变量

alternatives --install /usr/bin/java java /usr/local/jdk1.8.0/jre/bin/java 3000

alternatives --install /usr/bin/jar jar /usr/local/jdk1.8.0/bin/jar 3000

alternatives --install /usr/bin/javac javac /usr/local/jdk1.8.0/bin/javac 3000

alternatives --install /usr/bin/javaws javaws /usr/local/jdk1.8.0/jre/bin/javaws 3000

alternatives --set java /usr/local/jdk1.8.0/jre/bin/java

alternatives --set jar /usr/local/jdk1.8.0/bin/jar

alternatives --set javac /usr/local/jdk1.8.0/bin/javac

alternatives --set javaws /usr/local/jdk1.8.0/jre/bin/javaws

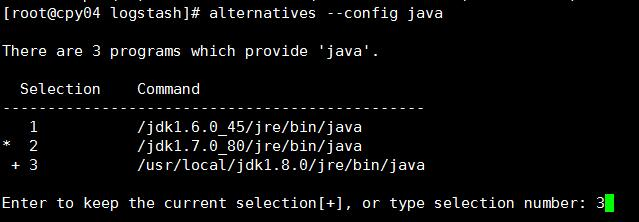

#切换java 版本

alternatives --config java

二. 安装logstash

1. 登陆cpy04.dev.xjh.com(需下载其他版本请点击:https://www.elastic.co/downloads/logstash )

wget https://artifacts.elastic.co/downloads/logstash/logstash-5.6.1.tar.gz -o /opt/logstash-5.6.1.tar.gz

tar xf /opt/logstash-5.6.1.tar.gz -C /usr/local

mv /usr/local/logstash-5.6.1 /usr/local/logstash

三、配置logstash

1. 编辑 /usr/local/logstash/config/logstash.yml配置文件修改如下内容:

node.name: cpy04.dev.xjh.com #设置节点名称,一般写主机名

path.data: /usr/local/logstash/plugin-data #创建logstash 和插件使用的持久化目录

config.reload.automatic: true #开启配置文件自动加载

config.reload.interval: 10 #定义配置文件重载时间周期

http.host: "cpy04.dev.xjh.com" #定义访问主机名,一般为域名或IP

2. 新建持久化目录:

mkdir -p /usr/local/logstash/plugin-data

3. 配置logstash 从Filebeat 输入、过滤、输出至elasticsearch(logstash 有非常多插件,详见官网,此处不列举)

3.1 安装logstash-input-jdbc 和logstash-input-beats-master 插件

/usr/local/logstash/bin/logstash-plugin install logstash-input-jdbc

wget https://github.com/logstash-plugins/logstash-input-beats/archive/master.zip -O /opt/master.zip

unzip -d /usr/local/logstash /opt/master.zip

3.2 配置logstash input 段

vim /usr/local/logstash/from_beat.conf

input {

beats {

port => 5044

}

}

output {

stdout { codec => rubydebug }

}

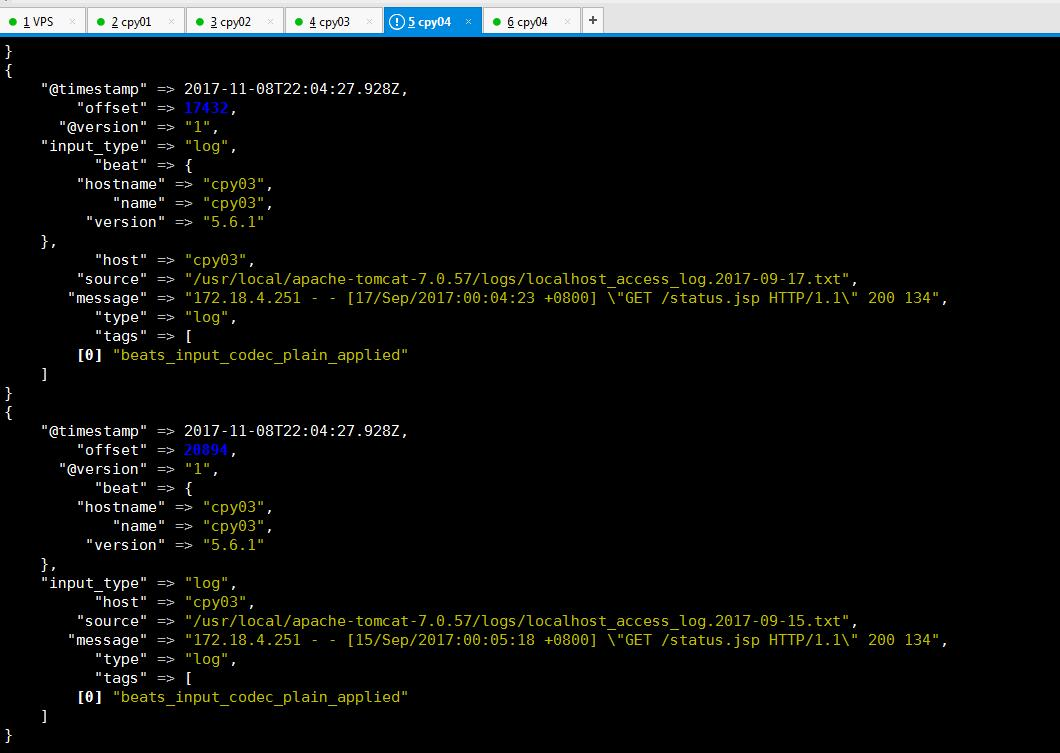

启动logstash 看是否能接收到filebeat 传过来的日志内容,要确保filebeat 在日志节点上启动正常。此时只测试传入是否正常,并未对原始日志进行过滤和筛选

/usr/local/logstash/bin/logstash -f /usr/local/logstash/config/from_beat.conf

启动后如果没有报错需要等待logstash 完成,此时间可能比较长

3.3 配置 logstash filter 段,修改/usr/local/logstash/from_beat.conf 为以下内容,配置完成后再次启动logstash,此时如果成功,输出内容应该是自己正则表达式捕获后的字段切分内容。

input {

beats {

port => 5044

}

}

filter {

#过滤access 日志

if ( [source] =~ "localhost\_access\_log" ) {

grok {

match => {

message => [ "%{COMMONAPACHELOG}" ]

}

}

date {

match => [ "request_time", "ISO8601" ]

locale => "cn"

target => "request_time"

}

#过滤tomcat日志

} else if ( [source] =~ "catalina" ) {

#使用正则匹配内容到字段

grok {

match => {

message => [ "(?<webapp_name>\[\w+\])\s+(?<request_time>\d{4}\-\d{2}\-\d{2}\s+\w{2}\:\w{2}\:\w{2}\,\w{3})\s+(?<log_level>\w+)\s+(?<class_package>[^.^\s]+(?:\.[^.\s]+)+)\.(?<class_name>[^\s]+)\s+(?<message_content>.+)" ]

}

}

#解析请求时间

date {

match => [ "request_time", "ISO8601" ]

locale => "cn"

target => "request_time"

}

} else {

drop {}

}

}

output {

stdout { codec => rubydebug }

}

3.4 配置 过滤后内容输出至elasticsearch,修改from_beat.conf 文件为以下内容:

input {

beats {

port => 5044

}

}

filter {

#过滤access 日志

if ( [source] =~ "localhost\_access\_log" ) {

grok {

match => {

message => [ "%{COMMONAPACHELOG}" ]

}

}

date {

match => [ "request_time", "ISO8601" ]

locale => "cn"

target => "request_time"

}

#过滤tomcat日志

} else if ( [source] =~ "catalina" ) {

#匹配内容到字段

grok {

match => {

message => [ "(?<webapp_name>\[\w+\])\s+(?<request_time>\d{4}\-\d{2}\-\d{2}\s+\w{2}\:\w{2}\:\w{2}\,\w{3})\s+(?<log_level>\w+)\s+(?<class_package>[^.^\s]+(?:\.[^.\s]+)+)\.(?<class_name>[^\s]+)\s+(?<message_content>.+)" ]

}

}

#解析请求时间

date {

match => [ "request_time", "ISO8601" ]

locale => "cn"

target => "request_time"

}

} else {

drop {}

}

}

output {

if ( [source] =~ "localhost_access_log" ) {

elasticsearch {

hosts => ["cpy04.dev.xjh.com:9200"]

index => "access_log"

}

} else {

elasticsearch {

hosts => ["cpy04.dev.xjh.com:9200"]

index => "tomcat_log"

}

}

stdout { codec => rubydebug }

}

至此,logstash 配置完成。如果需要做其他过滤或者输出至除elasticsearch 以外插件,如kafka 详见:https://www.elastic.co/guide/en/logstash/current/index.html

input {beats {port => 5044}}filter { #过滤access 日志 if ( [source] =~ "localhost\_access\_log" ) { grok { match => { message => [ "%{COMMONAPACHELOG}" ] } } date { match => [ "request_time", "ISO8601" ] locale => "cn" target => "request_time" } #过滤tomcat日志 } else if ( [source] =~ "catalina" ) { #匹配内容到字段 grok { match => {message => [ "(?<webapp_name>\[\w+\])\s+(?<request_time>\d{4}\-\d{2}\-\d{2}\s+\w{2}\:\w{2}\:\w{2}\,\w{3})\s+(?<log_level>\w+)\s+(?<class_package>[^.^\s]+(?:\.[^.\s]+)+)\.(?<class_name>[^\s]+)\s+(?<message_content>.+)" ] } } #解析请求时间 date { match => [ "request_time", "ISO8601" ] locale => "cn" target => "request_time" } } else { drop {} }}output { if ( [source] =~ "localhost_access_log" ) { elasticsearch { hosts => ["cpy04.dev.xjh.com:9200"] index => "access_log" } } else { elasticsearch { hosts => ["cpy04.dev.xjh.com:9200"] index => "tomcat_log" } } stdout { codec => rubydebug }}第三篇:Logstash 安装配置的更多相关文章

- 从0开始搭建SQL Server 2012 AlwaysOn 第三篇(安装数据,配置AlwaysOn)

这一篇是从0开始搭建SQL Server 2012 AlwaysOn 的第三篇,这一篇才真正开始搭建AlwaysOn,前两篇是为搭建AlwaysOn 做准备的 操作步骤: 1.安装SQL server ...

- Logstash 安装配置使用

一.Windows下安装运行 官网下载,下载与elasticSearch同一个版本,zip格式.Logstash占用内存较大,我在使用的时候cpu一般都是冲到90% 1.CMD直接运行 创建一个基本的 ...

- 构建Docker平台【第三篇】安装 kubernetes 组件

第一步:准备 1. 安装包: kubeadm-1.6.0-0.alpha.0.2074.a092d8e0f95f52.x86_64.rpm kubernetes-cni-0.3.0.1-0.07a8a ...

- logstash 安装 配置

1.Logstash 安装:在产生日志的服务器上安装 Logstash1.安装java环境 # yum install java-1.8.0-openjdk.x86_642.安装logstash(使用 ...

- tomcat(三)--基本安装配置

0x01 JDK和Tomcat安装 到oracle官网下载jdk,当前下载的版本是Linux x64 jdk-8u101-linux-x64.tar.gz 到apache官网下载tomcat,当前最 ...

- Flume篇---Flume安装配置与相关使用

一.前述 Copy过来一段介绍Apache Flume 是一个从可以收集例如日志,事件等数据资源,并将这些数量庞大的数据从各项数据资源中集中起来存储的工具/服务,或者数集中机制.flume具有高可用, ...

- [转载] 纯手打 第一篇:安装配置gradle

本文转载自: http://www.cnblogs.com/uncle2000/p/4276833.html 一个bug 一个脚印的叫你们用gradle. 1介于网络上的很多资料都是老的 不适用与现在 ...

- gradle教程 [原创](eclipse/ADT下 非插件 非Android Studio/AS)纯手打 第一篇:安装配置gradle

一个bug 一个脚印的叫你们用gradle. 1介于网络上的很多资料都是老的 不适用与现在的新版本gradle 尤其是有些gradle方法改名了老的用不了 2介于网上都是粘贴复制并且零碎我很蛋疼啊,走 ...

- logstash安装配置

vim /usr/local/logstash/etc/hello_search.conf 输入下面: input { stdin { type => "human" }} ...

随机推荐

- TestList汇总

[基本类型] 类的构造方法调用问题 重载复写的区别 Final finally finalized 的区别 定义final变量是否需要初始化 forward和redirect的区别 equals方法和 ...

- About Markdown -- 进入Markdown园子

起初也就是打算简单一些Markdown在编辑Blog方面的一些常用操作和注意事项,没想到,一下没刹住,毫无防备地闯进了这个好趣的园子-. 1. 认识 Markdown HTML(HyperText M ...

- Linux系统入门命令100条 转

https://www.howtoforge.com/linux-commands/ 2017-04-27 RiboseYim 睿哥杂货铺 Author : Himanshu Arora 原文:htt ...

- html 打印代码,支持翻页

ylbtech_html_print html打印代码,支持翻页 <html> <head> <meta name=vs_targetSchema content=&qu ...

- ElasticSearch 监控单个节点详解

1.介绍 集群健康 就像是光谱的一端——对集群的所有信息进行高度概述. 而 节点统计值 API 则是在另一端.它提供一个让人眼花缭乱的统计数据的数组,包含集群的每一个节点统计值. 节点统计值 提供的统 ...

- Android服务之bindService源代码分析

上一篇分析startService时没有画出调用ActivityManagerService之前的时序图,这里画出bindService的时序图.它们的调用流程是一致的. 先看ContextWrapp ...

- AJAX2.0

Ajax2.0 早期的ajax技术不支持异步文件上传 在后面更新了ajax2.0版本 支持文件上传了 但需要借助一个对象----FormData对象 Ajax2.0大体的步骤跟以前是一样的 但也是 ...

- shell通配符、命令代换、引号

1.通配符 (1)* :匹配多个任意字符 (2)? :匹配一个任意字符 (3)[若干字符] :匹配方括号中任意一个字符的一次出现 2.命令代换:反引号``或者$() 例1:vim test_th.sh ...

- linux下rar包的解压方法

linux下rar包的解压方法 学习了:https://blog.csdn.net/yonggeit/article/details/72190246?utm_source=itdadao&u ...

- Binder与interface

在Interface中,asBinder函数涌来将服务类接口类型转换为IBinder类型: 相反的,asInterface函数用来将Ibinder类型转换为服务接口类型