json数据处理实战:Kafka+Flume+Morphline+Solr+Hue数据组合索引

背景:Kafka消息总线的建成,使各个系统的数据得以在kafka节点中汇聚,接下来面临的任务是最大化数据的价值,让数据“慧”说话。

环境准备:

Kafka服务器*3。

CDH 5.8.3服务器*3,安装Flume,Solr,Hue,HDFS,Zookeeper服务。

Flume提供了可扩展的实时数据传输通道,Morphline提供了轻量级的ETL功能,SolrCloud+Hue提供了高性能搜索引擎和多样的数据展现形式。

12.20补充:(Hue的另外一种代替方式:Banana。)

2017.3.28补充:如果不使用CDH,而是使用开源的Flume+Solr=>纪录:Solr6.4.2+Flume1.7.0 +kafka集成

一.环境安装(略)

二.修改CDH默认配置:

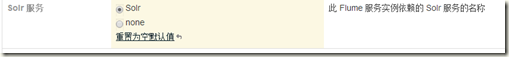

1.在Flume配置界面配置Flume依赖Solr。

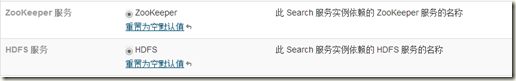

2.在Solr配置界面配置Solr使用Zookeeper存储配置文件,使用HDFS存储索引文件。

3.在Hue配置界面配置Hue依赖Solr

4.配置Hue界面可以被外网访问。

三.按场景配置各CDH服务及开发代码。

Kafka Topic: eventCount

Topic数据格式:

{

"timestamp": "1481077173000",

"accountName": "旺小宝",

"tagNames": [

"incoming"

],

"account": "WXB",

"eventType": "phone",

"eventTags": [

{

"value": 1,

"name": "incoming"

}

]

}

1.Solr创建对应Collection。

1)登录任意CDH节点。生成collection配置文件骨架。

$ solrctl instancedir --generate $HOME/solr_configs

2)找到文件夹中的schema.xml文件,修改collection的schema。

第一步:修改field(先不要动type和dynamicField这些)。schema.xml中预定义了很多field,field对应的是json中需要被索引的字段。除了name=id,_root_,_version_不能去掉之外,其他的field可以去掉。

(Notice:json中的timestamp对应的是下面的eventTime,而下面的timestamp是flume接受kafka数据的时间。这是通过Morphline配置实现的转换)

<field name="id" type="string" indexed="true" stored="true" required="true" multiValued="false" /> <!-- points to the root document of a block of nested documents. Required for nested

document support, may be removed otherwise

-->

<field name="_root_" type="string" indexed="true" stored="false"/>

<field name="account" type="string" indexed="true" stored="true"/>

<field name="accountName" type="string" indexed="true" stored="true"/>

<field name="subaccount" type="string" indexed="true" stored="true"/>

<field name="subaccountName" type="string" indexed="true" stored="true"/>

<field name="eventTime" type="tlong" indexed="false" stored="true"/>

<field name="eventType" type="string" indexed="true" stored="true"/>

<field name="eventTags" type="string" indexed="true" stored="true" multiValued="true"/>

<field name="_attachment_body" type="string" indexed="false" stored="true"/>

<field name="timestamp" type="tlong" indexed="false" stored="true"/>

<field name="_version_" type="long" indexed="true" stored="true"/>

第二步:去掉所有copy field。

第三步:添加动态字段dynamicFiled。

<dynamicField name="tws_*" type="text_ws" indexed="true" stored="true" multiValued="true"/>

3) 上传配置,创建collection

$ solrctl instancedir --create event_count_records solr_configs

$ solrctl collection --create event_count_records -s 3 -c event_count_records

2.Flume配置

创建一个新的角色组kafka2solr,修改代理名称为kafka2solr,并为该角色组分配服务器。

# 配置 source channel sink 的名字

kafka2solr.sources = source_from_kafka

kafka2solr.channels = mem_channel

kafka2solr.sinks = solrSink # 配置Source类别为kafka

kafka2solr.sources.source_from_kafka.type = org.apache.flume.source.kafka.KafkaSource

kafka2solr.sources.source_from_kafka.channels = mem_channel

kafka2solr.sources.source_from_kafka.batchSize = 100

kafka2solr.sources.source_from_kafka.kafka.bootstrap.servers= kafkanode0:9092,kafkanode1:9092,kafkanode2:9092

kafka2solr.sources.source_from_kafka.kafka.topics = eventCount

kafka2solr.sources.source_from_kafka.kafka.consumer.group.id = flume_solr_caller

kafka2solr.sources.source_from_kafka.kafka.consumer.auto.offset.reset=latest #配置channel type为memory,通常生产环境中设置为file或者直接用kafka作为channel

kafka2solr.channels.mem_channel.type = memory

kafka2solr.channels.mem_channel.keep-alive = 60 # Other config values specific to each type of channel(sink or source)

# can be defined as well

# In this case, it specifies the capacity of the memory channel

kafka2solr.channels.mem_channel.capacity = 10000

kafka2solr.channels.mem_channel.transactionCapacity = 3000 # 配置sink到solr,并使用morphline转换数据

kafka2solr.sinks.solrSink.type = org.apache.flume.sink.solr.morphline.MorphlineSolrSink

kafka2solr.sinks.solrSink.channel = mem_channel

kafka2solr.sinks.solrSink.morphlineFile = morphlines.conf

kafka2solr.sinks.solrSink.morphlineId=morphline1

kafka2solr.sinks.solrSink.isIgnoringRecoverableExceptions=true

3.Flume-NG的Solr接收器配置

SOLR_LOCATOR : {

# Name of solr collection

collection : event_count_records

# ZooKeeper ensemble

#CDH的专有写法,开源版本不支持。

zkHost : "$ZK_HOST"

} morphlines : [

{

id : morphline1

importCommands : ["org.kitesdk.**", "org.apache.solr.**"] commands : [

{

#Flume传过来的kafka的json数据是用二进制流的形式,需要先读取json

readJson{}

} {

#读出来的json字段必须转换成filed才能被solr索引到

extractJsonPaths {

flatten:true

paths:{

account:/account

accountName:/accountName

subaccount:/subaccount

subaccountName:/subaccountName

eventTime:/timestamp

eventType:/eventType

eventTags:"/eventTags[]/name"

#按分钟存timestamp

eventTimeInMinute_tdt:/timestamp

#按小时存timestamp

eventTimeInHour_tdt:/timestamp

#按天存timestamp

eventTimeInDay_tdt:/timestamp

#_tdt后缀会被动态识别为日期类型的索引字段

#按不同时间间隔存索引以增加查询性能

} }

} #转换long型时间为Date格式

{convertTimestamp {

field : eventTimeInMinute_tdt

inputFormats : ["unixTimeInMillis"]

inputTimezone : UTC

outputFormat : "yyyy-MM-dd'T'HH:mm:ss.SSS'Z/MINUTE'"

outputTimezone : Asia/Shanghai

}} {convertTimestamp {

field : eventTimeInHour_tdt

inputFormats : ["unixTimeInMillis"]

inputTimezone : UTC

outputFormat : "yyyy-MM-dd'T'HH:mm:ss.SSS'Z/HOUR'"

outputTimezone : Asia/Shanghai

}}

{convertTimestamp {

field : eventTimeInDay_tdt

inputFormats : ["unixTimeInMillis"]

inputTimezone : UTC

outputFormat : "yyyy-MM-dd'T'HH:mm:ss.SSS'Z/DAY'"

outputTimezone : Asia/Shanghai

}} #kafka中的json数据传到flume中时会被放入_attachment_body字段,readJson后会变成JsonNode对象,需要toString之后才能保存

{toString { field : _attachment_body }} #为每一条记录生成一个UUID

{generateUUID {

field : id

}} #对未定义的Solr字段加tws前缀,根据schema.xml中定义的tws_*为text_ws类型,会动态未未定义的字段建索引。

{

sanitizeUnknownSolrFields {

# Location from which to fetch Solr schema

solrLocator : ${SOLR_LOCATOR}

renameToPrefix:"tws_"

}

} #将数据导入到solr中

{loadSolr {solrLocator : ${SOLR_LOCATOR}}}

]

}

]

重启被影响的Flume节点,数据开始导入solr。

3.通过Hue查询Solr中的数据。

(作者卡尔:http://www.cnblogs.com/arli/p/6158771.html )

json数据处理实战:Kafka+Flume+Morphline+Solr+Hue数据组合索引的更多相关文章

- Cloudera5.8.3:Flume+Morphline+Solr开发小技巧

1.Flume和Morphline添加日志打印 log4j.logger.org.apache.flume.sink.solr=DEBUG log4j.logger.org.kitesdk.morph ...

- python接口自动化(十九)--Json 数据处理---实战(详解)

简介 上一篇说了关于json数据处理,是为了断言方便,这篇就带各位小伙伴实战一下.首先捋一下思路,然后根据思路一步一步的去实现和实战,不要一开始就盲目的动手和无头苍蝇一样到处乱撞,撞得头破血流后而放弃 ...

- Spark SQL JSON数据处理

背景 这一篇可以说是“Hive JSON数据处理的一点探索”的兄弟篇. 平台为了加速即席查询的分析效率,在我们的Hadoop集群上安装部署了Spark Server,并且与我们的Hive数据仓 ...

- Kafka实战-Flume到Kafka

1.概述 前面给大家介绍了整个Kafka项目的开发流程,今天给大家分享Kafka如何获取数据源,即Kafka生产数据.下面是今天要分享的目录: 数据来源 Flume到Kafka 数据源加载 预览 下面 ...

- 【转】Kafka实战-Flume到Kafka

Kafka实战-Flume到Kafka Kafka 2015-07-03 08:46:24 发布 您的评价: 0.0 收藏 2收藏 1.概述 前面给大家介绍了整个Kafka ...

- Kafka实战-Flume到Kafka (转)

原文链接:Kafka实战-Flume到Kafka 1.概述 前面给大家介绍了整个Kafka项目的开发流程,今天给大家分享Kafka如何获取数据源,即Kafka生产数据.下面是今天要分享的目录: 数据来 ...

- How-to: Do Real-Time Log Analytics with Apache Kafka, Cloudera Search, and Hue

Cloudera recently announced formal support for Apache Kafka. This simple use case illustrates how to ...

- MySQL数据实时增量同步到Kafka - Flume

转载自:https://www.cnblogs.com/yucy/p/7845105.html MySQL数据实时增量同步到Kafka - Flume 写在前面的话 需求,将MySQL里的数据实时 ...

- JSON数据处理框架Jackson精解第一篇-序列化与反序列化核心用法

Jackson是Spring Boot默认的JSON数据处理框架,但是其并不依赖于任何的Spring 库.有的小伙伴以为Jackson只能在Spring框架内使用,其实不是的,没有这种限制.它提供了很 ...

随机推荐

- Spring MVC静态资源处理(转)

优雅REST风格的资源URL不希望带 .html 或 .do 等后缀.由于早期的Spring MVC不能很好地处理静态资源,所以在web.xml中配置DispatcherServlet的请求映射,往往 ...

- oracle sql初次接触

oracle 语法有些地方都是和mysql一样,但还是有很多不同之处: 注意:dual该表为oracle中本身就存在的数据表.比如想取数据库时间(系统时间)就可以用这张表来完成. 创建表语法: cre ...

- 泛函编程(35)-泛函Stream IO:IO处理过程-IO Process

IO处理可以说是计算机技术的核心.不是吗?使用计算机的目的就是希望它对输入数据进行运算后向我们输出计算结果.所谓Stream IO简单来说就是对一串按序相同类型的输入数据进行处理后输出计算结果.输入数 ...

- FreeBSD-安装与配置(10.3@VMware)

(#今天尝试了一天,装上了FreeBSD:记录几个重要的地方 bsdinstall/bsdconfig 善用ports,本地源 善用handbook以及doc pkg install XXX,装上Xo ...

- java 克隆

1. About Java中, 对于基本数据类型可以使用"=" 来克隆,此时两个对象除了相等是没有任何关系的; 而对于引用类型, 却不能简单地使用"="来克隆, ...

- 左求值表达式,堆栈,调试陷阱与ORM查询语言的设计

1,表达式的求值顺序与堆栈结构 “表达式” 是程序语言一个很重要的术语,也是大家天天写的程序中很常见的东西,但是表达式的求值顺序一定是从左到右么? C/C++语言中没有明确规定表达式的运算顺序(从左到 ...

- Dynamics.js - 创建逼真的物理动画的 JS 库

Dynamics.js 是一个用来创建物理动画 JavaScript 库.你只需要把dynamics.js引入你的页面,然后就可以激活任何 DOM 元素的 CSS 属性动画,也可以用户 SVG 属性. ...

- 让你忘记 Flash 的15款精彩 HTML5 游戏

HTML5 游戏开发是一个热门的话题,开发人员和设计人员最近经常谈论到.虽然不能迅速取代 Flash 的地位,但是 HTML5 凭借它的开放性和强大的编程能力,取代 Flash 是必然的趋势.你会看到 ...

- slid.es – 创建在线幻灯片和演示文稿的最佳途径

slid.es 提供了一种创建在线幻灯片和演示文稿的简单方法,让你通过几个简单的步骤制作效果精美的在线演示文稿.基于 HTML5 和 CSS3 实现,在现代浏览器中效果最佳. 您可能感兴趣的相关文章 ...

- 【web前端面试题整理07】我不理解表现与数据分离。。。

拜师传说 今天老夫拜师了,老夫有幸认识一个JS高手,在此推荐其博客,悄悄告诉你,我拜他为师了,他承诺我只收我一个男弟子..... 师尊刚注册的账号,现在博客数量还不多,但是后面点会有干货哦,值得期待. ...