KNN近邻算法

K近邻(KNN,k-NearestNeighbor)分类算法是数据挖掘分类技术中最简单的方法之一。所谓K最近邻,就是k个最近的邻居的意思,说的是每个样本都可以用它最接近的k个邻居来代表。kNN算法的核心思想是如果一个样本在特征空间中的k个最相邻的样本中的大多数属于某一个类别,则该样本也属于这个类别,并具有这个类别上样本的特性。该方法在确定分类决策上只依据最邻近的一个或者几个样本的类别来决定待分样本所属的类别。 kNN方法在类别决策时,只与极少量的相邻样本有关。由于kNN方法主要靠周围有限的邻近的样本,而不是靠判别类域的方法来确定所属类别的,因此对于类域的交叉或重叠较多的待分样本集来说,kNN方法较其他方法更为适合。

-- 邻近算法 百度百科

KNN近邻算法思想

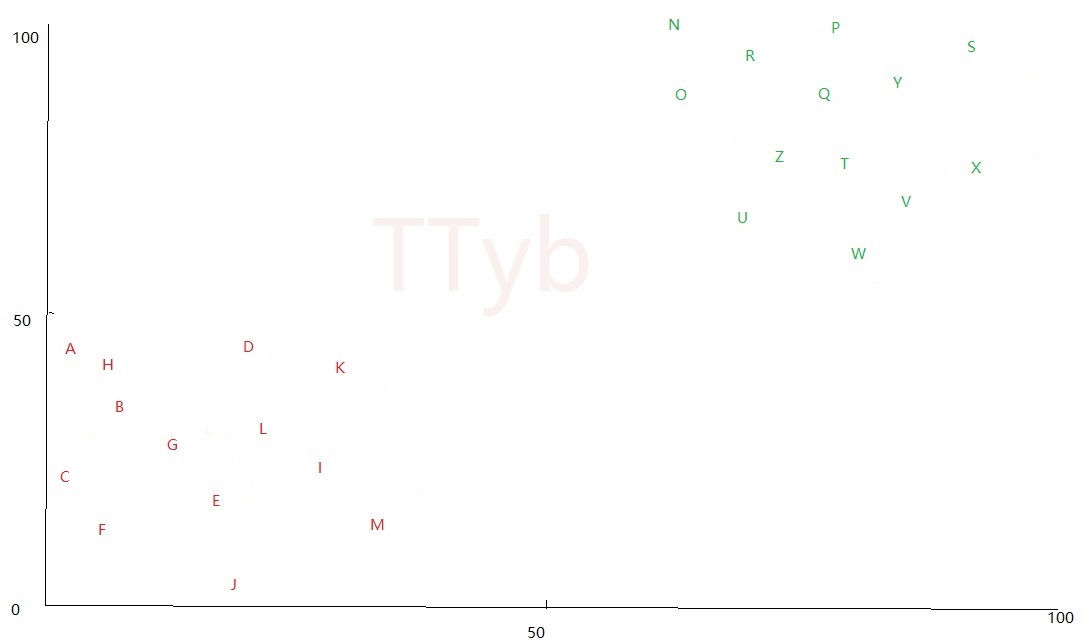

根据上文 K-means 算法分类,可以将一堆 毫无次序 的样本分成N个簇,如下:

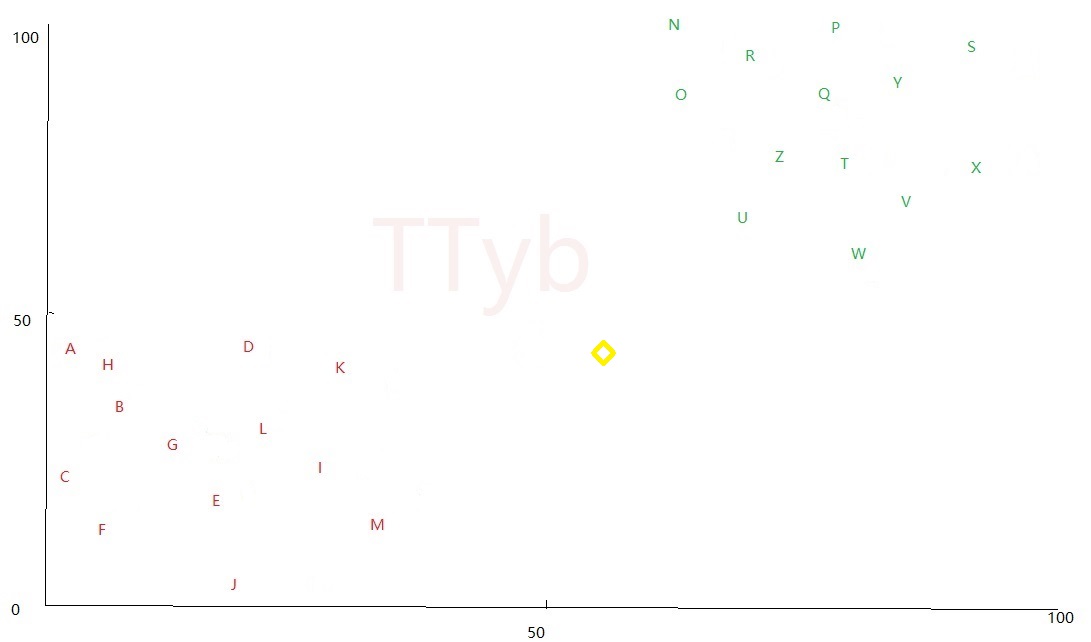

上图中红色代表一个分簇,绿色代表另一个分簇,这两个簇现在可以称呼为 训练样本 ,现在突然出现了一个 黄色的四边形 ,如下:

该 黄色的四边形 现在还不知道属于哪一个分簇。选取 黄色的四边形 周围的 K个点 (K一定要是奇数):

- 当K=3时,直观看出 黄色的四边形 周围的3个点为:K、M、U,就可以判断 黄色的四边形 属于红色簇

- 当K=4时,直观看出 黄色的四边形 周围的3个点为:K、M、U、W,无法判断 黄色的四边形 属于哪个簇,因此不能为偶数

- 当K=5时,直观看出 黄色的四边形 周围的3个点为:K、M、U、W、Z,就可以判断 黄色的四边形 属于绿色簇

KNN近邻算法就是以一定量的训练样本,来对其他未知样本进行分类,分类的标准和选取的K值有很大关系

KNN近邻算法实现

假设训练样本为:

clusters = {

'cluster2': {'H': {'y': 25, 'x': 27}, 'F': {'y': 30, 'x': 36}, 'G': {'y': 14, 'x': 31}, 'A': {'y': 34, 'x': 24},

'D': {'y': 33, 'x': 25}, 'I': {'y': 11, 'x': 28}, 'C': {'y': 23, 'x': 26}, 'E': {'y': 23, 'x': 38},

'B': {'y': 23, 'x': 6}, 'L': {'y': 15, 'x': 7}, 'K': {'y': 25, 'x': 17}, 'M': {'y': 39, 'x': 24},

'J': {'y': 26, 'x': 21}},

'cluster1': {'R': {'y': 97, 'x': 80}, 'N': {'y': 82, 'x': 99}, 'U': {'y': 81, 'x': 95}, 'V': {'y': 88, 'x': 79},

'O': {'y': 85, 'x': 73}, 'Y': {'y': 99, 'x': 87}, 'X': {'y': 72, 'x': 88},

'Q': {'y': 84, 'x': 100}, 'T': {'y': 70, 'x': 84}, 'W': {'y': 100, 'x': 89},

'S': {'y': 67, 'x': 86}, 'Z': {'y': 97, 'x': 66}, 'P': {'y': 88, 'x': 62}}}

随机生成一个point:

# 随机生成一个点

def buildpoint():

temp = {}

x = random.randint(0, 100)

y = random.randint(0, 100)

temp["x"] = x

temp["y"] = y

return temp

分别计算计算这个point与26个字母的 欧氏距离

# 取得point与K个值的距离

def classify(K, clusters, point):

dict = {}

distan = {}

for cluster in clusters:

for key in clusters[cluster].keys():

distan[key] = distance(clusters[cluster][key]["x"], point["x"], clusters[cluster][key]["y"], point["y"])

# reverse=False值按照从小到大排序

distan = sorted(distan.items(), key=lambda d: d[1], reverse=False)

for i in range(K):

key = distan[i][0]

value = distan[i][1]

dict[key] = value

return dict

返回的距离 distan 为:

# [('E', 21.02379604162864), ('F', 21.095023109728988), ('H', 30.805843601498726), ('G', 31.622776601683793), ('D', 32.01562118716424), ('C', 32.28002478313795), ('A', 33.06055050963308), ('M', 33.734255586866), ('I', 35.805027579936315), ('J', 36.49657518178932), ('K', 40.607881008493905), ('S', 45.45327270945405), ('T', 46.61544808322666), ('X', 50.60632371551998), ('B', 51.78802950489621), ('L', 52.81098370604357), ('O', 55.362442142665635), ('P', 56.22277118748239), ('V', 60.166435825965294), ('U', 62.00806399170998), ('N', 65.29931086925804), ('Z', 65.62011886609167), ('Q', 67.47592163134935), ('R', 68.9492567037528), ('Y', 73.40980860893181), ('W', 75.15317691222374)]

因为本文选取的 K=3 ,所以返回了距离point最近的3个点:

# {'U': 30.805843601498726, 'M': 21.02379604162864, 'K': 21.095023109728988}

最后判断这3个点属于哪个分簇即可:

def judgecluster(dict, clusters):

newdict = {}

for cluster in clusters:

for key in dict.keys():

if key in clusters[cluster]:

if cluster in newdict:

newdict[cluster] += 1

else:

newdict[cluster] = 1

newdict = sorted(newdict.items(), key=lambda d: d[1], reverse=True)

print("Point属于分簇" + str(newdict[0][0]))

print(newdict)

return newdict

返回的结果为:

# [('cluster2', 2), ('cluster1', 1)]

Point属于分簇cluster2

源码在我的博客上面:

KNN近邻算法的更多相关文章

- 机器学习之利用KNN近邻算法预测数据

前半部分是简介, 后半部分是案例 KNN近邻算法: 简单说就是采用测量不同特征值之间的距离方法进行分类(k-Nearest Neighbor,KNN) 优点: 精度高.对异常值不敏感.无数据输入假定 ...

- 机器学习入门KNN近邻算法(一)

1 机器学习处理流程: 2 机器学习分类: 有监督学习 主要用于决策支持,它利用有标识的历史数据进行训练,以实现对新数据的表示的预测 1 分类 分类计数预测的数据对象是离散的.如短信是否为垃圾短信,用 ...

- 机器学习实战笔记(Python实现)-01-K近邻算法(KNN)

--------------------------------------------------------------------------------------- 本系列文章为<机器 ...

- 基本分类方法——KNN(K近邻)算法

在这篇文章 http://www.cnblogs.com/charlesblc/p/6193867.html 讲SVM的过程中,提到了KNN算法.有点熟悉,上网一查,居然就是K近邻算法,机器学习的入门 ...

- 机器学习之K近邻算法(KNN)

机器学习之K近邻算法(KNN) 标签: python 算法 KNN 机械学习 苛求真理的欲望让我想要了解算法的本质,于是我开始了机械学习的算法之旅 from numpy import * import ...

- class-k近邻算法kNN

1 k近邻算法2 模型2.1 距离测量2.2 k值选择2.3 分类决策规则3 kNN的实现--kd树3.1 构造kd树3.2 kd树搜索 1 k近邻算法 k nearest neighbor,k-NN ...

- 机器学习——KNN算法(k近邻算法)

一 KNN算法 1. KNN算法简介 KNN(K-Nearest Neighbor)工作原理:存在一个样本数据集合,也称为训练样本集,并且样本集中每个数据都存在标签,即我们知道样本集中每一数据与所属分 ...

- k近邻算法(KNN)

k近邻算法(KNN) 定义:如果一个样本在特征空间中的k个最相似(即特征空间中最邻近)的样本中的大多数属于某一个类别,则该样本也属于这个类别. from sklearn.model_selection ...

- 1. K近邻算法(KNN)

1. K近邻算法(KNN) 2. KNN和KdTree算法实现 1. 前言 K近邻法(k-nearest neighbors,KNN)是一种很基本的机器学习方法了,在我们平常的生活中也会不自主的应用, ...

随机推荐

- iOS thirdKeyboard Develop (APP Extension)

如果需要开发第三方键盘 首先得了解一下苹果官方文档 https://developer.apple.com/library/ios/documentation/General/Conceptual/ ...

- Spring中的自动装配

src\dayday\Person.java package dayday;/** * Created by I am master on 2016/11/28. */public class Per ...

- 使用USRP探索无线世界 Part 1:USRP从入门到追踪飞机飞行轨迹

温馨提示:请自觉遵守无线电管理法规,依法设置和使用无线电设备 0×00 前言 USRP是数款流行的SDR硬件中功能和应用都相对成熟的一款产品,从WIFI协议.ZigBee协议.RFID协议.GSM通信 ...

- AJAX实现异步登录

//代码较为简单,只是测试所用 1.html登录页面代码 <table> <tr> <td>用户名:</td> <td><input ...

- C++利用IO流对浮点数进行格式化控制输出

浮点数输出 (100/100 分数) 题目描述 编写一个程序,输入一个浮点数和输出格式要求,按照格式要求将该浮点数输出.给定非负整数m和n,表示输出的浮点数小数点前的宽度为m,若宽度不够则在前面补0, ...

- js 关键字和保留字

不能把关键字.保留字.true.false和null用作标识符. js中的关键字可用于表示控制语句的开始或结束,或者用于执行特定操作等.按照规则,关键字也是语言保留的,不能用作标识符.以下就是ECMA ...

- JavaScript设计模式学习笔记

1 JavaScript设计模式深入分析 私有属性和方法:函数有作用域,在函数内用var 关键字声明的变量在外部无法访问,私有属性和方法本质就是你希望在对象外部无法访问的变量. 特权属性和方法:创建属 ...

- 什么是 JSON ?

什么是 JSON ? JSON 指的是 JavaScript 对象表示法(JavaScript Object Notation) JSON 是轻量级的文本数据交换格式 JSON 独立于语言 JSON ...

- C++学习笔记33:泛型编程拓展2

调用标准模板库的find()函数查找数组元素 例子: #include <iostream> #include <algorithm> using namespace std; ...

- 记账类APP竞品分析-挖财与随手记

注:本文更新中. 一.概览 1. 产品名称及版本 l 挖财11.2.0.0 免费版(2016/9/6发布) l 随手记10.2.8免费版(2016/8/22发布) 2. 设备信息 设备型号:i ...