Hive(4)-Hive的数据类型

一. 基本数据类型

|

Hive数据类型 |

Java数据类型 |

长度 |

例子 |

|

TINYINT |

byte |

1byte有符号整数 |

20 |

|

SMALINT |

short |

2byte有符号整数 |

20 |

|

INT |

int |

4byte有符号整数 |

20 |

|

BIGINT |

long |

8byte有符号整数 |

20 |

|

BOOLEAN |

boolean |

布尔类型,true或者false |

TRUE FALSE |

|

FLOAT |

float |

单精度浮点数 |

3.14159 |

|

DOUBLE |

double |

双精度浮点数 |

3.14159 |

|

STRING |

string |

字符系列。可以指定字符集。可以使用单引号或者双引号。 |

‘now is the time’ “for all good men” |

|

TIMESTAMP |

时间类型 |

||

|

BINARY |

字节数组 |

对于Hive的String类型相当于数据库的varchar类型,该类型是一个可变的字符串,不过它不能声明其中最多能存储多少个字符,理论上它可以存储2GB的字符数。

二.集合数据类型

|

数据类型 |

描述 |

语法示例 |

|

STRUCT |

和c语言中的struct类似,都可以通过“点”符号访问元素内容。例如,如果某个列的数据类型是STRUCT{first STRING, last STRING},那么第1个元素可以通过字段.first来引用。 |

struct() 例如struct<street:string, city:string> |

|

MAP |

MAP是一组键-值对元组集合,使用数组表示法可以访问数据。例如,如果某个列的数据类型是MAP,其中键->值对是’first’->’John’和’last’->’Doe’,那么可以通过字段名[‘last’]获取最后一个元素 |

map() 例如map<string, int> |

|

ARRAY |

数组是一组具有相同类型和名称的变量的集合。这些变量称为数组的元素,每个数组元素都有一个编号,编号从零开始。例如,数组值为[‘John’, ‘Doe’],那么第2个元素可以通过数组名[1]进行引用。 |

Array() 例如array<string> |

Hive有三种复杂数据类型ARRAY、MAP 和 STRUCT。ARRAY和MAP与Java中的Array和Map类似,而STRUCT与C语言中的Struct类似,它封装了一个命名字段集合,复杂数据类型允许任意层次的嵌套。

三.数据转换

Hive的原子数据类型是可以进行隐式转换的,类似于Java的类型转换,例如某表达式使用INT类型,TINYINT会自动转换为INT类型,但是Hive不会进行反向转化,例如,某表达式使用TINYINT类型,INT不会自动转换为TINYINT类型,它会返回错误,除非使用CAST操作。

1. 隐式类型转换规则如下

1). 任何整数类型都可以隐式地转换为一个范围更广的类型,如TINYINT可以转换成INT,INT可以转换成BIGINT。

2). 所有整数类型、FLOAT和STRING类型都可以隐式地转换成DOUBLE。

3). TINYINT、SMALLINT、INT都可以转换为FLOAT。

4). BOOLEAN类型不可以转换为任何其它的类型。

2. 可以使用CAST操作显示进行数据类型转换

例如CAST('1' AS INT)将把字符串'1' 转换成整数1;如果强制类型转换失败,如执行CAST('X' AS INT),表达式返回空值 NULL。

四.案例实操

1. 假设某表有如下一行,我们用JSON格式来表示其数据结构。在Hive下访问的格式为

{

"name": "nty",

"friends": ["pengpeng" , "junjun"] , //列表Array,

"children": { //键值Map,

"ritian": 8 ,

"tuntian": 3

}

"address": { //结构Struct,

"street": "tuan jie hu" ,

"city": "beijing"

}

}

2. 基于上述数据结构,我们在Hive里创建对应的表,并导入数据。创建本地测试文件test.txt

kv之间用,分割 Array用_分割 Map用:分割

nty,pengpeng_junjun,ritian:8_tuntian:3,tuan jie hu_beijing

3. 创建测试表

create table test (

name string,

friends array<string>,

children map<string, int>,

address struct<street:string, city:string>

)

row format delimited fields terminated by ','

collection items terminated by '_'

map keys terminated by ':'

lines terminated by '\n';

字段解释:

row format delimited fields terminated by ',' -- 列分隔符

collection items terminated by '_' --MAP STRUCT 和 ARRAY 的分隔符(数据分割符号)

map keys terminated by ':' -- MAP中的key与value的分隔符

lines terminated by '\n'; -- 行分隔符

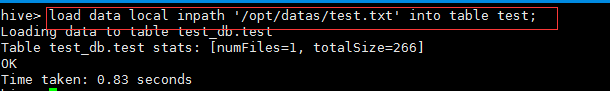

4. 导入文件到测试表

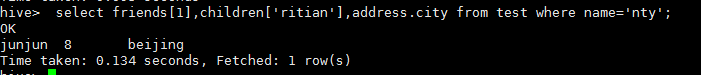

5. 查询

感觉少了点什么

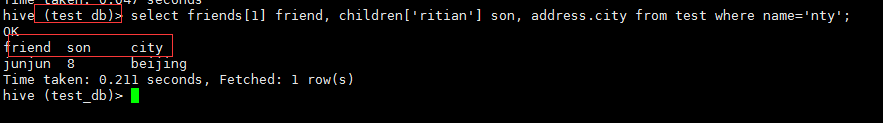

退出hive客户端,cd到conf目录下,修改hive-site.xml,添加以下两个配置

<property>

<name>hive.cli.print.header</name>

<value>true</value>

</property> <property>

<name>hive.cli.print.current.db</name>

<value>true</value>

</property>

再bin/hive一下,重新查询一下,显示了在操作的数据库和查询头

Hive(4)-Hive的数据类型的更多相关文章

- 大数据时代的技术hive:hive的数据类型和数据模型

在上篇文章里,我列举了一个简单的hive操作实例,创建了一张表test,并且向这张表加载了数据,这些操作和关系数据库操作类似,我们常把hive和关系数据库进行比较,也正是因为hive很多知识点和关系数 ...

- Hive的基本操作和数据类型

Hive的基本操作 1.启动Hive bin/hive 2.查看数据库 hive>show databases; 3. 打开默认数据库 hive>use default; 4.显示defa ...

- Hive(三)hive的高级操作

一.hive的各种join操作 语法结构:join_table:table_reference JOIN table_factor [join_condition]| table_reference ...

- Hive 文件格式 & Hive操作(外部表、内部表、区、桶、视图、索引、join用法、内置操作符与函数、复合类型、用户自定义函数UDF、查询优化和权限控制)

本博文的主要内容如下: Hive文件存储格式 Hive 操作之表操作:创建外.内部表 Hive操作之表操作:表查询 Hive操作之表操作:数据加载 Hive操作之表操作:插入单表.插入多表 Hive语 ...

- (hive)hive优化(转载)

1. 概述 1.1 hive的特征: 可以通过SQL轻松访问数据的工具,从而实现数据仓库任务,如提取/转换/加载(ETL),报告和数据分析: 它可以使已经存储的数据结构化: 可以直接访问存储在Apac ...

- 【hive】——Hive四种数据导入方式

Hive的几种常见的数据导入方式这里介绍四种:(1).从本地文件系统中导入数据到Hive表:(2).从HDFS上导入数据到Hive表:(3).从别的表中查询出相应的数据并导入到Hive表中:(4).在 ...

- ubuntu下搭建hive(包括hive的web接口)记录

Hive版本 0.12.0(独立模式) Hadoop版本 1.12.1 Ubuntu 版本 12.10 今天试着搭建了hive,差点迷失在了网上各种资料中,现在把我的经验分享给大家,亲手实践过,但未必 ...

- [Hive - LanguageManual] Hive Concurrency Model (待)

Hive Concurrency Model Hive Concurrency Model Use Cases Turn Off Concurrency Debugging Configuration ...

- Shell脚本运行hive语句 | hive以日期建立分区表 | linux schedule程序 | sed替换文件字符串 | shell推断hdfs文件文件夹是否存在

#!/bin/bash source /etc/profile; ################################################## # Author: ouyang ...

- Hive记录-Hive介绍(转载)

1.Hive是什么? Hive 是基于 Hadoop 的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供完整的 SQL 查询功能,将类 SQL 语句转换为 MapReduce 任务执 ...

随机推荐

- Linux 内核超时导致虚拟机无法正常启动

问题描述 当 Linux 虚拟机启动时,通过串口输出或者启动日志, 观察到超时的报错.导致虚拟机无法正常启动和连接. 问题分析 常见的超时报错范例如下: 复制 INFO: task swapper:1 ...

- HTML头部声明文件类型

在你每一个页面的顶端,你需要文件声明.是的,必须. 如果不指定文件类型,你的HTML不是合法的HTML,并且大部分浏览器会用“怪癖模式(quirks mode)”来处理页面,这意味着浏览器认为你自己也 ...

- MySQL半同步复制的搭建和配置原理

半同步复制: 什么是半同步复制?我们知道在默认情况下,MySQL的复制是异步的,这意味着主服务器及其从服务器是独立的.异步复制可以提供最佳的性能,因为主服务器在将更新的数据写入它的二进制日志(Binl ...

- MVC Dropdownlist数据绑定 默认值

@Html.DropDownList("Data", (SelectList)ViewBag.Data, new { @class = "form-control cho ...

- 使用websploit在局域网全自动渗透

原理为 websploit调用dnsdpoof进行dns欺骗配合神器metasploit的web_autopwn模块进行渗透:特点:过程基本全自动. 终端输入websploit打开websploit: ...

- Windows下设置Ubuntu引导项

最近在进行一些实验环境的配置,最终通过双系统实现了多系统的管理,而不仅限于虚拟机的方式.以此方式成功安装了Windows8.1 Pro和Windows 10,原文在此. 在此基础上进一步安装了 Ubu ...

- oracle中PLSQL存储过程中如何使用逗号分隔的集合(逗号分隔字符串转换为一个集合)

原文: https://blogs.oracle.com/aramamoo/entry/how_to_split_comma_separated_string_and_pass_to_in_claus ...

- UVALive 4025 Color Squares(BFS)

题目链接:UVALive 4025 Color Squares 按题意要求放带有颜色的块,求达到w分的最少步数. //yy:哇,看别人存下整个棋盘的状态来做,我什么都不想说了,不知道下午自己写了些什么 ...

- webpack究竟是什么

在很久很久以前,当我们写一个web网页的时候,js实现的逻辑相对是比较弱的.但随着前端技术的发展,前端能实现的内容越来越多.在js里面加了非常非常多的逻辑,于是呢,我们就发现我们通过这种面向过程的方式 ...

- [19/04/06-星期六] 多线程_静态代理(StaticProxy)和 lamda (简化代码,jdk8新增)

一.静态代理 [代码示例] /*** * 静态代理:记录日志等,类是写好的,直接拿来用. 动态代理:随用随构建,临时抱佛脚 * 婚庆公司:代理角色,帮你搞婚庆的一切,布置房间等等 * 自己:真实角色, ...