【spark】分区

RDD是弹性分布式数据集,通常RDD很大,会被分成多个分区,保存在不同节点上。

那么分区有什么好处呢?

分区能减少节点之间的通信开销,正确的分区能大大加快程序的执行速度。

我们看个例子

首先我们要了解一个概念,分区并不等同于分块。

分块是我们把全部数据切分成好多块来存储叫做分块。

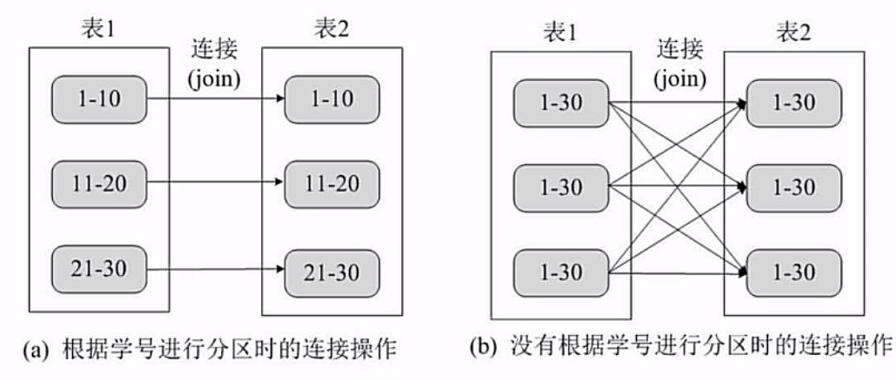

如上图b,产生的分块,每个分块都可能含有同样范围的数据。

而分区,则是把同样范围的数据分开,如图a

我们通过这个图片可以清楚的看到,我们通过把相同主键的数据连接。

经过有序分区的数据,只需要按照相同的主键分区 join 即可。

未通过分区的分块执行 join ,额外进行多次连接操作,把同样的数据连接到不同节点上,大大增大了通信开销。

在一些操作上,join groupby,filer等等都能从分区上获得很大的收益。

分区原则

RDD分区的一个分区原则是使得分区个数尽量等于集群中的CPU核心(core)数量。分区过多并不会增加执行速度。

例如,我们集群有10个core,我们分5个区,每个core执行一个分区操作,剩下5个core浪费。

如果,我们分20分区,一个core执行一个分区,剩下的10分区将会排队等待。

默认分区数目

对于不同的Spark部署模式而言(本地模式,standalone模式,YARN模式,Mesos模式)

都可以数值spark.default.parallelism这个参数值,来配置默认分区。

当然针对不同的部署模式,默认分区的数目肯定也是不相同的。

本地模式,默认为本地机器的CPU数目,若设置了local[N],则默认为N。一般使用local[*]来使用所有CPU数。

YARN模式,在集群中所有CPU核心数目总和和 2 二者中取较大值作为默认值。

Mesos模式,默认分区为8.

如何手动设置分区

1.创建RDD时:在调用 textFile 和 parallelize 方法的时候手动指定分区个数即可。

语法格式 sc.parallelize(path,partitionNum) sc.textFile(path,partitionNum)

//sc.parallelize(path,partitionNum)

val list = List("Hadoop","Spark","Hive");

val rdd1 = sc.parallelize(list,2);//设置两个分区

val rdd2 = sc.parallelize(list);//未指定分区,默认为spark.default.parallelism //sc.textFile(path,partitionNum)

val rdd3 = sc.textFile("file://+本地文件地址",2);//设置两个分区

val rdd4 = sc.textFile("file://+本地文件地址");//未指定分区,默认为min(2,spark.default.parallelism)

val rdd5 = sc.textFile("file://+HDFS文件地址");//未指定分区,默认为HDFS文件分片数

2.通过转化操作得到新的RDD时:调用 repartition 方法即可。

语法格式 val newRdd = oldRdd.repartition(1)

val list = List("Hadoop","Spark","Hive");

val rdd1 = sc.parallelize(list,2);//设置两个分区

val newRdd1 = rdd1.repartition(3);//重新分区

println(newRdd1.partitions.size);//查看分区数

分区函数

我们在使用分区的时候要了解两条规则

(1)只有Key-Value类型的RDD才有分区的,非Key-Value类型的RDD分区的值是None

(2)每个RDD的分区ID范围:0~numPartitions-1,决定这个值是属于那个分区的

spark内部提供了 HashPartitioner 和 RangePartitioner 两种分区策略。

1.HashPartitioner

原理:

对于给定的key,计算其hashCode,并除于分区的个数取余,如果余数小于0,则用余数+分区的个数,最后返回的值就是这个key所属的分区ID。

语法:

rdd.partitionBy(new spark.HashPartitioner(n))

示例:

object Main{

def main(args:Array[String]): Unit ={

val conf = new SparkConf();

val sc = new SparkContext(conf);

val list = List((1,1),(1,2),(2,1),(2,2),(3,1),(3,2))//注意这里必须是(k,v)形式

val rdd = sc.parallelize(list);

rdd.partitionBy(new spark.HashPartitioner(3));//使用HashPartitioner

}

}

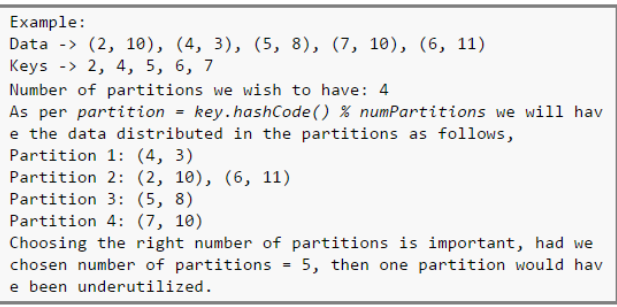

我们再看一个例子说明HashPartitioner如何分区的。

注意:实际我们使用的默认分区方式实际是 HashPartitioner 分区方式

2.RangePartitioner

原理:

根据key值范围和分区数确定分区范围,将范围内的键分配给相应的分区。

语法:

rdd.partitionBy(new RangePartitioner(n,rdd));

示例:

object Main{

def main(args:Array[String]): Unit ={

val conf = new SparkConf();

val sc = new SparkContext(conf);

val list = List((1,1),(1,2),(2,1),(2,2),(3,1),(3,2))

val rdd = sc.parallelize(list);

val pairRdd = rdd.partitionBy(new RangePartitioner(3,rdd));//根据key分成三个区

}

}

3.用户自定义分区

如果上面两种分区都满足不了你的要求的时候,我们可以自己定义分区类。

Spark提供了相应的接口,我们只需要扩展Partitioner抽象类。

abstract class Partitioner extends Serializable {

def numPartitions: Int //这个方法需要返回你想要创建分区的个数

def getPartition(key: Any): Int //这个函数需要对输入的key做计算,然后返回该key的分区ID,范围一定是0到 numPartitions-1

}

定义完毕后,通过parttitionBy()方法调用。

示例:

我们看这样一个实例,需要按照最后一位数来分区,我们用普通的分区并不能满足要求,所以这个时候需要自己定义分区类。

class UDPartitioner (numParts:Int) extends Partitioner {

//覆盖分区数

override def numPartitions = numParts;

//覆盖分区获取函数,返回分区所用的key

override def getPartition(key: Any) : Int= {

key.toString.toInt % 10;//通过key除10取余来获取最后一位数并返回。

}

}

object Main{

def main(args:Array[String]): Unit ={

val conf = new SparkConf();

val sc = new SparkContext(conf);

//模拟5个分区的数据

val data1 = sc.parallelize(1 to 10,5);

//注意,RDD一定要是key-value,才能使用用户自定义的分区类,通过key来确定分区

val data2 = data1.map((_,1));//占位符用法,等同于data.map(x => (x,1))

//根据尾号转变为10个分区,分别写到10个文件中

data2.partitionBy(new UDPartitioner(10)).saveAsTextFile("file:///usr/local/output");

}

}

另外,我们也可以通过在函数中额外定义 hashcode()方法 和 equal()方法来保证分区的正确分配。

【spark】分区的更多相关文章

- 【Spark 深入学习-08】说说Spark分区原理及优化方法

本节内容 ------------------ · Spark为什么要分区 · Spark分区原则及方法 · Spark分区案例 · 参考资料 ------------------ 一.Spark为什 ...

- Spark学习之路 (十七)Spark分区

一.分区的概念 分区是RDD内部并行计算的一个计算单元,RDD的数据集在逻辑上被划分为多个分片,每一个分片称为分区,分区的格式决定了并行计算的粒度,而每个分区的数值计算都是在一个任务中进行的,因此任务 ...

- Spark(十一)Spark分区

一.分区的概念 分区是RDD内部并行计算的一个计算单元,RDD的数据集在逻辑上被划分为多个分片,每一个分片称为分区,分区的格式决定了并行计算的粒度,而每个分区的数值计算都是在一个任务中进行的,因此任务 ...

- spark分区

spark默认的partition的分区数是和本机CPU的核数保持一致: bucket的数量和reduce的数量一致:buket的概念是map会将计算获得数据放到各个buket中,每个bucket和一 ...

- Spark学习之路 (十七)Spark分区[转]

分区的概念 分区是RDD内部并行计算的一个计算单元,RDD的数据集在逻辑上被划分为多个分片,每一个分片称为分区,分区的格式决定了并行计算的粒度,而每个分区的数值计算都是在一个任务中进行的,因此任务的个 ...

- Hive和Spark分区策略

1.概述 离线数据处理生态系统包含许多关键任务,最大限度的提高数据管道基础设施的稳定性和效率是至关重要的.这边博客将分享Hive和Spark分区的各种策略,以最大限度的提高数据工程生态系统的稳定性和效 ...

- Spark分区实例(teacher)

package URL1 import org.apache.spark.Partitioner import scala.collection.mutable class MyPartitioner ...

- 重要 | Spark分区并行度决定机制

最近经常有小伙伴在本公众号留言,核心问题都比较类似,就是虽然接触Spark有一段时间了,但是搞不明白一个问题,为什么我从HDFS上加载不同的文件时,打印的分区数不一样,并且好像spark.defaul ...

- Spark分区器浅析

分区器作用:决定该数据在哪个分区 概览: 仅仅只有pairRDD才可能持有分区器,普通RDD的分区器为None 在分区器为None时RDD分区一般继承至父RDD分区 初始RDD分区数: 由集合创建,R ...

- spark 分区

http://stackoverflow.com/questions/39368516/number-of-partitions-of-spark-dataframe

随机推荐

- 我的Android进阶之旅------>Android自定义View实现带数字的进度条(NumberProgressBar)

今天在Github上面看到一个来自于 daimajia所写的关于Android自定义View实现带数字的进度条(NumberProgressBar)的精彩案例,在这里分享给大家一起来学习学习!同时感谢 ...

- 我的Android进阶之旅------>关于使用CSDN-markdown编辑器来编写博客

关于使用MarkDown编辑器的原因 什么是 Markdown 制作一份待办事宜 Todo 列表 书写一个质能守恒公式LaTeX 高亮一段代码code 高效绘制 流程图 高效绘制序列图 绘制表格 更详 ...

- hibernate detached分离查询 与 抓取策略注意事项

1.detached在抓取策略为 jion显式左外连接查询情况下 会产生笛卡儿积现象 DetachedCriteria dc = DetachedCriteria.forClass(Topic.cla ...

- RS232串口通信

RS232串口经常使用在PC机与FPGA通信中,用于两者之间的数据传输,因为UART协议简单.易实现,故经常使用. DB9接口只需要使用3根线,RXD(2).TXD(3)和GND(5),如下图所示.而 ...

- Eclipse ftp插件

一个比较好的插件:esftp 下载地址http://sourceforge.net/projects/esftp/ 解压后放到plugins目录下重启即可. 配置estfp, 右击项目crm-> ...

- Linux常用命令(更新)

- 08 Spring框架 AOP (一)

首先我们先来介绍一下AOP: AOP(Aspect Orient Programming),面向切面编程,是面向对象编程OOP的一种补充.面向对象编程是从静态角度考虑程序的结构,面向切面编程是从动态的 ...

- docker安装部署PHP nginx

sudo tee /etc/yum.repos.d/docker.repo <<-'EOF' [dockerrepo] name=Docker Repository baseurl=htt ...

- Spring 之定义切面尝试(基于 XML)

有些场景下只能基于 XML 来定义切面. [Spring 之定义切面尝试] 1.XML 下定义切面(首先是要有一个对应的类...显然要比基于注解的麻烦) <?xml version=" ...

- Django---自定义admin组件思维导图