爬虫 (6)- Scrapy 实战案例 - 爬取不锈钢的相关钢卷信息

超详细创建流程及思路

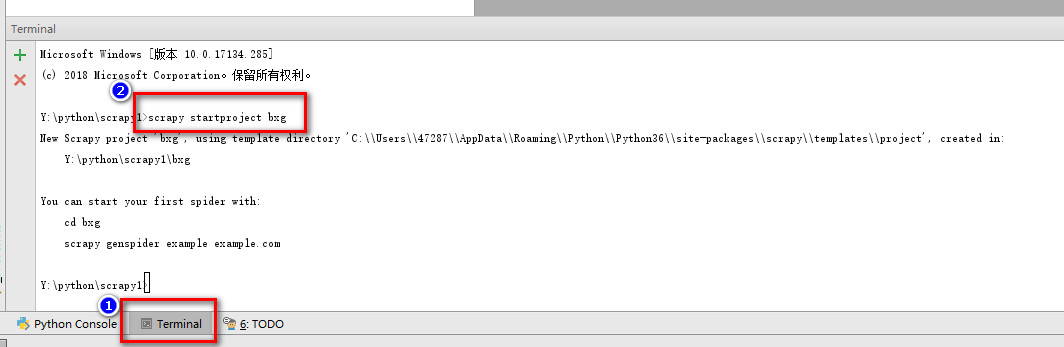

一. 新建项目

1.创建文件夹,然后在对应文件夹创建一个新的python项目

2.点击Terminal命令行窗口,运行下面的命令创建scrapy项目

scrapy startproject bxg

二、明确目标

1.我们打算抓取2018年1月到8月,佛山市场各个公司关于304钢卷的价格、规格等数据;

(1)打开mySpider目录下的items.py

配置将我们需要爬取的信息

import scrapy class BxgItem(scrapy.Item):

vender = scrapy.Field() # 厂家

texture = scrapy.Field() # 材质

thickness = scrapy.Field() # 厚度

cutting = scrapy.Field() # 切边

price = scrapy.Field() # 价格

date = scrapy.Field() # 日期

三、制作爬虫

1. 爬数据

(1)在bxg/bxg/spiders目录下输入命令,将在bxg/bxg/spiders目录下创建一个名为bxg1的爬虫,并指定爬取域的范围,注意,爬虫名字不能根项目名字一样。

scrapy genspider bxg1 "51bxg.com"

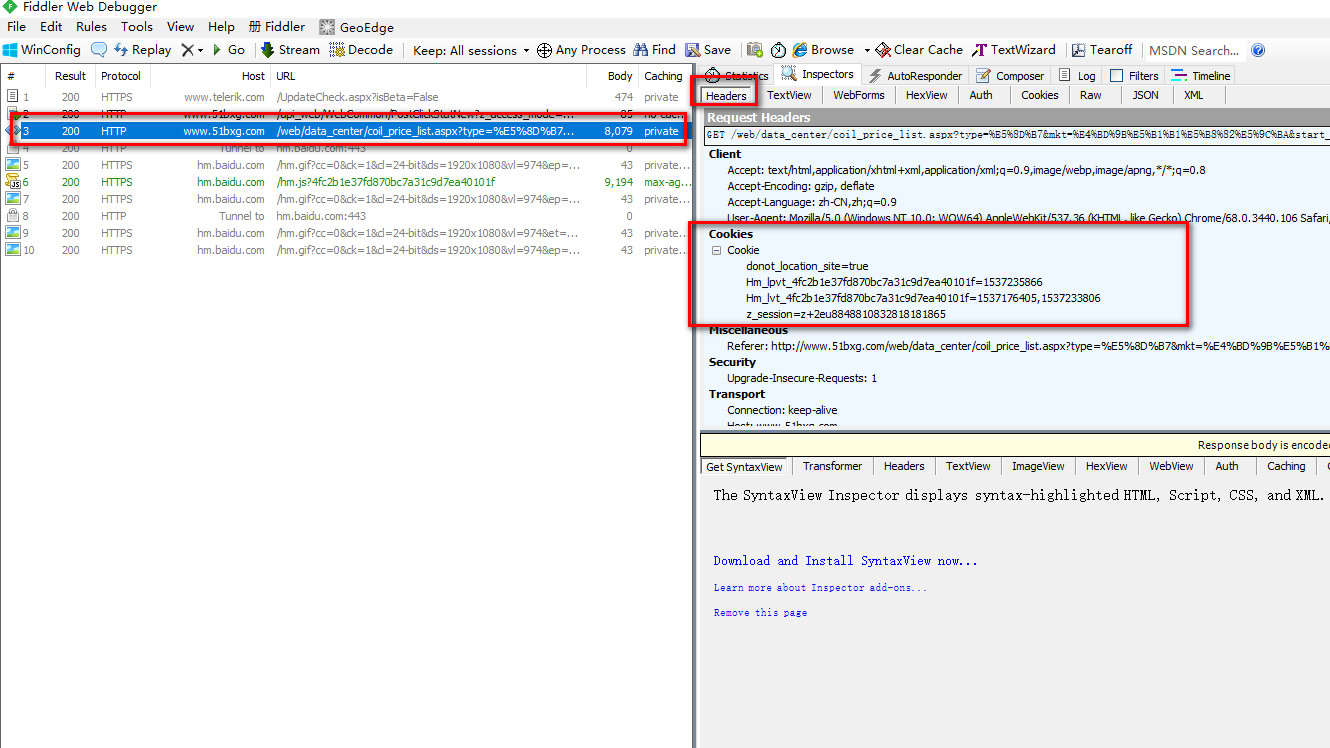

难点一,这是一个需要付费会员登陆后才能访问的搜索钢卷页面。

我们需要模拟登陆后的状态,所以我们用fidder工具获取到登陆后的cookies先。

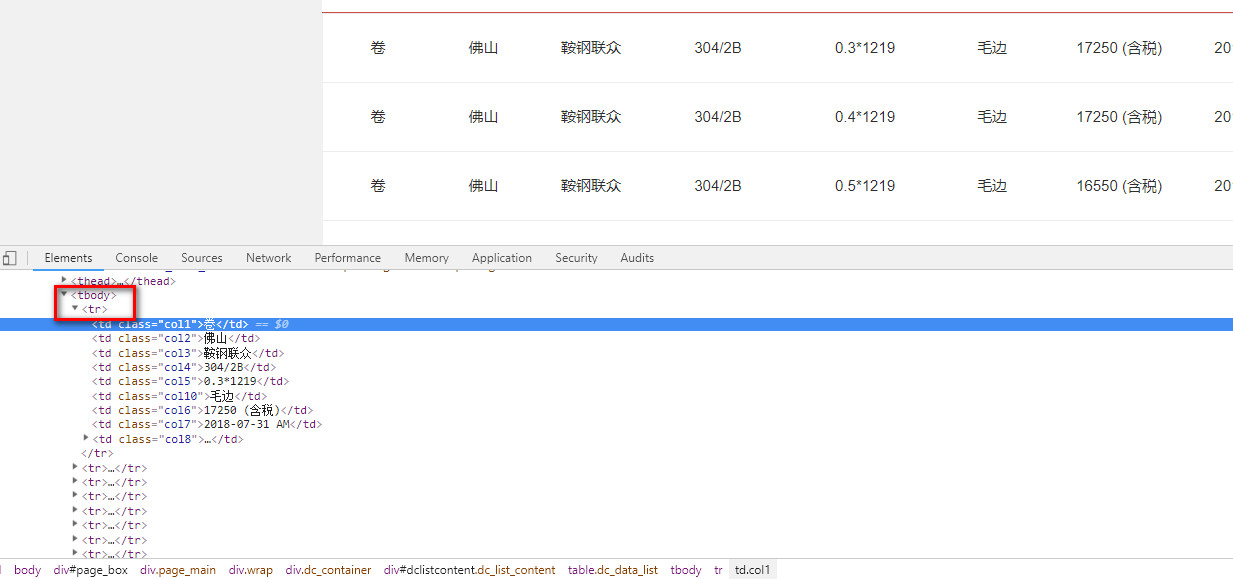

难点二,用Xpath语法过滤获取到我们需要的数据 Xpath语法文档

xpath("//tbody/tr")

(2)打开bxg/bxg/spiders目录里的 bxg1.py,替换成下面的代码

# -*- coding: utf-8 -*-

import scrapy

from bxg.items import BxgItem # 实在没办法了,可以用这种方法模拟登录,麻烦一点,成功率100% class Bxg1Spider(scrapy.Spider):

name = "bxg1"

allowed_domains = ["51bxg.com"] url = 'http://www.51bxg.com/web/data_center/coil_price_list.aspx?type=卷&mkt=佛山市场&start_date=2018-01-01&end_date=2018-07-31&mat=J1&pageIndex='

offset = 1

start_urls = [url + str(offset)] # 从fidder中获取到的cookies数据

cookies = {

'z_session' : 'z+2eu8848810832818181865',

'donot_location_site' : 'true',

'Hm_lvt_4fc2b1e37fd870bc7a31c9d7ea40101f' : '1533546617,1533607332',

'Hm_lpvt_4fc2b1e37fd870bc7a31c9d7ea40101f' : '1533621991'

} def start_requests(self): # 具体循环次数需要看搜索到的页数,这里方便测试只导出10页

while (self.offset < 10):

self.start_urls.append(self.url + str(self.offset))

self.offset += 1 for url in self.start_urls:

print(url)

yield scrapy.FormRequest(url, cookies = self.cookies, callback = self.parse_page) def parse_page(self, response): items = [] # 循环页面中所有对应Xpath语法过滤到的列

for each in response.xpath("//tbody/tr"): item = BxgItem() vender = each.xpath("td[@class='col3']/text()").extract()

texture = each.xpath("td[@class='col4']/text()").extract()

thickness = each.xpath("td[@class='col5']/text()").extract()

cutting = each.xpath("td[@class='col10']/text()").extract()

price = each.xpath("td[@class='col6']/text()").extract()

date = each.xpath("td[@class='col7']/text()").extract() # xpath返回的是包含一个元素的列表

item['vender'] = vender[0]

item['texture'] = texture[0]

item['thickness'] = thickness[0]

item['cutting'] = cutting[0]

item['price'] = price[0]

item['date'] = date[0] items.append(item) # 运行脚本:scrapy crawl bxg1 -o data.csv

# 直接返回最后数据 iconv -f utf-8 -t gbk data.csv > a.csv

return items

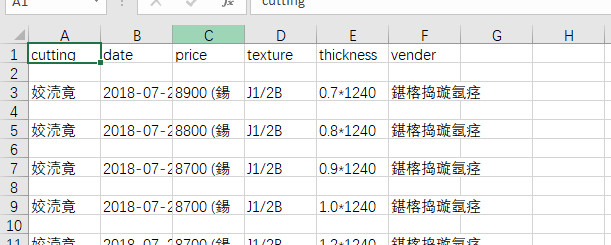

2.取数据

(1)在bxg/bxg/spiders目录下输入命令,运行bxg1爬虫,将爬取的数据导出到data.csv文件中

scrapy crawl bxg1 -o data.csv

(2)发现获取的数据编码格式有点问题,出现乱码,需要对文件处理

iconv -f utf-8 -t gbk data.csv > a.csv

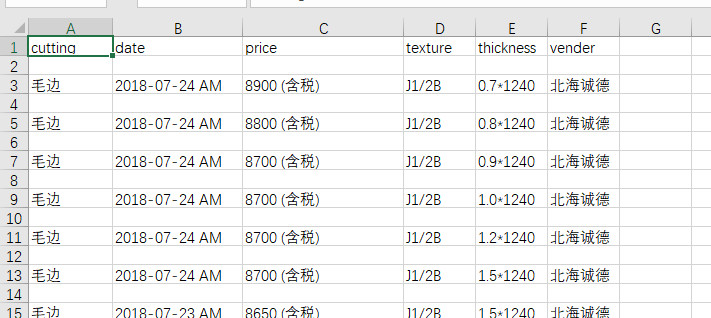

最后得到我们需要爬取的数据。

爬虫 (6)- Scrapy 实战案例 - 爬取不锈钢的相关钢卷信息的更多相关文章

- Java爬虫系列之实战:爬取酷狗音乐网 TOP500 的歌曲(附源码)

在前面分享的两篇随笔中分别介绍了HttpClient和Jsoup以及简单的代码案例: Java爬虫系列二:使用HttpClient抓取页面HTML Java爬虫系列三:使用Jsoup解析HTML 今天 ...

- python网络爬虫之scrapy 调试以及爬取网页

Shell调试: 进入项目所在目录,scrapy shell “网址” 如下例中的: scrapy shell http://www.w3school.com.cn/xml/xml_syntax.as ...

- Scrapy实战:爬取http://quotes.toscrape.com网站数据

需要学习的地方: 1.Scrapy框架流程梳理,各文件的用途等 2.在Scrapy框架中使用MongoDB数据库存储数据 3.提取下一页链接,回调自身函数再次获取数据 重点:从当前页获取下一页的链接, ...

- scrapy实战7爬取搜狗微信:

爬取微信热门文章标题,内容,内容地址,微信公众号,公众号地址,发布日期等 如图 源码地址:https://github.com/huwei86/sougouweixin

- scrapy实战6爬取IT桔子国内所有融资公司:

爬取融资公司,融资公司简介,融资时间,轮次,融资额,投资方,股权占比以及融资公司完整融资历史 如图 源码地址:https://github.com/huwei86/spiderITjuzi

- python实战项目 — 爬取中国票房网年度电影信息并保存在csv

import pandas as pd import requests from bs4 import BeautifulSoup import time def spider(url, header ...

- 分布式爬虫系统设计、实现与实战:爬取京东、苏宁易购全网手机商品数据+MySQL、HBase存储

http://blog.51cto.com/xpleaf/2093952 1 概述 在不用爬虫框架的情况,经过多方学习,尝试实现了一个分布式爬虫系统,并且可以将数据保存到不同地方,类似MySQL.HB ...

- Python爬虫实战之爬取百度贴吧帖子

大家好,上次我们实验了爬取了糗事百科的段子,那么这次我们来尝试一下爬取百度贴吧的帖子.与上一篇不同的是,这次我们需要用到文件的相关操作. 本篇目标 对百度贴吧的任意帖子进行抓取 指定是否只抓取楼主发帖 ...

- 爬虫系列5:scrapy动态页面爬取的另一种思路

前面有篇文章给出了爬取动态页面的一种思路,即应用Selenium+Firefox(参考<scrapy动态页面爬取>).但是selenium需要运行本地浏览器,比较耗时,不太适合大规模网页抓 ...

随机推荐

- Shiro(4)默认鉴权与自定义鉴权

=========默认鉴权======== 过滤链中定义: <!-- 过滤链定义 --> <property name="filterChainDefinitions&qu ...

- intellij idea使用maven本地仓库及修改本地仓库路径

什么maven本地仓库,默认是用户目录下的.m2/repository这个文件. idea是自带maven插件的不用我们再,怎么把依赖包下载到我们的本地仓库呢?一般是idea默认了路径,而且idea是 ...

- RocketMQ通信协议

我们先从client端看一个消息是如何发送到服务端,服务端又是如何解析消息的. client端: 构造请求体: 构造请求体: 发送消息体: 下面看服务端: rocketmq的协议服务端解析救灾这里了R ...

- windows 下apache 以fastcgi形式执行php

以xampp为例解说,过程例如以下: 1:下载相应的mod_fastcgi .下载參考站点:http://www.apachelounge.com/download/VC11/ 2:拷贝mod_fas ...

- win7之64位下安装oracle11g遇到问题和不能删除干净的问题

今天在win7下装了oracle11g 删了又卸 来来回回重启了4.5次,结合网上是解释归纳下几点: 一.win64_11gR2_database_1of2.zip和win64_11gR2_datab ...

- 001-使用idea开发环境安装部署,npm工具栏,脚本运行

一.概述 参看官方文档:https://ant.design/docs/spec/introduce-cn 其中包含了设计价值观.设计原则.视觉.模式.可视化.动态等. 其中Ant Design 的 ...

- Protocol Informatics (PI项目)【基于网络轨迹的协议逆向工程文献学习】

Protocol Informatics[基于网络轨迹的协议逆向工程文献学习]by tsy 声明: 1)本报告由博客园bitpeach撰写,版权所有,免费转载,请注明出处,并请勿作商业用途.恕作者著作 ...

- 设计模式在cocos2d-x中的使用--简单工厂模式(Simple Factory)

什么是简单工厂模式? 从设计模式的类型上来说,简单工厂模式是属于创建型模式,又叫做静态工厂方法(Static Factory Method)模式.通过专门定义一个类来负责创建其它类的实例,被创建的实例 ...

- Java集合-Map接口相关操作方法

Map接口不是Collection接口的继承.Map接口用于维护键/值对(key/value pairs). 该接口描述了从不重复的键到值的映射. (1) 添加.删除操作: Object put(Ob ...

- shell中$0,$?,$!等的特殊使用方法

变量说明: $$ Shell本身的PID(ProcessID) $! Shell最后执行的后台Process的PID $? 最后执行的命令的结束代码(返回值) $- 使用Set命令设定的Flag一览 ...