Sqoop数据迁移工具

一、概述

sqoop 是 apache 旗下一款“ Hadoop 和关系数据库服务器之间传送数据”的工具。

导入数据: MySQL, Oracle 导入数据到 Hadoop 的 HDFS、 HIVE、 HBASE 等数据存储系统;

导出数据:从 Hadoop 的文件系统中导出数据到关系数据库 mysql 等

Sqoop 的本质还是一个命令行工具,和 HDFS, Hive 相比,并没有什么高深的理论。

二、工作机制

将导入或导出命令翻译成 mapreduce 程序来实现

在翻译出的 mapreduce 中主要是对 inputformat 和 outputformat 进行定制

三、sqoop安装

安装 sqoop 的前提是已经具备 java 和 hadoop 的环境

安装包下载地址 http://ftp.wayne.edu/apache/sqoop/1.4.6/

安装步骤 :

(1)准备安装包 sqoop-1.4.6.bin__hadoop-2.0.4-alpha.tar.gz

(2) 解压安装包到安装目录

tar -zxvf sqoop-1.4.6.bin__hadoop-2.0.4-alpha.tar.gz -C apps/

cd apps

mv sqoop-1.4.6.bin__hadoop-2.0.4-alpha/ sqoop1.4.6

(3) 进入到 conf 文件夹,找到 sqoop-env-template.sh,修改其名称为 sqoop-env.sh

cd conf

mv sqoop-env-template.sh sqoop-env.sh

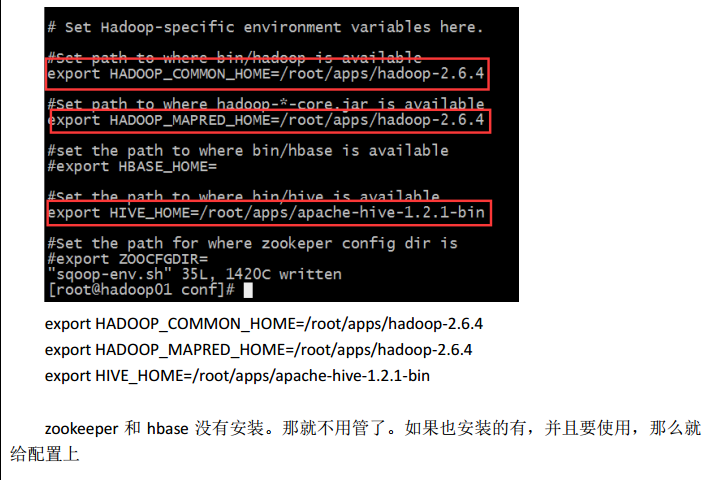

(4) 修改 sqoop-env.sh

(5) 加入 mysql 驱动包到 sqoop1.4.6/lib 目录下

cp mysql-connector-java-5.1.39.jar apps/sqoop1.4.6/lib/

(6) 配置系统环境变量

vi /etc/profile

然后输入:

export SQOOP_HOME=/root/apps/sqoop1.4.6

export PATH=$PATH:$SQOOP_HOME/bin

然后保存退出

source /etc/profile

(7) 验证安装是否成功

sqoop –version

(8)出现如图所示画面,证明安装成功,那么接下来就可以正常使用了。

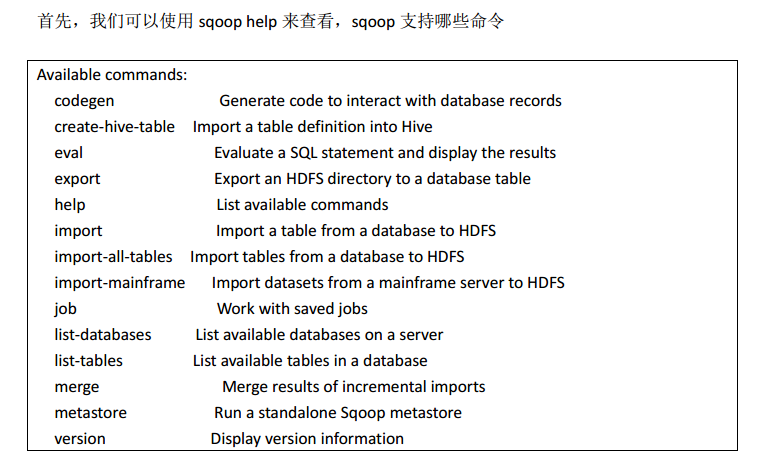

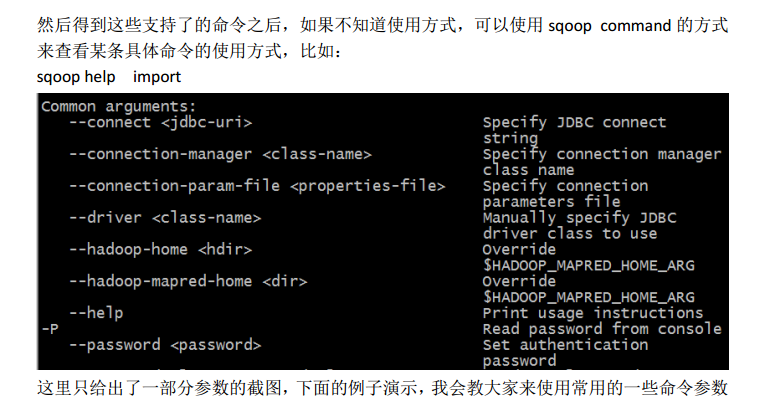

四、sqoop基本命令介绍

五、sqoop数据导入

“导入工具”导入单个表从 RDBMS 到 HDFS。表中的每一行被视为 HDFS 的记录。所有记录 都存储为文本文件的文本数据(或者 Avro、 sequence 文件等二进制数据)

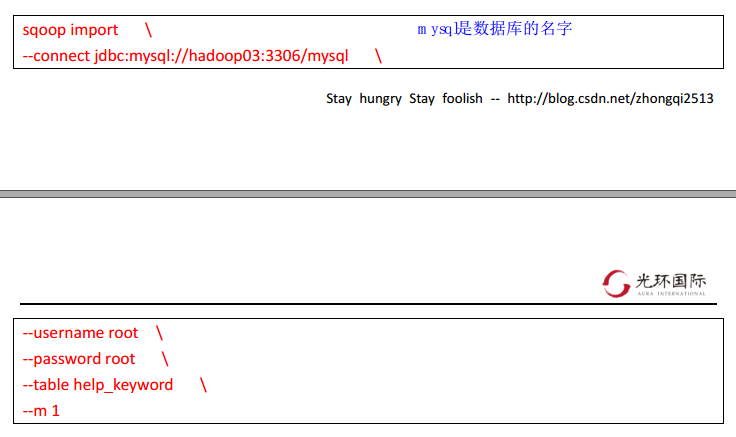

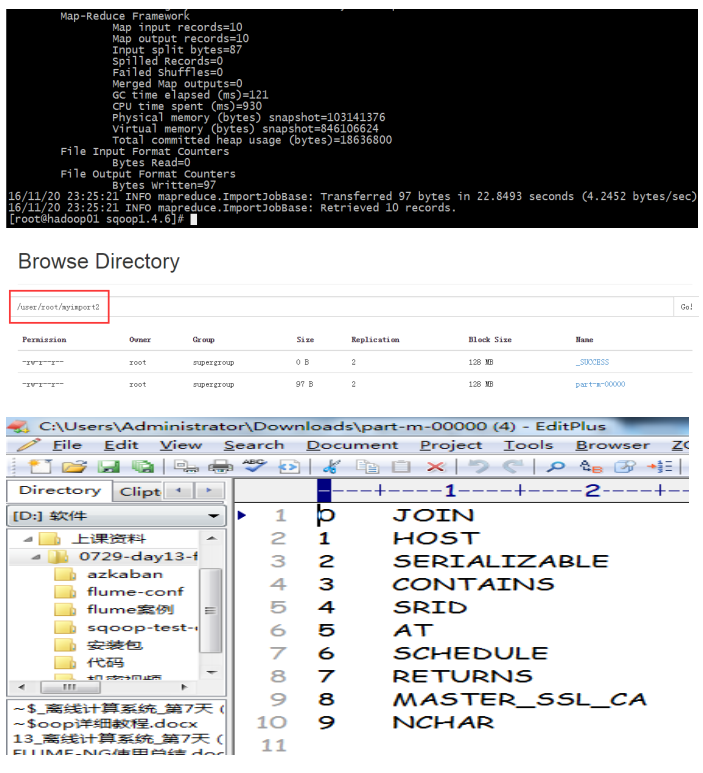

1、导入mysql数据到HDFS

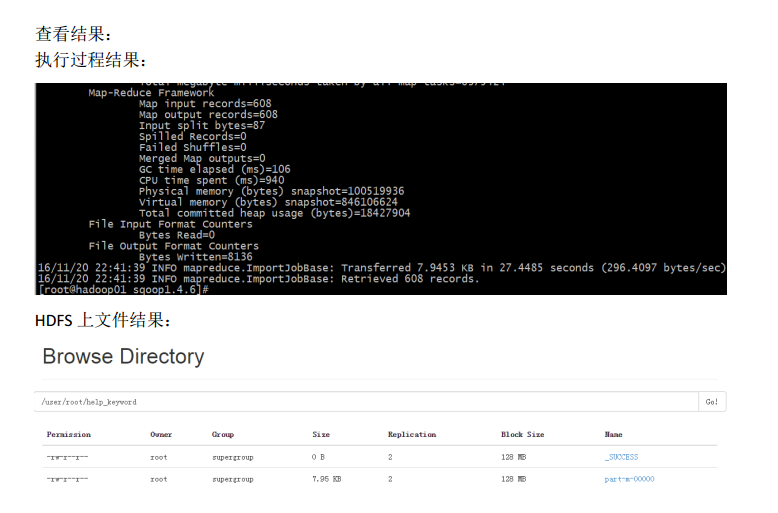

(1)普通导入

如果我们没有给该命令指定导出的文件的存储路径,那么默认会保存在 HDFS 上的

/user/root/help_keyword 目中

其中,第一个 user 是固定的,第二个 root,表示链接的用户名,第三个表示表名

从以上结果可以得出一个结论: 如果没有指定路径,则会按默认规则生成路径,如果没有 指定分隔符,默认按照逗号分隔

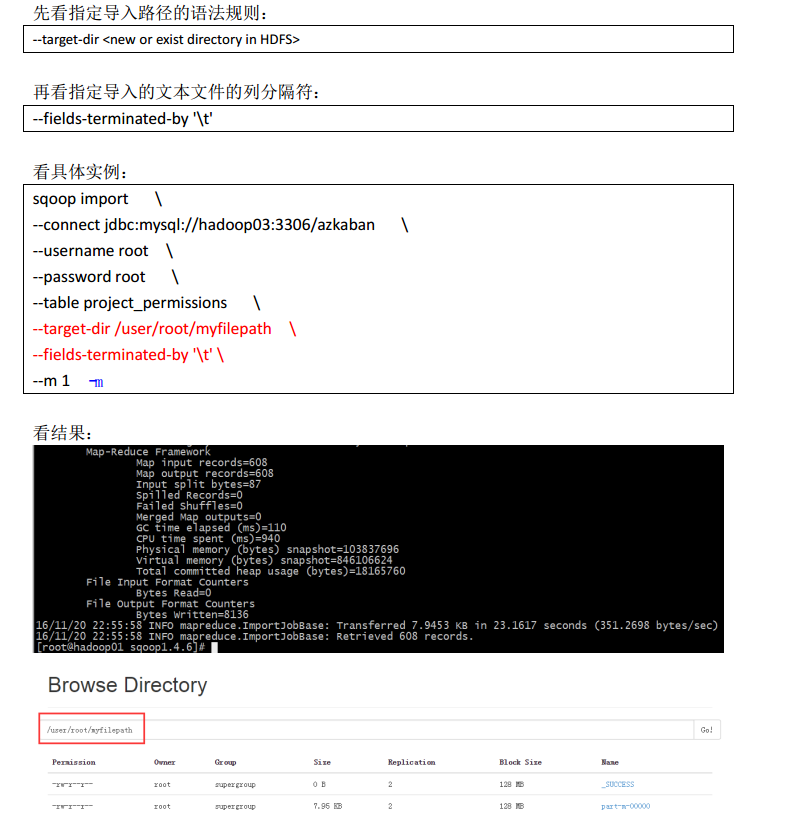

(2)指定分隔符和导入路径

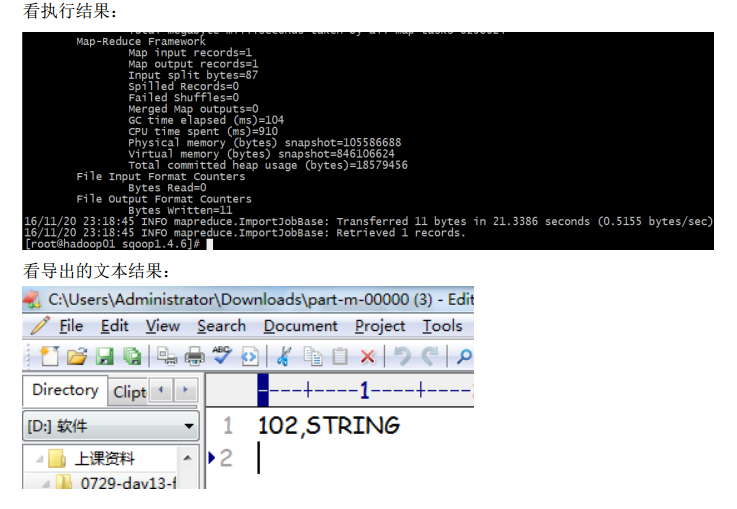

(3)导入where条件数据

我们可以导入表的使用 Sqoop 导入工具, "where"子句的一个子集。它执行在各自的数据库 服务器相应的 SQL 查询,并将结果存储在 HDFS 的目标目录。

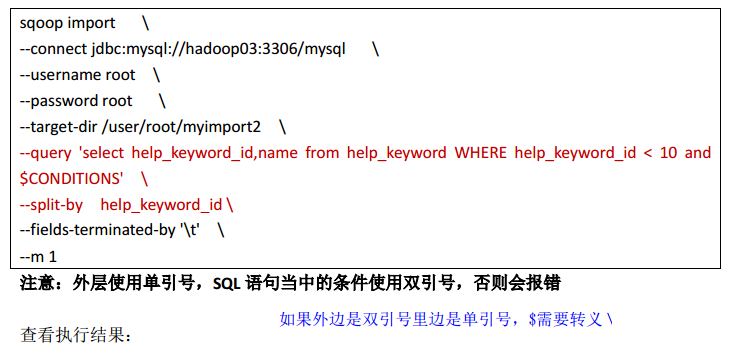

(4)导入 Query 结果数据

2、导入 MySQL 到 HIVE

Sqoop 导入关系型数据到 hive 的过程是先导入到 hdfs,然后再 load 进入 hive

Sqoop数据迁移工具的更多相关文章

- Sqoop数据迁移工具的使用

文章作者:foochane 原文链接:https://foochane.cn/article/2019063001.html Sqoop数据迁移工具的使用 sqoop简单介绍 sqoop数据到HDF ...

- Sqoop 数据迁移工具

Sqoop 数据迁移工具 sqoop : SQL to hadOOP 两个功能: 1. RDB 向HDFS导入 2. HDFS向RDB导入 注:拷贝mysql-connector.jar 和 json ...

- 数据迁移工具sqoop

有问题........数据迁移工具sqoop sqoop安装 [root@sqoop data]# wget wget http://apache.fayea.com/sqoop/1.4.6/sqo ...

- sqoop 数据迁移

sqoop 数据迁移 1 概述 sqoop是apache旗下一款“Hadoop和关系数据库服务器之间传送数据”的工具. 导入数据:MySQL,Oracle导入数据到Hadoop的HDFS.HIVE.H ...

- sqoop数据校验

sqoop数据校验 # check data oracle_cnt=$(sqoop eval \ -Dmapred.job.queue.name=${queue} \ --connect ${conn ...

- 撸了个 django 数据迁移工具 django-supertube

撸了个 django 数据迁移工具 django-supertube 支持字段映射和动态字段转化. 欢迎 star,issue https://github.com/FingerLiu/django- ...

- 【Hadoop离线基础总结】Sqoop数据迁移

目录 Sqoop介绍 概述 版本 Sqoop安装及使用 Sqoop安装 Sqoop数据导入 导入关系表到Hive已有表中 导入关系表到Hive(自动创建Hive表) 将关系表子集导入到HDFS中 sq ...

- 数据迁移工具Sqoop和DataX功能比较

本文转载自: http://www.cnblogs.com/panfeng412/archive/2013/04/29/data-migration-tool-sqoop-and-datax.html ...

- sqoop数据导出导入命令

1. 将mysql中的数据导入到hive中 sqoop import --connect jdbc:mysql://localhost:3306/sqoop --direct --username r ...

随机推荐

- 译图智讯VIN码识别助力汽配商转型升级

汽配猫是上海佳驰经合能源科技有限公司自主开发的汽车配件B2B网上商城及服务平台,该平台依托互联网云技术.利用创新的商业模式及互联网思维,整合汽配产业链优秀资源,为汽车维修保养企业等产业链各方面提供汽配 ...

- TensorFlow(实战深度学习框架)----深层神经网络(第四章)

深层神经网络可以解决部分浅层神经网络解决不了的问题. 神经网络的优化目标-----损失函数 深度学习:一类通过多层非线性变化对高复杂性数据建模算法的合集.(两个重要的特性:多层和非线性) 线性模型的最 ...

- jmeter执行顺序及作用域规则

1.执行顺序 配置元件 前置处理器 定时器 采样器 后置处理器 断言 监听器 备注: 服务器响应为空的话后三个不执行 作用域内存在采样器时定时器.断言.前置/后置处理器才执行 逻辑控制器和采样器按照在 ...

- Python接口测试实战2 - 使用Python发送请求

如有任何学习问题,可以添加作者微信:lockingfree 课程目录 Python接口测试实战1(上)- 接口测试理论 Python接口测试实战1(下)- 接口测试工具的使用 Python接口测试实战 ...

- 《Cocos2d-x游戏开发实战精解》学习笔记2--在Cocos2d-x中显示一行文字

在Cocos2d-x中要显示文字就需要用到Label控件.在3.x版本的Cocos2d中,舍弃了之前版本所使用的LabelTTF.LabelAtlas.LabelBMFont 3个用于显示文字的类,而 ...

- 算法笔记(c++)--桶排序题目

算法笔记(c++)--桶排序 记得题目是排序,输入n个1-1000的数字然后去重然后排序. 桶排序没毛病 #include<iostream> using namespace std; i ...

- FPGA的过去,现在和未来

我们知道,相对于专业的ASIC,FPGA有上市时间和成本上的优势.另外,在大多数情况下,FPGA执行某些功能较之CPU上的软件操作更高效.这就是为什么我们认为它不但会运用在数据中心的服务器.交换器.存 ...

- iframe高度自适应的6个方法

原文链接:http://caibaojian.com/iframe-adjust-content-height.html JS自适应高度,其实就是设置iframe的高度,使其等于内嵌网页的高度,从而看 ...

- 跨域写cookie

假设a站想往b站写cookie,那么目前有两种方案,参考如下: 第一种(使用jsonp): a站js代码如下: $.ajax({ url: 'http://www.b.com/jsonp.jsp?do ...

- 关于解决乱码问题的一点探索之二(涉及Unicode(utf-16)和GBK)

在上篇日志中(链接),我们讨论了utf-8编码和GBK编码之间转化的乱码问题,这一篇我们讨论Unicode(utf-16编码方式)与GBK编码之间转换的乱码问题. 在Windows系统 ...