scrapy实战--爬取最新美剧

现在写一个利用scrapy爬虫框架爬取最新美剧的项目。

准备工作:

目标地址:http://www.meijutt.com/new100.html

爬取项目:美剧名称、状态、电视台、更新时间

1、创建工程目录

mkdir scrapyProject

cd scrapyProject

2、创建工程项目

scrapy startproject meiju100

cd meiju100

scrapy genspider meiju meijutt.com

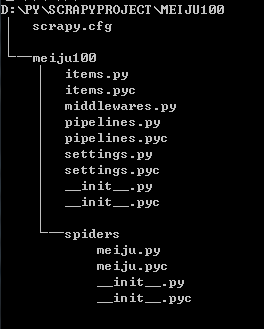

3、查看目录结构

4、设置爬取项目(items.py)

#

# See documentation in:

# http://doc.scrapy.org/en/latest/topics/items.html import scrapy class Meiju100Item(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

storyName = scrapy.Field()

storyState = scrapy.Field()

tvStation = scrapy.Field()

updateTime = scrapy.Field()

5、编写爬取脚本(meiju.py)

# -*- coding: utf-8 -*-

import scrapy

from meiju100.items import Meiju100Item class MeijuSpider(scrapy.Spider):

name = "meiju"

allowed_domains = ["meijutt.com"]

start_urls = ['http://www.meijutt.com/new100.html'] def parse(self, response):

items = []

subSelector = response.xpath('//ul[@class="top-list fn-clear"]/li')

for sub in subSelector:

item = Meiju100Item()

item['storyName'] = sub.xpath('./h5/a/text()').extract()

item['storyState'] = sub.xpath('./span[1]/font/text()').extract()

if item['storyState']:

pass

else:

item['storyState'] = sub.xpath('./span[1]/text()').extract()

item['tvStation'] = sub.xpath('./span[2]/text()').extract()

if item['tvStation']:

pass

else:

item['tvStation'] = [u'未知']

item['updateTime'] = sub.xpath('./div[2]/text()').extract()

if item['updateTime']:

pass

else:

item['updateTime'] = sub.xpath('./div[2]/font/text()').extract()

items.append(item)

return items

6、对爬取结果的处理

# -*- coding: utf-8 -*- # Define your item pipelines here

#

# Don't forget to add your pipeline to the ITEM_PIPELINES setting

# See: http://doc.scrapy.org/en/latest/topics/item-pipeline.html

import time

import sys

reload(sys)

sys.setdefaultencoding('utf8') class Meiju100Pipeline(object):

def process_item(self, item, spider):

today = time.strftime('%Y%m%d',time.localtime())

fileName = today + 'movie.txt'

with open(fileName,'a') as fp:

fp.write(item['storyName'][0].encode("utf8") + '\t' + item['storyState'][0].encode("utf8") + '\t' + item['tvStation'][0] + '\t' + item['updateTime'][0] + '\n')

return item

7、设置settings.py

……

ITEM_PIPELINES = {'meiju100.pipelines.Meiju100Pipeline':1}

8、启动爬虫

scrapy crawl meiju

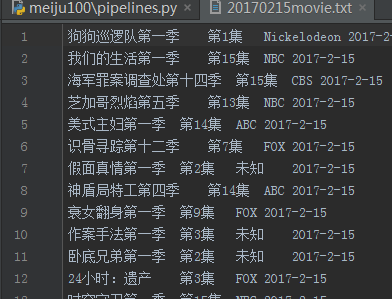

9、结果

10、代码下载

http://files.cnblogs.com/files/kongzhagen/meiju100.zip

scrapy实战--爬取最新美剧的更多相关文章

- 简单的scrapy实战:爬取腾讯招聘北京地区的相关招聘信息

简单的scrapy实战:爬取腾讯招聘北京地区的相关招聘信息 简单的scrapy实战:爬取腾讯招聘北京地区的相关招聘信息 系统环境:Fedora22(昨天已安装scrapy环境) 爬取的开始URL:ht ...

- 教程+资源,python scrapy实战爬取知乎最性感妹子的爆照合集(12G)!

一.出发点: 之前在知乎看到一位大牛(二胖)写的一篇文章:python爬取知乎最受欢迎的妹子(大概题目是这个,具体记不清了),但是这位二胖哥没有给出源码,而我也没用过python,正好顺便学一学,所以 ...

- 爬虫07 /scrapy图片爬取、中间件、selenium在scrapy中的应用、CrawlSpider、分布式、增量式

爬虫07 /scrapy图片爬取.中间件.selenium在scrapy中的应用.CrawlSpider.分布式.增量式 目录 爬虫07 /scrapy图片爬取.中间件.selenium在scrapy ...

- java爬虫系列第二讲-爬取最新动作电影《海王》迅雷下载地址

1. 目标 使用webmagic爬取动作电影列表信息 爬取电影<海王>详细信息[电影名称.电影迅雷下载地址列表] 2. 爬取最新动作片列表 获取电影列表页面数据来源地址 访问http:// ...

- 第三百三十节,web爬虫讲解2—urllib库爬虫—实战爬取搜狗微信公众号—抓包软件安装Fiddler4讲解

第三百三十节,web爬虫讲解2—urllib库爬虫—实战爬取搜狗微信公众号—抓包软件安装Fiddler4讲解 封装模块 #!/usr/bin/env python # -*- coding: utf- ...

- 使用scrapy框架爬取自己的博文(2)

之前写了一篇用scrapy框架爬取自己博文的博客,后来发现对于中文的处理一直有问题- - 显示的时候 [u'python\u4e0b\u722c\u67d0\u4e2a\u7f51\u9875\u76 ...

- 如何提高scrapy的爬取效率

提高scrapy的爬取效率 增加并发: 默认scrapy开启的并发线程为32个,可以适当进行增加.在settings配置文件中修改CONCURRENT_REQUESTS = 100值为100,并发设置 ...

- 九 web爬虫讲解2—urllib库爬虫—实战爬取搜狗微信公众号—抓包软件安装Fiddler4讲解

封装模块 #!/usr/bin/env python # -*- coding: utf-8 -*- import urllib from urllib import request import j ...

- scrapy框架爬取笔趣阁完整版

继续上一篇,这一次的爬取了小说内容 pipelines.py import csv class ScrapytestPipeline(object): # 爬虫文件中提取数据的方法每yield一次it ...

随机推荐

- mysql 数据库自动备份

@echo offset "Ymd=%date:~,4%%date:~5,2%%date:~8,2%""E:/MySQL/MySQL Server 5.7/bin/mys ...

- C#中null值属于什么变量类型

今天学习发现有段代码的输出结果有些理解不了,如图1,输出的结果全部为 false: 图1 后来和同事讨论研究了一下才明白,原来是这样:↓ class Program { static void Mai ...

- C#的SubString(int start,int end);

C#的SubString(); 例子: string str = "i am a girl"; string temp = str.Substring(2,2);//从索引2开始, ...

- 深入JVM学习心得

前言 相信很多人和我一样长期使用java编程,却很少关注过JVM底层实现,这很大程度上是因为JVM设计的很精巧,因此平时项目也很少遇到涉及JVM的问题.但是一方面出于对java底层技术的好奇,另一方面 ...

- tomcat与jboss等容器的区别

1.JBoss 是 J2EE 应用服务器,而 Tomcat 只是一个 Servlet 容器,或者说是一个简单的 J2EE 应用服务器. JBoss 中的 Servlet 容器还是 Tomcat. 与 ...

- Redis高可用升级

前言: 缓存对应实时性要求比较高的业务需求可谓十分重要,但缓存中的实时数据一旦丢失,将直接影响整个业务功能.考虑到各场景的业务需求,redis推出了高可用的方案,即:主从+哨兵的HA机制. 准备 &q ...

- IList,ICollection,IEnumerable,IEnumerator,IQueryable

http://www.cnblogs.com/edison1105/archive/2012/07/30/2616082.html 1.首先看一个简单的例子 int[] myArray = { 1, ...

- C#中深拷贝和浅拷贝

一:概念 内存:用来存储程序信息的介质. 指针:指向一块内存区域,通过它可以访问该内存区域中储存的程序信息.(C#也是有指针的) 值类型:struct(整形.浮点型.decimal的内部实现都是str ...

- easyUi datagrid鼠标经过提示单元格内容

此文章是基于 EasyUI+Knockout实现经典表单的查看.编辑 一. jquery.cellTip.js /** * 扩展两个方法 */ using('datagrid', function() ...

- 获取本地内网和外网IP地址

public class IPUtil { /// <summary> /// 获取本地内网IP /// </summary> /// <returns></ ...