Spark使用Java读取mysql数据和保存数据到mysql

原文引自:http://blog.csdn.net/fengzhimohan/article/details/78471952

项目应用需要利用Spark读取mysql数据进行数据分析,然后将分析结果保存到mysql中。

开发环境:

java:1.8

IDEA

spark:1.6.2

一.读取mysql数据

1.创建一个mysql数据库

user_test表结构如下:

create table user_test (

id int(11) default null comment "id",

name varchar(64) default null comment "用户名",

password varchar(64) default null comment "密码",

age int(11) default null comment "年龄"

)engine=InnoDB default charset=utf-8;

2.插入数据

insert into user_test values(12, 'cassie', '123456', 25);

insert into user_test values(11, 'zhangs', '1234562', 26);

insert into user_test values(23, 'zhangs', '2321312', 27);

insert into user_test values(22, 'tom', 'asdfg', 28);

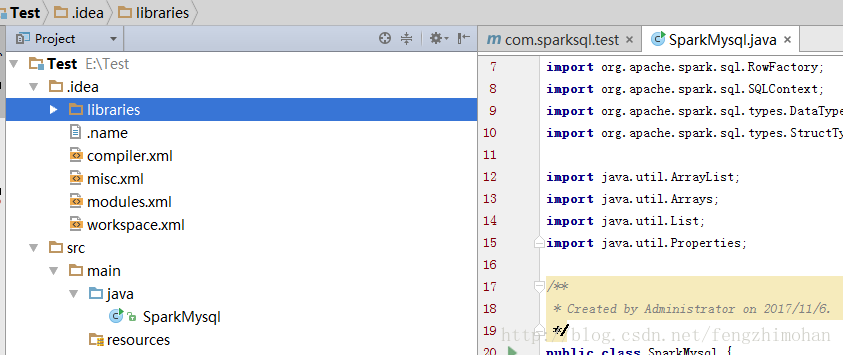

3.创建maven工程,命名为Test,添加java类SparkMysql

添加依赖包

pom文件内容:

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion> <groupId>SparkSQL</groupId>

<artifactId>com.sparksql.test</artifactId>

<version>1.0-SNAPSHOT</version>

<properties>

<java.version>1.8</java.version>

</properties>

<dependencies>

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

<version>5.1.24</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>2.6.0</version>

</dependency>

<dependency>

<groupId>net.sf.json-lib</groupId>

<artifactId>json-lib</artifactId>

<version>2.4</version>

<classifier>jdk15</classifier>

</dependency> </dependencies> </project>

4.编写spark代码

import org.apache.spark.SparkConf;

import org.apache.spark.api.java.JavaSparkContext;

import org.apache.spark.sql.DataFrame;

import org.apache.spark.sql.SQLContext; import java.util.Properties; /**

* Created by Administrator on 2017/11/6.

*/

public class SparkMysql {

public static org.apache.log4j.Logger logger = org.apache.log4j.Logger.getLogger(SparkMysql.class); public static void main(String[] args) {

JavaSparkContext sparkContext = new JavaSparkContext(new SparkConf().setAppName("SparkMysql").setMaster("local[5]"));

SQLContext sqlContext = new SQLContext(sparkContext);

//读取mysql数据

readMySQL(sqlContext); //停止SparkContext

sparkContext.stop();

}

private static void readMySQL(SQLContext sqlContext){

//jdbc.url=jdbc:mysql://localhost:3306/database

String url = "jdbc:mysql://localhost:3306/test";

//查找的表名

String table = "user_test";

//增加数据库的用户名(user)密码(password),指定test数据库的驱动(driver)

Properties connectionProperties = new Properties();

connectionProperties.put("user","root");

connectionProperties.put("password","123456");

connectionProperties.put("driver","com.mysql.jdbc.Driver"); //SparkJdbc读取Postgresql的products表内容

System.out.println("读取test数据库中的user_test表内容");

// 读取表中所有数据

DataFrame jdbcDF = sqlContext.read().jdbc(url,table,connectionProperties).select("*");

//显示数据

jdbcDF.show();

}

}

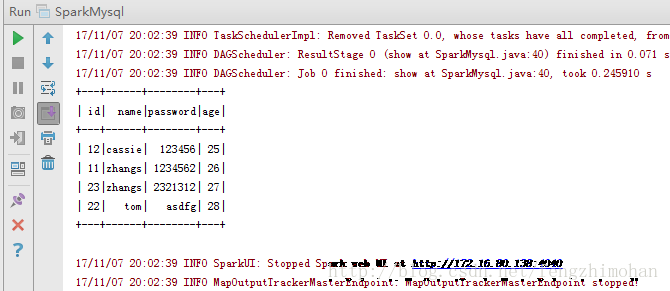

运行结果:

二.写入数据到mysql中

import org.apache.spark.SparkConf;

import org.apache.spark.api.java.JavaRDD;

import org.apache.spark.api.java.JavaSparkContext;

import org.apache.spark.api.java.function.Function;

import org.apache.spark.sql.DataFrame;

import org.apache.spark.sql.Row;

import org.apache.spark.sql.RowFactory;

import org.apache.spark.sql.SQLContext;

import org.apache.spark.sql.types.DataTypes;

import org.apache.spark.sql.types.StructType; import java.util.ArrayList;

import java.util.Arrays;

import java.util.List;

import java.util.Properties; /**

* Created by Administrator on 2017/11/6.

*/

public class SparkMysql {

public static org.apache.log4j.Logger logger = org.apache.log4j.Logger.getLogger(SparkMysql.class); public static void main(String[] args) {

JavaSparkContext sparkContext = new JavaSparkContext(new SparkConf().setAppName("SparkMysql").setMaster("local[5]"));

SQLContext sqlContext = new SQLContext(sparkContext);

//写入的数据内容

JavaRDD<String> personData = sparkContext.parallelize(Arrays.asList("1 tom 5","2 jack 6","3 alex 7"));

//数据库内容

String url = "jdbc:mysql://localhost:3306/test";

Properties connectionProperties = new Properties();

connectionProperties.put("user","root");

connectionProperties.put("password","123456");

connectionProperties.put("driver","com.mysql.jdbc.Driver");

/**

* 第一步:在RDD的基础上创建类型为Row的RDD

*/

//将RDD变成以Row为类型的RDD。Row可以简单理解为Table的一行数据

JavaRDD<Row> personsRDD = personData.map(new Function<String,Row>(){

public Row call(String line) throws Exception {

String[] splited = line.split(" ");

return RowFactory.create(Integer.valueOf(splited[0]),splited[1],Integer.valueOf(splited[2]));

}

}); /**

* 第二步:动态构造DataFrame的元数据。

*/

List structFields = new ArrayList();

structFields.add(DataTypes.createStructField("id",DataTypes.IntegerType,true));

structFields.add(DataTypes.createStructField("name",DataTypes.StringType,true));

structFields.add(DataTypes.createStructField("age",DataTypes.IntegerType,true)); //构建StructType,用于最后DataFrame元数据的描述

StructType structType = DataTypes.createStructType(structFields); /**

* 第三步:基于已有的元数据以及RDD<Row>来构造DataFrame

*/

DataFrame personsDF = sqlContext.createDataFrame(personsRDD,structType); /**

* 第四步:将数据写入到person表中

*/

personsDF.write().mode("append").jdbc(url,"person",connectionProperties); //停止SparkContext

sparkContext.stop();

}

}

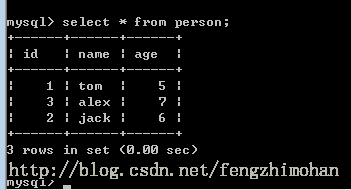

运行结果:

Spark使用Java读取mysql数据和保存数据到mysql的更多相关文章

- Learning Spark中文版--第五章--加载保存数据(2)

SequenceFiles(序列文件) SequenceFile是Hadoop的一种由键值对小文件组成的流行的格式.SequenceFIle有同步标记,Spark可以寻找标记点,然后与记录边界重新 ...

- spark通过JDBC读取外部数据库,过滤数据

官网链接: http://spark.apache.org/docs/latest/sql-programming-guide.html#jdbc-to-other-databases http:// ...

- Learning Spark中文版--第五章--加载保存数据(1)

开发工程师和数据科学家都会受益于本章的部分内容.工程师可能希望探索更多的输出格式,看看有没有一些适合他们下游用户的格式.数据科学家可能会更关注他们已经使用的数据格式. Motivation 我 ...

- Android开发学习---android下的数据持久化,保存数据到rom文件,android_data目录下文件访问的权限控制

一.需求 做一个类似QQ登录似的app,将数据写到ROM文件里,并对数据进行回显. 二.截图 登录界面: 文件浏览器,查看文件的保存路径:/data/data/com.amos.datasave/fi ...

- Python学习_从文件读取数据和保存数据

运用Python中的内置函数open()与文件进行交互 在HeadFirstPython网站中下载所有文件,解压后以chapter 3中的“sketch.txt”为例: 新建IDLE会话,首先导入os ...

- java读取记事本文件的部分数据添加到mysql

package com.tideway.readtxt; import java.io.BufferedReader; import java.io.FileInputStream; import j ...

- Java 读取Excel内容并保存进数据库

读取Excel中内容,并保存进数据库 步骤 建立数据库连接 读取文件内容 (fileInputStream 放进POI的对应Excel读取接口,实现Excel文件读取) 获取文件各种内容(总列数,总行 ...

- JAVA读取TXT文本中的数据

现在在Demo.txt中存在数据: ABC 需要将ABC从文本文件中读取出来 代码片: import java.io.*; class FileReaderDemo { public static v ...

- Java读取Excel指定列的数据详细教程和注意事项

本文使用jxl.jar工具类库实现读取Excel中指定列的数据. jxl.jar是通过java操作excel表格的工具类库,是由java语言开发而成的.这套API是纯Java的,并不依赖Windows ...

随机推荐

- L2Dwidget

只需要在[页首html代码]中引入L2Dwidget.js即可.<!-- 右下角live2d效果 --> <script src="https://eqcn.ajz.mie ...

- 配置进程外Session 同时解决一个奇怪的BUG 因为SQLserver 服务器名不是默认的.或者localhost而引发的一系列问题

用公司的电脑学习如鹏网的视频,开发一个项目,用到了进程外session,因为公司电脑SQLServer 是2008 服务器名称是. 然后参考这篇文章进行设置进程外session 很顺利 完成了设置. ...

- Idea maven项目不能新建package和class的解决【转】

如图,新建的maven项目不能新建package 这是因为java是普通的文件夹,要设置为 现在就可以了 博客原链接:http://blog.csdn.net/qq_24949727/article/ ...

- 使用Surface View来显示图片

public class YUVImageView extends SurfaceView { private static final String TAG = "YUVImageView ...

- mysql各种join连接查询

最近项目用到了几次sql join查询 来满足银行变态的需求:正好晚上自学时,看到了相关视频,所以记录下相关知识,下次再用时,根据如下图片,便可知道 怎么写sql; 注意点: 在join操作中的 on ...

- dubbo服务调试管理实用命令

公司如果分项目组开发的,各个项目组调用各项目组的接口,有时候需要在联调环境调试对方的接口,可以直接telnet到dubbo的服务通过命令查看已经布的接口和方法,并能直接invoke具体的方法,我们可以 ...

- jQuery HTML- 添加元素

添加内容 html <!DOCTYPE html> <html> <head> <meta charset="utf-8" /> & ...

- ganglia监控部署

1.ganglia组件 ganglia 相比于falcon和zabbix主要在于集群的状态集中显示,可以很便捷的对比各主机的性能状态. gmond:相当于是agent端,主要用于收集各node的性能状 ...

- 【python3】基于scrapyd + scrapydweb 的可视化部署

一.部署组件概览 该部署方式适用于 scrapy项目.scrapy-redis的分布式爬虫项目 需要安装的组件有: 1.scrapyd 服务端 [运行打包后的爬虫代码](所有的爬虫机器都要安 ...

- shell脚本编写nginx部署脚本

下面为shell脚本编写的nginx的安装及修改nginx.conf的脚本,脚本比较简单: #!/bin/bash function yum_install(){ yum install epel-r ...