Context-Aware Network Embedding for Relation Modeling

Context-Aware Network Embedding for Relation Modeling

论文:http://www.aclweb.org/anthology/P17-1158

创新点:

- 考虑属性连边关系

- 引入卷积神经网络

- 结构信息借助深层网络表示,将不同节点间关联信息融入CNN中

- 基于TensorFlow 架构实现CNN

- 首先通过 cnn 得到网络顶点的一个 embedding(context-free embedding)

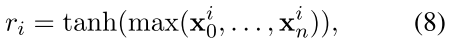

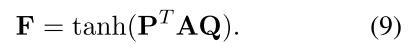

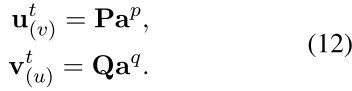

- 之后通过计算该节点与相邻节点的 mutual attention(在 pooling 层引入一个相关程度矩阵),得到顶点针对该相邻节点的 context-aware embedding

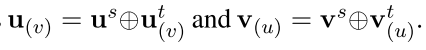

- 最终顶点的 embedding 表示由这两个 embedding 结合得到

总结

任务

背景

1. 概述

2. 相关概念

3. 模型构建

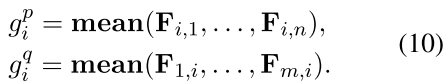

- 基于结构的嵌入 Vs

- 基于文本的嵌入 Vt

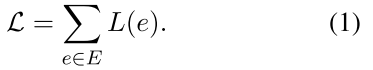

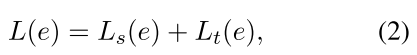

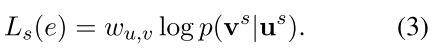

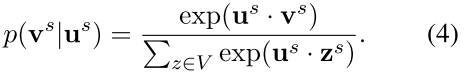

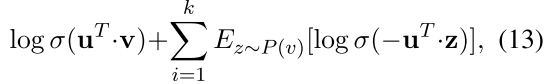

3.1. 基于结构的目标函数

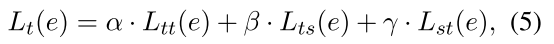

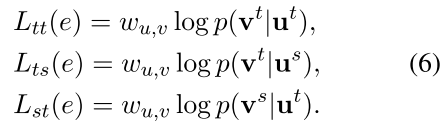

3.2. 基于文本的目标函数(无感知/上下文感知,决定V是否为上下文感知)

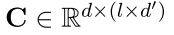

4. CNN 在表示学习的转化应用

4.1. 无上下文文本嵌入

1. Looking-up

2. convolution

4.2. CANE 优化

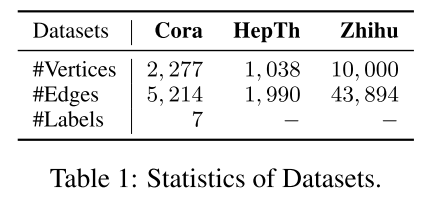

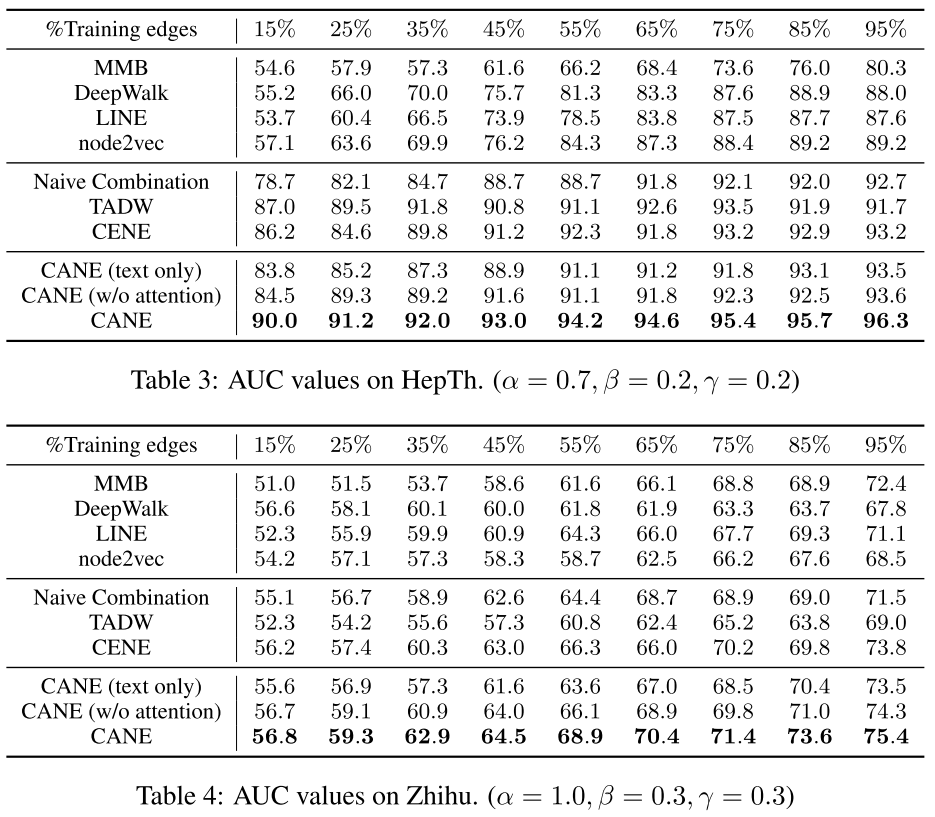

5. 实验

- Cora:引文网络

- 含有text 信息

- 有分类信息

- 存在标签信息缺失

- HepTh

- arxiv 的引文网络

6. baseline

- MMB(Mixed Membership Stochastic Blockmodel)

- 关系数据的传统图形模型,允许每个顶点形成边缘时随机选择不同“主题”

- DeepWalk

- 通过网络随机游走并使用Skip-Gram 模型学习顶点嵌入

- LINE

- 使用一阶和二阶邻域学习大规模网络中的顶点嵌入

- Node2vec

- 基于DeepWalk 的偏向随机游走算法,可有效检索邻域架构

- Naive Combination

- 简单将基于结构的嵌入于基于CNN 的嵌入连接表示顶点

- TADW

- 采用矩阵分解合并顶点文本特征进行网络嵌入

- CENE

- 通过将文本内容视为特殊顶点利用结构和文本信息,并优化异构链接的概率

7. 评估指标和实验设置

- 链路预测

- 采用标准的评估矩阵 AUC,表示随机未观察到的链接中的顶点比随机不存在的链接中的顶点更相似的概率

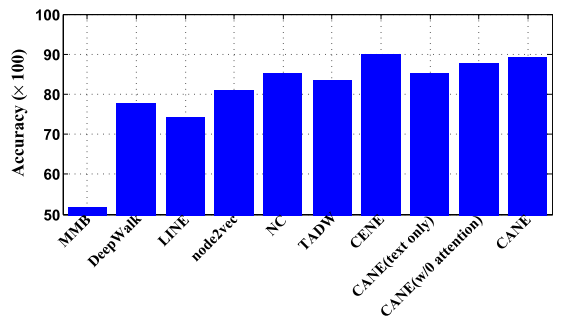

- 顶点分类

- L2 正则化逻辑回归(L2R-LR) 训练分类器,并评估各种方法的分类准确性

- LINE

- 负样本数量 5

- 分别学习100 维一阶和二阶嵌入,连接形成200 维嵌入

- node2vec

- 采用网格搜索选择最佳执行的超参数进行训练

- CANE

- 应用网格搜索设置CANE中的超参数

- 将负样本数k 设置为 1,加快训练过程

- 用三个版本CANE 验证

- text-only

- CANE without attention

- CANE

8. 结果显示

- 通过平均操作转换为高质量的无上下文嵌入

9. 可改进/受限

- 本文考虑的 context 是针对一条边所连接的节点文本信息,

- 可将节点 context 认为是该节点连接的边及其邻居节点信息

- 节点表示可能方案:将抽取到的selective attention 找到和该节点连接重要的边,再使用mutual attention 对节点的text 和 边邻域节点的text 进行融合表示

Context-Aware Network Embedding for Relation Modeling的更多相关文章

- Network Embedding 论文小览

Network Embedding 论文小览 转自:http://blog.csdn.net/Dark_Scope/article/details/74279582,感谢分享! 自从word2vec横 ...

- network embedding 需读论文

Must-read papers on NRL/NE. github: https://github.com/nate-russell/Network-Embedding-Resources NRL: ...

- [CVPR2017] Visual Translation Embedding Network for Visual Relation Detection 论文笔记

http://www.ee.columbia.edu/ln/dvmm/publications/17/zhang2017visual.pdf Visual Translation Embedding ...

- 论文阅读:Relation Structure-Aware Heterogeneous Information Network Embedding

Relation Structure-Aware Heterogeneous Information Network Embedding(RHINE) (AAAI 2019) 本文结构 (1) 解决问 ...

- [论文阅读笔记] Community aware random walk for network embedding

[论文阅读笔记] Community aware random walk for network embedding 本文结构 解决问题 主要贡献 算法原理 参考文献 (1) 解决问题 先前许多算法都 ...

- 论文阅读 Dynamic Network Embedding by Modeling Triadic Closure Process

3 Dynamic Network Embedding by Modeling Triadic Closure Process link:https://scholar.google.com.sg/s ...

- On the Optimal Approach of Survivable Virtual Network Embedding in Virtualized SDN

Introduction and related work 云数据中心对于虚拟技术是理想的创新地方. 可生存性虚拟网络映射(surviavable virtual network embedding ...

- NEU(Fst Network Embedding Enhancement via High Order Proximity Approximation)

NEU(Fst Network Embedding Enhancement via High Order Proximity Approximation) NEU:通过对高阶相似性的近似,加持快速网络 ...

- 论文:network embedding

KDD2016: network embedding model: deep walk(kdd 2014): http://videolectures.net/kdd2014_perozzi_deep ...

随机推荐

- BZOJ2875 & 洛谷2044:[NOI2012]随机数生成器——题解

https://www.lydsy.com/JudgeOnline/problem.php?id=2875 https://www.luogu.org/problemnew/show/P2044 栋栋 ...

- BZOJ1997:[HNOI2010]PLANAR——题解

https://www.lydsy.com/JudgeOnline/problem.php?id=1997 https://www.luogu.org/problemnew/show/P3209 若能 ...

- bzoj1010: [HNOI2008]玩具装箱toy(斜率优化DP)

Orz CYC帮我纠正了个错误.斜率优化并不需要决策单调性,只需要斜率式右边的式子单调就可以了 codevs也有这题,伪·双倍经验233 首先朴素DP方程很容易看出:f[i]=min(f[j]+(i- ...

- java 实现多个接口 方法重名的解决办法——内部类

package com.kk.innerClass; /** * 通过内部类实现接口 * 解决多个接口中方法重名问题 * */interface Machine { void run();} clas ...

- 爬虫实例——爬取煎蛋网OOXX频道(反反爬虫——伪装成浏览器)

煎蛋网在反爬虫方面做了不少工作,无法通过正常的方式爬取,比如用下面这段代码爬取无法得到我们想要的源代码. import requests url = 'http://jandan.net/ooxx' ...

- 如何修改即时聊天websocket的端口号

需要修改2个地方 1.修改\src\main\java\com\woodstudio\framework\modules\chat\StartFilter.java里面的端口号 2.修改\src\ ...

- spring 整合 redis 单机版

增加spring配置文件: application-jedis.xml <?xml version="1.0" encoding="UTF-8"?> ...

- POJ3164:Command Network(有向图的最小生成树)

Command Network Time Limit: 1000MS Memory Limit: 131072K Total Submissions: 20766 Accepted: 5920 ...

- android xml字符串通配

1.基本使用方法 xml中定义如下字符串: <string name="buff">%1$d --- %2$s</string> 代码中解析: String ...

- vue实现菜单权限控制

大家在做后台管理系统时一般都会涉及到菜单的权限控制问题.当然解决问题的方法无非两种——前端控制和后端控制.我们公司这边的产品迭代速度较快,所以我们是从前端控制路由迭代到后端控制路由.下面我会分别介绍这 ...