Python爬虫教程-24-数据提取-BeautifulSoup4(二)

Python爬虫教程-24-数据提取-BeautifulSoup4(二)

本篇介绍 bs 如何遍历一个文档对象

遍历文档对象

- contents:tag 的子节点以列表的方式输出

- children:子节点以迭代器形式返回

- descendants:所有子孙节点

- string:用string打印出标签的具体内容,不带有标签,只有内容

- 案例代码27bs3.py文件:https://xpwi.github.io/py/py爬虫/py27bs3.py

# BeautifulSoup 的使用案例

# 遍历文档对象

from urllib import request

from bs4 import BeautifulSoup

url = 'http://www.baidu.com/'

rsp = request.urlopen(url)

content = rsp.read()

soup = BeautifulSoup(content, 'lxml')

# bs 自动解码

content = soup.prettify()

print("=="*12)

# 使用 contents

for node in soup.head.contents:

if node.name == "meta":

print(node)

if node.name == "title":

print(node.string)

print("=="*12)

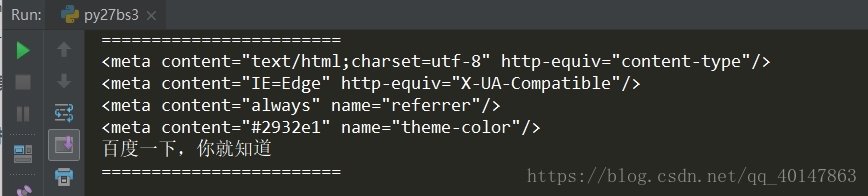

运行结果

常用string打印出标签的具体内容,不带有标签,只有内容

当然,如果觉得遍历太耗费资源,没有必要遍历的时候,可以使用搜索

搜索文档对象

- find_all(name, attrs, recursive, text, ** kwargs)

- 使用find_all(),返回的列表格式,也就是说如果 find_all(name='meta') ,如果有多个 meta 就以列表形式返回

- name 参数:按照哪个字符搜索,可以传入的内容为

- 1.字符串

- 2.正则表达式,使用正则需要编译:

例如:我们需要打印所有以 me 开头的标签内容

tags = soup.find_all(re.compile('^me')) - 3.也可以是列表

- keyword 参数,可以用来表示属性

- text:对应 tag 的文本值

- 案例代码27bs4.py文件:https://xpwi.github.io/py/py爬虫/py27bs4.py

# BeautifulSoup 的使用案例

# 搜索文档对象

from urllib import request

from bs4 import BeautifulSoup

import re

url = 'http://www.baidu.com/'

rsp = request.urlopen(url)

content = rsp.read()

soup = BeautifulSoup(content, 'lxml')

# bs 自动解码

content = soup.prettify()

# 使用 find_all

# 使用 name 参数

print("=="*12)

tags = soup.find_all(name='link')

for i in tags:

print(i)

# 使用正则表达式

print("=="*12)

# 同时使用两个条件

tags = soup.find_all(re.compile('^me'), content='always')

# 这里直接打印 tags 会打印一个列表

for i in tags:

print(i)

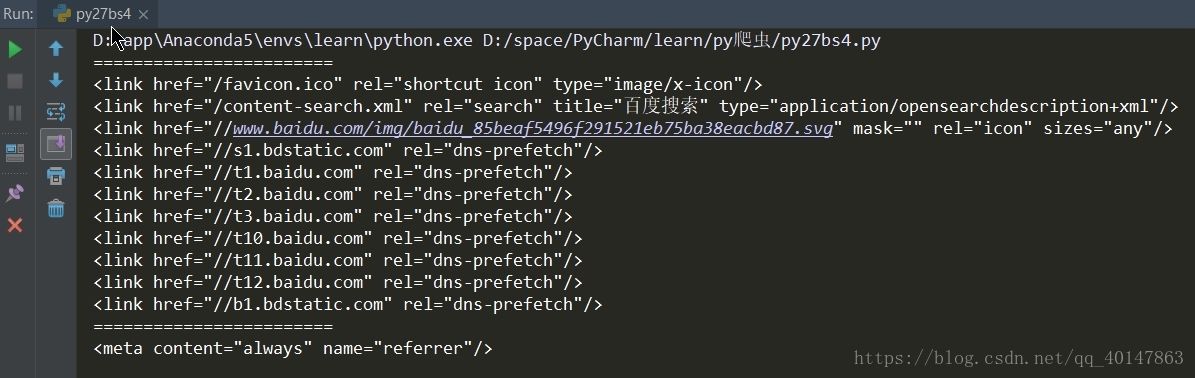

运行结果:

因为使用两个条件,所以只匹配到一条 meta

下一篇介绍,BeautifulSoup 的 css 选择器

更多文章链接:Python 爬虫随笔

- 本笔记不允许任何个人和组织转载

Python爬虫教程-24-数据提取-BeautifulSoup4(二)的更多相关文章

- Python爬虫教程-23-数据提取-BeautifulSoup4(一)

Beautiful Soup是python的一个库,最主要的功能是从网页抓取数据,查看文档 https://www.crummy.com/software/BeautifulSoup/bs4/doc. ...

- Python爬虫教程-25-数据提取-BeautifulSoup4(三)

Python爬虫教程-25-数据提取-BeautifulSoup4(三) 本篇介绍 BeautifulSoup 中的 css 选择器 css 选择器 使用 soup.select 返回一个列表 通过标 ...

- Python爬虫教程-19-数据提取-正则表达式(re)

本篇主页内容:match的基本使用,search的基本使用,findall,finditer的基本使用,匹配中文,贪婪与非贪婪模式 Python爬虫教程-19-数据提取-正则表达式(re) 正则表达式 ...

- Python爬虫教程-01-爬虫介绍

Spider-01-爬虫介绍 Python 爬虫的知识量不是特别大,但是需要不停和网页打交道,每个网页情况都有所差异,所以对应变能力有些要求 爬虫准备工作 参考资料 精通Python爬虫框架Scrap ...

- Python爬虫教程-00-写在前面

鉴于好多人想学Python爬虫,缺没有简单易学的教程,我将在CSDN和大家分享Python爬虫的学习笔记,不定期更新 基础要求 Python 基础知识 Python 的基础知识,大家可以去菜鸟教程进行 ...

- Python爬虫教程-18-页面解析和数据提取

本篇针对的数据是已经存在在页面上的数据,不包括动态生成的数据,今天是对HTML中提取对我们有用的数据,去除无用的数据 Python爬虫教程-18-页面解析和数据提取 结构化数据:先有的结构,再谈数据 ...

- python爬虫的页面数据解析和提取/xpath/bs4/jsonpath/正则(1)

一.数据类型及解析方式 一般来讲对我们而言,需要抓取的是某个网站或者某个应用的内容,提取有用的价值.内容一般分为两部分,非结构化的数据 和 结构化的数据. 非结构化数据:先有数据,再有结构, 结构化数 ...

- Python爬虫教程-34-分布式爬虫介绍

Python爬虫教程-34-分布式爬虫介绍 分布式爬虫在实际应用中还算是多的,本篇简单介绍一下分布式爬虫 什么是分布式爬虫 分布式爬虫就是多台计算机上都安装爬虫程序,重点是联合采集.单机爬虫就是只在一 ...

- Python爬虫教程-33-scrapy shell 的使用

本篇详细介绍 scrapy shell 的使用,也介绍了使用 xpath 进行精确查找 Python爬虫教程-33-scrapy shell 的使用 scrapy shell 的使用 条件:我们需要先 ...

随机推荐

- 【Template】Miller Rabin

#include<cstdio> #include<cstring> #include<iostream> #include<algorithm> #i ...

- FreeRTOS-02任务挂起和恢复

根据正点原子FreeRTOS视频整理 单片机:STM32F207VC FreeRTOS源码版本:v10.0.1 任务挂起和恢复API函数: 工程列表: 1. main.c /**/ #include ...

- 网络编程- 解决黏包现象方案二之struct模块(七)

上面利用struct模块与方案一比较,减少一次发送和接收请求,因为方案一无法知道client端发送内容的长度到底有多长需要和接收OK.多一次请求防止黏包,减少网络延迟

- Java使用占位符拼接字符串-String.format()的使用

String domain = "www.ykmaiz.com"; int iVisit = 0; String info = String.format("该域名%s被 ...

- 05-oralce转换函数

to_char() 设置日期的显示格式 to_char() 进行数字格式化{如:to_char(987654321.789,'999,999,999,999,999.9999') 将数字三位一逗号显 ...

- 爬虫--requeste

1.requeste模块,是我们Python对我们爬虫有好的一面,,其主要作用是用来模拟浏览器发起请求.功能强大,用法简洁高效.在爬虫领域中占据着半壁江山的地位.没有的话直接pip3 install ...

- 我的Python升级打怪之路【六】:面向对象(二)

面向对象的一些相关知识点 一.isinstance(obj,cls) 检查实例obj是否是类cls的对象 class Foo(object): pass obj = Foo() isinstance( ...

- jedis入门教程

1 jedis介绍 2 java连接Redis 1 导入jar包 2 连接实例 @Test //获得单一的jedis对象操作数据库 public void test1(){ //1.获得连接对象 设置 ...

- 解决display none到display block 渲染时间过长的问题,以及bootstrap模态框导致其他框中input不能获得焦点问题的解决

在做定制页面的时候,遇到这么一个问题,因为弹出框用的是bootstrap的自带的弹出框,控制显示和隐藏也是用自带的属性控制 控制显示,在触发的地方 例如botton上面加上 data-toggle=& ...

- Android规划周期任务

问题:应用总要周期性的执行某项任务,例如检查服务器上的更新或者提醒用户做某些事情. 解决方案:用AlarmManager来管理和执行任务.AlarmManager可用于计划未来的单次或重复操作,甚至在 ...