Hbase写入hdfs源码分析

版权声明:本文由熊训德原创文章,转载请注明出处:

文章原文链接:https://www.qcloud.com/community/article/258

来源:腾云阁 https://www.qcloud.com/community

本文档从源码角度分析了,hbase作为dfs client写入hdfs的hadoop sequence文件最终刷盘落地的过程。

之前在《wal线程模型源码分析》中描述wal的写过程时说过会写入hadoop sequence文件,hbase为了保证数据的安全性,一般都是写入同为hadoop生态的hdfs(Hadoop Distribute File System)中。append的最终结果是使用write.append()写入,而sync()则是使用write.sync()刷盘。这时其实并未真正的结束,为了保障数据安全性,hdfs可会根据用户的配置写到多个datanode节点中,不管是HFile还是FSHLog都不仅仅是简单的写入或刷入(flush)了真正的存储节点--DataNode中,其中涉及到数据流(WALEntry)如何安全有序且高效地写到datanode文件中,而flush又是具体如何做的,这个文档就将从源码上分析hbase的“写”操作到了wirter.append()和writer.sync()后具体发生了什么,如何落地的。

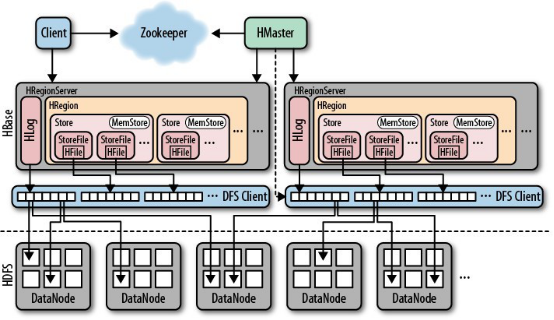

下图是《Hbase权威指南》中描述Hbase底层存储结构的顶层结构图。可以看到Hbase将处理HFile文件(memstore生成)和HLog文件(WAL生成)这两种文件都将有HRegionServer管理,当真正存储到HDFS中时,会使用DFS Client作为hdfs的客户端把大批量的这两种数据流写到多个DataNode节点中。

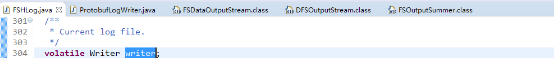

在文档 《wal线程模型源码分析》中为了突出重点说明wal线程模型,并未具体说明writer.append()和writer.sync()中writer实例是什么,在FSHLog中被volatile关键字修饰声明为一个WALProvider.Writer类型的接口:

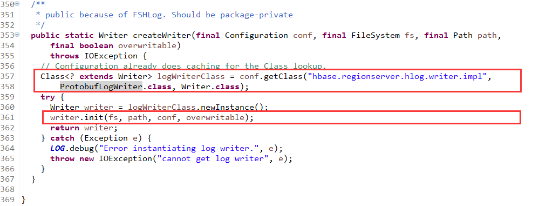

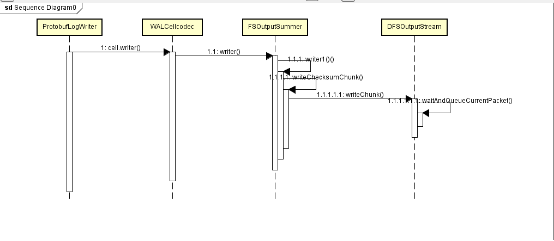

其实它的实现类是ProtobufLogWriter,这个类也在org.apache.hadoop.hbase.regionserver.wal包中,在wal包中是作为wal向datanode的writer,它在FSHLog是使用工厂模式createWriterInstance()实例化,然后调用init()方法初始化:

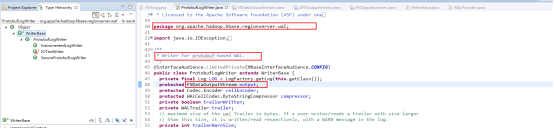

从源码中可以看到真正写实例是FSDataOutputStream,它用于向新生成的文件中写入数据,就像前面叙述的,在ProtobufLogWriter的init()方法中被初始化:

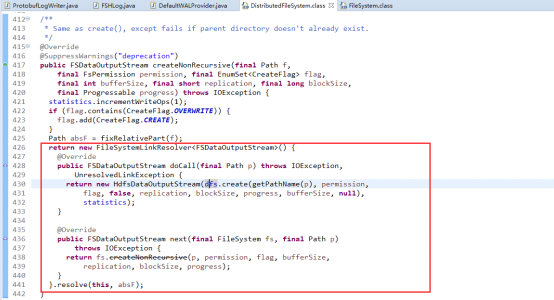

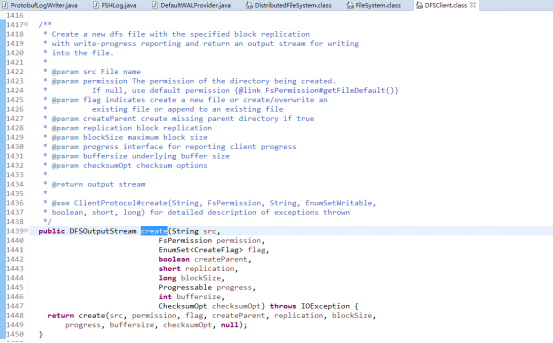

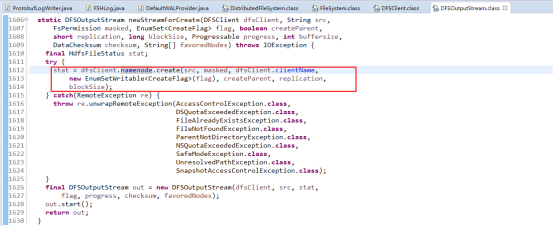

在这里我们仅仅讨论使用hdfs作为hbase的文件系统,也即是init参数中fs(System)是DistributedFileSystem的实例。在其createNonRecursive的实现的参数除了path参数指明需要在hdfs创建的文件路径比较重要以外,还有一个replication参数也很重要,这个参数说明了备份数量也即是写datanode份数。DistributedFileSystem中dfs是DFSClient的实例引用,也即最开始那张架构图中所指的DFS Client。hbase使用DFSClient的create方法通过RPC调用向hdfs的namenode创建一个文件并构造了输出流DFSOutputStream实例,这个方法另外一个重点就启动了一个pipeline,具体调用是streamer.start(),这个pipleline是hbase向hdfs的多个datanode管道写的实现。虽然这里分析的是wal的写入过程,但是其实keyvalue写到memstore,再写到HFile后也是采用这种方式管道写(pipeline)的方式实现。

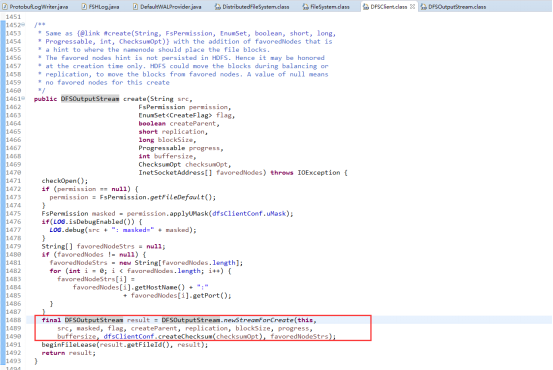

通过rpc调用NameNode的create函数,调用namesystem.startFile函数,其又调用startFileInternal函数,它创建一个新的文件,状态为under construction,没有任何data block与之对应。于此同时创建成功后会返回一个DFSOutputStream类型的实例,在FSDataOutputStream中被称作wrappedStream,该对象负责处理datanode和namenode之间的通讯。

hdfs的文件结构,HDFS一个文件由多个block(默认64MB)构成。这里通过注释可以看到HDFS在进行block读写的时候是以packet(默认每个packet为64K)为单位进行的。每一个packet由若干个chunk(默认512Byte)组成。Chunk是进行数据校验的基本单位,对每一个chunk生成一个校验和(默认4Byte)并将校验和进行存储。

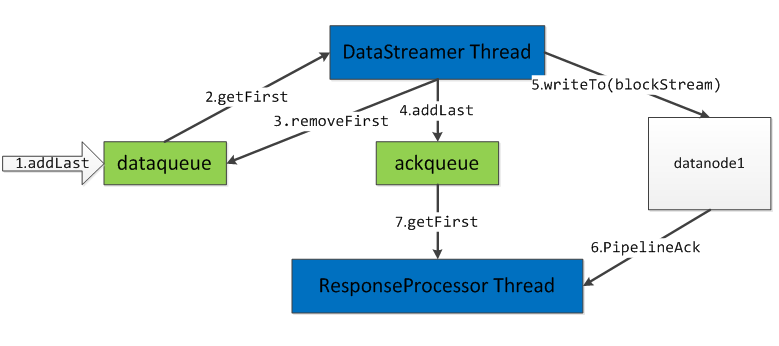

分析到这,已经可以看出hbase文件写入hdfs的过程并没有特别,hdfs就把hbase当做hdfs的client然后封装成chunk再组装成packet,再向datanode批量写数据。为了保证数据有序的传输,使用了数据发送队列dataqueue和待确认队列ackqueue,并使用两个线程DFSOutputStream$DataStreamer和DFSOutputStream$DataStreamer$ResponseProcessor(在run()中)分别来发送数据到对应block和确认数据是否到达。

还有另外一个重点就是hbase是如何把数据到datanode的磁盘的。

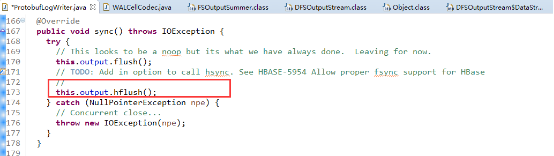

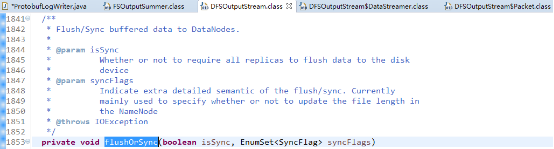

在此,我们又要回到ProtobufLogWriter类中因为writer.sync()最终调用的就是ProtobufLogWriter的writer方法,它的源码如下:

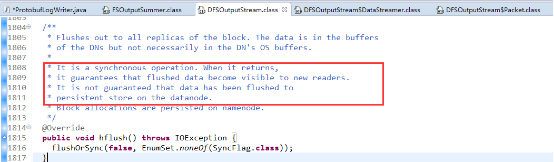

其中,output在就是之前分析过的FSDataOutputStream的实例,在sync()方法中调用了FSDataOutputStream的flush和hflush,其实flush什么都没做(noop,源码中也说明了),hflush()则会调用也是前面提过的DFSOutputStrem类的hflush方法,hflush方法将Client缓存的所有数据(packet)立即发送给Datanodes,并阻塞直到它们写入成功为止。hflush之后,可以确保Client端故障不会导致数据丢失,但如果Datanodes失效仍有丢失数据的可能,当FSDataOutputStream关闭时也会额外的执行一次flush操作:

就像注释中所解释的一样,hflush是同步的只能保证能让新reader能看到,但是并不能保证其真正的持久化到了每个datanode中,也即没真的调用posix中的fsync()系统调用。它只是将client端写入的数据刷到每个DataNode的OS缓存(store)中,如果每个副本所在的DataNode同时crash时(例如机房断电)将会导致数据丢失。

hdfs给客户端还提供了另外一种语义hsync:client端所有的数据都发送到副本的每个datanode上,并且datanode上的每个副本都完成了posix中fsync的调用,也就是说操作系统已经把数据刷到磁盘上(当然磁盘也可能缓冲数据);需要注意的是当调用fsync时只有当前的block会刷到磁盘中,要想每个block都刷到磁盘,必须在创建流时传入Sync标示。

hbase当前选择的是hflush语义。这两种语义都调用的flushOrsync方法,其中hflush调用的isSync传入false,而hsync传入的是true。

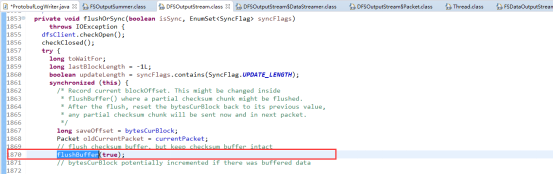

这个方法的主要作用就是把还在缓存(buffered )中的数据刷到datanodes中,

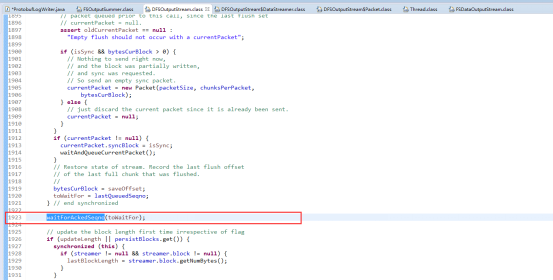

其中最终要的几个方法就是flushBuffer(),waitAndQueueCurrentPackket()和waitForAckedSeqno(),调用waitAndQueueCurrentPacket()将当前Package放到发送队列中waitForAckedSeqno()等待发送package的确认包,而其原理和写数据一样,就是把数据封装成chunk在把chunk一个个填充到package,再以pipeline的方式一个个写到datanode再根据是否有sync标识刷盘。

waitForAckedSeqno()就是用于等待ackqueue中的ack回来,并被唤醒。

Hbase写入hdfs源码分析的更多相关文章

- HDFS源码分析数据块汇报之损坏数据块检测checkReplicaCorrupt()

无论是第一次,还是之后的每次数据块汇报,名字名字节点都会对汇报上来的数据块进行检测,看看其是否为损坏的数据块.那么,损坏数据块是如何被检测的呢?本文,我们将研究下损坏数据块检测的checkReplic ...

- HDFS源码分析之数据块及副本状态BlockUCState、ReplicaState

关于数据块.副本的介绍,请参考文章<HDFS源码分析之数据块Block.副本Replica>. 一.数据块状态BlockUCState 数据块状态用枚举类BlockUCState来表示,代 ...

- HDFS源码分析DataXceiver之整体流程

在<HDFS源码分析之DataXceiverServer>一文中,我们了解到在DataNode中,有一个后台工作的线程DataXceiverServer.它被用于接收来自客户端或其他数据节 ...

- HDFS源码分析之UnderReplicatedBlocks(一)

http://blog.csdn.net/lipeng_bigdata/article/details/51160359 UnderReplicatedBlocks是HDFS中关于块复制的一个重要数据 ...

- HDFS源码分析数据块校验之DataBlockScanner

DataBlockScanner是运行在数据节点DataNode上的一个后台线程.它为所有的块池管理块扫描.针对每个块池,一个BlockPoolSliceScanner对象将会被创建,其运行在一个单独 ...

- HDFS源码分析数据块复制监控线程ReplicationMonitor(二)

HDFS源码分析数据块复制监控线程ReplicationMonitor(二)

- HDFS源码分析数据块复制监控线程ReplicationMonitor(一)

ReplicationMonitor是HDFS中关于数据块复制的监控线程,它的主要作用就是计算DataNode工作,并将复制请求超时的块重新加入到待调度队列.其定义及作为线程核心的run()方法如下: ...

- HDFS源码分析之UnderReplicatedBlocks(二)

UnderReplicatedBlocks还提供了一个数据块迭代器BlockIterator,用于遍历其中的数据块.它是UnderReplicatedBlocks的内部类,有三个成员变量,如下: // ...

- HDFS源码分析之LightWeightGSet

LightWeightGSet是名字节点NameNode在内存中存储全部数据块信息的类BlocksMap需要的一个重要数据结构,它是一个占用较低内存的集合的实现,它使用一个数组array存储元素,使用 ...

随机推荐

- 史上最臭名昭著五大软件Bug

在现今数字年代,计算机bug不但困扰着每个程序员,更会无可避免影响我们的生活,小到每个人的衣食住行,大到国家经济,世界局势.随着我们的生活方式渐渐的数字化.互联网化,数字世界的找虫和杀虫就变得越来越重 ...

- jQuery 中 attr() 和 prop() 方法的区别

前几天,有人给 Multiple Select 插件 提了问题: setSelects doesn't work in Firefox when using jquery 1.9.0 一直都在用 jQ ...

- [BS-30] 你真的会用storyboard开发吗?

你真的会用storyboard开发吗? 随着苹果大屏手机的推出,苹果公司马上推出了屏幕适配的一些东西Constraints and Size Classes同时,在开发项目时候,是使用sb还是写代 ...

- 打开VS调试不进入开发的网站直接跳转到主页

重启了熟悉有卸载IE11的,搞了好几个小时 最后把电脑管家里的锁定主页打开就好了! 很久之后 我再锁上 也没有这问题了

- 忘记Linux root用户的密码怎么办?

以前忘记windows密码的时候,要么用工具清除,要么重装系统.假如你忘记了linux系统的root密码,怎么办呢?是像windows一样用工具破解还是重装系统呢?哈哈,都不用.这方法很简单,现在做一 ...

- jquery实时监测手机号是否符合规则,并根据手机号检测结果将提交按钮设为不同状态

功能: 输入手机号,实时判断手机号输入的是否符合规则: 如果不合规则,则提交按钮为禁用状态,手机号信息不可提交,按钮显示灰色背景: 如果符合规则,则可提交所输入的手机号信息,并将按钮背景设成红色. 代 ...

- leetcode 374

这个题目很简单,但是要注意细节和对题目的理解,一开始我把guess函数的作用理解错了,第一版代码长这样: int guessNumber(int n) { ; int high = n; while( ...

- jQuery简介及语法

jQuery引入 jQuery语法

- Repeater控件三层嵌套-内层Repeater添加绑定事件

用Repeater三层嵌套,最外层Repeater可以生成自己的ItemCommand事件.但接下来中间层因为是嵌套了的,所以无法在属性窗口中生成自己的事件.如果手动敲入则无效. 解决办法是需要通过编 ...

- viewdata向view传递匿名类,view该如何遍历?

//方法中的代码var userInfoList = from p in db.UserInfo select new {UserID=p.ID, UserName = p.UName, UserPw ...