Scrapy_redis

简介

scrapy_redis是一个基于Redis的Scrapy组件,用于scrapy项目的分布式部署和开发

你可以启动多个spider对象,互相之间共享有一个redis的request队列,最适合多个域名的广泛内容的爬取

特点

分布式爬取

分布式数据处理

爬取到的item数据被推送到redis中,这意味着你可以启动尽可能多的item处理程序

scrapy即插即用

scrapy调度程序+过滤器,项目管道,base spidre

安装

pip install scrapy-redis

使用

首先创建scrapy的项目

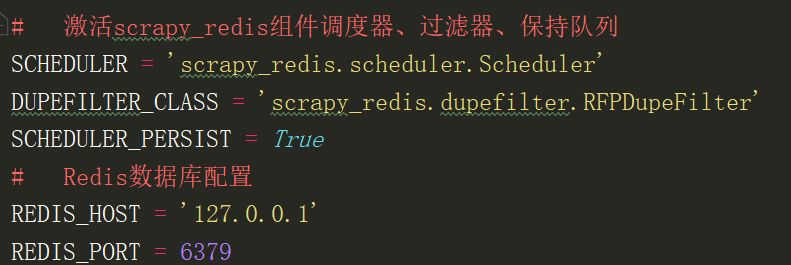

在settings修改默认的调度器和过滤

SCHEDULER = 'scrapy_redis.scheduler.Scheduler'

DUPEFILTER_CLASS = 'scrapy_redis.dupefilter.RFPDupeFilter'

SCHEDULER_PERSIST = True

在spider里面修改继承的类RedisSpider,属性redis_key

常用设置

# 启用调度将请求存储进redis SCHEDULER = "scrapy_redis.scheduler.Scheduler"

# 确保所有spider通过redis共享相同的重复过滤 DUPEFILTER_CLASS = "scrapy_redis.dupefilter.RFPDupeFilter"

# 不清理redis队列,允许暂停/恢复抓取 SCHEDULER_PERSIST = True

# 指定连接到Redis时要使用的主机和端口 REDIS_HOST = 'localhost'

REDIS_PORT = 6379

redis中存储的数据

spidername:items list类型,保存爬虫获取到的数据item内容是json字符串

spidername:dupefilter set类型,用于爬虫访问的URL去重,内容是40个字符的url的hash字符串

spidername:start_urls list类型,用于接收redisspider启动时的第一个url

spidername:requests zset类型,用于存放requests等待调度。内容是requests对象的序列化字符串

Scrapy_redis的更多相关文章

- scrapy分布式爬虫scrapy_redis二篇

=============================================================== Scrapy-Redis分布式爬虫框架 ================ ...

- scrapy分布式爬虫scrapy_redis一篇

分布式爬虫原理 首先我们来看一下scrapy的单机架构: 可以看到,scrapy单机模式,通过一个scrapy引擎通过一个调度器,将Requests队列中的request请求发给下载器,进行页 ...

- scrapy_redis 相关: 多线程更新 score/request.priority

0.背景 使用 scrapy_redis 爬虫, 忘记或错误设置 request.priority(Rule 也可以通过参数 process_request 设置 request.priority), ...

- scrapy_redis 相关: 查看保存的数据

0.参考资料 https://redis.io/topics/data-types-intro An introduction to Redis data types and abstractions ...

- scrapy_redis实现爬虫

1.scrapy_redis的流程 在scrapy_redis中,所有的带抓取的对象和去重的指纹都存在所有的服务器公用的redis中 所有的服务器公用一个redis中的request对象 所有的req ...

- scrapy_redis项目配置

一.创建普通scrapy项目 二.spiders爬虫文件中修改项 import scrapy from XX.items import XXItem import json # ----1 导入类 f ...

- scrapy和scrapy_redis入门

Scarp框架 需求 获取网页的url 下载网页内容(Downloader下载器) 定位元素位置, 获取特定的信息(Spiders 蜘蛛) 存储信息(ItemPipeline, 一条一条从管里走) 队 ...

- 定制起始url(scrapy_redis)

爬虫:(在这里不用配置start_url,直接可以取redis里面取start_url,可以多个) from scrapy_redis.spiders import RedisSpider # cla ...

- [置顶]使用scrapy_redis,自动实时增量更新东方头条网全站新闻

存储使用mysql,增量更新东方头条全站新闻的标题 新闻简介 发布时间 新闻的每一页的内容 以及新闻内的所有图片.项目文件结构. 这是run.py的内容 1 #coding=utf-8 2 from ...

- 使用scrapy_redis,实时增量更新东方头条网全站新闻

存储使用mysql,增量更新东方头条全站新闻的标题 新闻简介 发布时间 新闻的每一页的内容 以及新闻内的所有图片.东方头条网没有反爬虫,新闻除了首页,其余板块的都是请求一个js.抓包就可以看到. 项目 ...

随机推荐

- C++之下载Visual Studio Installer缓慢问题

将IPv4中设置DNS首选项为8.8.8.8即可.

- 原生js的2048的制作过程

1.首先我们来看一下效果图 开始: 结束: 接下来我们来实现代码部分: HTML部分: 2048大家应该都玩过,首先我们要准备16个盒子让它4*4排列,这里的css我就不说了,这应该使我们都会的,在这 ...

- IT兄弟连 HTML5教程 CSS3属性特效 3D变换2

3 perspective-origin景深基点 perspective-origin景深基点属性时3D变形中另一个重要属性,主要用来决定perspective属性的源点角度.它实际上设置了X轴和Y ...

- 最近上传图片上传文件报413错误及仅Https下报413问题,IIS高版本的配置方案及Web.config配置全解

IIS文件上传大小限制30M,C盘中有的IIS_schema.xml文件 C:\Windows\System32\inetsrv\config\schema\ 但是考虑到安全等问题,而且这个文件默认是 ...

- 与用户xxx一起提供的密码不正确。请确认输入的密码正确并重试

环境: SharePoint 2010 / 2013 以系统账户身份登录管理中心,然后创建Web Application,报: 与用户xxx一起提供的密码不正确.请确认输入的密码正确并重试 明明都已经 ...

- Mybatis XML映射文件

mybatis为聚焦于SQL而构建,SQL映射文件常用的顶级元素如 resultMap,是最复杂也是最强大的元素,用来描述如何从数据库结果集中来加载对象. insert,映射插入语句 update, ...

- SQL Server之替换文本内容中的回车符和换行符

UPDATE 表 SET 栏位A = REPLACE(栏位A, CHAR(10), '') UPDATE表 SET 栏位A = REPLACE(栏位A, CHAR(13), '')

- 一、I/O模型之BIO

I/O模型之BIO 基本介绍 Java BIO 就是传统的 Java IO 编程,其相关的类和接口再 java.io 包下 BIO(blocking I/O):同步阻塞,服务器实现模式为一个连接一个线 ...

- ASP.NET Server对象

Server.HtmlEncode() 执行文本代码Server.HtmlDecode()可以将代码显示 而不是执行它 但是ASP.NET会认为恶意 我们可以将aspx代码开头添加validateRe ...

- Spring常用注解式开发

1.组件注册@Configuration.@Bean给容器中注册组件. 注解,@Configuration告诉Spring这是一个配置类,相当于bean.xml配置文件. 注解,@Bean给Sprin ...