Python爬取Boss直聘,帮你获取全国各类职业薪酬榜

前言

本文的文字及图片来源于网络,仅供学习、交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理。

作者: 王翔 清风Python

PS:如有需要Python学习资料的小伙伴可以加点击下方链接自行获取

http://note.youdao.com/noteshare?id=3054cce4add8a909e784ad934f956cef

爬虫面临的问题

不再是单纯的数据一把抓

多数的网站还是请求来了,一把将所有数据塞进去返回,但现在更多的网站使用数据的异步加载,爬虫不再像之前那么方便

很多人说js异步加载与数据解析,爬虫可以做到啊,恩是的,无非增加些工作量,那是你没遇到牛逼的前端,多数的解决办法只能靠渲染浏览器抓取,效率低下,接着往下走

千姿百态的登陆验证

从12306的说说下面哪个糖是奶糖,到现在各大网站的滑动拼图、汉子点击解锁,这些操作都是在为了阻止爬虫的自动化运行。

你说可以先登录了复制cookie,但cookie也有失效期吧?

反爬虫机制

何为反爬虫?犀利的解释网上到处搜,简单的逻辑我讲给你听。你几秒钟访问了我的网站一千次,不好意思,我把你的ip禁掉,一段时间你别来了。

很多人又说了,你也太菜了吧,不知道有爬虫ip代理池的开源项目IPProxys吗?那我就呵呵了,几个人真的现在用过免费的ip代理池,你去看看现在的免费代理池,有几个是可用的!

再说了,你通过IPProxys代理池,获取到可用的代理访问人家网站,人家网站不会用同样的办法查到可用的代理先一步封掉吗?然后你只能花钱去买付费的代理

数据源头封锁

平时大家看的什么爬爬豆瓣电影网站啊,收集下某宝评论啊....这些都是公开数据。但现在更多的数据逐步走向闭源化。数据的价值越来越大,没有数据获取的源头,爬虫面临什么问题?

上面说了一堆的爬虫这不好那不好,结果我今天发的文章确是爬虫的,自己打自己的脸? 其实我只是想说说网站数据展示与分析的技巧...恰巧Boss直聘就做的很不错。怎么不错?一点点分析...

数据共享

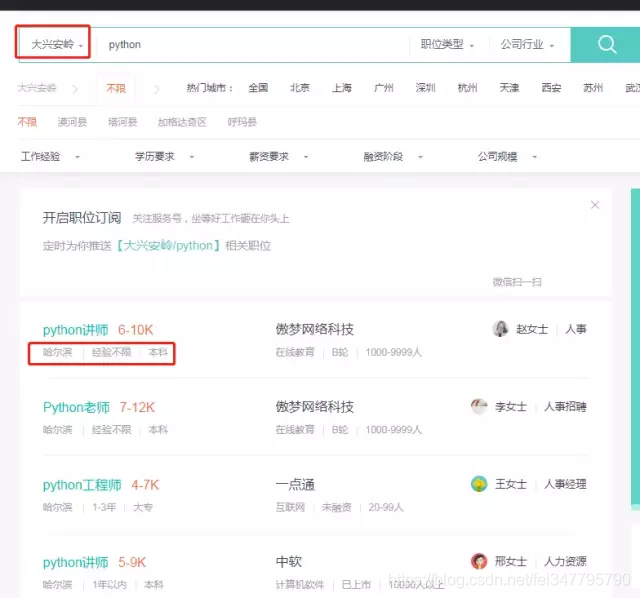

先来看一张图

我选择黑龙江省的大兴安岭,去看看那里有招聘python的没,多数系统查询不到数据就会给你提示未获取到相关数据,但Boss直聘会悄悄地吧黑龙江省的python招聘信息给你显示处理,够鸡~贼。

数据限制

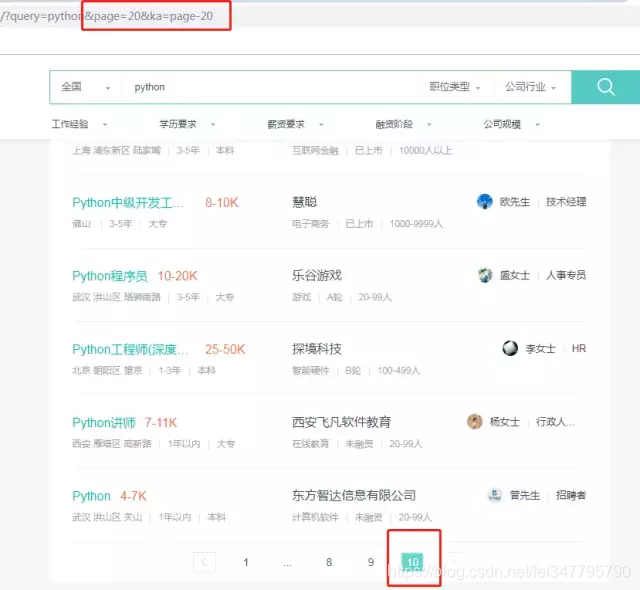

大兴安岭没有搞python的,那我们去全国看看吧:

这里差一点就把我坑了,我开始天真的以为,全国只有300条(一页30条,共10也)python招聘信息。 然后我回过头去看西安的,也只有10页,然后想着修改下他的get请求parameters,没卵用。

这有啥用?仔细想...一方面可以做到放置咱们爬虫一下获取所有的数据,但这只是你自作多情,这东西是商机!

每天那么多的商家发布招聘信息,进入不了top100,别人想看都看不到你的消息,除非搜索名字。那么如何排名靠前?答案就是最后俩字,靠钱。你是Boss直聘的会员,你发布的就会靠前....

偷换概念

依旧先看图:

我搜索的是ruby,你资料不够,其他来凑....

ip解析

老套路,再来看一张图:

Boss直聘的服务器里,留着我的痕迹,多么骄傲的事情啊。你们想不想和我一样?只需要3秒钟.... 三秒钟内你的访问量能超过1000,妥妥被封!

那么我们该怎么办

设置不同的User-Agent

使用pip install fake-useragent安装后获取多种User-Agent,但其实本地保存上几十个,完全够了....

不要太夯(大力)

适当的减慢你的速度,别人不会觉得是你菜....别觉得一秒爬几千比一秒爬几百的人牛逼(快枪手子弹打完的早....不算开车吧?)。

购买付费的代理

为什么我跳过了说免费的代理?因为现在搞爬虫的人太多了,免费的基本早就列入各大网站的黑名单了。

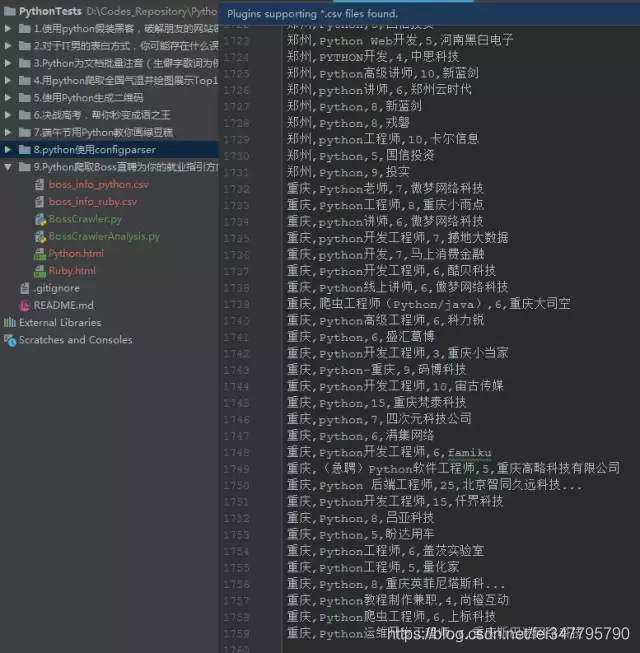

所以解析到的原始数据如下:

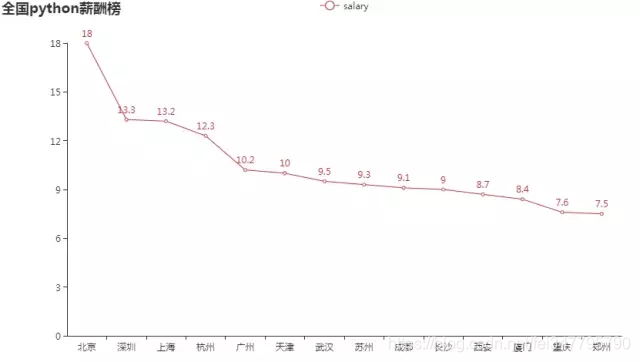

先来看看python的薪酬榜:

看一下西安的排位,薪资平均真的好低.....

代码

import requests

from bs4 import BeautifulSoup

import csv

import random

import time

import argparse

from pyecharts.charts import Line

import pandas as pd

class BossCrawler:

def __init__(self, query):

self.query = query

self.filename = 'boss_info_%s.csv' % self.query

self.city_code_list = self.get_city()

self.boss_info_list = []

self.csv_header = ["city", "profession", "salary", "company"]

@staticmethod

def getheaders():

user_list = [

"Opera/9.80 (X11; Linux i686; Ubuntu/14.10) Presto/2.12.388 Version/12.16",

"Opera/9.80 (Windows NT 6.0) Presto/2.12.388 Version/12.14",

"Mozilla/5.0 (Windows NT 6.0; rv:2.0) Gecko/20100101 Firefox/4.0 Opera 12.14",

"Mozilla/5.0 (compatible; MSIE 9.0; Windows NT 6.0) Opera 12.14",

"Opera/12.80 (Windows NT 5.1; U; en) Presto/2.10.289 Version/12.02",

"Opera/9.80 (Windows NT 6.1; U; es-ES) Presto/2.9.181 Version/12.00",

"Opera/9.80 (Windows NT 5.1; U; zh-sg) Presto/2.9.181 Version/12.00",

"Opera/12.0(Windows NT 5.2;U;en)Presto/22.9.168 Version/12.00",

"Opera/12.0(Windows NT 5.1;U;en)Presto/22.9.168 Version/12.00",

"Mozilla/5.0 (Windows NT 5.1) Gecko/20100101 Firefox/14.0 Opera/12.0",

"Opera/9.80 (Windows NT 6.1; WOW64; U; pt) Presto/2.10.229 Version/11.62",

"Opera/9.80 (Windows NT 6.0; U; pl) Presto/2.10.229 Version/11.62",

"Opera/9.80 (Macintosh; Intel Mac OS X 10.6.8; U; fr) Presto/2.9.168 Version/11.52",

"Opera/9.80 (Macintosh; Intel Mac OS X 10.6.8; U; de) Presto/2.9.168 Version/11.52",

"Opera/9.80 (Windows NT 5.1; U; en) Presto/2.9.168 Version/11.51",

"Mozilla/5.0 (compatible; MSIE 9.0; Windows NT 6.1; de) Opera 11.51",

"Opera/9.80 (X11; Linux x86_64; U; fr) Presto/2.9.168 Version/11.50",

"Opera/9.80 (X11; Linux i686; U; hu) Presto/2.9.168 Version/11.50",

"Opera/9.80 (X11; Linux i686; U; ru) Presto/2.8.131 Version/11.11",

"Opera/9.80 (X11; Linux i686; U; es-ES) Presto/2.8.131 Version/11.11",

"Mozilla/5.0 (Windows NT 5.1; U; en; rv:1.8.1) Gecko/20061208 Firefox/5.0 Opera 11.11",

"Opera/9.80 (X11; Linux x86_64; U; bg) Presto/2.8.131 Version/11.10",

"Opera/9.80 (Windows NT 6.0; U; en) Presto/2.8.99 Version/11.10",

"Opera/9.80 (Windows NT 5.1; U; zh-tw) Presto/2.8.131 Version/11.10",

"Opera/9.80 (Windows NT 6.1; Opera Tablet/15165; U; en) Presto/2.8.149 Version/11.1",

"Opera/9.80 (X11; Linux x86_64; U; Ubuntu/10.10 (maverick); pl) Presto/2.7.62 Version/11.01",

"Opera/9.80 (X11; Linux i686; U; ja) Presto/2.7.62 Version/11.01",

"Opera/9.80 (X11; Linux i686; U; fr) Presto/2.7.62 Version/11.01",

"Opera/9.80 (Windows NT 6.1; U; zh-tw) Presto/2.7.62 Version/11.01",

"Opera/9.80 (Windows NT 6.1; U; zh-cn) Presto/2.7.62 Version/11.01",

"Opera/9.80 (Windows NT 6.1; U; sv) Presto/2.7.62 Version/11.01",

"Opera/9.80 (Windows NT 6.1; U; en-US) Presto/2.7.62 Version/11.01",

"Opera/9.80 (Windows NT 6.1; U; cs) Presto/2.7.62 Version/11.01",

"Opera/9.80 (Windows NT 6.0; U; pl) Presto/2.7.62 Version/11.01",

"Opera/9.80 (Windows NT 5.2; U; ru) Presto/2.7.62 Version/11.01",

"Opera/9.80 (Windows NT 5.1; U;) Presto/2.7.62 Version/11.01",

"Opera/9.80 (Windows NT 5.1; U; cs) Presto/2.7.62 Version/11.01",

"Mozilla/5.0 (Windows NT 6.1; U; nl; rv:1.9.1.6) Gecko/20091201 Firefox/3.5.6 Opera 11.01",

"Mozilla/5.0 (Windows NT 6.1; U; de; rv:1.9.1.6) Gecko/20091201 Firefox/3.5.6 Opera 11.01",

"Mozilla/4.0 (compatible; MSIE 8.0; Windows NT 6.1; de) Opera 11.01",

"Opera/9.80 (X11; Linux x86_64; U; pl) Presto/2.7.62 Version/11.00",

"Opera/9.80 (X11; Linux i686; U; it) Presto/2.7.62 Version/11.00",

"Opera/9.80 (Windows NT 6.1; U; zh-cn) Presto/2.6.37 Version/11.00",

"Opera/9.80 (Windows NT 6.1; U; pl) Presto/2.7.62 Version/11.00",

"Opera/9.80 (Windows NT 6.1; U; ko) Presto/2.7.62 Version/11.00",

"Opera/9.80 (Windows NT 6.1; U; fi) Presto/2.7.62 Version/11.00",

"Opera/9.80 (Windows NT 6.1; U; en-GB) Presto/2.7.62 Version/11.00",

"Opera/9.80 (Windows NT 6.1 x64; U; en) Presto/2.7.62 Version/11.00",

"Opera/9.80 (Windows NT 6.0; U; en) Presto/2.7.39 Version/11.00"

]

user_agent = random.choice(user_list)

headers = {'User-Agent': user_agent}

return headers

def get_city(self):

headers = self.getheaders()

r = requests.get("http://www.zhipin.com/wapi/zpCommon/data/city.json", headers=headers)

data = r.json()

return [city['code'] for city in data['zpData']['hotCityList'][1:]]

def get_response(self, url, params=None):

headers = self.getheaders()

r = requests.get(url, headers=headers, params=params)

r.encoding = 'utf-8'

soup = BeautifulSoup(r.text, "lxml")

return soup

def get_url(self):

for city_code in self.city_code_list:

url = "https://www.zhipin.com/c%s/" % city_code

self.per_page_info(url)

time.sleep(10)

def per_page_info(self, url):

for page_num in range(1, 11):

params = {"query": self.query, "page": page_num}

soup = self.get_response(url, params)

lines = soup.find('div', class_='job-list').select('ul > li')

if not lines:

# 代表没有数据了,换下一个城市

return

for line in lines:

info_primary = line.find('div', class_="info-primary")

city = info_primary.find('p').text.split(' ')[0]

job = info_primary.find('div', class_="job-title").text

# 过滤答非所谓的招聘信息

if self.query.lower() not in job.lower():

continue

salary = info_primary.find('span', class_="red").text.split('-')[0].replace('K', '')

company = line.find('div', class_="info-company").find('a').text.lower()

result = dict(zip(self.csv_header, [city, job, salary, company]))

print(result)

self.boss_info_list.append(result)

def write_result(self):

with open(self.filename, "w+", encoding='utf-8', newline='') as f:

f_csv = csv.DictWriter(f, self.csv_header)

f_csv.writeheader()

f_csv.writerows(self.boss_info_list)

def read_csv(self):

data = pd.read_csv(self.filename, sep=",", header=0)

data.groupby('city').mean()['salary'].to_frame('salary').reset_index().sort_values('salary', ascending=False)

result = data.groupby('city').apply(lambda x: x.mean()).round(1)['salary'].to_frame(

'salary').reset_index().sort_values('salary', ascending=False)

print(result)

charts_bar = (

Line()

.set_global_opts(

title_opts={"text": "全国%s薪酬榜" % self.query})

.add_xaxis(result.city.values.tolist())

.add_yaxis("salary", result.salary.values.tolist())

)

charts_bar.render('%s.html' % self.query)

if __name__ == '__main__':

parser = argparse.ArgumentParser()

parser.add_argument("-k", "--keyword", help="请填写所需查询的关键字")

args = parser.parse_args()

if not args.keyword:

print(parser.print_help())

else:

main = BossCrawler(args.keyword)

main.get_url()

main.write_result()

main.read_csv()

Python爬取Boss直聘,帮你获取全国各类职业薪酬榜的更多相关文章

- 打造IP代理池,Python爬取Boss直聘,帮你获取全国各类职业薪酬榜

爬虫面临的问题 不再是单纯的数据一把抓 多数的网站还是请求来了,一把将所有数据塞进去返回,但现在更多的网站使用数据的异步加载,爬虫不再像之前那么方便 很多人说js异步加载与数据解析,爬虫可以做到啊,恩 ...

- Scrapy 爬取BOSS直聘关于Python招聘岗位

年前的时候想看下招聘Python的岗位有多少,当时考虑目前比较流行的招聘网站就属于boss直聘,所以使用Scrapy来爬取下boss直聘的Python岗位. 1.首先我们创建一个Scrapy 工程 s ...

- Python的scrapy之爬取boss直聘网站

在我们的项目中,单单分析一个51job网站的工作职位可能爬取结果不太理想,所以我又爬取了boss直聘网的工作,不过boss直聘的网站一次只能展示300个职位,所以我们一次也只能爬取300个职位. jo ...

- 用BeautifulSoup简单爬取BOSS直聘网岗位

用BeautifulSoup简单爬取BOSS直聘网岗位 爬取python招聘 import requests from bs4 import BeautifulSoup def fun(path): ...

- python3 爬取boss直聘职业分类数据(未完成)

import reimport urllib.request # 爬取boss直聘职业分类数据def subRule(fileName): result = re.findall(r'<p cl ...

- scrapy爬取boss直聘实习生数据

这个..是我最近想找实习单位..结果发现boss上很多实习单位名字就叫‘实习生’.......太不讲究了 == 难怪一直搜不到..咳,其实是我自己水平有限,有些简历根本就投不出去 == 所以就想爬下b ...

- Pyhton爬虫实战 - 抓取BOSS直聘职位描述 和 数据清洗

Pyhton爬虫实战 - 抓取BOSS直聘职位描述 和 数据清洗 零.致谢 感谢BOSS直聘相对权威的招聘信息,使本人有了这次比较有意思的研究之旅. 由于爬虫持续爬取 www.zhipin.com 网 ...

- python分析BOSS直聘的某个招聘岗位数据

前言 毕业找工作,在职人员换工作,离职人员找工作……不管什么人群,应聘求职,都需要先分析对应的招聘岗位,岗位需求是否和自己匹配,常见的招聘平台有:BOSS直聘.拉钩招聘.智联招聘等,我们通常的方法都是 ...

- scrapy——7 scrapy-redis分布式爬虫,用药助手实战,Boss直聘实战,阿布云代理设置

scrapy——7 什么是scrapy-redis 怎么安装scrapy-redis scrapy-redis常用配置文件 scrapy-redis键名介绍 实战-利用scrapy-redis分布式爬 ...

随机推荐

- docker打包python应用

操作系统 : CentOS7.5.1804_x64 docker版本 : 18.06.3-ce 本文描述了怎么将简单的python应用打包成docker镜像的过程. 本文涉及文件目录结构如下: [ro ...

- C++ 课程设计——电梯调度系统

这是我在本学期C++课程最后的课程设计报告,源代码将会上传到GitHub上. 一.背景 随着经济的不断发展,越来越多的摩天大楼拔地而起,而电梯作为高层建筑物种的运送人员货物的设备也越来越被广泛使用.电 ...

- 哈希算法原理【Java实现】(十)

前言 在入学时,学校为我们每位童鞋建立一个档案信息,当然每个档案信息都对应档案编号,还有比如在学校图书馆,图书馆为每本书都编了唯一的一个书籍号,那么问题来了,当我们需要通过档案号快速查到对应档案信息或 ...

- vsto 检测是否在编辑状态或者光标闪动

object m = Type.Missing; const int MENU_ITEM_TYPE = 1; const int NEW_MENU = 18; CommandBarControl oN ...

- 关于Java的多线程Runnable的个人理解(基础,不讲概念)

背景说明: 在学了Java的多线程(继承Thread,Runnable)以后,我出于好奇,就想知道java到底是不是多线程的,不能它说自己是多线程就是多线程,自己想验证一下,于是我就想测试一下,但继承 ...

- PHP 部分语法(一)

PHP: PHP 是一种创建动态交互性站点的强有力的服务器端脚本语言,它以 <?php 开始,并以 ?> 结束: 它还是一门弱类型语言,类型不需显式声明 变量: PHP 没有声明变量的命令 ...

- MySQL问题记录——2003-Can't connect to MySQL server on 'localhost'(10038)

MySQL问题记录——2003-Can't connect to MySQL server on 'localhost'(10038) 摘要:本文主要记录了连接到MySQL数据库时出现的问题以及解决办 ...

- cmd如何跨盘cd切换路径

cmd跨盘cd要加参数 /d ,难怪,我还以为电脑有问题呢~

- Spring Cloud 如何搭建eureka

Eureka Server 的搭建 eureka 是 Spring Cloud 的注册中心,提供服务注册和服务发现的功能. 利用idea 快速创建一个eureka应用File - NewProject ...

- 设计模式-Proxy(结构型模式)

以下代码来源: 设计模式精解-GoF 23种设计模式解析附C++实现源码 //Proxy.h #pragma once class Subject { public: virtual ~Subject ...