macbook安装scala、hadoop、saprk环境

一、scala安装

1. 安装jdk

有mac专用的jdk安装包,这里下载安装jdk1.8

2. 安装scala

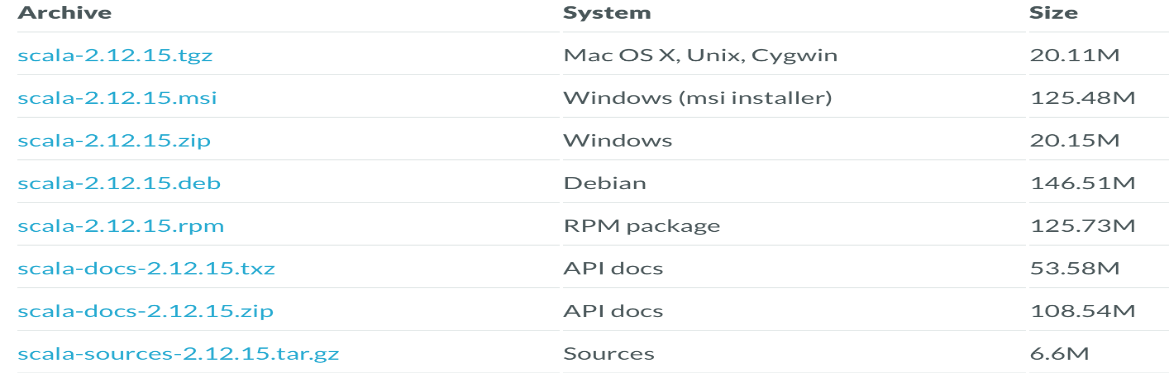

2.1下载scala

2.2解压到指定目录

tar -zxvf /Users/lodestar/Desktop/临时/scala-2.12.15.tar -C /Users/lodestar/software

2.3环境变量配置

vi ./bash_profile

我本机装过python和maven,这里再加入scala配置

PATH="/Library/Frameworks/Python.framework/Versions/3.7/bin:${PATH}"

export PATH

export M2_HOME=/Library/apache-maven-3.6.3

export PATH=$PATH:$M2_HOME/bin

export SCALA_HOME=/Users/lodestar/software/scala-2.12.15

export PATH=$SCALA_HOME/bin:$PATH

保存退出

source .bash_profile让配置生效

echo $SCALA_HOME 验证配置是否生效

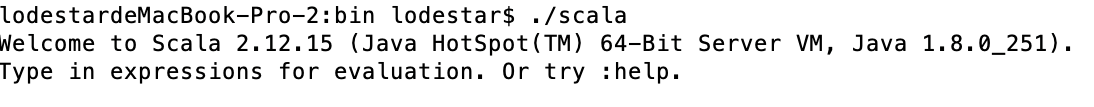

2.4.执行./scala进入控制台

2.5 编写,编译执行scala代码

文件后缀.scala;编译:scalac Helloworld.scala

3.Hadoop安装

3.1下载后解压到指定目录

tar -zxvf /Users/lodestar/Desktop/临时/hadoop-2.8.5.tar.gz -C /Users/lodestar/hadoop

hadoop目录结构如下:

bin:客户端工具

sbin:启动hadoop相关进程的脚本

etc/hoadoop:hadoop配置文件

share:常用例子

3.2 hadoop参数配置

vi ./bash_profile

export HADOOP_HOME=/Users/lodestar/hadoop/hadoop-2.8.5

export PATH=$HADOOP_HOME/bin:$PATH

export JAVA_HOME= /Library/Java/JavaVirtualMachines/jdk1.8.0_201.jdk/Contents/Home

export PATH=$JAVA_HOME/bin:$PATH

hadoop-env.sh

export JAVA_HOME= /Library/Java/JavaVirtualMachines/jdk1.8.0_201.jdk/Contents/Home

core-site.xml

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:8020</value>

</property>

hdfs-site.xml

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/Users/lodestar/hadoop/tmp</value>

</property>

slaves

hadoop000

3.4.ssh免密码登录,否则启动hadoop需要不断输入密码

--hadoop用户操作

ssh localhost --产生.ssh的隐藏目录

ssh-keygen -t rsa --产生密钥对(1路回车)

cat id_rsa.pub >> authorized_keys --讲公钥写入authorized_keys

chmod 600 authorized_keys --authorized_keys 只有创建者有读写权限

ssh localhost 测试,不需要密码配置成功

3.5 初始化文件系统

第一次启动前格式化文件系统

hdfs namenode -format

3.6 启动hadoop

进入sbin目录:

启动Start-dfs.sh

关闭stop-dfs.sh

3.7验证

Jps命令查询看到namenode和datanode进程

测试一下:

hadoop fs -ls /

hadoop fs -put README.txt /

进入浏览器查看hdfs状态

4 Spark安装和配置

4.1、Spark安装

tar xvf /Users/lodestar/Desktop/临时/spark-3.0.3-bin-hadoop2.7.tar -C /Users/lodestar/spark

4.2、Spark配置

1.配置环境变量

修改~/.bash_profile

export SPARK_HOME=/Users/lodestar/spark/spark-3.0.3-bin-hadoop2.7

export PATH=$SPARK_HOME/bin:$SPARK_HOME/sbin:$PATH

使得配置修改生效:source .bash_profile

2.修改配置文件spark-env.sh

1.修改conf下的spark-env.sh.template为spark-env.sh

cp spark-env.sh.template spark-env.sh

2:修改配置

export JAVA_HOME=/Library/Java/JavaVirtualMachines/jdk1.8.0_201.jdk/Contents/Home

export SCALA_HOME=/Users/lodestar/software/scala-2.12.15

export SPARK_HOME=/Users/lodestar/spark/spark-3.0.3-bin-hadoop2.7

#SPRAK MASTER地址

export SPARK_MASTER_IP=127.0.0.1

export SPARK_LOCAL_IP=127.0.0.1

export SPARK_EXECUTOR_MEMORY=500M

export SPARK_WORKER_MEMORY=1G

#spark master UI地址

export master=spark://127.0.0.1:7070

3.修改配置文件slaves

1.修改conf下的spark-env.sh.template为spark-env.sh

cp slaves.template slaves

echo “localhost” >> slaves

4.启动spark

./start-all.sh

使用jps查看,master上会有Master和Worker,worker节点上会有Worker

http://1192.168.251.86:8080查看spark的web界面

5.执行spark提供的默认demo

spark-submit --class org.apache.spark.examples.SparkPi --master spark://lodestardembp-2:7077 /Users/lodestar/spark/spark-3.0.3-bin-hadoop2.7/examples/jars/spark-examples_2.12-3.0.3.jar

--这里以前写的是localhos:7077,始终不能正常解析,后面换成spark web ui上的机器名

macbook安装scala、hadoop、saprk环境的更多相关文章

- Spark简单介绍,Windows下安装Scala+Hadoop+Spark运行环境,集成到IDEA中

一.前言 近几年大数据是异常的火爆,今天小编以java开发的身份来会会大数据,提高一下自己的层面! 大数据技术也是有很多: Hadoop Spark Flink 小编也只知道这些了,由于Hadoop, ...

- scala+hadoop+spark环境搭建

一.JDK环境构建 在指定用户的根目录下编辑.bashrc文件,添加如下部分: # .bashrc # Source global definitions if [ -f /etc/bashrc ]; ...

- RHEL7.2 安装Eclipse-oxygen Hadoop开发环境

1 Eclipse-oxygen下载地址 http://www.eclipse.org/downloads/download.php?file=/technology/epp/downloads/re ...

- [Linux] 安装JDK和Maven及hadoop相关环境

紧接上一篇,继续安装hadoop相关环境 JDK安装: 1. 下载,下面这两个地址在网上找的,可以直接下载: http://download.oracle.com/otn-pu ...

- 安装Scala开发环境

Scala 介绍 Step 1: 安装 Java开发环境 Scala 版本与Java版本的兼容关系 从Oracle网站下载JDK URL: http://www.oracle.com/technetw ...

- linux环境下载和安装scala

Linux下安装Scala和Windows下安装类似,步骤如下: 1.首先访问下载链接:http://www.scala-lang.org/download/默认这里下载的是Windows版本,这时点 ...

- 从VMware虚拟机安装到hadoop集群环境配置详细说明(第一期)

http://blog.csdn.net/whaoxysh/article/details/17755555 虚拟机安装 我安装的虚拟机版本是VMware Workstation 8.04,自己电脑上 ...

- ubuntu环境下eclipse的安装以及hadoop插件的配置

ubuntu环境下eclipse的安装以及hadoop插件的配置 一.eclipse的安装 在ubuntu桌面模式下,点击任务栏中的ubuntu软件中心,在搜索栏搜索eclipse 注意:安装过程需要 ...

- linux安装scala环境

(安装scala的前提是已经安装好了jdk) 1.下载scala的安装包 wget https://scala-lang.org/files/archive/scala-2.11.0-M2.tgz 2 ...

随机推荐

- Jeesite富文本编辑框ckeditor显示错误

Jeesite富文本编辑框ckeditor显示错误 原文链接:https://www.toutiao.com/i6485135618190869005/ Jeesite中Control都会继承一个Ba ...

- MongoDB-基础知识学习(一)

概述 最近mongodb在互联网的活跃度直线上升,并且我们公司也使用了mongoDB 3.6 作为生产重要的数据库,我们项目组要监控mongodb的op.log日志,在此整理以前学习的知识,为以后备份 ...

- 【PTA】字符串正反序连接

将s所指字符串的正序和反序进行连接,形成一个新串放在t所指的数组中. 函数接口定义: void fun (char *s, char *t); 其中s 和t都是用户传入的参数.函数将s所指字符串的正序 ...

- 《剑指offer》面试题47. 礼物的最大价值

问题描述 在一个 m*n 的棋盘的每一格都放有一个礼物,每个礼物都有一定的价值(价值大于 0).你可以从棋盘的左上角开始拿格子里的礼物,并每次向右或者向下移动一格.直到到达棋盘的右下角.给定一个棋盘及 ...

- 将待授权的数据库的dbowner指派给该用户

USE 数据库goEXEC dbo.sp_changedbowner N'账号'

- 问题记录——BigDecimal保留两位小数及格式化成百分比

1.函数总结 BigDecimal.setScale()方法用于格式化小数点 setScale(1)表示保留一位小数,默认用四舍五入方式 setScale(1,BigDecimal.ROUND_DOW ...

- [源码分析] Facebook如何训练超大模型 --- (2)

[源码分析] Facebook如何训练超大模型 --- (2) 目录 [源码分析] Facebook如何训练超大模型 --- (2) 0x00 摘要 0x01 回顾 1.1 ZeRO 1.1.1 Ze ...

- netty系列之:请netty再爱UDT一次

目录 简介 netty对UDT的支持 搭建一个支持UDT的netty服务 异常来袭 TypeUDT和KindUDT 构建ChannelFactory SelectorProviderUDT 使用UDT ...

- 学习axios必知必会(1)~axios基本介绍、axios配置、json-server接口模拟工具

一.axios基本介绍 1.axios(前端最流行的 ajax 请求库) 特点: ① 基于 xhr + promise 的异步 ajax 请求库 ② 浏览器端/node 端都可以使用 ③ 支持请求/响 ...

- Tomcat-如何创建动态的web工程及目录介绍

1,IDEA中如何创建动态web工程 (1)创建一个新模块 (2)选择你要创建什么类型的模块 (3)输入模块名,finish完成创建 创建成功如下图: 一般在WEB-INF下建一个lib目录 存放ja ...